Mi SciELO

Servicios Personalizados

Revista

Articulo

Indicadores

-

Citado por SciELO

Citado por SciELO -

Accesos

Accesos

Links relacionados

-

Citado por Google

Citado por Google -

Similares en

SciELO

Similares en

SciELO -

Similares en Google

Similares en Google

Compartir

FEM: Revista de la Fundación Educación Médica

versión On-line ISSN 2014-9840versión impresa ISSN 2014-9832

FEM (Ed. impresa) vol.19 no.5 Barcelona oct. 2016

ORIGINAL

Validez concurrente del examen clínico objetivo estructurado con el portafolio electrónico, examen teórico y promedio ponderado en estudiantes de cirugía de la Universidad Privada Antenor Orrego

Concurrent validity of the objective structured clinical examination with electronic portfolio, theoretical exam and weighted average in students of surgery at the Antenor Orrego Private University

Juan A. Díaz-Plasencia, Paulita A. Moreno-Castillo, James Calmet-Ipince, Edgar Yan-Quiroz, Melissa Díaz-Villazón, Anthony Iglesias-Obando, Karina Zegarra-Castillo y Karla Urquiaga-Ríos

Universidad Privada Antenor Orrego (J.A. Díaz-Plasencia, P.A. Moreno-Castillo, J. Calmet-Ipince, M. Díaz-Villazón, A. Iglesias-Obando, K. Zegarra-Castillo, K. Urquiaga-Ríos).

Instituto Regional de Enfermedades Neoplásicas (E. Yan-Quiroz). Trujillo, Perú.

Dirección para correspondencia

RESUMEN

Sujetos y métodos. Este estudio correlacional descriptivo tuvo como objetivo demostrar la validez concurrente del examen clínico objetivo estructurado (ECOE) con el promedio ponderado, la nota teórica y el portafolio electrónico en 123 estudiantes de medicina del curso de Cirugía I del IX ciclo, durante el semestre académico 2014-I, de la Facultad de Medicina de la Universidad Privada Antenor Orrego (Trujillo, Perú).

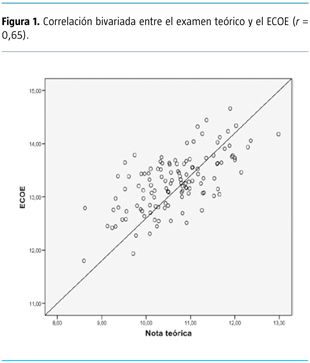

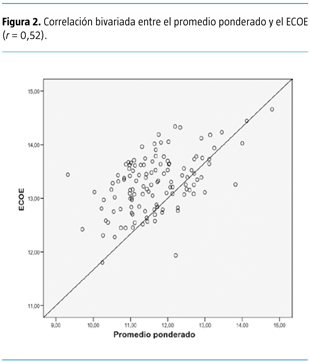

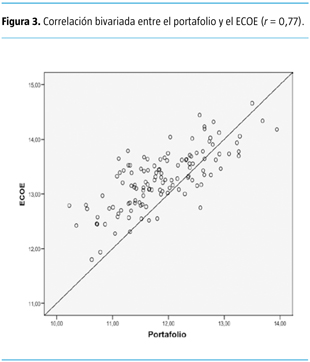

Resultados. Hubo correlación bivariada aceptable (r = 0,65) entre la nota teórica y el ECOE; correlación moderada (r = 0,52) entre el promedio ponderado y el ECOE; y correlación alta (r = 0,77) entre la nota del portafolio electrónico y el ECOE. Hubo correlación lineal múltiple entre el portafolio, el ECOE y el examen teórico (coeficiente de determinación múltiple R2 = 0,55).

Conclusión. Este estudio demuestra que el ECOE, el portafolio electrónico y la nota teórica utilizados para evaluar a los estudiantes de un curso de cirugía de pregrado tuvieron validez concurrente en el rango de aceptable a alta, y esta información constituye la base para mejorar los estándares de evaluación.

Palabras clave: Cirugía y pregrado. Educación médica. Examen clínico objetivo estructurado. Examen teórico. Portafolio. Promedio ponderado. Validez. Validez concurrente.

SUMMARY

Subjects and methods. This descriptive correlational study aimed to demonstrate the concurrent validity of the objective structured clinical examination (OSCE) with the weighted average, theoretical note and the electronic portfolio of 123 medical students of the I Course of Surgery of the ninth cycle during the academic semester 2014-I, at the Faculty of Medicine of the Antenor Orrego Private University (Trujillo, Peru).

Results. There was an acceptable bivariate correlation (r = 0.65) between the theoretical note and OSCE; moderate correlation (r = 0.52) between the weighted average and OSCE; and high correlation (r = 0.77) between the notes of the electronic portfolio and OSCE. There was a multiple linear correlation among the portfolio, OSCE and theoretical note (multiple determination coefficient R2 = 0.55).

Conclusion. This study showed that the OSCE, electronic portfolio and theoretical note used to evaluate students in an undergraduate course of surgery had concurrent validity in the range of acceptable and high and this information forms the basis in order to improve the standards of evaluation.

Key words: Concurrent validity. Medical education. Objective structured clinical examination. Portfolio. Theoretical test. Undergraduate surgery. Validity. Weighted average.

Introducción

Tradicionalmente, los exámenes psicométricos se centraron en gran medida en la fiabilidad. En los últimos años -desde que los nuevos currículos de pregrado médico cambiaron en la década de los noventa- también se ha prestado mucha más atención a la validez. La validez es un asunto complejo que es muy difícil de medir, pero se ocupa esencialmente de si las cosas correctas se están evaluando de manera pertinente por los asesores adecuados, y si la evaluación está teniendo un efecto positivo en el aprendizaje y la conducta profesional [1]. McManus et al [2] hallan una falta de correlación entre los resultados de los exámenes finales tradicionales y la experiencia clínica, y han sugerido que deben explorarse métodos alternativos de evaluación.

El examen clínico objetivo estructurado (ECOE), descrito por primera vez por Harden en 1975 como una alternativa a los métodos existentes de evaluación del desempeño clínico [3], fue diseñado para mejorar la validez y fiabilidad de la evaluación del desempeño, que se evaluó previamente utilizando casos largos y exámenes de casos cortos. Desde entonces, el uso de este instrumento se ha generalizado en la enseñanza clínica de pregrado y posgrado. El ECOE permite la evaluación en una gran variedad de escenarios, a través de maniquíes o pacientes simulados, en los cuales el alumno realiza una tarea específica que observa el examinador y la coteja con una lista previamente elaborada y validada por un grupo de expertos. Algunos de los elementos más destacables en el ECOE son:

- Mayor integración entre la teoría y práctica.

- Empleo de métodos e instrumentos que permiten valorar la diversidad de desempeños esperados.

- Énfasis en la valoración de competencias ligadas con la síntesis y aplicación contextualizada de diversos contenidos (conceptuales, procedimentales, actitudinales).

- Emisión de juicios razonados, cualificados, sobre la competencia desplegada en un momento y contexto particular de cada estudiante [4].

Adicionalmente, un portafolio de la práctica clínica tiene evidencia documental de los estudiantes combinado con una autorreflexión [5,6] en torno a las evidencias que van recopilando, y en este proceso deben establecer la relación entre la evidencia, el aprendizaje logrado y el desarrollo de la competencia [7], identificando sus niveles de avance, e incluso trazarse un plan de mejora para lograr la competencia deseada.

En la actualidad, la Universidad Privada Antenor Orrego (UPAO) cuenta con la plataforma informática Moodle y el sistema Blackboard, así como con el Instituto de Competencias y Destrezas Médicas (ICODEM), donde se han instalado equipos de simulación médica (maniquíes de alta tecnología), y para asegurar que el ECOE tenga una alta fiabilidad se ha diseñado una rueda de 18 estaciones, todo lo cual ha permitido el desarrollo de un currículo basado en competencias complementado con el aprendizaje virtual y la simulación clínica. El ECOE fue introducido como herramienta de evaluación en el curso de Cirugía I en el año 2000; sin embargo, esta experiencia local aún no ha sido convenientemente analizada, por lo que se torna necesario establecer la validez concurrente del ECOE con respecto a la nota teórica, el portafolio y el promedio ponderado previo. Esto permitirá aplicar instrumentos más válidos y contribuirá a que la evaluación por competencias sea integral, objetiva, procesal, sistemática, participativa, flexible y científica, lo que implica implementar un proceso mediante el cual se observe, recoja y analice información relevante respecto al proceso de evaluación, con el fin de tomar decisiones para optimizar el plan de estudios y el proceso de enseñanza-aprendizaje en el área clínica.

Sujetos y métodos

En la presente investigación descriptiva de tipo correlacional, la muestra comprendía 123 alumnos matriculados en el semestre 2014-I, de los cuales 71 fueron mujeres y 52 varones, que rotaron por Cirugía General y Abdominal y Especialidades Quirúrgicas, correspondientes al curso de Cirugía I de la Facultad de Medicina de la UPAO de Trujillo, Perú.

Nota teórica

La nota teórica (ponderación total: 70%) implica la aplicación de tres exámenes de elección múltiple en la rotación de cirugía general y uno en la rotación de especialidades quirúrgicas, de 50 preguntas cada uno (ponderación parcial: 95%), aunados a la nota de seminario, que tiene una ponderación parcial del 5% (cinco seminarios en cada rotación).

Nota del ECOE

La nota del ECOE (ponderación total: 15%) estuvo constituida por la obtenida a través de las 18 estaciones que conforman un circuito. En cada estación, el estudiante se enfrentó a una situación que evaluó una tarea y desempeño específicos en las tres áreas de dominio: cognitivo, actitudinal y destrezas psicomotoras. El ECOE se realiza en el circuito de estaciones ubicado en el ICODEM de la UPAO. Se realizan cuatro ECOE de 18 estaciones cada uno durante el curso, dos para la rotación de especialidades quirúrgicas y otros dos para cirugía general y abdominal; debido a que, con fines de establecer una programación académica modular, la promoción de alumnos se divide en dos grandes grupos que rotan a la mitad del curso. El proceso de evaluación del ECOE está a cargo de un comité de prueba conformado por los ocho coordinadores del curso (técnica operatoria, cirugía general, simulación clínica, anestesiología, cirugía pediátrica, cirugía oncológica, cirugía de tórax y cardiovascular, traumatología y ortopedia), presidido por el coordinador general del curso. El comité de prueba realiza la tabla de especificaciones teniendo en cuenta las competencias y capacidades nucleares del curso, y se programan las tareas que deben realizar los alumnos en las estaciones correspondientes, incluyendo habilidades clínicas básicas: anamnesis y exploración física, habilidad para obtener información, habilidades técnicas, manejo de las situaciones (diagnósticas, terapéuticas y de seguimiento), habilidades preventivas, comunicación y trato con el paciente, y atención a la familia. Un día antes del examen se realiza una charla de inducción a cargo del coordinador de simulación clínica del curso, donde se explica a los alumnos de manera detallada la metodología que hay que seguir en el circuito, para asegurar el orden del proceso. El día del examen se les invita a pasar a una sala de espera, donde se repiten las indicaciones a los alumnos y éstos van ingresando en orden al circuito de estaciones y permanecen en cada estación cinco minutos para resolver la tarea asignada. Cada docente aplica una lista de cotejo o escala de verificación, validada previamente, para cada una de las estaciones programadas. Al final de la actividad se realiza el debriefing para la retroalimentación correspondiente.

Portafolio virtual

Se solicitó a cada estudiante de manera individual, al inicio de cada capítulo, que introdujera información en un portafolio semiestructurado diseñado en forma electrónica (ponderación total: 15%), cuya construcción y entrega de actividades se realizaron al término de cada rotación en la plataforma Moodle de código abierto. El portafolio consta de los siguientes campos:

- Actividades registrales (ponderación parcial: 60%). Se consideró la evaluación mediante rúbricas del caso clínico real, y, usando escalas de verificación, la presentación oral del caso clínico, el análisis de un incidente crítico, las actividades clínicas diarias (consulta externa, hospitalización, sala de operaciones y emergencia) y la coevaluación por un compañero. Se trabajó sobre situaciones relacionadas con cualquier aspecto de la práctica clínica diaria que aparecieron durante el capítulo. De la distribución de los cuestionarios aplicados al compañero (coevaluación) se encargó el tutor, quien lo entregó en formato papel, para que luego el alumno evaluado lo escaneara y subiera a la plataforma virtual, debidamente firmado por su par.

- Autoevaluación personal (ponderación parcial: 10%). Se pretendió que el alumno, mediante una escala de verificación, llevara a cabo una auto-evaluación y tuviera la oportunidad de desarrollar su propio plan de aprendizaje. Esta sección pretendió ayudarle a identificar sus propias necesidades de aprendizaje en relación con las habilidades prácticas que debía dominar al final, e incluyó, a su vez, dos subsecciones: una herramienta para la autoevaluación crítica y un plan de desarrollo personal.

- Práctica reflexiva (ponderación parcial: 20%). Fue la reflexión del estudiante con respecto a su trabajo y a lo que aprendió. Señaló fortalezas y debilidades de su aprendizaje y cómo lo iba a mejorar. Se pretendió aquí que el alumno utilizara la experiencia que había adquirido en cada escenario de prácticas como ayuda para su aprendizaje. Este material personal fue incluido como evidencia de competencia y desarrollo personal. Con esto cada alumno dispuso de una muestra de las más interesantes y significativas experiencias personales a las que se enfrentó en los diferentes escenarios de prácticas, así como de las reflexiones que éstas le suscitaron. Esta sección incluyó igualmente cualquier comentario que pudo realizar en la sección anterior y pretendió animar al alumno a que reflexionase sobre lo que había aprendido en su última práctica, lo diferente o no que ésta le había podido resultar en comparación con sus expectativas previas y en qué medida él mismo se había podido afectar en sus ideas preconcebidas sobre la dirección que estuvo llevando su formación en prácticas. La evaluación de esta sección fue mediante rúbricas.

- Estructura y lenguaje escrito (ponderación parcial: 10%). Se calificó mediante rúbricas.

Para todos los implicados debieron quedar muy claros todos los elementos del portafolio, particularmente, su objetivo formativo y sumativo, y el carácter confidencial de la información registrada. A los portafolios de los estudiantes sólo tuvieron acceso los docentes y los coordinadores de cada capítulo, así como el coordinador general del curso (J.A.D.P.). La programación, mantenimiento y actualización del portafolio virtual fueron realizados por una ingeniera de sistemas (K.U.R.), junto con los coordinadores de los capítulos, todos integrantes del comité académico del curso.

Nota final

El curso de Cirugía I consta de dos rotaciones: cirugía general, con los capítulos de técnica operatoria y cirugía general y abdominal, y cirugía de especialidades quirúrgicas, que incluye los capítulos de anestesiología, cirugía oncológica, cirugía pediátrica, tórax y cardiovascular y traumatología y ortopedia. La nota parcial de cada rotación se obtiene aplicando la siguiente fórmula: nota teórica (70%), portafolio (15%) y ECOE (15%); de tal manera que, para procesar la nota final del curso, se suman ambas notas parciales en el sistema vigesimal y se promedia entre dos. La nota aprobatoria promocional es de 10,5 a más, redondeando el medio punto al número entero inmediatamente superior en la nota final, pero no en la parcial.

Análisis estadístico

Los datos numéricos fueron expresados en medias ± desviación estándar. Los datos de las variables categóricas se expresaron en porcentajes y proporciones. Para la diferencia de más de dos medias se empleó el análisis de varianza de una sola vía (ANOVA). Para correlacionar el ECOE con el promedio ponderado, la nota teórica y el aprendizaje virtual se utilizó el análisis de correlación lineal múltiple, y para el análisis bivariado se empleó el coeficiente de correlación producto-momento de Pearson. Se consideró un valor p < 0,05 como estadísticamente significativo. Todos los datos se analizaron mediante el programa estadístico SPSS v. 17.0.

Resultados

- El promedio de la nota teórica, el ECOE, el portafolio y el promedio ponderado de la serie global fue de 10,65 ± 0,83, 13,28 ± 0,53, 11,88 ± 0,74 y 11,67 ± 0,93, respectivamente (p = 0,0001).

- Hubo correlación aceptable (r = 0,65) entre la nota teórica y el ECOE estructurado (Fig. 1).

- Hubo correlación moderada (r = 0,52) entre el promedio ponderado previo y el ECOE (Fig. 2).

- Hubo correlación alta (r = 0,77) entre las notas del portafolio y el ECOE (Fig. 3).

- Hubo correlación lineal múltiple entre el portafolio, el ECOE y la nota teórica (coeficiente de determinación R2 = 0,55) (Fig. 4).

Discusión

ECOE y examen teórico

En el presente trabajo hubo una correlación significativa entre el ECOE y la nota teórica (0,65), aspecto que también es destacado por Petrusa et al [8] quienes indicaron una correlación de la parte escrita del ECOE con los exámenes escritos tradicionales de evaluación del posgrado. Merrick et al [9], en un estudio realizado en estudiantes de cirugía del tercer año de medicina del Departamento de Cirugía y la Oficina de Recursos e Investigación Educacional de la Facultad de Medicina de Ohio, demostraron una relación significativa entre el rendimiento del ECOE y la evaluación clínica (0,264), el examen oral (0,327), el examen escrito (0,39) y la nota total (0,348). Enfatizaron que el ECOE es una técnica única de evaluación del estudiante, en la medida que mide la aplicación de conocimiento de un modo estandarizado, y demostraron, además, que el ECOE es similar a otros instrumentos de evaluación de la capacidad general.

Estos resultados son similares también a los encontrados en estudios realizados en el pregrado en medicina por Townsend et al [10], quienes evaluaron a 28 estudiantes del Departamento de Medicina Familiar de la Facultad de Medicina y Ciencias de la Salud de la Universidad de Emiratos Árabes Unidos en Al Ain, que rotaron a través de la integración y tomaron ECOE pre y postintegración con un formato similar, pero de contenido diferente. Los resultados fueron analizados para determinar relaciones entre las puntuaciones medias en los dos ECOE y la puntuación del estudiante en sus exámenes finales escritos de la facultad de medicina. Las calificaciones del examen total de integración de la práctica general se correlacionaron significativamente con el ECOE final, pero más significativamente (p < 0,01) con las calificaciones del examen escrito final total. Adicionalmente, Schwartz et al [11] evaluaron a 22 internos de cirugía general del Departamento de Cirugía de la Universidad de Kentucky Chandler Medical Center con un ECOE de 35 estaciones de 17 problemas al ingresar al internado. Siete meses más tarde se sometieron el examen de entrenamiento del Comité Americano de Cirugía (ABSITE). Encontraron que el ECOE se correlacionó con la evaluación clínica y el examen escrito, y permitió además identificar los déficits de aprendizaje en muchos de los internos, y también fue la modalidad más importante en la fiabilidad total del programa de evaluación. Los autores concluyeron que, si futuros estudios confirman estos hallazgos, las técnicas de evaluación basadas en competencias como el ECOE deberían llegar a ser un parámetro de evaluación mucho más importante en la valoración de la competencia clínica de los internos de cirugía.

Minion et al [12] realizaron su estudio en 34 estudiantes de medicina que rindieron una evaluación integral al final del curso de cirugía en el tercer año de la Facultad de Medicina de la Universidad del Centro Médico de Kentucky en el Departamento de Cirugía. La evaluación consistió en cinco mediciones: el examen del banco de preguntas de cirugía del National Board of Medical Examiners, un ECOE, una simulación de competencia clínica computarizada, una evaluación de la plana docente y la evaluación por pares. Concluyeron que el examen escrito se correlaciona significativamente con el ECOE (r = 0,66), la simulación de la competencia clínica computarizada (r = 0,43) y la evaluación por pares (r = 0,55). Hubo otra correlación estadísticamente significativa entre el ECOE y la simulación de la competencia clínica computarizada (r = 0,36).

Carraccio y Englander [13] analizaron todos los estudios de habla inglesa que consideraron el uso del ECOE en la evaluación pediátrica publicados en Estados Unidos y Gran Bretaña entre los años 1975 y 2000, y concluyeron que, con una apropiada atención al diseño, se pueden obtener para el ECOE una fiabilidad y una validez aceptables. Encontraron correlaciones significativas entre el ECOE y los exámenes de precertificación, así como también con las evaluaciones clínicas mensuales, siendo más fuerte en la primera que en la segunda.

El presente estudio difiere con lo señalado por Wass et al [14], quienes encontraron una baja correlación significativa entre el examen de conocimientos y el ECOE. Estos autores estimaron la confiabilidad total de un examen compuesto, la correlación entre los exámenes y el efecto de las diferencias en la duración del examen, el número de ítems y la ponderación de los resultados en la confiabilidad en un examen final del pregrado aplicado a 214 estudiantes de la Guy's, King's y St. Thomas' School of Medicine de Londres, y en el Department of Educational Development and Research de la Universidad de Maastricht, en los Países Bajos. Los coeficientes de correlación para el examen de conocimiento factual de elección múltiple con los componentes clínicos fueron de 0,28 para el ECOE y de 0,04 para los casos largos. Como es reconocido, las preguntas usadas en el test de elección múltiple desarrolladas durante años evalúan el conocimiento factual directo del libro de texto acerca de las enfermedades, y esto explicaría por qué este conocimiento tiene poca relación con el conocimiento más sustentado clínicamente requerido por los estudiantes para rendir el ECOE y los casos largos. Los autores plantean que el contenido del examen de elección múltiple puede necesitar revisión, con la inclusión de preguntas de apareamiento extendido, en la medida que estas muestran en su estudio una correlación más fuerte entre el examen de respuestas cortas y el ECOE.

Otro estudio cuyos resultados contrastan con el presente trabajo es el de Williams et al [15], quienes, al examinar competencias en 222 estudiantes de medicina durante seis semestres académicos a través del examen objetivo de cirugía del National Board of Medical Examiners y de un ECOE quirúrgico al término del curso de ocho semanas de duración, encontraron que las puntuaciones de los exámenes de cirugía no se correlacionaban con las del ECOE (r = 0,095). Epstein y Hundert [16], en una revisión, realizaron una crítica basada en la evidencia de las técnicas actuales de evaluación en los estudiantes de medicina y residentes, y concluyeron que las puntuaciones del ECOE pueden no correlacionarse con los grados académicos y los exámenes de elección múltiple. Estos dos últimos estudios concluyeron que el ECOE y el examen escrito miden destrezas clínicas diferentes.

ECOE y promedio ponderado

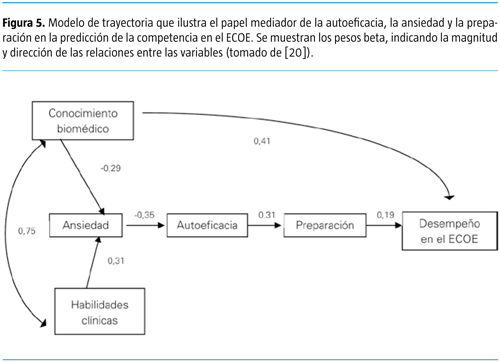

Desde una perspectiva constructivista, los productos observables del aprendizaje significativo son consecuencia de procesos de construcción y operaciones cognitivas que finalizan en la elaboración de representaciones (esquemas, significados) sobre los contenidos curriculares [17,18]. Ausubel et al [19] sostienen que esta base de conocimientos (memoria semántica), almacenada en forma de redes jerárquicas, permitiría una adecuada recuperación de la información, que en el caso de la educación médica afloraría cuando el caso o la tarea clínica lo requieran. Los contenidos curriculares proporcionados en el contexto educativo de manera general, y en el clínico de manera particular, pueden ser de naturaleza diferente (conceptual, procedimental, actitudinal), por lo que la evaluación de los aprendizajes exige procedimientos y técnicas diferenciadas. De acuerdo con el modelo causal de Mavis (Fig. 5) [20], el conocimiento base requisito es subyacente a un buen desempeño, especialmente en las destrezas clínicas evidenciadas en el ECOE; y esta relación podría reflejarse en que el dominio de las habilidades clínicas se edificaría en el conocimiento biomédico base. Esto explicaría la correlación positiva existente, en el presente estudio y en otros [9,12], entre la nota teórica con el ECOE. Este trabajo confirma, además, la hipótesis de que las puntuaciones más altas obtenidas por los estudiantes en el ECOE correspondieron a los que tenían mayor promedio ponderado, ya que tenían una mayor capacidad de integrar el conocimiento teórico base con las destrezas clínicas.

Ambos, el conocimiento biomédico y las habilidades clínicas, están asociados con la ansiedad. Los estudiantes que rinden bien en los cursos de ciencias biomédicas están menos ansiosos en relación con el ECOE. De manera inversa, la competencia en las destrezas clínicas está positivamente relacionada con la ansiedad en el ECOE. Esta relación, como la asociación negativa entre el conocimiento biomédico y la preparación, no es intuitiva; sin embargo, es congruente con la sugerencia de Hoppe et al [21] de que, en la medida en que los estudiantes obtienen más conocimiento, se tornan más críticos de sus habilidades y más conscientes de lo que no saben. La ansiedad y la autoeficacia están asociadas negativamente: los estudiantes que tienen una mayor ansiedad acerca del ECOE están menos seguros acerca de su competencia en la simulación. Como se esperaba, los estudiantes con una autoeficacia más alta para rendir el ECOE se sienten más preparados, y la preparación está asociada con la competencia [20].

Mavis [22] sostiene que lo atractivo del ECOE es que coloca al estudiante en una simulación donde cada estación proporciona una oportunidad para la evaluación de destrezas más auténticas que la que es disponible a través de la evaluación de papel y lápiz. Estos mismos factores también contribuyen a la ansiedad de los estudiantes acerca del ECOE. La encuesta aplicada a un grupo de estudiantes en este estudio reveló que ellos valoraron la oportunidad para 'practicar' medicina, pero reconocieron la ansiedad de la experiencia de la evaluación (el 36,9% estuvo de acuerdo o completamente de acuerdo en que fue un examen estresante). A diferencia de los exámenes familiares de papel y lápiz, los ECOE tienen diferentes expectativas de experticia, y así podrían requerir estrategias diferentes de estudio.

Jolly et al [23] encuentran poca relación entre la competencia en el ECOE y las experiencias clínicas de los estudiantes. Los estudiantes de segundo año con resultados en el ECOE promedio o por encima del promedio son mejores académicamente en los primeros dos años del currículo de la facultad de medicina que los estudiantes con resultados por debajo del promedio. Lo que diferencia a los que obtienen resultados promedio de los que están por encima del promedio es el tiempo de estudio: la competencia en el ECOE por encima del promedio está asociada con un tiempo menor de estudio en comparación con el visto en el grupo promedio. Esto sugiere que las puntuaciones en el ECOE por encima del promedio generalmente corresponden a los estudiantes muy talentosos, quienes se desenvuelven bien académicamente. Alternativamente, en este grupo podría haber estudiantes que regularmente afinan y practican sus destrezas comparados con los estudiantes que practican sólo antes del examen. Las puntuaciones promedio en el ECOE parecen corresponder a los estudiantes que trabajan duro y tienen buenos antecedentes académicos. Las puntuaciones previas al examen sugieren que su reserva de conocimiento fue comparable a la de los estudiantes por encima del promedio. Dado que cumplir un ECOE típicamente requiere que los estudiantes integren el conocimiento de ciencias básicas y destrezas clínicas en una simulación en tiempo real, los estudiantes con puntuaciones promedio podrían tener menos capacidad o velocidad para integrar información nueva. Asimismo, los estudiantes con resultados por debajo del promedio en el ECOE son más flojos en su rendimiento curricular de ciencias básicas; ellos también tienden a no pasar mayor tiempo estudiando para el ECOE [23].

ECOE y portafolio

En el presente estudio hubo una alta correlación bivariada entre el ECOE y el portafolio electrónico (0,77), a diferencia de un ensayo clínico aleatorizado en el que se asignó a estudiantes a un grupo de estudio que elaboró un portafolio de aprendizaje no estructurado (n = 80) comparado con un grupo control (n = 79), en el cual no se demostraron diferencias entre los dos grupos en las puntuaciones observadas en el ECOE, pero los estudiantes que presentaron portafolios para la evaluación formativa tuvieron puntuaciones más altas en el ECOE que los que no presentaron portafolios [24]. La falta de correlación entre las puntuaciones en el ECOE y si el estudiante utiliza un portafolio puede indicar que ambos formatos están midiendo resultados diferentes. El portafolio reflexivo implementado en la UPAO, que mide el 'hace' de la punta de la pirámide de Miller, enfatiza la resolución de casos clínicos e incidentes críticos, y monitoriza una suficiente exposición de los alumnos a casos que se presentan en la práctica clínica usual en los diferentes contextos hospitalarios. La experiencia adquirida por el estudiante en el desempeño real -concretizado en su portafolio- le facilitaría un mejor desempeño en un contexto simulado, demostrado en el circuito del ECOE. Contrario a la noción común de que la capacidad de hacer algo mientras es observado o evaluado en el lugar de trabajo (usando EBT) es una evaluación de desempeño, y que el circuito del ECOE es una evaluación de la competencia, ambas deben ser vistas como una evaluación de 'desempeño'. La primera debe ser llamada 'desempeño observado en los lugares de trabajo', y la segunda, 'desempeño observado en contextos simulados', teniendo en cuenta que ambas son 'evaluaciones basadas en competencias' y evalúan el 'desempeño' de los candidatos en diferentes entornos o contextos bajo la influencia de diferentes factores [25]. Este concepto se apoya en la declaración de Hager y Gonczi [26] de que todas 'las evaluaciones basadas en competencias se centran en el desempeño'.

Lonka et al [27] encontraron una correlación significativa entre la realización de procedimientos y la cantidad de texto desarrollado en el portafolio. Esta correlación puede indicar una relación genérica en lugar de una relación específica entre las dos mediciones, es decir, ambas reflejan el nivel de actividad general del estudiante. Bibliografía creciente sobre el uso del portafolio de aprendizaje como un proceso de educación médica continua demuestra las mismas dificultades en la evaluación del portafolio que las encontradas en los alumnos; sin embargo, esto se ha compensado en la medida que los profesionales invierten más tiempo en educación médica continua basada en portafolio y acreditan que este instrumento aumenta la práctica reflexiva [28-32].

ECOE, examen teórico y portafolio

En el presente estudio, en contraste a lo señalado por Wass et al [14], se encontró una correlación significativa entre el examen teórico, el promedio ponderado y el portafolio con el ECOE. Sin embargo, los resultados de la presente investigación concuerdan con los de Shams et al [33], quienes señalaron correlaciones estadísticamente significativas entre el ECOE con el portafolio (r = 0,55), entre el ECOE con el examen escrito (r = 0,51) y entre el ECOE con el examen total del curso (r = 0,86). Adicionalmente, encontraron correlación bivariada estadísticamente significativa entre el portafolio con el examen escrito (r = 0,41) y con el examen total (r = 0,85). Existen pocos estudios en la literatura que evalúan la validez concurrente del ECOE con otros formatos de evaluación. También en un estudio sobre portafolios para 91 estudiantes que realizaron una pasantía de obstetricia y ginecología hubo correlación modesta, pero estadísticamente significativa, entre las calificaciones finales del examen de grado y el desempeño en determinados procedimientos, así como también entre los resultados de los exámenes finales y la cantidad de texto escrito en el portafolio [27].

Patricio et al [34], en un metaanálisis, encontraron que 70 de 104 estudios no comunicaron la validez (67,3%), y en cinco estudios, aunque los autores se referían a la validez, no presentaron datos que apoyaran su evidencia (4,8%). Para los restantes estudios (32,7%), la validez concurrente se mencionaba en solo un estudio; la validez de constructo, en dos; la validez aparente, en 17; y correlaciones con otras mediciones o dentro de las mediciones del ECOE fueron exploradas en 13. Además, consideraron que, aunque el ECOE se correlaciona con el examen de elección múltiple, las correlaciones fueron bajas a moderadas, y sólo cinco estudios notificaron valores altos de casi 0,7. La correlación más alta (0,82) se encontró en la comparación con los exámenes de respuestas cortas. La baja correlación entre el ECOE y la evaluación clínica podría explicarse por la pobre confiabilidad de esta última.

El presente estudio mostró que el ECOE es similar a otros formatos de evaluación en la valoración de la capacidad general y que también es capaz de evaluar la capacidad clínica de manera estandarizada. Por tanto, la combinación del ECOE, los exámenes estandarizados y la observación directa en los contextos clínicos tiene la potencialidad de convertirse en la prueba de referencia para la medición de la competencia, lo cual requiere un cambio de paradigma en la dirección de la educación médica basada en competencias y evaluación de resultados [13]. El ECOE es un método válido y reproducible para evaluar la competencia clínica de los estudiantes de cirugía cuando se utiliza en conjunto con otras formas de evaluación, ya que provee una forma objetiva de evaluar el progreso de los estudiantes en formación. Por lo tanto, se deberán realizar investigaciones futuras con respecto a su utilidad como una herramienta de evaluación diagnóstica, formativa y acumulativa en los futuros médicos, ya que es sensible para diferenciar el nivel de formación y proporciona retroalimentación inmediata en el proceso de evaluación y en la etapa de medición de resultados, por lo que el ECOE debería desempeñar un papel siempre en expansión y ser un instrumento esencial para evaluar tanto la competencia clínica individual del estudiante como la efectividad total de un programa de formación.

Bibliografía

1. General Medical Council. Supplementary guidance. Reliability issues in the assessment of small cohorts. London: GMC; 2010. [ Links ]

2. McManus IC, Richards P, Winder BC, Sproston KA. Clinical experience, performance in final examinations, and learning style in medical students: prospective study. BMJ 1998; 316: 345-50. [ Links ]

3. Harden RM, Stevenson M, Downie WW, Wilson GM. Assessment of clinical competence using objetive structured examination. Br Med J 1975; 1: 447-51. [ Links ]

4. López J. Aplicación de un examen clínico objetivo estructurado (ECOE) para la evaluación de las habilidades y competencias clínicas en la Licenciatura de Medicina. Educ Med 2008; 5: 1-11. [ Links ]

5. Snadden D, Thomas M. The use of portfolio learning in medical education. Med Teach 1998; 20: 192-200. [ Links ]

6. Friedman Ben David M, Davis MH, Harden RM, Howie PW, Ker J, Pippard MJ. AMEE Medical Education Guide no. 24: Portfolios as a method of student assessment. Med Teach 2001; 23: 535-51. [ Links ]

7. Challis M. AMEE Medical Education Guide no. 11 (revised): Portfolio based-learning and assessment in medical education. Med Teach 1999; 21: 370-86. [ Links ]

8. Petrusa ER, Blackwell TA, Ainsworth MA. Reliability and validity of objective structured clinical examination for assessing the clinical performance of residence. Arch Intern Med 1990; 150: 573-7. [ Links ]

9. Merrick HW, Nowacek G, Boyer J, Robertson J. Comparison of the objective structured clinical examination with the performance of third-year medical students in surgery. J Am J Surg 2000; 179: 286-8. [ Links ]

10. Townsend AH, Mcllvenny S, Miller CF, Dunn EV. The use of an objective structured clinical examination (OSCE) for formative and summative assessment in a general practice clinical attachment and its relationship to final medical school examination performance. Med Educ 2002; 35: 841-6. [ Links ]

11. Schwartz R, Donnelly M, Sloan D, Johnson S, Strodel W. The relationship between faculty ward evaluations, OSCE, and ABSITE as measures of surgical intern performance. Am J Surg 1995; 169: 414-7. [ Links ]

12. Minion DJ, Donnelly MB, Quick RC, Pulito A, Schwartz R. Are multiple objective measures of student performance necessary? Am J Surg 2002; 183: 663-5. [ Links ]

13. Carraccio C, Englander R. The objective structured clinical examination: a step in the direction of competence-based evaluation. Arch Pediatr Adolesc Med 2000; 154: 736-41. [ Links ]

14. Wass V, McGibbon D, Van der Vleuten C. Composite under-graduate clinical examination: How should the components be combined to maximize reliability? Med Educ 2001; 35: 326-30. [ Links ]

15. Williams M, Abrose M, Carlin MD, Tyburski JG, Steffes CP. Evaluation of academic and community surgery clerkships in a Midwestern Medical School. J Surg Res 2004; 116: 11-3. [ Links ]

16. Epstein RM, Hundert EM. Defining and assessing professional competence. JAMA 2002; 287: 226-36. [ Links ]

17. Herman JL, Aschbacher PR, Winters L. A practical guide to alternative assessment. Alexandria, VA: Association for Supervision and Curriculum Development; 1992. [ Links ]

18. Miras-Miras M, Solé I. La evaluación del aprendizaje y la evaluación en el proceso de enseñanza y aprendizaje. In Coll C, Palacios J, Marchesi A, eds. Desarrollo psicológico y educación II. Psicología de la educación. Madrid: Alianza; 1990. p. 11-20. [ Links ]

19. Ausubel DP, Novak JD, Hanesian H. Psicología educativa: un punto de vista cognoscitivo. México DF: Trillas; 1983. [ Links ]

20. Mavis B. Does studying for an objective structured clinical examination make a difference? Med Educ 2000; 34: 808-12. [ Links ]

21. Hoppe R, Farquhar L, Henry R, Stoffelmayr B. A course component to teach interviewing skills in informing and motivating patients. J Med Educ 1988; 63: 176-81. [ Links ]

22. Mavis B. Self-efficacy and OSCE performance among second year medical students. Adv Health Sci Educ 2001; 6: 93-102. [ Links ]

23. Jolly B, Jones A, Dacre J, Elzubeir M, Kopelman P, Timan G. Relationships between student's clinical experience in introductory clinical courses and their performances on an objective structured clinical examination (OSCE). Acad Med 1996; 71: 909-16. [ Links ]

24. Finlay IG, Maughan TS, Webster DJ. A randomized controlled study of portfolio learning in undergraduate cancer education. Med Educ 1998; 32: 172-6. [ Links ]

25. Khan K, Ramachandran S. Conceptual framework for performance assessment: competency, competence and performance in the context of assessments in healthcare-deciphering the terminology. Med Teach 2012; 34: 920-8. [ Links ]

26. Hager P, Gonczi A. What is competence? Med Teach 1996; 18: 15-8. [ Links ]

27. Lonka K, Slotte V, Halttunen M, Kurki T, Tiitinen A, Vaara L, et al. Portfolios as a learning tool in obstetrics and gynaecology undergraduate training. Med Educ 2001; 35: 1125-30. [ Links ]

28. Mathers NJ, Challis MC, Howe AC, Field NJ. Portfolios in continuing medical education-effective and efficient? Med Educ 1999; 33: 521-30. [ Links ]

29. Parboosingh J. Learning portfolios: potential to assist health professional with self-directed learning. J Cont Educ Health Prof 1996; 16: 75-81. [ Links ]

30. Challis M, Mathers NJ, Howe AC, Field NJ. Portfolio-based learning: continuing medical education for general practitioners-a mid-point evaluation. Med Educ 1997; 31: 22-6. [ Links ]

31. Campbell CM, Parboosingh JT, Gondocz ST, Babitskaya G, Lindsay E, De Guzmán RC, et al. Study of physician's use of a software program to create a portfolio of their self-directed learning. Acad Med 1996; 71 (Suppl 10): S49-51. [ Links ]

32. Pitts J, Coles C, Thomas P. Educational portfolios in the assessment of general practice trainers: reliability of assessors. Med Educ 1999; 33: 515-20. [ Links ]

33. Shams T, El-Masry R, Al Wadani H, Amr M. Assessment of current undergraduate anesthesia course in a Saudi University. Saudi J Anaesth 2013; 7: 122-7. [ Links ]

34. Patricio M, Juliao M, Fareleira F, Young M, Norman G, Vaz-Carneiro A. A comprehensive checklist for reporting the use of OSCEs. Med Teach 2009; 3: 112-24. [ Links ]

![]() Dirección para correspondencia:

Dirección para correspondencia:

Dr. Juan Alberto Díaz Plasencia.

Universidad Privada Antenor Orrego.

Las Casuarinas, 208-210.

Urb. Santa Edelmira. Trujillo, Perú.

E-mail: alberdiaz@hotmail.com

Conflicto de intereses: No declarado.

Recibido: 18.01.16.

Aceptado: 16.03.16.