Meu SciELO

Serviços Personalizados

Journal

Artigo

Indicadores

-

Citado por SciELO

Citado por SciELO -

Acessos

Acessos

Links relacionados

-

Citado por Google

Citado por Google -

Similares em

SciELO

Similares em

SciELO -

Similares em Google

Similares em Google

Compartilhar

Anales de Psicología

versão On-line ISSN 1695-2294versão impressa ISSN 0212-9728

Anal. Psicol. vol.29 no.2 Murcia Mai. 2013

https://dx.doi.org/10.6018/analesps.29.2.161851

Adaptación española de la versión reducida multicanal del Perfil de Sensibilidad No Verbal (MiniPONS)

The Spanish version of the short multichannel version of the Profile of Nonverbal Sensitivity (MiniPONS)

Francisco Martínez-Sánchez1, Enrique G. Fernández-Abascal2 y Juan C. Martínez-Modia2

1 Universidad de Murcia

2 Universidad Nacional de Educación a Distancia, UNED

Dirección para correspondencia

RESUMEN

En este trabajo se presenta la adaptación española de la versión reducida multicanal del Perfil de Sensibilidad No Verbal (MiniPONS) (Bänziger, Scherer, Hall y Rosenthal, 2011). Esta escala evalúa las diferencias individuales en la habilidad para reconocer emociones, actitudes interpersonales y comunicación de intenciones por canales no verbales. Esta versión multicanal reducida está compuesta por 64 estímulos no verbales de vídeo y/o audio que representan a una mujer en blanco y negro. El principal objetivo de este estudio es analizar las propiedades psicométricas del MiniPONS empleando para ello una amplia muestra de participantes (N = 1154) de entre 18 a 60 años, también se examinaron las diferencias en la sensibilidad no verbal en función del sexo y la edad. Se presentan los valores normativos, la fiabilidad y validez en tres estudios con 168, 254 y 1154 estudiantes universitarios. Los resultados muestran que las mujeres obtienen mejores puntuaciones en todas las condiciones estimulares, éstas no sólo procesan más eficientemente información emocional no verbal por canales unisensoriales (rostro, cuerpo, voz), si no que también la integran mejor. Los resultados indican que la versión española del MiniPONS presenta unas propiedades psicométricas similares a la escala original, mostrando moderada consistencia interna y fiabilidad test-retest, así como también una razonable validez convergente obtenida en las correlaciones con otras pruebas que evalúan la capacidad de reconocimiento emocional. Se concluye que la versión española del MiniPONS es un instrumento que evalúa adecuadamente la sensibilidad no verbal. Se discuten las limitaciones y potencial utilidad de la escala.

Palabras clave: Sensibilidad no verbal, reconocimiento emocional, expresión facial, prosodia emocional, evaluación, alexitimia, inteligencia emocional.

ABSTRACT

The Spanish version of the MiniPONS (Banziger, Scherer, Hall y Rosenthal, 2011), the short version multichannel of the Profile of Nonverbal Sensitivity (PONS), is presented. This scale was designed to measure individual differences in the ability to recognize emotions, interpersonal attitudes, and communicative intentions in nonverbal channels. This short multichannel version is composed of 64 items nonverbal audio and/or visual scenes portrayed by a female in black and white color. The main aim of this study was to analyze the psychometric properties of MiniPONS using a large sample of university students (N = 1154) aged 18-60, this study also examined gender and age differences in nonverbal sensitivity. Normative data, reliability and validity were examined in three studies with 168, 254, and 1154 university students. The Spanish version of the MiniPONS has psychometric properties similar to those of the original version, the MiniPONS had moderate internal consistency and test-retest reliability, and shows reasonable convergent validity through significant correlations with other tests of non-verbal emotion recognition ability. Results revealed an advantage of women in all the conditions of stimulus presentation; women not only process more efficiently unisensory nonverbal information (face, body and voice) but may also be better at integrating emotional expressions. We conclude that the MiniPONS Spanish version is an adequate instrument to be used in measure of socio-nonverbal sensitivity. Limitations and potential applications for research are described.

Key words: Nonverbal sensitivity, emotional recognition, facial expression, emotional prosody, assessment, alexithymia, emotional intelligence.

Introducción

La comunicación no verbal es la vía más frecuente de comunicación en nuestra especie. Continuamente expresamos a los demás (codificamos) y recibimos (decodificamos) un gran número de señales de carácter no verbal, entre las que se incluyen expresiones faciales (Russell y Fernandez-Dols, 1997), vocalizaciones (Juslin y Scherer, 2005), posturas y gestos (Wallbott, 1998), que interpretamos, bien de forma deliberada bien involuntaria, como sentimientos, emociones, actitudes o intenciones. Señales que cumplen funciones regulatorias, tanto de la propia experiencia emocional, como de su expresión (Riggio, 2006).

Tanto el modelo de habilidades propuesto por Mayer y Salovey (1993), como el de competencias emocionales de Scherer (2007), acentúan la importancia de la capacidad para percibir señales afectivas que faciliten la adaptación del individuo a entornos en continuo cambio. Scherer (2007, 2009) propone disociar ambos tipos de enfoques (el de habilidades y el de competencias), centrándose en el estudio de las competencias que facilitan que un individuo interactúe óptimamente en situaciones sociales, culturalmente determinadas. Tres son las competencias emocionales que facilitarían la adaptación. La producción hace referencia a la ejecución de cambios adaptativos en los patrones corporales y conductuales ante hechos relevantes, facilitando al organismo afrontar exitosamente sus consecuencias. La regulación recoge la capacidad para controlar y manipular el estado emocional, y la expresión motriz para facilitar la homeóstasis orgánica, el cumplimiento de las normas socioculturales y la consecución de metas complejas. Y por último, la competencia en la percepción emocional, que describe la habilidad para percibir con precisión e interpretar los estados afectivos de los otros, para inferir adecuadamente sus reacciones ante situaciones relevantes y así predecir sus tendencias de acción y ajustarse a ellas.

La habilidad para inferir con precisión las emociones de los otros es de suma importancia en la competencia socioemocional, ya que provee información sobre el significado de sus reacciones ante eventos próximos, incluyendo nuestra propia conducta y sus posibles reacciones futuras; esta información es vital en las interacciones sociales. Con ser importante esta competencia en la vida cotidiana, aún lo es más para el desempeño exitoso de las actividades profesionales de terapeutas, médicos, policías y profesores, entre otros, que requieren identificar y anticiparse con precisión a las reacciones e intenciones de los demás.

A pesar de la importancia de esta competencia, llama la atención la ausencia de instrumentos que faciliten su evaluación. Obviamente ésta no puede ser evaluada adecuadamente mediante el empleo de cuestionarios de inteligencia emocional tales como el MSCEIT (Mayer-Salovey-Caruso Emotional Intelligence Test; Mayer, Salovey, Caruso y Sitarenios, 2003), que emplean un reducido número de ítems para evaluar el reconocimiento de emociones, ni por cuestionarios que preguntan a los sujetos por sus habilidades no verbales tales como el Perceived Decoding Ability (PDA), una subescala del Social Skills Inventory (SSI; Riggio, 1989); evidentemente, preguntar a un sujeto sobre su capacidad para reconocer estímulos no verbales constituye una fuente cuestionable de información valida. Por ello se hace preciso el desarrollo de instrumentos de evaluación capaces de evaluar las diferencias individuales en la capacidad para percibir señales no verbales que recojan emociones y actitudes interpersonales procedentes del rostro, el cuerpo y la voz (Hall y Bernieri, 2001).

Se han desarrollado algunas pruebas que recogen estímulos visuales estáticos y en vídeo, así como prosódicos, para evaluar la sensibilidad afectiva no verbal, tales como el Communication of Affect Receiving Ability Test (CARAT; Buck, 1976), el Diagnostic Analysis of Nonverbal Accuracy (DANVA; Nowicki y Duke, 1994), el Interpersonal Perception Task (IPT; Archer y Costanzo, 1988) y el Multimodal Emotion Recognition Test (MERT; Bänziger, Grandjean y Scherer, 2009). La prueba más utilizada es el Perfil de Sensibilidad No Verbal (Profile of Nonverbal Sensitivity - PONS) de Rosenthal, Hall, DiMatteo, Rogers y Archer, 1979. Éste fue desarrollado para evaluar las diferencias individuales en la capacidad para reconocer emociones, actitudes interpersonales y comunicar intenciones mediante diversos canales expresivos no verbales. Numerosos estudios demuestran que quienes obtienen altas puntuaciones en el PONS son más sensibles a la información afectiva no verbal (Hill, Siegelman, Gronsky, Sturniolo y Fretz, 1981; Lee, Hallberg, Kocsis y Haase, 1980; Miller y Lenzenweger, 2012; Tickle-Degnen, 1998) así, por ejemplo, los pacientes de médicos con altas puntuaciones en el PONS se muestran más satisfechos con ellos que sus colegas con bajas puntuaciones (DiMatteo, Friedman y Taranta, 1979; DiMatteo, Hays y Prince, 1986).

La prueba original consta de 220 estímulos de 2 segundos de duración cada uno, que incluyen veinte situaciones distintas en las que aparece una mujer joven en una situación de interacción interpersonal. Todos los estímulos se agrupan en un diseño 2 x 2 que combina valencia afectiva y dominancia. Cada uno de los cuadrantes está representado por 5 estímulos no verbales que recogen el cruce de ambos factores: dominancia-positiva (por ejemplo, expresando amor maternal), dominancia-negativa (por ejemplo, amenazando a alguien), sumisión-negativa (por ejemplo, pidiendo perdón) y sumisión-positiva (por ejemplo, expresando gratitud). Todas estas escenas están codificadas para producir 11 canales distintos que muestran: a) el cuerpo completo, de la cabeza a las rodillas de la actriz de pie, sin sonido, b) sólo el rostro llenando la pantalla, sin sonido, c) sólo el cuerpo (del cuello hasta las rodillas, sin sonido), d) un canal de audio de la voz filtrada mediante un filtro de paso bajo, e) un canal de audio con la voz enmascarada que retiene la cualidad prosódica de la voz y, f) la combinación de estos canales de vídeo y audio. En la prueba se pide al sujeto que seleccione, de entre una lista de 5 opciones posibles, qué está expresando la actriz.

El PONS posee alta validez predictiva y consistencia interna (KR-20 = .86), a pesar de la bajas correlaciones entre sus ítems (Rosenthal et al., 1979). Se ha criticado su excesiva duración, por lo que se han arbitrado diversos procedimientos abreviados, sin embargo éstos presentan baja consistencia interna (Hall, 2001).

Bänziger, Scherer, Hall y Rosenthal (2011) desarrollaron una versión reducida de la prueba (MiniPONS), que mantiene la mayor parte de los canales expresivos no verbales (y su combinación) de la prueba original, con el objeto de recoger la amplia variedad de habilidades para decodificar la expresión emocional. La ventaja de esta adaptación estriba en su duración que se ha reducido a 15 minutos aproximadamente, implementada, además, mediante una aplicación informática que facilita su aplicación.

Este trabajo incluye tres estudios en los que se realiza la adaptación española de la escala, empleando un amplio número de participantes de ambos sexos con un extenso rango de edad, siguiendo un muestreo de tipo incidental. En el primero de ellos se estudió la validez convergente, empleando para ello pruebas que evalúan constructos relacionados, tales como la inteligencia emocional, así como una prueba de reconocimiento de expresiones faciales emocionales estáticas basada en el Picture of Facial Affect (Ekman y Friesen, 1976), además de una prueba de reconocimiento prosodia emocional. Se evaluó también la validez discriminante empleado la Escala de Alexitimia de Toronto (TAS-20). Finalmente se estudió también la fiabilidad de la escala por el procedimiento de test-retest. En el segundo estudio se amplió el número de participantes a quienes se aplicó la prueba, con el objeto de ampliar la información sobre su validez convergente, administrándoles una prueba que evalúa aspectos emocionales complejos mediante la observación de estímulos estáticos de la región ocular (desde la mitad superior de la nariz hasta las cejas) de hombres y mujeres (Test de los ojos; Baron-Cohen, Wheelwright, Hill, Raste y Plumb, 2001). Finalmente, en el tercer estudio se amplió el número de participantes (N = 1154), con el objeto de obtenerlos los valores normativos de la escala para ambos sexos; se estudió nuevamente la validez convergente de la escala, empleando para ello las calificaciones académicas obtenidas por los participantes, como índice relacionado positivamente con la sensibilidad interpersonal.

Primer estudio

Método

Participantes

Participaron en este estudio 168 alumnos (36 hombres y 132 mujeres) de la asignatura Psicología de la Emoción de la Universidad Nacional de Educación a Distancia (UNED), de edades comprendidas entre los 18 y 55 años (M = 33.93; DT = 9.5; Asimetría = .25; Curtosis = -.81).

Todos ellos fueron informados de que su participación era voluntaria, así como que el objeto del estudio era valorar las diferencias individuales en el reconocimiento de expresiones emocionales. Se les aseguró la confidencialidad de sus resultados individuales, así como que era imposible identificar a cada individuo en el conjunto total de los resultados; finalmente se les solicitó una dirección de correo electrónico para que pudieran recibir un informe personalizado de los resultados obtenidos y su interpretación.

Instrumentos

Se empleó el MiniPONS (Bänziger et al., 2011), administrando la prueba mediante una aplicación informática que tiene una duración aproximada de 15 minutos. El MiniPONS pretende recoger el mayor número posible de formas de expresión recogidas en la literatura científica, constituyendo una combinación ecológicamente válida de señales emocionales no verbales. Está compuesta por 64 estímulos, así como de 3 ejemplos iniciales para instruir a los participantes, que incluyen seis canales expresivos y su combinaciones: 1o) 16 vídeos en que aparece sólo el cuerpo (CuS), del cuello hasta las rodillas, sin sonido, 2o) 16 vídeos sólo del rostro llenando la pantalla (RoS), sin sonido, 3o) 16 sonidos de prosodia emocional, de los cuales 8 son de voz filtrada (PeF) y otros tantos distorsionada (PeD), 4o) 16 ítems que combinan vídeo y prosodia, 4 de ellos del rostro y prosodia filtrada (RoS + PeF), 4 del rostro y prosodia distorsionada (RoS + PeD), 4 combinando cuerpo y prosodia filtrada (CuS + PeF) y, finalmente, otros 4 combinan cuerpo y prosodia distorsionada (CuS + PeD).

Adicionalmente, todos los ítems se reparten entre otros dos factores: la mitad de los estímulos muestran afecto positivo y la otra mitad negativo; del mismo modo, la mitad de los estímulos expresan actitudes dominantes y el resto de sumisión.

El procedimiento de respuesta consiste en pedir al sujeto que seleccione, entre una lista de 5 opciones posibles, cuál cree que es la respuesta correcta relativa a qué está expresando la actriz.

La validez convergente se evaluó empleando el Índice de Reconocimiento Emocional (Emotion Recognition Index - ERI). El ERI (Scherer 2007; Scherer y Scherer 2011), emplea un conjunto de 30 imágenes del Picture of Facial Affect (Ekman y Friesen, 1976) que recogen expresiones de 5 emociones básicas (ira, miedo, alegría, tristeza y asco), así como 30 muestras de prosodia emocional extraídas de Scherer, Banse, Wallbott y Goldbeck (1991) de cuatro emociones (tristeza, miedo, ira y alegría), además de muestras de prosodia emocional neutra. La prueba permite obtener un índice de reconocimiento facial y otro verbal.

La validez discriminante se evaluó mediante el empleo de la Escala de Alexitimia de Toronto de 20 ítems (TAS-20) (Bagby, Parker y Taylor, 1994). Esta escala está compuesta por tres factores que evalúan la dificultad de identificar sentimientos (factor I), la dificultad para describir sentimientos a los demás (factor II) y el pensamiento orientado a lo externo (factor III). La escala presenta una buena consistencia interna (α = 0.81) y fiabilidad test-retest (r = .77) en un intervalo de tres semanas. La estabilidad y la replicabilidad de esta estructura de tres factores ha sido ampliamente estudiada en poblaciones clínicas y no-clínicas. En el presente estudio se utilizó la versión española de la escala TAS-20 (Martínez-Sánchez, 1996), que posee una adecuada consistencia interna (α = .78) y una alta fiabilidad test-retest, medida en un período de 19 semanas (r = . 71, p < .001); valores similares a los registrados por la escala original.

La validez convergente se evaluó empleando el Trait Meta-Mood Scale (TMMS; Salovey, Mayer, Goldman, Turvey y Palfai, 1995), en la adaptación española de Fernandez-Berrocal, Extremera y Ramos (2004). La prueba está compuesta por 24 ítems que miden tres dimensiones de la Inteligencia Emocional: Atención emocional (el grado en el que se cree prestar atención a sus emociones y sentimientos), Claridad emocional (describe cómo las personas creen percibir sus emociones) y Reparación de las emociones (la creencia en la capacidad para interrumpir y regular estados emocionales negativos y prolongar los positivos). La prueba posee unas propiedades psicométricas adecuadas, siendo los índices de fiabilidad α de .84, .82 y .81 en las escalas de Atención, Claridad y Reparación, respectivamente (Salguero, Fernandez-Berrocal, Balluerka y Aritzeta, 2010).

Procedimiento

Todas las pruebas se aplicaron individualmente durante el curso académico 2011-2012, mediante una utilidad informática elaborada para esta investigación, que presentaba los estímulos y registraba las respuestas. Inicialmente el número de participantes en este primer estudio fue de 191, se descartaron los datos de 23 ellos por no haber completado en su totalidad alguna de las pruebas, quedando la muestra compuesta finalmente por 168 participantes.

Resultados

En la Tabla 1 se recogen los estadísticos descriptivos (medias, desviaciones típicas, así como los valores máximos, mínimos y el rango) de las puntuaciones obtenidas en el MiniPONS en cada uno de los canales expresivos evaluados.

Inicialmente calculamos la consistencia interna de la prueba empleando el coeficiente Alfa de Cronbach (a = .563). Se calculó también la fiabilidad por el procedimiento test-retest para la puntuación total de la prueba. Para ello se aplicó la prueba a un grupo formado por 55 participantes en un plazo de 4 semanas desde la primera administración. Los resultados mostraron una correlación moderada (r = .626; p <. 01).

Se calcularon las correlaciones entre los diversos índices del MiniPONS, el Emotion Recognition Index (ERI) y las escalas de Alexitimia e Inteligencia Emocional (Tabla 2), obteniéndose en conjunto bajas correlaciones y, la mayoría de ellas, no significativas. Es la escala que recoge las puntuaciones combinadas (vídeos del rostro y cuerpo) del MiniPONS la que muestra mayores niveles de correlación, además de la puntuación total en la prueba. El ERI obtiene su máxima correlación con las puntuaciones combinadas (r = .174; p < .05). Por su parte, en relación a los cuestionarios, sólo el factor que describe el patrón de pensamiento orientado a lo externo (éste evalúa la tendencia a prestar atención a estímulos no afectivos del entorno) de la Escala de Alexitimia de Toronto, muestra bajas correlaciones significativas con el MiniPONS (r = -.148; p < .05); la subescala de atención emocional (evalúa el grado en el que se cree prestar atención a las emociones y sentimientos) del TMMS muestra un mayor grado de correlación con las puntuaciones obtenidas en la prueba, en especial con la puntuación total del MiniPONS (r = .258;p < .01).

Segundo estudio

Método

Participantes

La muestra estuvo compuesta por 256 participantes, de los cuales 254 (61 hombres y 184 mujeres) completaron todas las pruebas, de edades comprendidas entre los 18 y 60 años (M = 32.7; DT = 10.31; Asimetría = 4.74; Curtosis = -4.45), todos ellos alumnos de la asignatura Psicología de la Emoción de la UNED. El estudio se realizó cumpliendo las normas éticas vigentes (consentimiento informado y derecho a la información, protección de datos personales y garantías de confidencialidad).

Instrumentos

Se aplicó el MiniPONS, ya descrito en el primer estudio y el "Test de los ojos" (Baron-Cohen et al., 2001). Esta última prueba consta de 36 fotografías en blanco y negro de 15x30 cm de la región ocular (desde la mitad superior de la nariz hasta las cejas) de hombres y mujeres. Ante cada fotografía se da al sujeto cuatro opciones de respuesta posibles, y éste debe elegir la que cree que describe la emoción que está sintiendo el sujeto que aparece en la imagen. Esta prueba valora aspectos emocionales complejos, ya que su resultado está mediado por el conocimiento de un léxico emocional complejo que alude a emociones y sentimientos; además, el participante debe "completar" la expresión facial representada en cada estímulo, así como identificar la emoción ligada a cada una de ellas.

Procedimiento

Al igual que en el estudio anterior, se elaboró una aplicación informática que recogía los estímulos auditivos y visuales, así como las escalas y almacenaba las respuestas. El programa fue contestado voluntariamente. Una vez ejecutada la prueba, el programa fue retornado a los investigadores quienes analizaron los resultados. Es preciso señalar que es imposible la manipulación de los resultados del programa que ejecuta el MiniPONS; del mismo modo, los participantes no conocían sus resultados hasta que les fueron enviados individualmente a cada uno de ellos.

Resultados

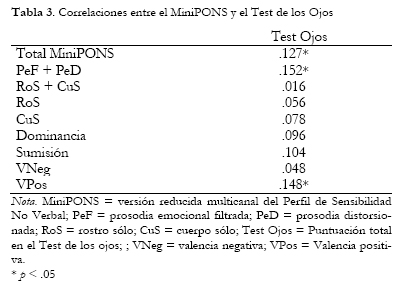

Se calcularon las correlaciones entre los diversos índices del MiniPONS y los resultados obtenidos en el Test de los ojos. Los resultados (Tabla 3) muestran moderadas correlaciones, significativas entre la puntuación total del Test de los ojos y la puntuación total del MiniPONS (r = .127; p < .05), así como también con el canal que evalúa prosodia y la puntuación total de estímulos de valencia positiva.

Tercer estudio

Método

Participantes

Participaron en este estudio 1154 alumnos (264 hombres y 890 mujeres) de la asignatura Psicología de la Emoción de la UNED, así como de la asignatura Memoria, Motivación y Emoción de la Universidad de Murcia, de edades comprendidas entre los 18 y 60 años (M = 31.67; DT = 9.81; Asimetría = .67; Curtosis = -.087). La distribución de los grupos en relación a la variable "sexo" (22.9 % hombres y 77.1 % mujeres) fue diferente, con amplia significación estadística (χ21 = 347.09; p < .001). Por su parte, la distribución de la variable "edad" en ambos grupos incumplía el supuesto de normalidad tanto en el grupo de hombres (K-S = 1.14; p < .05) como de mujeres (K-S = 2.85; p < .001), siendo superior en los hombres (M = 33.53; DT = 10.47), a las mujeres (M = 31.12; DT = 9.81) (t= 3.37; p < .001). El estudio se realizó cumpliendo las normas éticas vigentes (consentimiento informado y derecho a la información, protección de datos personales y garantías de confidencialidad).

Instrumentos

Se aplicó el MiniPONS, ya descrito anteriormente; además se recogieron las calificaciones finales de la asignatura Psicología de la Emoción obtenidas por los participantes, con el objeto de utilizar esta variable como un índice de validez convergente; este índice fue utilizado con anterioridad por los autores de la escala original (Rosenthal et al., 1979).

Procedimiento

Como en los estudios anteriores, una aplicación informática presentaba los estímulos y almacenaba las respuestas (véase la descripción del procedimiento del primer estudio).

Resultados

Inicialmente valoramos las diferencias en las puntuaciones del MiniPONS atendiendo al sexo y la edad de los participantes. De acuerdo a la literatura científica se esperaba la existencia de diferencias entre hombres y mujeres, hipotetizando que habrían de ser superiores las puntuaciones de las mujeres; del mismo modo, se esperaba la existencia de relaciones negativas entre la edad y sus puntuaciones en la prueba.

Se realizaron pruebas de comparación de medias (Tabla 4) entre las puntuaciones obtenidas con el MiniPONS en cada uno de los canales evaluados, agrupadas por sexo. Los resultados arrojaron diferencias significativas en todas las variables del MiniPONS, al comparar las puntuaciones de hombres y mujeres; es preciso señalar que el incumplimiento de los supuestos de normalidad y homocedasticidad son irrelevantes al realizar análisis de comparación de medias de grupos formados por muestras del tamaño de las utilizadas en este estudio (Erceg-Hurn y Mirosevich, 2008; Sawilowsky y Blair, 1992). Los resultados ponen de manifiesto que las mujeres obtienen mejores puntuaciones en todas las condiciones estimulares, éstas no sólo procesan más eficientemente información emocional no verbal por canales unisensoriales (rostro, cuerpo o voz), si no que también la integran mejor, al ser más eficientes en el reconocimiento de los estímulos complejos cuando se presentaba paralelamente la combinación de señales procedentes del rostro y el cuerpo sin prosodia emocional asociada, así las señales complejas que combinan información no verbal del rostro y el cuerpo (RoS + CuS) son significativamente mejor reconocidas por las mujeres que por los hombres (t = -.95; p < .01), del mismo modo que también lo son la combinación de las dos vías de expresión prosódica (PeF + PeD) (t = -2.23;p < .05).

Al estudiar la relación entre la edad de los participantes y la sensibilidad no verbal, se comprueba que ésta influye negativamente (r = -.228; p < .001) en la capacidad para reconocer emociones, actitudes interpersonales e intenciones mediante canales expresivos no verbales, siendo mayor en el caso de los hombres (r = -.250; p < .001) que en el de las mujeres (r = -.202;p < .001).

Se calcularon también las correlaciones entre la puntación total de la prueba y la calificación final obtenida por 617 participantes de la UNED en la asignatura Psicología de la Emoción; el grupo de participantes de la Universidad de Murcia (n = 98) fueron excluidos de los análisis con el objeto de unificar los criterios de calificación. Los resultados muestran una correlación significativa (r = .13; p <.001) entre ambas variables.

Finalmente, las puntuaciones normativas de la escala se presentan en el Anexo I.

Discusión

El propósito de este trabajo fue adaptar la versión reducida multicanal del Perfil de Sensibilidad No Verbal (MiniPONS) (Bänziger et al., 2011), con el objeto de valorar sus propiedades psicométricas, así como analizar las diferencias de ejecución en función del sexo y la edad, además de recoger los valores normativos en población española.

Las propiedades psicométricas de la prueba concuerdan con los valores aportados por sus autores en el único estudio que se conoce realizado con ella y, a su vez, también son coincidentes con las de la escala original (PONS). Así, en esta adaptación el coeficiente de fiabilidad (α = .563) es similar a la de la versión original (α = .566); la fiabilidad test-retest fue, también, similar en ambos estudios, .52 y .64 para la muestra española y suiza (Bänzinger et al., 2011) respectivamente.

Los relativamente bajos niveles de fiabilidad de la prueba merecen ser discutidos pormenorizadamente. Hall (2011) apunta que los bajos niveles de consistencia interna del PONS pueden atribuirse principalmente a que el modelo psicométrico estándar asume que están causados por los errores aleatorios, y sostiene que este hecho puede no ser aplicable a las pruebas no verbales. Por el contrario, la inclusión de distintas emociones, expresadas por canales diferentes, confieren validez a los estímulos que componen estas pruebas, en vez de asumir que la replicación del contenido de un ítem es la única vía que le confiere fiabilidad, como sostiene la psicometría clásica.

Generalmente se asume que altos niveles de consistencia confieren mayor validez a una prueba, sin embargo es preciso considerar también que, como afirman Bänziger et al. (2011), ésta se compone de dos factores: n, el número de ítems que componen la escala y rxx, la correlación media entre ellos. Ciertamente, la escala muestra modestos niveles de correlación entre sus ítems, sin embargo la correlación con la variable criterio se incrementa cuando el n aumenta (ya que las covarianzas entre los ítems se incrementan proporcionalmente más que la varianza de los totales) mientras que, por el contrario, decrece su validez paralelamente al incremento de la correlación entre ítems.

Se ha argumentado (Hall, 2011; Scherer y Scherer, 2011) que los análisis psicométricos tradicionales presentan problemas al aplicarlos a las pruebas de reconocimiento de la sensibilidad no verbal tales como el PONS y el MiniPONS, lo que daría razón de los relativamente bajos niveles de fiabilidad y validez de estas escalas. A nuestro juicio, el modelo clásico presenta dificultades para recoger y expresar en términos de calidad psicométrica la información obtenida en este tipo de pruebas.

La razón fundamental estriba en que, por ejemplo, en una escala verbal clásica se mide el contenido de un solo elemento mediante varias formulaciones que recogen un margen muy estrecho del dominio que pretenden medir. De hecho, el concepto de consistencia interna expresa homogeneidad; ésta puede reflejar la redundancia en la formulación de los ítems que componen una prueba (Boyle, 1991; John y Soto, 2007); incrementar el nivel de la α de Cronbach es relativamente sencillo mediante la inclusión redundante de los mismos ítems que componen una escala, formulados en distintos términos. Esta práctica no es posible en una prueba de sensibilidad no verbal ya que los estímulos que la componen son, habitualmente, codificados por distintos sujetos; además, los actores no pueden variar sistemáticamente la expresión emocional sin que esto afecte a la tasa de reconocimiento y, finalmente, muchas emociones pueden expresarse de forma muy diversa (véase Scherer y Bänziger, 2010) y sin embargo las tasas de reconocimiento pueden ser altas.

El empleo del procedimiento test-retest para calcular la fiabilidad también acarrea problemas en esta área de estudio ya que, por ejemplo, Scherer y Cherer (2011) demostraron que la exposición previa a modelos de expresión emocional genera fuertes efectos de aprendizaje de la primera a la segunda exposición, lo que conlleva el desarrollo de estrategias de discriminación y exclusión de ítems que influyen fuertemente en el resultado de la segunda aplicación de la prueba.

Una estrategia para incrementar la consistencia interna de la prueba podría consistir en la inclusión de estímulos repetitivos, algo que se ha cuidado de evitar en el MiniPONS, en aras a obtener una mayor representatividad, ecológicamente racional, de la amplia variedad de estímulos no verbales: dos formas de prosodia, vídeos del rostro y el cuerpo, así como las combinaciones de todos ellos.

Ciertamente todos los ítems no miden lo mismo, lo que a priori supone una amenaza a la asunción de unidimensionalidad implícita en estas pruebas, si bien entendemos que el rasgo latente, esto es, la sensibilidad no verbal, queda adecuadamente recogida en la homogeneidad conceptual en esta prueba. Por otra parte, es bien conocido que las pruebas que evalúan expresión emocional no verbal, ya sean faciales, prosódicas o su combinación, presentan niveles medios de consistencia interna, del mismo modo que las correlaciones entre distintas pruebas son bajas en la mayoría de las ocasiones (véase una exhaustiva revisión de 109 estudios en Hall, Andrzejewski, Murphy, Mast y Feinstein, 2008). Valga como ejemplo las bajas correlaciones, la mayoría de ellas no significativas, obtenidas por Bänziger et al. (2011), al comparar los resultados de pruebas que teóricamente evalúan capacidad para identificar expresiones emocionales faciales y prosódicas. Similares resultados, esto es, bajas correlaciones y la mayoría de ellas no significativas, obtienen Roberts, Schulze, O'Brien, MacCann, Reid y Maul (2006) al valorar la validez convergente del MSCEIT (Mayer et al., 2003).

Las bajas correlaciones entre el MiniPONS y las dos pruebas de ejecución (ERI y Test de los ojos) empleadas para valorar la validez convergente, pueden atribuirse a que la primera evalúa no sólo expresiones emocionales sino también actitudes en las relaciones sociales, por cuanto los vídeos que componen la parte visual muestran siempre al modelo en una situación de interacción social, expresando distintos estados afectivos ante un interlocutor y, en gran número de ocasiones, aparece exclusivamente el cuerpo por lo que la relación con las escalas que evalúan expresión facial ha de ser, necesariamente, nula. Esta prueba evalúa sensibilidad no verbal en situaciones complejas de interacción social, mientras que las pruebas que miden reconocimiento de expresiones faciales (ERI) valoran emociones básicas prototípicas cuya expresión es estática, abierta y fácilmente reconocibles y no dinámicas, enmascaradas y brevemente expuestas (2 segundos) como las recogidas por en el MiniPONS.

En suma, la existencia de interrelaciones positivas, aunque bajas, entre distintas medidas de sensibilidad no verbal, pueden interpretase en el sentido de que las habilidades para decodificar la expresión emocional no verbal son complejas y están compuestas por múltiples habilidades relacionadas, a la vez que independientes, unas de otras.

En relación a las diferencias observadas en las puntuaciones entre hombres y mujeres, los resultados concuerdan con diversos estudios que han puesto de manifiesto que las mujeres obtienen mayores puntuaciones en el PONS que los hombres (Hall, 1978, 1984). En la mayoría de la treintena de estudios revisados por Hall (1998), que englobaban 133 muestras de participantes, las mujeres mostraron mayores niveles de sensibilidad no verbal que los hombres, evaluada con el PONS (Rosenthal et al. 1979). Knapp y Hall (2002) concluyen que las mujeres no sólo decodifican, si no que también codifican de forma más eficiente que los hombres las señales afectivas no verbales.

Concuerdan también con numerosas investigaciones que demuestran que las mujeres obtienen puntuaciones significativamente superiores en pruebas que evalúan la habilidad para identificar expresiones faciales emocionales (Collignon, Girard, Gosselin, Saint-Amour, Lepore y Lassonde, 2010) y prosódicas (Belin, Fillion-Bilodeau y Gosselin, 2008), así como la combinación de ambas (Simon, Craig, Gosselin, Belin y Rainville, 2008), siendo más hábiles en la integración de la información emocional procedente de diversos canales sensoriales (rostro y voz) (Collignon et al., 2010). Se confirman los estereotipos sociales que atribuyen en las sociedades occidentales a la mujer ser más "emocional" que el hombre (Timmers, Fischer y Manstead, 2003); de hecho, son más reactivas fisiológicamente ante sonidos (Bradley y Lang, 2000) e imágenes emocionales (Bradley, Codispoti, Sabatinelli y Lang, 2001). Numerosas evidencias confirman que éstas realizan narraciones más vívidas, detalladas y emocionales de sus memorias autobiográficas (Bauer, Stennes y Haight, 2003), comparten socialmente sus emociones en mayor medida (Martínez-Sánchez, Blanco, Páez y Costa, en prensa; Martínez-Sánchez, Zech y Páez, 2004) y, en general, muestran una mayor complejidad y diferenciación en la expresión de sus experiencias emocionales (Barrett, Lane, Sechrest y Schwartz, 2000).

Las correlaciones negativas halladas entre la edad y el grado de sensibilidad no verbal corroboran los resultados de numerosas investigaciones en las que, de forma consistente, se informa que la capacidad para reconocer expresiones faciales decrece con la edad (Mill, Allik, Realo y Valk, 2009), no sólo en pruebas en que se presentan estímulos visuales clásicos que recogen el rostro completo como las FACS (Ekman y Friesen, 1976), especialmente ante emociones negativas (Sullivan y Ruffman, 2004; Suzuki, Hoshino, Shigemasu y Kawamura, 2007) sino también en pruebas más complejas, como la empleada en este estudio, en que presentan partes del rostro a los participantes (Sullivan, Ruffman y Hutton, 2007). Del mismo modo, la capacidad para reconocer prosodia emocional también parece verse afectada negativamente por la edad (Orbelo, Grim, Talbott y Ross, 2005; Ruffman, Henry, Livingstone y Phillips, 2008).

La correlación positiva hallada en este estudio entre la puntuación total en la escala y el nivel de éxito académico, es concordante con los resultados obtenidos por Rosenthal et al. (1979), así como con otras investigaciones que han puesto de manifiesto que los sujetos con altas capacidades de sensibilidad interpersonal son más exitosos en el desempeño de sus tareas profesionales (Hall, Bernieri, Carney, 2005; Hall y Halberstadt, 1994; Hall, Murphy y Mast, 2006; Hall et al., 2009; Schmid Mast, Jonas y Hall, 2009); por otra parte, estos sujetos están más adaptados y son mejor valorados por sus compañeros y profesores durante sus estudios elementales (Konold, Jamison, Stanton-Chapman y Rimm-Kaufman, 2010), medios (Acoach y Webb, 2004) y universitarios (Hall, Roter, Blanch y Frankel, 2009).

Disponer de altas habilidades de sensibilidad no verbal es sino una condición necesaria, no suficiente, para facilitar el ajuste personal. Se hace preciso el concurso de habilidades regulatorias (Gross, 2001), ya que los altos niveles de expresividad emocional no regulados pueden ser desadaptativos (Pérez y Riggio, 2003).

Nuestros resultados señalan que la adaptación española del MiniPONS presenta una serie de limitaciones. La primera de ellas está relacionada con que la validez de constructo, tanto convergente como discriminante, es reducida, ya que una medida de reconocimiento de emociones básicas mediante fotografías de expresiones emocionales prototípicas de las que se dispone, no es la prueba ideal para establecer la validez de convergente de una prueba de sensibilidad no verbal más general, que recoge diversas situaciones de interacción complejas. Sin embargo, no existe ningún instrumento con la que pueda compararse esta prueba, por ello, tanto los autores de la prueba, como en este estudio, hemos seleccionado una prueba de reconocimiento de emociones básicas. La desproporción en la composición del sexo es otra de las limitaciones del estudio, por ello los resultados han de ser generalizados con precaución; sin embargo el relativamente amplio número de participantes y el rango amplio de edades que recoge le confieren más validez. Por otra parte, la homogeneidad cultural de los participantes en el estudio aconseja ser prudentes también en la generalización de los resultados.

Finalmente, creemos que este instrumento es susceptible de ser empleado en el estudio experimental, así como en la clínica, de los procesos que subyacen a las diferencias individuales no sólo de la sensibilidad no verbal, si no también en la identificación, expresión y regulación emocional. La sensibilidad no verbal es un constructo muy estable, además de ser uno de los factores más importantes que componen la inteligencia emocional, ya que implica inferir correctamente los estados afectivos complejos que los interlocutores expresan, entre los que se incluyen muchos de los recogidos en esta prueba: pedir, disculparse y amonestar entre otros.

Referencias

1. Acoach, L. C. y Webb, L. M. (2004). The influence of language brokering on Hispanic teenagers' acculturation, academic performance, and nonverbal decoding skills: a preliminary study. The Howard Journal of Communication, 15, 1-19. [ Links ]

2. Bagby, R.M., Parker, J.D. y Taylor, G.J. (1994). The twenty-item Toronto Alexithymia Scale. I. Item selection and cross-validation of the factor structure. Journal of Psychosomatic Research, 38(1), 23-32. [ Links ]

3. Bänziger, T., Grandjean, D. y Scherer, K. R. (2009). Emotion recognition from expressions in face, voice, and body: The Multimodal Emotion Recognition Test (MERT). Emotion, 9(5), 691-704. [ Links ]

4. Bänziger, T., Scherer, K. R., Hall, J. A. y Rosenthal, R. (2011). Introducing the MiniPONS: A Short Multichannel Version of the Profile of Non-verbal Sensitivity (PONS). Journal of Nonverbal Behavior, 35(3), 189-204. [ Links ]

5. Baron-Cohen, S., Wheelwright, S., Hill, J., Raste, Y. y Plumb, I. (2001). The 'reading the mind m the eyes' test revised version: a study with normal adults, and adults with Asperger syndrome or high-functioning autism. Journal of Child Psychology and Psychiatry, 42(2), 241-251. [ Links ]

6. Barrett, L.F., Lane, R.D., Sechrest, L. y Schwartz, G.E. (2000). Sex differences in emotional awareness. Personality and Social Psychology Bulletin, 26(9), 1027-1035. [ Links ]

7. Bauer, P., Stennes, L., y Haight, J. (2003). Representation of the inner self in autobiography: Women's and men's use of internal states language in personal narratives. Memory, 11(1), 27-42. [ Links ]

8. Belin, P., Fillion-Bilodeau, S. y Gosselin, F. (2008). The montreal affective voices: A validated set of nonverbal affect bursts for research on auditory affective processing. Behavioural Research Methods, 40(2), 531-539. [ Links ]

9. Boyle, G. J. (1991). Does item homogeneity indicate internal consistency or item redundancy in psychometric scales? Personality and Individual Differences, 12(3), 291-294. [ Links ]

10. Bradley, M. M. y Lang, P. J. (2000). Affective reactions to acoustic stimuli. Psychophysiology, 37, 204-215. [ Links ]

11. Bradley, M. M., Codispoti, M., Sabatinelli, D. y Lang, P. J. (2001). Emotion and motivation II: Sex differences in picture processing. Emotion, 1, 300-319. [ Links ]

12. Buck, R. (1976). A test of nonverbal receiving ability: Preliminary studies. Human Communication Research, 2(2), 162-171. [ Links ]

13. Collignon, O., Girard, S., Gosselin, F., Saint-Amour, D., Lepore, F. y Lassonde, M. (2010). Women process multisensory emotion expressions more efficiently than men. Neuropsychologia, 48(1), 220-225. [ Links ]

14. DiMatteo, M. R., Friedman, H. S., y Taranta, A. (1979). Sensitivity to bodily non-verbal communication as a factor in practitioner-patient rapport. Journal of Nonverbal Behavior, 4(1), 18-26. [ Links ]

15. DiMatteo, M. R., Hays, R. D. y Prince, L. M. (1986). Relationship of physician's nonverbal communication skill to patient satisfaction, appointment noncompliance, and physician workload. Health Psychology, 5(6), 581-594. [ Links ]

16. Ekman, P. y Friesen, W.V. (1976). Pictures of Facial Affect. Palo Alto, CA: Consulting Psychology Press. [ Links ]

17. Erceg-Hurn, D. M. y Mirosevich, V. M. (2008). Modern robust statistical methods: An easy way to improve the accuracy and power of your research. American Psychologist, 63(7), 591-601. [ Links ]

18. Fernandez-Berrocal, P., Extremera, N. y Ramos, N. (2004). Validity and reliability of the Spanish modified version of the Trait Meta-Mood Scale (Validez y fiabilidad de la version española modificada de la Trait Meta-Mood Scale). Psychological Reports, 94(3), 751-755. [ Links ]

19. Gross, J. J. (2001). Emotion regulation in adulthood: Timing is everything. Current Directions in Psychological Science, 10, 214-219. [ Links ]

20. Hall, J. A. (1978). Gender effects in decoding nonverbal cues. Psychological Bulletin, 85(4), 845-857. [ Links ]

21. Hall, J. A. (1984). Nonverbal sex differences: Communication accuracy and expressive style. Baltimore: The Johns Hopkins University Press. [ Links ]

22. Hall, J. A. (1998). How big are nonverbal sex differences? The case of smiling and sensitivity to non-verbal cues. En Canary, D.J. y Dindia, K. (Eds), Sex differences and similarities in communication: Critical essays and empirical investigations of sex and gender in interaction (pp. 155-177). Mahwah, NJ: Erlbaum. [ Links ]

23. Hall, J. A. (2001). The PONS test and the psychometric approach to measuring interpersonal sensitivity. En J. A. Hall y F. J. Bernieri (Eds.), Interpersonal sensitivity: Theory and measurement (pp. 143-160). Mahwah, NJ: Erlbaum. [ Links ]

24. Hall, J. A. Bernieri, F. J., Carney, D. R. (2005). Nonverbal and Interpersonal Sensitivity. En Jinni, A. Harrigan, J. A., Rosenthal, R. y Scherer, K. R. (Eds.) The New Handbook of Methods in Nonverbal Behavior Research, pp. 267-269. Oxford: Oxford University Press. [ Links ]

25. Hall, J. A. y Bernieri, F. J. (2001). Interpersonal sensitivity: Theory and measurement. Mahwah, NJ: Erlbaum. [ Links ]

26. Hall, J. A. y Halberstadt, A. G. (1994). "Subordination" and sensitivity to nonverbal cues: A study of married working women. Sex Roles, 31, 149-165. [ Links ]

27. Hall, J. A., Andrzejewski, S. A. y Yopchick, J. E. (2009). Psychosocial correlates of interpersonal sensitivity: A meta-analysis. Journal of Nonverbal Behavior, 33(3), 149-180. [ Links ]

28. Hall, J. A., Andrzejewski, S. A., Murphy, N. A., Mast, M. S. y Feinstein, B. A. (2008). Accuracy of judging others' traits and states: Comparing mean levels across tests. Journal of Research in Personality, 42, 1476-1489. [ Links ]

29. Hall, J. A., Murphy, N. A. y Mast, M. S. (2006). Recall of nonverbal cues: Exploring a new definition of interpersonal sensitivity. Journal of Nonverbal Behavior, 30(4), 141-155. [ Links ]

30. Hall, J. A., Murphy, N. A. y Mast, M. S. (2007). Nonverbal self-accuracy in interpersonal interaction. Personality and Social Psychology Bulletin, 33, 1675-1685. [ Links ]

31. Hall, J. A., Roter, D. L., Blanch, D. C. y Frankel, R. M. (2009). Nonverbal sensitivity in medical students: Implications for clinical interactions. Journal of General Internal Medicine, 24(11), 1217-1222. [ Links ]

32. Hill, C. E., Siegelman, L., Gronsky, B. R., Sturniolo, F. y Fretz, B. R. (1981). Nonverbal communication and counseling outcome. Journal of Counseling Psychology, 28(3), 203-212. [ Links ]

33. John, O. P. y Soto, C. J. (2007). The importance of being valid. Reliability and the process of construct validation. In R. W. Robins, R. C. Fraley y R. F. Krueger (Eds.), Handbook of research methods in personality psychology (pp. 461-494). Nueva York, NY: Guilford. [ Links ]

34. Juslin, P. N. y Scherer, K. R. (2005). Vocal expression of affect. In J. A. Harrigan, R. Rosenthal, y K. Scherer (Eds.), The new handbook of methods in nonverbal behavior research (pp. 65-135). Oxford, UK: Oxford University Press. [ Links ]

35. Knapp, M.L. y Hall, J.A. (2002). Nonverbal communication in human interaction. Wadsworth: Thompson Learning, Inc. [ Links ]

36. Konold, T. R., Jamison, K. R., Stanton-Chapman, T. L. y Rimm-Kaufman, S. E. (2010). Relationships among informant based measures of social skills and student achievement: a longitudinal examination of differential effects by sex. Applied Developmental Science, 14(1), 18-34. [ Links ]

37. Lee, D. Y., Hallberg, E. T., Kocsis, M. y Haase, R. F. (1980). Decoding skills in nonverbal communication and perceived interviewer effectiveness. Journal of Counseling Psychology, 27(1), 89-92. [ Links ]

38. Martínez-Sánchez, F. (1996). Adaptación española de la escala de alexitimia de Toronto (TAS-20). Clínica y Salud, 7(1), 19-32. [ Links ]

39. Martínez-Sánchez, F., Blanco, M. L., Páez, D. y Costa, D. (en prensa). Beliefs about the effects of social sharing of emotion in alexithymia. Psicothema [ Links ]

40. Martínez-Sánchez, F., Zech, E. y Páez, D. (2004). Adaptación española del cuestionario de creencias sobre los efectos del compartimiento social de las emociones, BSEQ. Ansiedad y Estrés, 10(1), 63-74. [ Links ]

41. Mast, M. S., Jonas, K. y Hall, J. A. (2009). Give a person power and he or she will show interpersonal sensitivity: the phenomenon and its why and when. Journal of Personality and Social Psychology, 97(5), 835-850. [ Links ]

42. Mayer, J. D. y Salovey, P. (1993). The intelligence of emotional intelligence. Intelligence, 17(4), 433-442. [ Links ]

43. Mayer, J. D., Salovey, P., Caruso, D. R. y Sitaremos, G. (2003). Measuring emotional intelligence with the MSCEIT V2.0. Emotion, 3(1), 97-105. [ Links ]

44. Mill, A., Allik, J., Realo, A., Valk, R. (2009). Age-related differences in emotion recognition ability: a cross-sectional study. Emotion, 9(5), 619-630. [ Links ]

45. Miller, A. B. y Lenzenweger, M. F. (2012). Schizotypy, social cognition and interpersonal sensitivity. Personality Disorders: Theory, Research, and Treatment, May 28, [ Links ]

46. Nowicki, S. y Duke, M. P. (1994). Individual differences in the nonverbal communication of affect: The Diagnostic Analysis of Nonverbal Accuracy scale. Journal of Nonverbal Behavior, 18(1), 9-35. [ Links ]

47. Orbelo, D. M., Grim, M. A., Talbott, R. E. y Ross, E. D. (2005). Impaired comprehension of affective prosody in elderly subjects is not predicted by age-related hearing loss or age-related cognitive decline. Journal of Geriatric Psychiatry and Neurology, 18(1), 25-32. [ Links ]

48. Pérez, J. E. y Riggio, R. E. (2003). Nonverbal social skills and psychopathology. En P. Philippot, E. J. Coats y R. S. Feldman (Eds.), Nonverbal behavior in clinical settings (pp. 17-44). New York: Oxford University Press. [ Links ]

49. Riggio, R. E. (1989). Manual for the Social Skills Inventory: Research edition. Palo Alto, CA: Consulting Psychologists Press. [ Links ]

50. Riggio, R. E. (2006). Nonverbal skills and abilities. En V. Manusov y M. L. Patterson (Eds.), The Sage handbook of nonverbal communication (pp. 79-96). Thousand Oaks, CA: Sage. [ Links ]

51. Roberts, R. D., Schulze, R., O'Brien, K., MacCann, C., Reid, J. y Maul, A. (2006). Exploring the validity of the Mayer-Salovey-Caruso Emotional Intelligence Test (MSCEIT) with established emotions measures. Emotion, 6(4), 663-669. [ Links ]

52. Rosenthal, R., Hall, J. A., DiMatteo, M. R., Rogers, P. L. y Archer, D. (1979). Sensitivity to nonverbal communication: The PONS Test. Baltimore: The Johns Hopkins University Press. [ Links ]

53. Ruffman, T., Henry, J. D., Livingstone, V. y Phillips, L. H. (2008). A meta-analytic review of emotion recognition and aging: Implications for neuropsychological models of aging. Neuroscience and Biobehaviorai Reviews, 32(4), 863-881. [ Links ]

54. Russell, J. A. y Fernandez-Dols, J. M. (Eds.)(1997). The Psychoiogy of Faciai Expression. Cambridge, UK: Cambridge University Press. [ Links ]

55. Salguero, J. M., Fernandez-Berrocal, P., Balluerka, N. y Aritzeta, A. (2010). Measuring perceived emotional intelligence in adolescent population: psychometric properties of the Trait Meta Mood Scale. Sociai Behavior and Personaiity, 38(9), 1197-1210. [ Links ]

56. Salovey, P., Mayer, J. D., Goldman, S. L., Turvey, C., y Palfai, T. P. (1995). Emotional attention, clarity, and repair: exploring emotional intelligence using Trait Meta-Mood Scale. En J. W. Pennebaker (Ed.), Emotion, Disciosure, & Heaith (pp. 125-154). Washington: American Psychological Association. [ Links ]

57. Sawilowsky, S. y Blair, R. C. (1992). A more realistic look at the robustness and type II error properties of the t test to departures from population normality. Psychoiogical Bulletin, 111(22), 353-360. [ Links ]

58. Scherer, K. R. (2007). Component models of emotion can inform the quest for emotional competence. En G. Matthews, M. Zeidner y R. D. Roberts (Eds.), The science of emotionai intelligence: Knowns and unknowns (pp. 101-126). New York: Oxford University Press. [ Links ]

59. Scherer, K. R. (2009). The dynamic architecture of emotion: Evidence for the component process model. Cognition and Emotion, 23(7), 1307-1351. [ Links ]

60. Scherer, K. R. y Bänziger, T. (2010). On the use of actor portrayals in research on emotional expression. En K. R. Scherer, T. Bänziger y E. B. Roesch, (Eds.), Blueprint for affective computing: A sourcebook (pp. 166-178). Oxford: Oxford University Press. [ Links ]

61. Scherer, K. R. y Scherer, U. (2011). Assessing the ability to recognize facial and vocal expressions of emotion: Construction and validation of the Emotion Recognition Index (ERI). Journal of Nonverbal Behavior, 35(4), 305-326. [ Links ]

62. Scherer, K. R., Banse, R., Wallbott, H. G. y Goldbeck, T. (1991). Vocal cues in emotion encoding and decoding. Motivation and Emotion, 15(2), 123-148. [ Links ]

63. Simon, D., Craig, K. D., Gosselin, F., Belin, P. y Rainville, P. (2008). Recognition and discrimination of prototypical dynamic expressions of pain and emotions. Pain, 135(1-2), 55-64. [ Links ]

64. Sullivan, S. y Ruffman, T. (2004). Emotion recognition deficits in the elderly. International Journal of Neuroscience, 114(3), 403-432. [ Links ]

65. Sullivan, S., Ruffman, T. y Hutton, S. B. (2007). Age differences in emotion recognition skills and the visual scanning of emotion faces. Journal of Gerontology, 62B(1), 53-60. [ Links ]

66. Suzuki, A., Hoshino, T., Shigemasu, K. y Kawamura, M. (2007). Decline or improvement? Age-related differences in facial expression recognition. Biological Psychology, 74(1), 75-84. [ Links ]

67. Tickle-Degnen, L. (1998). Working well with others: The prediction of students' clinical performance. American Journal of Occupational Therapy, 52(2), 133-142. [ Links ]

68. Timmers, M., Fischer, A. y Manstead, A. (2003). Ability versus vulnerability: Beliefs about men's and women's emotional behaviour. Cognition & Emotion, 17(1), 41-63. [ Links ]

69. Wallbott, H. G. (1998). Bodily expression of emotion. European Journal of Social Psychology, 28(6), 879-896. [ Links ]

![]() Dirección para correspondencia:

Dirección para correspondencia:

Francisco Martínez-Sánchez

Dpto. de Psicología Básica y Metodología

Facultad de Psicología

Universidad de Murcia

Campus Universitario de Espinardo

30100 Murcia (España)

E-mail: franms@alum.es

Articulo recibido: 28-10-2012

revisado: 14-11-2012

aceptado: 8-1-2013