PROCESO EVALUATIVO

Los psicólogos utilizan los test para obtener muestras de conducta que les ayuden a tomar decisiones sobre las personas, bien sea en el ámbito clínico, laboral, educativo, jurídico, u otros muchos en los que desarrollan su labor. Los test no tienen vida propia, no son autónomos, no toman las decisiones por sí mismos, las decisiones las toman los profesionales, eso sí, apoyados en datos objetivos, en evidencias, y es ahí cuando entran en escena los test. Como bien nos alertó tempranamente Paul Meehl (1954) en su inquietante librito, como él lo llamaba, los psicólogos deben abstenerse de hacer diagnósticos y tomar decisiones basándose únicamente en su juicio clínico, deben apoyarse en datos objetivos, y una fuente clave para obtenerlos, no la única, son los test. Un proceso de evaluación psicológica es más amplio y complejo que el mero hecho de utilizar los test de forma correcta (Fernández-Ballesteros, 2014; Fernández-Ballesteros et al., 2001; Groth-Marnat y Wright, 2016; Wright, 2011), exige dar respuesta a otras muchas cuestiones capitales, entre las que cabe destacar las siguientes: qué se evalúa y para qué, quién evalúa, cuáles son las partes legítimamente implicadas en la evaluación, cómo se evalúa, cómo se va a proporcionar la información a las partes implicadas (feedback), qué planes de mejora e intervenciones se derivan de la evaluación, y finalmente, cómo perciben la evaluación los distintos agentes implicados. Lo primero es dejar muy claro qué y para qué se evalúa, pues ello determinará el tipo de instrumentos y estrategias a seguir. Como dejó dicho nuestro Séneca, nunca soplan vientos favorables para quienes no saben a qué puerto se dirigen. Naturalmente, lo que se evalúa y para qué se hace variará en cada situación aplicada, no hay recetas válidas para todos los casos, serán los profesionales quienes tengan que decidirlo en cada caso. Quién es el responsable de la evaluación es la segunda cuestión que debe quedar meridianamente clara, habrá situaciones en las resulte obvio, pero en otras pueden surgir dudas. Siempre que se trate de evaluar variables psicológicas el responsable debe ser un profesional de la psicología, aunque algunas labores auxiliares puedan delegarse, por ejemplo, la aplicación de los test, pero nunca la interpretación de los resultados o la elaboración de un diagnóstico. En tercer lugar, en un proceso evaluador hay que identificar a todas las partes legítimamente implicadas en la evaluación, que variarán según cada situación. El fallo en esta identificación puede arruinar la evaluación, independientemente de su diseño técnico. Así, por ejemplo, en un contexto educativo habrá que tener en cuenta, por supuesto al alumnado evaluado, pero también a los padres, profesores, dirección del centro, administración educativa, representantes legales de los profesores, entre otros. Todos juegan su papel legítimo, han de ser tenidos en cuenta, pues cualquiera de ellos puede hacer fracasar una evaluación, ya se sabe que es más fácil destruir que construir. En cuarto lugar, está el meollo central desde el punto de vista técnico, es decir, cómo se lleva a cabo la evaluación, qué instrumentos de medida y qué recursos se van a utilizar. Ni que decir tiene que los profesionales deben utilizar test que reúnan unas propiedades psicométricas adecuadas y usarlos de forma correcta. En la actualidad contamos con numerosas fuentes sobre la construcción y análisis de la calidad de los test (American Educational Research Association, American Psychological Association y National Council on Measurement in Education, 2014; Downing y Haladyna, 2006; Haladyna y Rodríguez, 2013; Irwing, Booth y Hughes, 2018; Lane, Raymond y Haladyna, 2016; Muñiz, 2018; Muñiz y Fonseca-Pedrero, 2019; Schmeiser y Welch, 2006). Muchas evaluaciones que llevan a cabo con éxito las cuatro fases descritas fallan de forma lamentable en la quinta, relativa a proporcionar la información adecuada (feedback) a todas las partes legítimamente implicadas. Cuando se diseña una evaluación hay que tener muy claro desde el principio el tipo de informe que se va a realizar para cada parte interviniente, siendo un error muy común el pensar que un modelo de informe es suficiente para todos, la talla única tampoco funciona aquí. No es infrecuente que una evaluación bien diseñada y ejecutada se eche a perder a la hora de comunicar los resultados. Hay que ser muy cuidadosos con los informes, y asegurarse de que los destinatarios los entienden, pues una buena evaluación mal comunicada se convierte automáticamente en una evaluación deficiente. Sobre el problema de la elaboración de informes pueden verse, por ejemplo, los trabajos de Goodman y Hambleton (2004), Ryan (2006), o Zenisky y Hambleton (2016). En sexto lugar, los profesionales deben ser conscientes de que no se evalúa por evaluar, lo más lógico es que la evaluación desemboque en el desarrollo de algún plan de mejora o intervención. Cuando se lleven a cabo planes de mejora estos deben ser viables, basados en evidencias y evaluables, para así poder comprobar empíricamente su eficacia. Finalmente, algo que se olvida con demasiada frecuencia es la necesidad de recabar de forma objetiva y sistemática la opinión de las partes implicadas sobre la evaluación. La percepción de los participantes es clave, pues va a modular de forma importante su éxito. Los participantes no tienen por qué ser expertos en cuestiones técnicas, casi nunca lo serán, pero no por ello su opinión es menos importante, no hace falta ser zapatero para opinar sobre unos zapatos. En suma, lo que se pretende subrayar en las líneas precedentes es que el desarrollo de un proceso evaluativo es mucho más amplio y complejo que la mera aplicación de test, si bien estos son cruciales en el proceso. Dicho lo cual, vamos a centrarnos ahora precisamente en la problemática implicada en la utilización de los test como instrumentos de evaluación y diagnóstico.

UTILIZACIÓN DE LOS TEST

Un uso inadecuado de los test puede causar graves perjuicios a las personas evaluadas. Por ello distintas organizaciones nacionales e internacionales vienen desarrollando acciones y programas para tratar de mejorar tres aspectos esenciales: la formación de los profesionales, la calidad de los test y la utilización que se hace de ellos. Las acciones llevadas a cabo por los Colegios Oficiales de Psicólogos (COP) y por organizaciones internacionales como la International Test Commission (ITC), o la Federación Europea de Asociaciones de Psicólogos (EFPA), pueden agruparse en dos grandes estrategias, denominadas restrictiva e informativa. Las acciones restrictivas se refieren a la limitación o restricción del uso de las pruebas a personas que tengan una formación adecuada. Esto varía mucho de unos países a otros (Bartram, 1996; Bartram y Coyne, 1998; Evers et al., 2012, 2017; Muñiz, Prieto, Almeida y Bartram, 1999), por ejemplo, los editores españoles clasifican los test en tres categorías (A, B, C) en función de su especialización, y solo venden los de las categorías B (test colectivos cognitivos y de personalidad) y C (escalas individuales y test proyectivos) a quienes acrediten el título de psicólogos. Esta y otras medidas, aunque adecuadas, no constituyen una garantía total, por lo que hay que complementarlas con otras de carácter informativo. La idea es que tanto los profesionales como los usuarios dispongan de toda la información necesaria sobre los test, para así minimizar su uso inadecuado. Entre estas acciones cabe destacar la publicación de códigos éticos, tales como el de la EFPA (2005), o las directrices de la asociación europea de evaluación psicológica (Fernández-Ballesteros et al., 2001). Un buen compendio en español puede verse en el número monográfico de la revista Papeles del Psicólogo (2009) dedicado al tema, o en autores como Knapp (2012), Koocher y Keith-Spiegel (2007), Lindsay, Koene, Ovreeide y Lang (2008), Leach y Oakland (2007), o Muñiz (1997). Aparte de estos códigos éticos hay todo un conjunto de directrices para orientar la construcción, análisis, uso y evaluación de la calidad de los test, entre las que cabe destacar los estándares técnicos desarrollados por la Asociación Americana de Psicología y otras dos organizaciones (AERA, APA y NCME, 2014), así como las directrices elaboradas por la ITC para la traducción y adaptación de los test de unas culturas a otras (Hambleton, Merenda y Spielberger, 2005; ITC, 2017; Muñiz, Elosua y Hambleton, 2013), o para su uso en investigación, control de calidad y seguridad (Muñiz, Hernández y Ponsoda, 2015). Para consultar otras directrices de interés, véase, por ejemplo, el trabajo de Muñiz y Bartram (2007), las páginas web de la ITC (www.intestcom.org), la EFPA (www.efpa.eu), o el COP (www.cop.es) en el apartado dedicado a la Comisión de Test.

Mención especial requiere la Norma ISO 10667 (AENOR, www.aenor.es), que regula todo lo relativo a la evaluación de personas en entonos laborales, y en cuya elaboración participó activamente el COP, formando parte de la comisión internacional que la desarrolló. En la norma se describen las competencias, obligaciones y responsabilidades de los clientes y de los proveedores del servicio de evaluación, antes, durante y después del proceso evaluativo. También proporciona directrices para todas las partes implicadas en el proceso evaluador, incluida la propia persona evaluada y quienes reciban los resultados de la evaluación (Muñiz y Fernández-Hermida, 2010). La norma está teniendo una gran influencia en la evaluación psicológica en contextos laborales, pues si bien no tiene rango de ley como tal, aporta un protocolo riguroso de actuación, prestigiando a las compañías que la adoptan. Las empresas e instituciones pueden certificarse en las agencias correspondientes si demuestran a los auditores que siguen los procesos de evaluación establecidos en la norma.

Otra actividad clave dentro de la estrategia de diseminar información rigurosa sobre los test es la publicación de los resultados de su evaluación por parte de expertos para ayudar a los profesionales a valorar los test más adecuados para sus fines. Hay dos grandes modelos de evaluación de la calidad de los test, uno de carácter más cualitativo, utilizado por el Buros Center for Testing en Estados Unidos, que viene a ser una revisión literaria en la que se comentan los puntos fuertes y débiles de la prueba evaluada (Carlson y Geisinger, 2012; Elosua y Geisinger, 2016; Geisinger, 2012, 2016), y otro el europeo, que tiene un carácter mixto cualitativo-cuantitativo. Se puntúan de 1 a 5 cada una de las características psicométricas del test y estas valoraciones numéricas se complementan con una evaluación cualitativa de los principales aspectos de la prueba. El modelo europeo puede consultase en la página web de la EFPA (www.efpa.eu), y los detalles de su revisión pueden verse en Evers et al. (2013). La versión española del Cuestionario de Evaluación de Test Revisado (CET-R) puede consultarse en la página web del COP (www.cop.es) y el proceso de adaptación seguido en Hernández, Ponsoda, Muñiz, Prieto y Elosua (2016). Utilizando este modelo CET-R ya se han llevado a cabo en España siete evaluaciones anuales de test, estando actualmente en marcha la octava (Elosua y Geisinger, 2016; Fonseca-Pedrero y Muñiz, 2017; Gómez-Sánchez, 2019; Hernández, Tomás, Ferreres y Lloret, 2015; Hidalgo y Hernández, 2019; Muñiz et al., 2011; Ponsoda y Hontagas, 2013). Hasta la fecha se han revisado un total de setenta y dos test, pudiendo consultarse libremente las revisiones en la página web del COP. Lo ideal sería que la mayoría de los test publicados en nuestro país estuviesen revisados, como ocurre en Holanda, no obstante, en el contexto europeo somos de los países que más avanzado lleva el proyecto de evaluación de test. Hay que destacar el papel de los editores españoles de test (CEPE, GiuntiEOS Psychometrics, Pearson y TEA), que en todo momento han colaborado en las evaluaciones, y ofrecido su ayuda y experiencia para ir mejorando la calidad de los test que editan, lo cual revertirá en beneficio de todos: profesionales, usuarios y las propias editoriales.

Esta evaluación ofrece dos grandes ventajas, por un lado, proporciona una información de primera mano a los profesionales sobre la calidad de los test, y, por otro, sirve de guía a constructores y editores, orientándoles sobre las características psicométricas exigibles a las pruebas. Un tercer aspecto nada desdeñable es su importancia en la docencia y formación de los futuros psicólogos (Hidalgo y Hernández, 2019).

OBJETIVO

Dentro del contexto de acciones encaminadas a la mejora de la práctica de los test, la EFPA ha impulsado la aplicación de una encuesta para conocer las opiniones de los psicólogos sobre el uso de los test en cada país. Conocer esta opinión es clave para promover acciones y proyectos sobre aquellos aspectos que sean percibidos como deficitarios por los profesionales. Los primeros datos en seis países europeos se obtuvieron en el año 2000 (Muñiz et al., 2001), y una buena panorámica sobre los resultados obtenidos a partir de entonces en Europa puede verse en Evers, Muñiz, Bartram et al. (2012). La misma encuesta fue utilizada también en otros países no europeos (Evers, McCormick, Hawley, Muñiz, et al. 2017). En España la primera encuesta para conocer las opiniones de los profesionales sobre los test se llevó a cabo en 1999 (Muñiz y Fernández-Hermida, 2000), y se volvió a repetir diez años después, actualizando el cuestionario utilizado inicialmente (Muñiz y Fernández-Hermida, 2010). Como se puede ver en los trabajos citados, en líneas generales las opiniones de los psicólogos españoles sobre el uso de los test en nuestro país son bastante positivas, si bien se identifican algunos aspectos que sería deseable mejorar.

Transcurrida una década desde que se aplicase la última encuesta, el objetivo central del presente trabajo es recoger las opiniones de los psicólogos españoles sobre el uso de los test en nuestro país y su evolución. Conocer estas opiniones es un primer paso fundamental para poder llevar a cabo acciones y proyectos encaminados a mejorar todo lo relativo a la práctica de los test. Se trata, en suma, de dar respuestas a preguntas tales como ¿Qué opinión tienen los psicólogos sobre los test? ¿Creen que se utilizan adecuadamente? ¿Les parecen caros? ¿Cuáles son los problemas más importantes? ¿Conocen la evaluación anual de test que lleva a cabo el COP? ¿Qué opinan sobre ella?

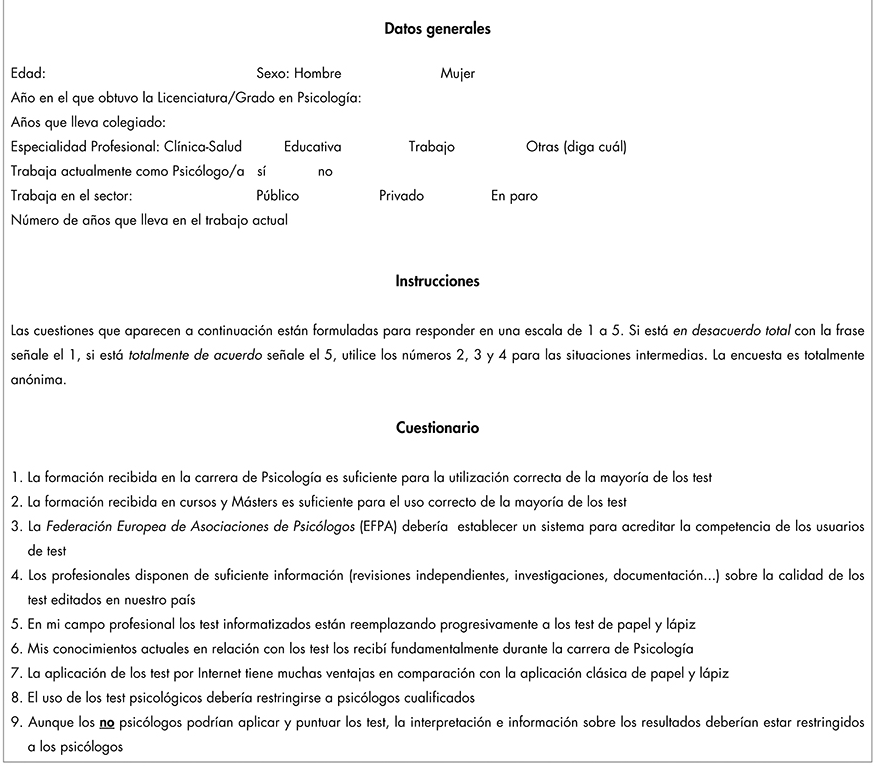

ENCUESTA

El cuestionario utilizado en 2019 es el mismo que el ya utilizado diez años atrás con algunas modificaciones, unas dirigidas a matizar algunos aspectos sobre los test que no se habían incluido entonces (ítems 25, 26, 27, 28-9, 28-10, 28-11), y otras a recabar la opinión de los psicólogos acerca del proceso de evaluación anual de test que lleva a cabo el COP desde 2011 (ítems 29-1, 29-2, 29-3, 29-4, 29-5). Todos los ítems de respuesta cerrada tienen un formato tipo Likert con cinco categorías, excepto el ítem 29-1 que es dicotómico. Precisamente en este ítem, si la persona responde que no conoce la evaluación anual de test que lleva a cabo el COP, la aplicación informática salta las cuatro preguntas siguientes (29.2, 29.3, 29.4, 29.5), relativas a dicha evaluación, y pasa directamente al ítem 30, en el que se pregunta por los tres test más utilizados por los encuestados. La encuesta utilizada puede verse en el Anexo 1.

PARTICIPANTES

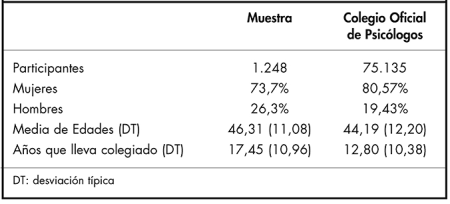

Respondieron a la encuesta 1.248 colegiados de un total de 75.135 que componen el COP. Las características principales de los participantes aparecen en lastablas 1 y2. La muestra está formada por un 73,7% de mujeres y un 26,3% de hombres, y dado que el COP está compuesto por un 80,57% de mujeres y un 19,43% de hombres, se observa una mayor participación de los hombres en la encuesta. En cuanto a la edad, el 6,3% tienen entre 23 y 29 años, el 24,1% entre 30 y 39, el 27,4% entre 40 y 49, el 29,1% entre 50 y 59, el 12,4% entre 60 y 69, y el 0,7% tiene 70 años o más, siendo el promedio de edad de los participantes de 46,31 años, con una desviación típica de 11,08 años. Este promedio es similar a la media de las edades del COP que está en 44,19 años con desviación típica de 12,2. Estos datos parecen indicar que la muestra utilizada representa razonablemente bien a la población de colegiados del COP, aunque hubiese sido deseable un mayor número de participantes. En cuanto a las especialidades predomina Clínica-Salud (67,6%), seguida de Educativa (12,7%) y Trabajo (5,5%). Otras especialidades, como deporte, jurídica, tráfico, servicios sociales, etc., constituyen el 14,1% restante. Resulta interesante notar que en Clínica y Educativa el porcentaje de hombres es del 24,6% y el 25,8%, respectivamente, mientras que en el área de Trabajo dicho porcentaje aumenta hasta el 48%. La mayoría trabaja en el sector privado (69,9%), independientemente de la especialidad: Clínica-Salud (74,5%), Educativa (66,7%) y Trabajo (62,3%). Un 91,2% de los encuestados trabajan como psicólogos, y sólo un 8,8% ejercen otro tipo de trabajos.

PROCEDIMIENTO

La encuesta se aplicó online, a través de un enlace en la página web del COP. El sistema informático utilizado verificaba que la persona estaba colegiada, y no daba la posibilidad de responder la encuesta más de una vez. Para difundirla entre los colegiados se utilizaron distintos medios, tales como Infocop, la Agenda, o el Congreso Nacional de Psicología, explicando los objetivos de la misma y solicitando la participación. También se envió un correo electrónico a los colegiados, informándoles de la encuesta y animándoles a responderla. Al entrar a la encuesta, los participantes daban su consentimiento informado y se garantizó el tratamiento confidencial de los datos.

ANÁLISIS DE LOS DATOS

Se calcularon los estadísticos descriptivos de los ítems y de las dimensiones factoriales obtenidas. La fiabilidad se evaluó mediante el coeficiente Alfa (Cronbach, 1951). Para el estudio de las diferencias entre las medias de las especialidades se utilizó el análisis de varianza. La estructura dimensional se estimó mediante un análisis de Componentes Principales, utilizando el Análisis Paralelo sobre una matriz de correlaciones policóricas, con rotación oblicua (Calderón, Navarro, Lorenzo-Seva y Ferrando, 2019; Ferrando y Lorenzo-Seva, 2017; Ferrando y Anguiano, 2010; Izquierdo, Olea y Abad, 2014; LLoret-Segura, Ferreres-Traver, Hernández-Baeza y Tomás-Marco, 2014). Los análisis se llevaron a cabo con los programas SPSS (IBM, 2016) y FACTOR (Ferrando y Lorenzo-Seva, 2017; Lorenzo-Seva y Ferrando, 2013).

DIMENSIONES EVALUADAS POR EL CUESTIONARIO

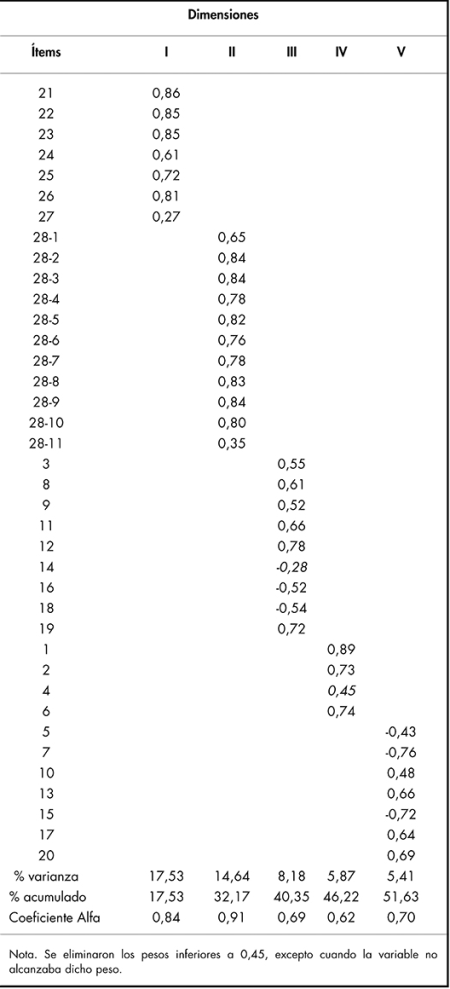

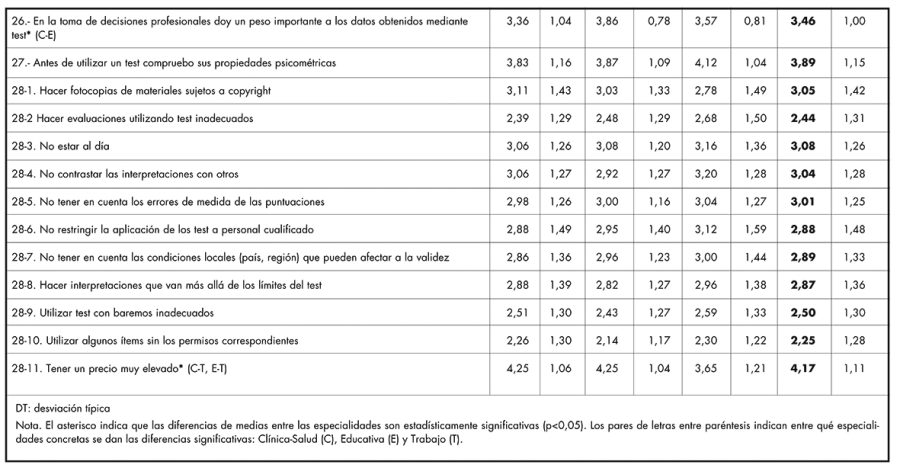

Se obtuvieron cinco dimensiones principales (tabla 3) que explican el 51,63% de la varianza total.

La primera dimensión se refiere a las actitudes de los psicólogos hacia los test por considerarlos una herramienta útil (ítems 21-26), más el ítem 27 que presenta una saturación factorial débil. La segunda agrupa los ítems relativos a los problemas de uso de los test, recoge los 11 problemas presentados en el cuestionario (ítems 28-1 a 28-11). La tercera recoge los ítems relativos a la regulación de los test y su uso. Como cabría esperar los ítems referidos a la necesidad de legislación y regulación del uso de los test presentaron saturaciones positivas, mientras que los referidos a la permisividad en su uso presentaron saturaciones negativas. La cuarta dimensión se refiere a la formación y conocimientos sobre los test (ítems 1, 2, 4 y 6). Finalmente, la quinta recoge el uso de internet, la informatización y automatización (ítems 5, 7, 10, 13, 15, 17 y 20). Los ítems que presentan saturaciones positivas son los que ponen en duda la validez y potencial de estos avances tecnológicos, mientras que los que presentan saturaciones negativas, plasman un reconocimiento a las ventajas de los test informatizados y el uso de internet. El cuarto componente, referido a formación y conocimientos sobre los test, es el que presenta una fiabilidad más baja, pudiendo atribuirse en gran medida al reducido número de ítems que conforman esta dimensión. En suma, teniendo en cuenta los resultados obtenidos parece razonable pensar que los ítems del cuestionario se organizan en torno a cinco grandes dimensiones, que podrían describirse como: actitudes hacia los test, problemas de uso, regulación del uso de los test, formación-conocimientos, y el uso de internet, la informatización y automatización. Cabe señalar que en las ediciones anteriores de la encuesta se obtuvieron ocho dimensiones en vez de cinco como ahora, lo cual es debido a que el método de extracción de dimensiones utilizado entonces (regla de Kaiser) tiende a generar estructuras factoriales más fragmentadas. Aunque no se incluye aquí por parsimonia, se han analizado también los datos utilizando dicho método y los resultados confirman en general los obtenidos en ediciones anteriores.

OPINIONES SOBRE EL USO DE LOS TEST

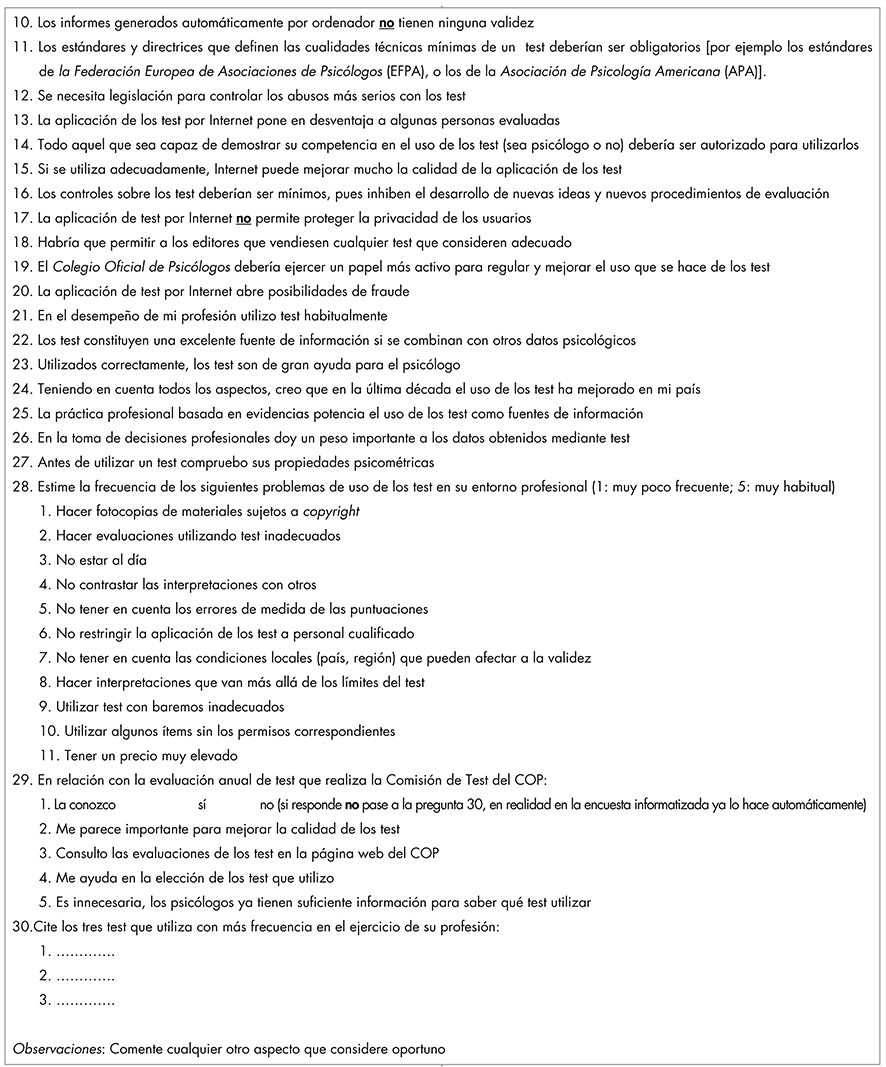

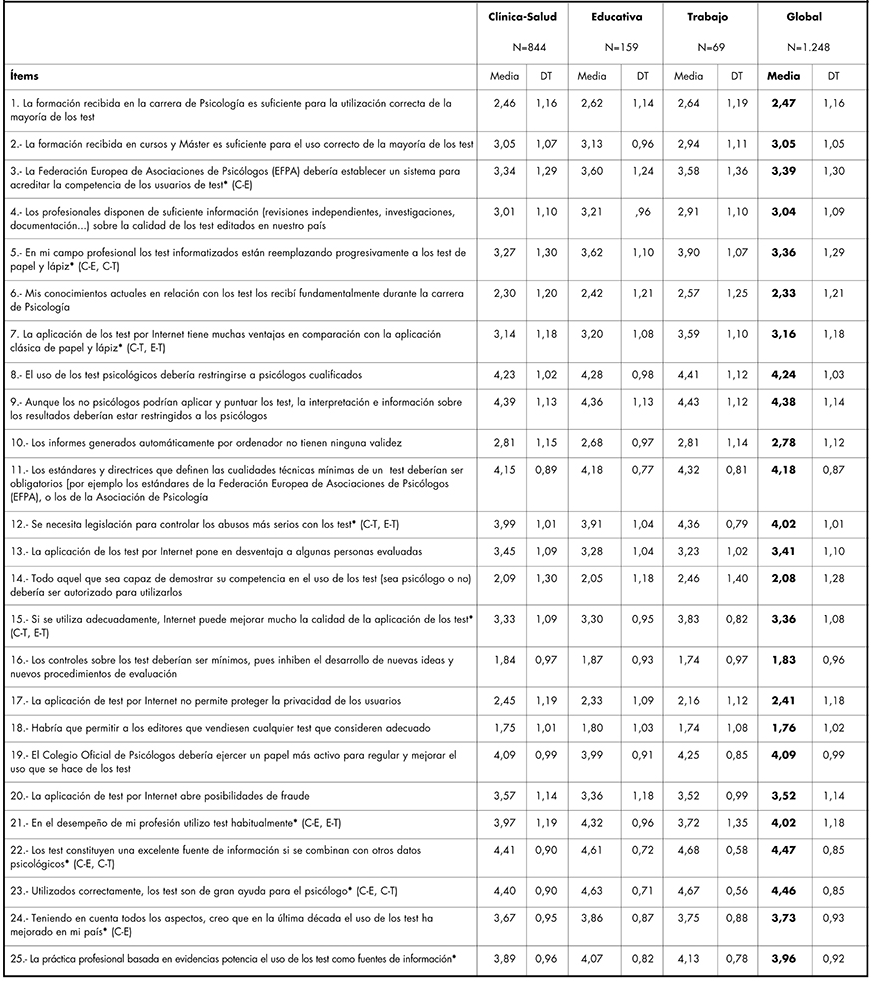

En la Tabla 4 se muestran las medias y las desviaciones típicas de las respuestas de los participantes a los ítems del cuestionario. Se ofrecen los datos de la muestra total y dividida por especialidades profesionales de Clínica-Salud, Educativa y Trabajo. Las diferencias entre las medias de las especialidades se estudiaron mediante el análisis de varianza. Cuando no se cumplía el supuesto de homogeneidad de las varianzas (ítems 5, 11,15, 17, 19, 21, 22, 23, 24, 26 y 28-2) se empleó la prueba robusta de Brown-Forsythe para las comparaciones. El asterisco detrás del texto del ítem indica que existieron diferencias significativas entre especialidades (p<0,05), y entre paréntesis figuran los pares de comparaciones que resultaron estadísticamente significativas (La C se refiere a Clínica-Salud, la E a Educación y la T a Trabajo).

TABLA 4. MEDIA Y DESVIACIÓN TÍPICA DE CADA UNO DE LOS ÍTEMS DE LA ENCUESTA POR ESPECIALIDADES (CLÍNICA-SALUD, EDUCATIVA, TRABAJO) Y GLOBAL

Los datos de la tabla hablan por sí mismos, pero cabe mencionar algunos aspectos reseñables. El primero (ítems 1 y 6) es que los colegiados consideran, con muy buen criterio, que los conocimientos obtenidos en la carrera de Psicología no son suficientes para el uso adecuado de la mayoría de los test, por tanto, es necesario seguir formándose. También alertan los profesionales de que los test informatizados (ítem 5) van reemplazando progresivamente a los clásicos de papel y lápiz, y ello con mayor intensidad en el ámbito educativo, y sobre todo en el de trabajo. Hay un consenso claro sobre la necesidad de que sean los psicólogos quienes utilicen e interpreten los resultados de los test (ítems 8 y 9). Los psicólogos son muy conscientes de las posibilidades de fraude que abre la aplicación de test por internet (ítems 17 y 20), y reclaman que el COP ejerza un papel más activo para mejorar el uso de los test (ítem 19). Los psicólogos utilizan habitualmente los test en el ejercicio de su profesión (ítem 21), especialmente en el ámbito educativo, seguido de clínica y trabajo, y no tienen dudas sobre su utilidad si se usan adecuadamente (ítems 22 y 23). Tienen además la percepción de que en la última década el uso de los test ha mejorado en España (ítem 24). En cuanto a los problemas en el uso de los test en nuestro país (ítems 28-1 al 28-11) su percepción es bastante positiva, quejándose, eso sí, sobre el elevado precio de las pruebas, especialmente en clínica y educativa.

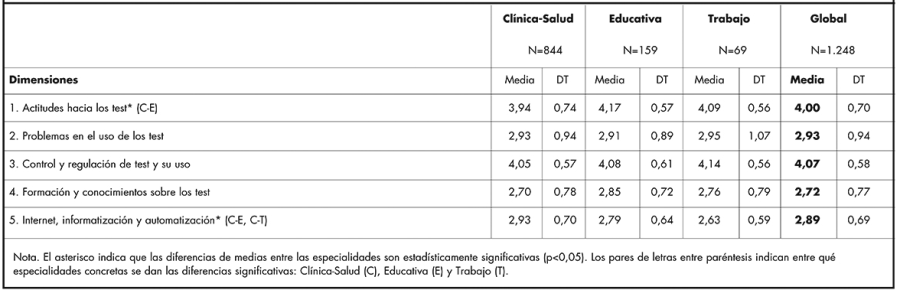

En la tabla 5 se muestran las medias y las desviaciones típicas de las respuestas de los participantes a las cinco dimensiones del cuestionario. Los ítems que presentaban saturaciones negativas en las dimensiones tres y cinco fueron invertidos antes de calcular la puntuación total. De esta manera una mayor puntuación indica una opinión más positiva hacia el control y legislación sobre los test y su uso, y una opinión más negativa hacia el uso de la tecnología (uso de internet, test informatizados, informes automatizados). Se ofrecen los resultados globales y para las tres especialidades, cuyas medias son comparadas mediante un ANOVA, con excepción de la primera dimensión, para la que se utilizó la prueba de Brown-Forsythe por no cumplirse el supuesto de homogeneidad de varianzas.

TABLA 5. MEDIA Y DESVIACIÓN TÍPICA DE LAS DIMENSIONES POR ESPECIALIDADES (CLÍNICA-SALUD, EDUCATIVA, TRABAJO)

Como se puede ver en la tabla 5, las actitudes de los psicólogos españoles hacia los test son bastante favorables, con una media global de 4 puntos en una escala que va de 1 a 5. Los especialistas en educativa y trabajo son algo más favorables que los clínicos, lo cual no deja de tener su lógica, dada la naturaleza del ejercicio profesional de las especialidades. Como ya se señaló al comentar los resultados desglosados por ítems, los psicólogos españoles no encuentran problemas graves de uso de los test, con una media de 2,93. Manifiestan una clara posición a favor de un mayor control y regulación del uso de los test, con una media de 4,07 en esa dimensión. Claramente demandan una necesidad de formación continua, como muestra una media de 2,72 en la dimensión 4. Y no se muestran muy entusiastas con el uso de las nuevas tecnologías (internet, informatización, automatización); en concreto los especialistas en clínica son algo más escépticos respecto a la utilidad de los avances tecnológicos y perciben más problemas en su uso (2,93), que los especialistas en Educativa (2,79) y Trabajo (2,63).

CONOCIMIENTO DE LA EVALUACIÓN DE TEST

En cuanto a la pregunta de si conocen la evaluación anual de test que lleva a cabo el COP, sorprende comprobar que sólo dicen conocerla el 22,5% de los colegiados, hay, por tanto, un 77,5% que desconocen esta importante evaluación, por lo que está clara la necesidad insistir en su difusión. Entre quienes sí la conocen, les parece importante y necesaria, como se observa en los datos de la tabla 6.

EVOLUCIÓN DE LAS OPINIONES

En la tabla 7 aparecen las puntuaciones medias para cada ítem en las tres evaluaciones llevadas a cabo en los años 2000, 2010 y 2020. Dado que las encuestas utilizadas en las tres evaluaciones no tienen exactamente los mismos ítems, sólo se ofrecen los resultados para los ítems comunes a las tres. Como se puede observar, la característica general más sobresaliente es la estabilidad, pero con algunos matices dignos de mención. Las correlaciones entre los resultados de las tres evaluaciones son muy elevadas: 0,986 entre la 1ª y 2ª, 0,955 entre la 1ª y la 3ª, y 0,982 entre la 2ª y la 3ª.

El primer aspecto a destacar es que los psicólogos españoles aprecian que mejora la información de la que disponen sobre la calidad de los test (ítem 4), pasando de un valor medio en 2010 de 2,73 a una media de 3,04 en 2020. Seguramente no es ajeno a esa percepción la labor de evaluación de los test llevada a cabo por el COP a lo largo de la última década. Otro aspecto a destacar es el aumento del uso de los test en el ejercicio de la profesión (ítem 21), pasando de un valor de 3,76 en 2010 a 4,02 en 2020. Esto constituye un indicador indirecto de la actitud positiva hacia los test, así como una apuesta clara sobre un ejercicio de la profesión basado en evidencias empíricas obtenidas a partir de los test. Cabe reseñar, en tercer lugar, que todos los ítems relativos a los problemas en el uso de los test (ítem 28) bajan sus valores medios, lo que significa que los profesionales perciben una mejora general en el uso de los test. El cambio más significativo se da en el ítem 28-1, relativo a las fotocopias de los test, que pasa de 3,51 en 2010 a 3,05 en 2020. Seguramente el aumento de los test online y las correcciones informatizadas haya favorecido esta percepción. También perciben que los test se ajustan mejor a las condiciones locales (país, región) que hace una década (ítem 28-7), pasando la media de 3,21 a 2,89 al evaluar el problema de la falta de ajuste. Parece surtir efecto el esfuerzo de las organizaciones nacionales como el COP, internacionales, como la ITC, y los propios editores, en traducir y adaptar los test a las condiciones de las poblaciones evaluadas.

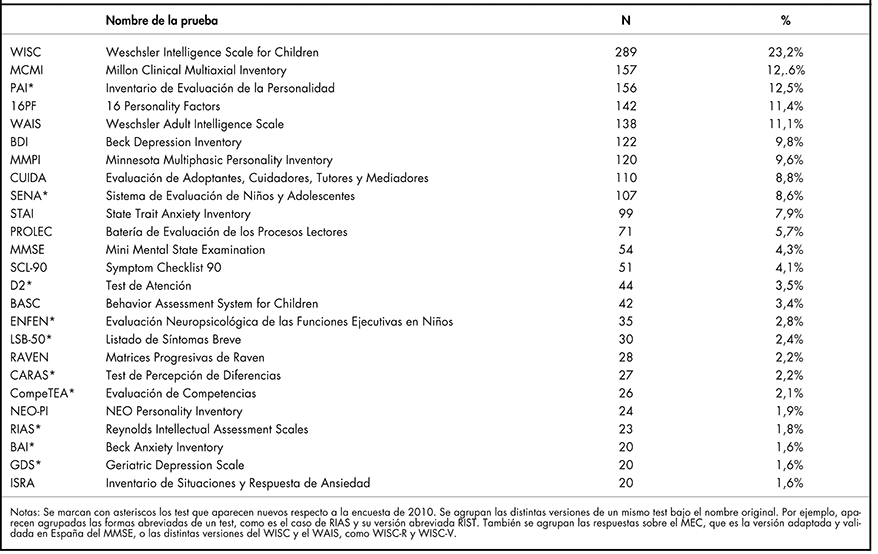

TEST MÁS UTILIZADOS EN ESPAÑA

En la tabla 8 se muestran los resultados referidos a los test más utilizados en la práctica diaria profesional de los psicólogos. Cabe destacar, en primer lugar, que los 25 test más utilizados son todos psicométricos, quedando los proyectivos relegados a posiciones muy inferiores. Como se puede observar, en primer lugar se encuentra el test de inteligencia para niños WISC, seguido del Inventario Clínico Multiaxial de Millon (MCMI) y de la adaptación española del Personality Assessment Inventory (PAI). También es destacable que todas las pruebas están adaptadas al contexto español, y 6 de las 25 han sido desarrolladas por autores españoles, lo que representa un 24%, lo cual no está nada mal. Comparada esta evaluación con la de hace diez años, se incorporan a la lista diez nuevas pruebas, señaladas en la tabla 8 con un asterisco (PAI, SENA, D2, ENFEN, LSB-50, CARAS, CompeTEA, RIAS, BAI, GDS), algunas de ellas publicadas con posterioridad a la encuesta de 2010 (PAI, SENA, LSB-50). Estos cambios en la lista de los test más utilizados constituyen un buen indicador de la gran actividad que se desarrolla en el campo de la construcción y publicación de test en España.

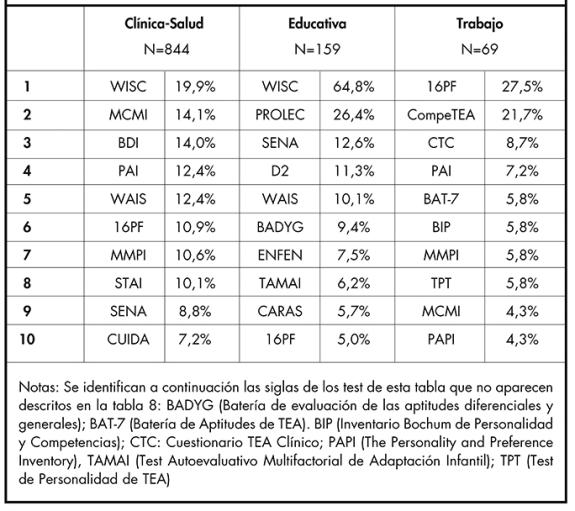

Cuando se analiza el uso por especialidades (tabla 9), se observa, como no puede ser de otro modo, que los test varían notablemente, así, por ejemplo, en Clínica y Educativa aparece en primer lugar la evaluación de aspectos cognitivos (WISC), mientras que en Trabajo lo hacen los de Personalidad (16PF).

ALGUNAS CONCLUSIONES GENERALES

Esta es la tercera encuesta que se hace a los psicólogos españoles acerca de sus opiniones sobre distintas cuestiones relacionadas con la práctica de los test en nuestro país, las otras dos datan de 2000 y 2010. Respondieron 1.248 colegiados a las treinta peguntas de la encuesta. A partir de los resultados, ya comentados con detalle en las líneas precedentes, pueden extraerse algunas conclusiones generales.

El análisis factorial de las preguntas de la encuesta indica que estas se articulan en torno a cinco dimensiones principales: Actitudes hacia los test, Problemas en el uso de los test, Control y regulación de los test y su utilización, Formación y conocimientos sobre los test, y finalmente, una quinta dimensión relativa a la influencia de las nuevas tecnologías en la práctica de los test, como informatización, internet y automatización de las evaluaciones.

Se constata una actitud positiva de los psicólogos españoles hacia los test utilizados adecuadamente, con una media de 4 puntos en una escala de 1 a 5 en esta dimensión. Los profesionales más favorables son los del área Educativa (4,17), seguidos de Trabajo (4,09) y Clínica-Salud (3,94).

En lo relativo a los problemas de uso de los test, los psicólogos españoles reconocen que hay aspectos a mejorar, pero consideran los problemas existentes de una gravedad moderada, con una media de 2,93, ligeramente por debajo de la media teórica de la escala que se sitúa en 3.

Los encuestados son claramente partidarios de incrementar el control y la regulación del uso de los test por parte de las instituciones implicadas (media de 4,07), tales como la Federación Europea de Asociaciones de Psicología (EFPA), International Test Commission (ITC), y el COP a nivel nacional.

Se pone de relieve la necesidad de una formación continuada en todo lo relacionado con los test (media de 2,72), pues se reconoce que lo aprendido en los estudios previos, tales como grado, licenciatura o Máster, no es suficiente para utilizar los test actuales con solvencia.

Se comprueba una cierta contención, tal vez prudencia, de los profesionales a la incorporación de las nuevas tecnologías en la práctica de los test, tales como la evaluación online a través de internet o la automatización de los informes (media de 2,89). Este escepticismo es mayor en Clínica, seguido de Educativa y Trabajo.

Los psicólogos consideran que los test tienen un precio demasiado elevado (media de 4,17), especialmente los clínicos y educativos, y en menor grado en el ámbito de trabajo. Los editores deberían de tomar en consideración este aspecto.

La evaluación de la calidad de los test que lleva a cabo la Comisión de Test del COP es poco conocida todavía entre los profesionales, sólo la conocen un 22,5%. Es evidente que hay que seguir haciendo esfuerzos en su difusión. Ahora bien, la buena noticia es que quienes la conocen la consideran muy importante y necesaria.

En cuanto a la evolución de las opiniones de los psicólogos españoles sobre la práctica de los test en las últimas dos décadas, cabe destacar que los profesionales aprecian una mejora de la información de la que disponen sobre la calidad de los test, un incremento del uso de los test en el ejercicio de la profesión, y una mejora en la percepción del uso correcto de los test. Son indicadores en la buena dirección, si bien queda un amplio margen de mejora sobre el que habrá que seguir insistiendo desde todas las instituciones, tanto nacionales como internacionales.

En cuanto a los test más utilizados por los profesionales, destaca que los 25 más citados son todos ellos psicométricos, quedando muy relegados los proyectivos. Los profesionales de las especialidades de Clínica-Salud, Educativa y Trabajo utilizan test muy distintos, como era de esperar, destacando los de carácter cognitivo en Clínica y Educativa (WISC), y los de Personalidad en Trabajo (16PF).

MIRANDO HACIA EL FUTURO

Las opiniones de los profesionales sobre la práctica de los test son una foto fija de sus percepciones actuales, y vistas en perspectiva reflejan una tendencia positiva en relación con las mismas de los años 2000 y 2010, ya veremos qué ocurre en 2030 y siguientes. Todo cambia muy rápidamente, y la evaluación psicológica no es una excepción. Ya Heráclito nos lo advirtió hace veinticinco siglos, todo fluye, nada permanece. Haremos unas breves reflexiones sobre el futuro de la evaluación y de los test siguiendo los trabajos recientes sobre el tema de Muñiz (2018) y Muñiz y Fonseca-Pedrero (2019). La fuerza motriz más relevante en el cambio de los procesos de evaluación son las nuevas tecnologías de la información y la comunicación, y en especial los avances informáticos, multimedia e Internet. Expertos como Bennet (1999, 2006), Breithaupt, Mills y Melican (2006), Drasgow (2016), Drasgow, Luecht y Bennet (2006), Sireci y Zenisky (2016), o Sireci y Faulkner-Bond (2014), entre otros muchos, consideran que dichas tecnologías están influyendo sobre todos los aspectos de la evaluación psicológica, tales como el diseño de los test, la construcción y presentación de los ítems, la puntuación de los test y la evaluación a distancia. Si bien emergen nuevas formas de evaluación, los test psicométricos seguirán siendo herramientas fundamentales, dada su objetividad y economía de medios y tiempo (Phelps, 2005, 2008). En este contexto de cambio tecnológico aparece la llamada Psicología 2.0 (Armayones et al., 2015), que pretende extender la psicología a través de las facilidades que ofrece Internet y las redes sociales. La evaluación no puede estar ajena a estas nuevas tendencias, apareciendo nuevos enfoques psicométricos conectados con el análisis de las grandes bases de datos (big data) de las que se dispone actualmente (Markovetz, Blaszkiewicz, Montag, Switala y Schlaepfer, 2014). Por ejemplo, las ventajas potenciales de usar los teléfonos móviles y otros portables como terminales para la evaluación abren nuevas posibilidades para la evaluación del futuro (Armayones et al., 2015; Chernyshenko y Stark, 2016; Insel, 2017; Miller, 2012). Además, trabajos como el pionero de Kosinski, Stillwell y Graepel (2013) analizan con éxito la posibilidad de utilizar los "me gusta" de facebook como predictores de distintas características humanas, entre ellas los rasgos de la personalidad, lo que hace preguntarse si nuestros rastros en las redes sociales sustituirán algún día no muy lejano a los cuestionarios y test tal como los conocemos ahora (Muñiz y Fonseca-Pedrero, 2019), nos parece que va a ser que no, pero nunca se sabe. Otro tema que cobra fuerza es el de la evaluación ambulatoria, que si bien no es nuevo en psicología, resurge con fuerza en la actualidad impulsada por las tecnologías de la información y comunicación (Chernyshenko y Stark, 2016; Myin-Germeys et al., 2018; Trull y Ebner-Priemer, 2013; van Os, Delespaul, Wigman, Myin-Germeys y Wichers, 2013). La evaluación ambulatoria abarca diferentes métodos y procedimientos que tratan de estudiar mediante dispositivos móviles las experiencias de las personas (emociones, sentimientos, pensamientos, síntomas psicológicos) en su entorno natural y en la vida diaria. Esta metodología permite evaluar los constructos psicológicos desde una perspectiva más dinámica, personalizada, contextual, micro-longitudinal y ecológica. Ello se consigue realizando evaluaciones varias veces al día para captar suficientemente la variabilidad temporal de los fenómenos. Las preguntas se activan mediante un beep y pueden presentarse de forma aleatoria o en intervalos de tiempo predeterminados. Se trata de una aproximación complementaria a los procedimientos tradicionales de evaluación psicométrica de papel y lápiz (Fonseca-Pedrero y Muñiz, 2017; Muñiz y Fonseca-Pedrero, 2019). Para analizar este tipo de datos se necesitan nuevos modelos psicométricos, entre los que destacan los modelos de redes (Borsboom y Cramer, 2013; Fonseca-Pedrero, 2017, 2018), así como los modelos procedentes de la teoría de los sistemas dinámicos o la teoría del caos (Nelson, McGorry, Wichers, Wigman, y Hartmann, 2017). Estos nuevos enfoques y tecnologías seguramente vienen para quedarse en los reales de la evaluación, y son bienvenidos, pero tendrán que superar la prueba del algodón y convencer a la implacable jueza: la validez. Todas las fantasías sobre los avances tecnológicos pasan por demostrar que aportan mejoras en la medida del constructo evaluado, de lo contrario no dejarán de ser meros fuegos de artificio, pues lo esencial no muta: siempre habrá que aportar evidencias empíricas de la fiabilidad y validez, y así garantizar que los instrumentos de medida evalúan de forma objetiva, equitativa y rigurosa, ese es el norte que no hay que perder de vista (Muñiz y Fonseca-Pedrero, 2019). De hecho, ya asistimos con demasiada frecuencia a propuestas sofisticadas informáticamente para evaluar constructos psicológicos y educativos online que no tienen detrás ninguna evidencia empírica que los avale. Osan algunos de ellos evaluar constructos tan complejos como la Dislexia o el TDAH, y generan gráficos muy aparentes con colores y semáforos varios, se lanzan incluso a diagnosticar, pero detrás no hay nada, no se aporta ninguna evidencia de validez, son mera apariencia, eso sí, seguramente muy lucrativa. Por el bien de los usuarios y de la profesión debemos contribuir entre todos a desenmascarar estos timos, envueltos de marketing y tecnología, pero carentes de toda validez. Todo instrumento de medida, use la tecnología que use, debe aportar un manual detallado donde consten las evidencias de validez que lo avalan, y si no lo hace no vale nada, así de simple.

AGRADECIMIENTOS

Los autores desean expresar su agradecimiento a todos los investigadores y profesionales que participaron en el desarrollo del cuestionario utilizado, que fueron muchos. Especial mención merecen, el presidente del COP, Francisco Santolaya, que apoyó el proyecto de forma clara y decidida, los miembros de la Comisión de Test del COP (Milagros Antón, José Luis Galve, Rosario Martínez Arias, Vicente Ponsoda y Frédérique Vallar), así como quienes coordinaron las evaluaciones anuales de test: Paula Elosua Oliden, Laura E. Gómez Sánchez, María Dolores Hidalgo, Eduardo Fonseca Pedrero y Carme Viladrich. La implementación informática de la encuesta corrió a cargo de José Ramón Correas González. Muchas gracias a todos, sin su ayuda este trabajo no hubiese sido posible.