El impacto de las tecnologías de la información y comunicación (TIC) sobre la construcción y el uso de test está transformando el entorno evaluativo. El test, como instrumento de medida al servicio del profesional, en cualquiera de los ámbitos de la psicología, educación y sanidad, y la evaluación, como actividad compleja que integra conocimiento, juicio clínico, información fiable y medidas psicométricas (American Psychological Association (APA, 2020), se han abierto a las posibilidades ofrecidas por las TIC. Los escenarios virtuales interactivos, los nuevos modelos psicométricos, la utilización de dispositivos móviles, la recogida de datos de proceso (log data) o el elevado volumen de datos accesibles desde fuentes diversas (big data) han modificado el modelo estático clásico de la medición con test de lápiz/papel. La tecnología aporta la posibilidad de aplicar test en formatos digitales o de corregir ensayos de forma automatizada, pero además ha venido acompañada de nuevos constructos relacionados con las competencias en el manejo de las TIC o de nuevas formas de medir las habilidades blandas como liderazgo, comunicación, pensamiento crítico, aprendizaje colaborativo o trabajo en equipo, cada vez más relevantes en los medios educativo, laboral y social (Grundke et al., 2017; OECD, 2016).

El efecto del desarrollo tecnológico sobre la evaluación puede describirse como un proceso progresivo de asimilación que afecta a diferentes áreas relacionados con el uso de pruebas. Desde la utilización de un ordenador como mero soporte para la administración de un test de lápiz/papel (Elosua, 2021), hasta la integración de la tecnología en modelos sustantivos que facilitan la medición de las nuevas variables, o el nuevo paradigma de investigación guiado por datos (data driven), la tecnología digital ha impactado en todas las fases que acompañan la construcción y uso de test. En el ámbito de la evaluación educativa, por ejemplo, se han diferenciado tres estadios que marcan el impacto de las TIC (Bennet, 2015); en un primer momento se desarrolla la infraestructura y se hace uso de la tecnología para administrar los test tradicionales en un nuevo soporte; sobre esta infraestructura y aprovechando las ventajas de la utilización del ordenador, se construyen los test adaptativos (Wainer et al., 2000; Weiss, 1982), aparecen los nuevos formatos de ítem (multimedia, respuestas construidas cortas, tareas de rendimiento estático como ensayos) y la generación automática de ítems, o la automatización de la corrección de test; finalmente, en el estadio más avanzado la tecnología se integra de tal modo en el proceso evaluativo que forma parte del diseño de pruebas a partir de modelos cognitivos que haciendo uso de simulaciones y tareas interactivas reproducen entornos “reales” favorecedores de una evaluación auténtica.

En este trabajo repasamos las innovaciones relacionadas con las TIC que están teniendo un mayor impacto en el campo de la evaluación ligada al uso de test. El objetivo es apuntar aquellos aspectos que, desde nuestra perspectiva, están teniendo una mayor relevancia en la construcción y uso de los test; con esa finalidad y con el propósito de ofrecer un panorama general comenzamos con unas breves notas para definir y ubicar los elementos del campo de las TIC que más han podido influir en la situación actual.

DESARROLLO DE LA TECNOLOGÍA DIGITAL

Una de las características más salientes de la tercera revolución industrial, y que ha dado origen a la sociedad de la información (Rifkin, 2011) ha sido el desarrollo de la tecnología digital. Los mayores hitos están relacionados con la aparición y desarrollo de elementos como los ordenadores personales o internet, que han transformado la forma de comunicación humana.

Ordenadores personales

La idea del ordenador personal surgió hace aproximadamente 50 años; compañías como IBM, HP y Apple presentaron sus primeras máquinas en los años 80; el IBM personal computer apareció en 1981, HP comercializó su primer ordenador personal en el año 1980, y The Apple Macintosh se expuso en un anuncio durante la retransmisión de la Super Bowl el año 1984. La aparición del ordenador personal situó la capacidad de computación directamente en manos de millones de personas, y cambió con ello el paradigma anterior en el cual los privilegios de acceso de los usuarios individuales estaban estrictamente controlados por los administradores del sistema. La introducción posterior de la arquitectura cliente-servidor condujo además a la vinculación de los ordenadores personales (clientes) a computadoras (servidores) que permitían compartir grandes cantidades de datos (O’Regan, 2021).

Internet y WWW

El inicio formal de internet suele situarse en los años 60, en el momento en el que el departamento de defensa de Estados Unidos configuró la red ARPANET (Advanced Research Project Agency) que conectaba 4 centros de investigación norteamericanos. Esta primera red junto con la invención de la conmutación de paquetes (packet switching) que permitía aumentar la velocidad y efectividad del teleproceso, y la aparición del código ASCII creado por el Comité Estadounidense de Estándares en 1963 (American Standard Code for Information Interchange) dieron lugar a que en los años 70 se pudieran conectar alrededor de 30 instituciones.

Internet y World Wide Web (WWW) no son sinónimos. La aparición de la WWW, concebida por Tim Berners-Lee, se fija en el Conseil Européen pour la Recherche Nucléaire (CERN, Organización Europea para la Investigación Nuclear) el año 1990. La WWW se fundamenta sobre avances anteriores relacionados con el desarrollo del hipertexto, del ratón y de internet. Berners-Lee creó un sistema que asignaba a cada página web una dirección estándar, la URL (Universal Resource Locator) a la cual se accedía por medio del protocolo HTTP (Hypertext Transfer Protocol), y programó un explorador que permitía solicitar, recuperar y visualizar páginas web en el PC local entre ordenadores conectados a través de internet. La invención de la World Wide Web fue un hito revolucionario. Transformó internet de un uso principalmente académico hasta donde ahora es una parte integral de la vida de las personas. Los usuarios podemos navegar por la web, hipervincular entre millones de ordenadores, y compartir información de forma rápida y sencilla. De acuerdo a internetworld stats (https://www.internetworldstats.com) se estima que la penetración de internet es a día de hoy del 65,6%; es decir, sobre una población mundial estimada en 7.8751765.587 personas, 5.1681780.607 utilizan internet.

Redes sociales

La ubicuidad de los teléfonos inteligentes o simplemente móviles, ha impulsado el crecimiento de las redes sociales, que a su vez han transformado las formas de comunicación humana. Las redes sociales son aplicaciones que permiten la creación e intercambio de contenido generado por el usuario; pueden ser horizontales o generalistas y verticales o especializadas en función de que tengan temáticas o actividades definidas; LinkedIn o Researchgate por ejemplo, serían redes verticales profesionales y de investigación.

Analizando el tipo y calidad de la información compartida en redes sociales, estas podrían clasificarse combinando modelos teóricos del campo de las redes con modelos sobre procesos sociales (Kaplan y Haenlein, 2010); un eje vendría definido por el nivel de presencia social y la riqueza del medio, es decir, por la cantidad de información que puede transmitirse en un intervalo de tiempo, y el segundo lo marcarían la auto-representación o deseo de control sobre las impresiones que se causan en el otro, y la revelación consciente o inconsciente de información personal (self-disclousure). (Tabla 2).

Inteligencia artificial

En el límite entre la tercera y la cuarta revolución industrial, definida como la revolución más rápida en el ámbito de la tecnología, y no comparable con nada en la historia de la humanidad en términos de impacto (Lee, 2018) la inteligencia artificial (IA) se erige en objeto de estudio y análisis desde ámbitos científicos, técnicos, políticos y sociales. La IA se ha nutrido de disciplinas tan variadas como la filosofía, las matemáticas, la economía, las neurociencias, la psicología, la ingeniería computacional, la cibernética y la lingüística. Hoy encontramos aplicaciones de IA en motores de búsqueda, diagnósticos médicos, reconocimiento de voz, control de robots, búsqueda web, publicidad e incluso juguetes.

Nota. Datos extraídos de www.https://internetworldstats.com en Noviembre de 2021

FIGURA 1 PENETRACIÓN DE INTERNET

Mencionar la inteligencia artificial lleva indudablemente a citar al matemático Alan Turing, que con sus trabajos a principios de la década de 1950 contribuyó al debate sobre máquinas pensantes, conciencia e inteligencia. Creó el famoso test de Turing para evaluar la consciencia de una máquina; en este experimento un juez evalúa una conversación en lenguaje natural entre dos partes, un humano y una máquina con el propósito de discernir cuál es la máquina. En esta línea de trabajo el alemán Joseph Weizenbaum programó el año 1966 en el Massachusetts Institute of Technology (MIT) el programa ELIZA; se trata de un bot que emulando a un psicoterapeuta de la escuela de Rogers interactúa con una persona sentada frente a una máquina de escribir (similar a un chat en línea). El software opera descomponiendo la entrada del usuario en sus partes constituyentes de voz y, a continuación, vuelve a escribirlas de un modo que aparenta un diálogo fluido. El autor se sorprendió al comprobar que muchos usuarios pensaban que el programa tenía una comprensión real. Esta observación le llevó a reflexionar sobre la ética y las implicaciones del campo de la inteligencia artificial (Weizenbaum, 1976), cuestión que impregna el desarrollo de la IA. El lector puede “conversar” con una versión en castellano de ELIZA en http://deixilabs.com/eliza.html

El término inteligencia artificial aparece en un proyecto de investigación de verano de Dartmouth escrito por el informático John McCarthy el año 1955. Hoy, una de las definiciones más aceptadas de IA es la propuesta por Russell y Norvig (2021), según la cual la IA se centra en el estudio y construcción de agentes que hacen lo correcto, siendo lo correcto el objetivo marcado para el agente, y definiendo agente como algo que percibe su medio a través de sensores. En términos estadísticos simples lo correcto podría ser aquella decisión (estimación) que minimiza la función de pérdida. Esta definición ha sido aceptada por la Unión Europea que la reformula como: “El software que se desarrolla empleando una o varias de las técnicas y estrategias que figuran en el Anexo I1 y que puede, para un conjunto determinado de objetivos definidos por seres humanos, generar información de salida como contenidos, predicciones, recomendaciones o decisiones que influyan en los entornos con los que interactúa” (Comisión Europea, 2021).

El campo de la IA es amplio y encontramos áreas especializadas en computación, aprendizaje automático (machine learning), procesamiento de lenguaje natural, visión computacional y robótica. Además, y dadas las implicaciones de la IA, el capítulo dedicado a los aspectos éticos y legales relacionados con su implementación es una constante.

El dato

La disponibilidad de información proveniente de las redes sociales o de aparatos, sensores y servicios que capturan datos a su alrededor (internet de las cosas) ha causado un cambio de paradigma en la investigación, en el mercado, y en la industria. El origen del término big data se sitúa en el año 2005, y es atribuido a Roger Mougalas. Hoy big data hace referencia a la información caracterizada por su Volumen, Velocidad y Variedad, y que requiere de métodos analíticos específicos para su tratamiento (De Mauro et al., 2016; Zicari, 2013). Las tres Vs características del big data han ido ampliándose con más sustantivos que intentan reflejar con mayor fidelidad su naturaleza; así encontramos determinantes como Valor, Veracidad, Visualización, Volatilidad, Validez y Viabilidad (Maté-Jimenez, 2014). El big data opera básicamente con modelos de aprendizaje automático (machine learning) que buscan patrones y relaciones para la clasificación y la predicción; es una aproximación a la investigación centrada en el dato, exploratoria, que aplica técnicas analíticas en la búsqueda de patrones en los datos. En contraposición, el acercamiento clásico, deductivo, centrado en la teoría, se asocia a la formulación y contraste de hipótesis sobre una muestra de datos. Entre ambas perspectivas que pueden definir un continuo, cada vez es mayor la postura que aboga por la complementariedad en pro del avance del conocimiento y de la productividad científica (Maass et al., 2018).

IMPACTO DE LAS TIC EN LOS TEST COMO INSTRUMENTOS DE EVALUACIÓN

Las innovaciones tecnológicas descritas en los puntos anteriores y algunas más que por limitaciones de espacio no podemos tratar (potencia computacional, robótica, desarrollo de software…) han impactado en todo el proceso relacionado con el uso de test; la construcción de ítems, el soporte y aplicación del test, la corrección de pruebas, la recogida de datos adicionales, los modelos psicométricos para tratarlos, el uso del dato como fuente de información… son áreas de trabajo e investigación que adecúan el test tradicional y las prácticas del siglo XX a las demandas sociales del siglo XXI.

Test adaptativos

FIGURA 2. REPRESENTACIÓN FIGURATIVA DE LA EVOLUCIÓN DE LAS TECNOLOGÍAS DE LA INFORMACIÓN Y DE LA PSICOMETRÍA

El desarrollo de los test adaptativos informatizados (TAI) y la teoría psicométrica asociada a ellos construida sobre las bases de la teoría de respuesta al ítem, han facilitado la construcción de test personalizados y la comparabilidad de puntuaciones entre personas que reciben ítems diferentes (Hambleton, 2006). El test adaptativo es un sistema compuesto por un banco de ítems con características psicométricas conocidas, y algoritmos de selección que en función del nivel de habilidad que se estima tras cada respuesta, eligen el ítem almacenado en el banco que por sus propiedades (parámetros) va a ofrecer la máxima información sobre el nivel de competencia de la persona evaluada (Olea et al., 2010; van der Linden y Glas, 2000).

Generación automatizada de ítems

La construcción automatizada de ítems o generación automatizada de ítems (GAI) se presenta como una solución a la creciente demanda de un mercado caracterizado por la implementación de test adaptativos computerizados, la aplicación de test por internet, la transparencia exigida a los proyectos evaluativos o el incremento de programas de evaluación educativa. La aplicación de los ítems, sobre todo en el ámbito educativo, ha pasado de considerarse una actividad ocasional a una actividad ad hoc que viene acompañada de la exigencia de disponer de un elevado número de ítems. Antes esta necesidad, la construcción artesanal que pone su foco atención en un único ítem que se construye, revisa, edita y calibra hasta que alcanza los estándares de calidad exigidos se presenta como un proceso poco eficiente.

La generación automática de ítems conjuga teorías cognitivas y psicométricas que permiten a partir de un modelo construir ítems con propiedades psicométricas preestablecidas. En este marco, la unidad de análisis es un modelo de ítem (Gierl et al., 2020) o a un modelo cognitivo (Embretson y Yang, 2006). La GAI puede representarse como un proceso que se desarrolla en 3 etapas: 1) se identifica el contenido que servirá de base para la generación de ítems; 2) se construye el modelo de ítem, y 3) se programan los algoritmos que a partir de las fases 1 y 2 generarán los ítems. Pueden consultarse varios modelos de generación de ítems en Bejar et. al. (2003), Case y Swanson (2002) o Gierl y Lai (2013).

Aplicación de pruebas por ordenador

Una de las grandes ventajas de la aplicación de pruebas por ordenador es la posibilidad de recoger datos de proceso referidos a la interacción de la persona evaluada con el entorno evaluativo. Estos datos, logdata, pueden utilizarse para reconstruir conductas específicas, ahondar en teorías sobre el aprendizaje, estudiar diferencias entre grupos y, en definitiva, ampliar los estudios de validación. La información sobre el tiempo dedicado a cada elemento, puede ser útil por ejemplo, para analizar la motivación, la fatiga o la velocidad de ejecución; además, la aplicación computerizada permite recoger datos multimodales, datos de proceso multivariado como movimientos faciales, oculares, audio, resonancia magnética o tomografía computerizada que si bien todavía presentan dificultades de análisis serán objeto de investigación los próximos años (Guidry et al., 2013; Ramalingam y Adams, 2018; Scherer et al., 2015; en este monográfico Suarez et al., 2022).

Nuevos formatos de ítems

La mejora en las capacidades de los ordenadores personales junto al desarrollo de internet y la disponibilidad de dispositivo móviles permite aplicar test/ítems en formatos diferentes al clásico de lápiz/papel. Los nuevos formatos de ítems, que se enriquecen con la utilización del video o de la animación superan algunas de las desventajas asociadas a los ítems de elección de respuesta y con ello, permiten la medición de aspectos difícilmente alcanzables con el formato de opción múltiple o con sus variantes.

Baste citar como ejemplo de la expansión y uso común de los nuevos formatos de ítems que la evaluación internacional PISA (Programme for International Student Assessment) gestionada por la OCDE introdujo la administración computerizada en el año 2006; a partir de la edición de 2015 PISA se diseña y aplica de forma digital (puede el lector ver ejemplos de ítems del programa PISA en https://www.oecd.org/pisa/test/ ).

La animación incluida en un ítem puede ser bidimensional, tridimensional simple y tridimensional fotorrealista o realidad virtual (Popp et al., 2016). La realidad virtual es una simulación, derivada de la industria del juego, que crea la sensación de presencia física (Linowes, 2015; Parisi, 2015). En principio, estos ítems prevén una validez aparente mayor, se acompañan de presentaciones dinámicas e interactivas que pueden generar una mejor aceptación e interés hacia la situación de test por parte de la persona evaluada, y favorecen la evaluación de tareas complejas (Bruk-Lee et al., 2013; Ryall et al., 2016). Sin embargo, los formatos multimedia también podrían introducir factores no deseados en el proceso evaluativo; por ejemplo, la caracterización sociodemográfica del avatar es un rasgo saliente que puede activar actitudes o experiencias afectivas que interactúan de forma no buscada ni deseada (Sadler et al., 2012). Son varias las críticas vertidas hacia este tipo de ítem por su falta de validez en el campo educativo (Young et. al, 2012), si bien en medicina gozan de tradición y prestigio (McGaghie et al., 2010).

Corrección automatizada de ensayos

La aparición en los años 30 de los lectores ópticos incrementó la eficiencia en el proceso de corrección, y con ello el volumen de los test de selección de respuesta; sin embargo, la implementación y cada vez mayor aplicación de ítems de producción (ensayos, ítems abiertos) han impulsado la búsqueda de métodos de corrección eficientes para este formato de tarea. La corrección automatizada de ensayos se inició en los años 60 (Page, 1968), y con la sofisticación del procesamiento del lenguaje natural y el machine learning, la corrección automatizada de ensayos está hoy aceptada como parte de la práctica educativa. Son varios los estudios que la comparan con la evaluación mediatizada por jueces, y han mostrado su eficacia en la evaluación sobre diferentes criterios de corrección (Williamson et al., 2012). Las compañías más pujantes relacionadas con la evaluación educativa disponen de software diseñado con esta finalidad (Pearson Test of English; ETS criterion; Accuplacer del College Board…).

La idea que subyace a la corrección automatizada de ensayos es que el sistema es capaz de convertir la producción del estudiante (oral o escrita) en una puntuación (o varias puntuaciones) o feedback, que es preciso, fiable y está alineado con los constructos a evaluar. El proceso descansa en una muestra amplia de ensayos que representa el rango de posibles producciones y puntuaciones. Los ensayos se corrigen por expertos humanos que ofrecen al sistema la información necesaria para que este se entrene en la estimación de la puntuación verdadera. Con esa base, el software aprende a asociar las características distintivas de cada ensayo con las puntuaciones asignadas por los expertos. Una vez construido el modelo el sistema es capaz de predecir la puntuación que los expertos asignarían a un nuevo ensayo.

Modelado psicométrico

Al mismo tiempo que la tecnología digital impregna la forma de construir, administrar y corregir test, los modelos psicométricos para el análisis de datos y estimación de las puntuaciones verdaderas y errores de medida se adaptan a las exigencias de los nuevos entornos. Los mayores retos a los que se enfrentan podrían ser la modelización de la multidimensionalidad, y la adaptación de la metodología construida para su uso en entornos controlados y estructurados para su uso en entornos dinámicos y con datos con un nivel de estructuración menor.

Modelos bifactoriales

Los modelos bifactoriales modelan la multidimensionalidad presente en muchos constructos analizados por la psicología, y se aplican cuando existe un factor general y factores específicos o factores de grupo. Aunque los modelos bifactoriales o modelos anidados fueron propuestos en 1937 (Holzinger y Swineford) su aplicación se ha extendido la última década (Rodriguez et al., 2016). Básicamente el modelo bifactorial y el modelo factorial de segundo orden podrían tener interpretaciones similares (Chen et al., 2006) pero los primeros cobran relevancia cuando el interés se centra en los factores de grupo, se desea analizar la relación entre éstos y los ítems que la conforman, o quiere profundizarse en la capacidad predictiva de las escalas parciales.

Modelos testlet

Los modelos TRI basados en testlet son formalmente modelos bifactoriales; la diferencia entre ambos proviene de la tradición en su uso que viene ligada a modelos factoriales y modelos TRI, o a campos de especialización psicológica o educativa. El testlet se construye por la necesidad de estimación en condiciones de violación de independencia local asociada a la aplicación de grupos de ítems dependientes de un contexto (Bradlow et al., 1999; Wainer et al., 2007). En un testlet cada ítem es un indicador de una dimensión general, y de una dimensión asociada a un grupo de ítems. La dimensión general representa la variable latente de interés central (por ejemplo, la competencia lectora) mientras que el resto se incorpora para tener en cuenta las dependencias adicionales entre los ítems que pertenecen al mismo subgrupo.

Modelado de ítems de elección forzosa

Frente al ítem comúnmente denominado Likert en el que una persona responde a una cuestión en una escala de respuesta ordenada, los ítems de elección forzosa o ítems ipsativos obligan a elegir entre dos o más enunciados que pueden ordenarse en función de las preferencias mostradas (en este monográfico Abad et al., 2022). Con ello se busca controlar el sesgo de respuesta (aquiescencia, deseabilidad social, tendencia central, severidad...) y mejorar el proceso evaluativo (Brown y Maydeu-Olivares, 2011, 2018; Chan, 2003).

Análisis de redes

El análisis de redes en psicología es una alternativa a la visión psicométrica tradicional que relaciona un constructo con varios indicadores de los que es causa. En el modelado de redes los indicadores se perciben como proxies (aproximaciones) de variables que interactúan entre ellas; por ejemplo, desde la perspectiva tradicional síntomas como la falta de energía, problemas de sueño o baja autoestima estarían causados por la depresión mientras que en el modelo de redes esos síntomas constituyen una red de interacción mutua. Supone un acercamiento diferente a la modelización y estudio de los fenómenos psicológicos (Epskamp et al., 2018; Fonseca-Pedrero, 2018).

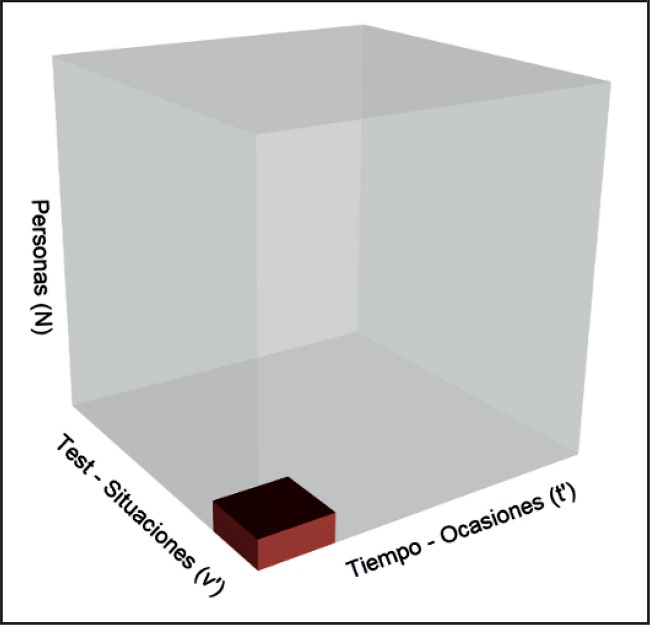

Big data. Redes sociales, wearables y dispositivos moviles

La tradición investigadora en ciencias sociales construida sobre la representación del cubo de datos de Cattell (1966) como un conjunto ordenado constituido por tres ejes (casos, variables y momentos temporales), ha dado paso al dato masivo, no estructurado y de alta dimensionalidad. Esta irrupción, en cierto modo cuestiona el concepto clásico de test como unidad básica para la recogida de información sobre comportamientos, actitudes o creencias. Las redes sociales como Facebook, LinkedIn o Twitter son fuentes continuas de datos que están dando lugar a una nueva línea de investigación en psicología (en este monográfico Andrés et al., 2022); la depresión, la ideación suicida, la personalidad o la selección de personal, por ejemplo, están siendo analizadas a través del análisis de la información desprendida de las redes sociales (Conway y O’Connor, 2016; Dwyer et al., 2018; Skaik y Inkpen, 2020; Woo et al., 2020). Pero además, el internet de la cosas o la utilización de dispositivos móviles abre la posibilidad de utilizar metodologías basada en el muestreo de experiencias (Experience sampling methodology, ESM; Myin-Germeys et al., 2018; Stieger et al., 2018) o evaluación ambulatoria (en este monográfico Fonseca-Pedrero et al., 2022) que aportan una perspectiva ecológica a la evaluación psicológica.

Aspectos éticos

De forma paralela al incremento de las aplicaciones de la IA, se desarrolla un debate sobre aspectos éticos, legales e implicaciones sociales. Son muchas las instituciones nacionales e internacionales que han creado comités de expertos ad hoc para la elaboración de documentos y directrices sobre la IA. En España en Julio del 2020 se constituyó el Consejo Asesor en inteligencia artificial, la Comunidad Europea publicó el año 2018 el plan coordinado sobre inteligencia artificial en el que se otorga el rol de vigilancia al AI Watch, y actualmente está trabajando en su reglamentación. La constitución de tales comités es un claro indicador del impacto tecnológico, económico, político y social de las nuevas tecnologías.

En una revisión sobre directrices y estándares en la que se estudian 84 documentos, se concluye que los problemas más tratados en los informes que analizan las cuestiones éticas implicadas con la IA están relacionadas con la transparencia, la justicia, la equidad y el sesgo (Jobin, Ienca y Vayena, 2019). Conceptos por otro lado que han sido, y son objeto de los estándares sobre construcción y uso de test, con los que estamos en permanente contacto (en este monográfico Hernández et al., 2022).

DISCUSIÓN

Los cimientos de la psicometría teórica actual se edificaron en la segunda mitad del siglo XX; el modelo de la teoría clásica de test, la formulación del modelo factorial o las primeras propuestas sobre la teoría de respuesta al ítem conocida también como “Nueva psicometría” corresponden a esa época (Lord y Novick, 1968; van der Linden y Hambleton, 1997). Desde entonces, la impulsión de la tecnología digital y la accesibilidad y potencia del software y hardware, han permitido la generalización del uso de esos modelos psicométricos acortando con ello la brecha entre psicometría teórica y aplicada (Elosua, 2012).

Pero la innovación no se centra únicamente en la socialización del modelo confirmatorio, importante por otro lado para el fortalecimiento de los estudios de validación. Junto a ella, se ha ampliado y enriquecido el concepto y uso de test; los entornos evaluativos son ahora diversos, complejos y dinámicos. Varias voces defienden que estamos en plena cuarta revolución industrial (Schwab, 2017); revolución caracterizada por el big data, la computación en la nube o el internet de las cosas. Si la tercera revolución industrial vino asociada a la explosión científica y a la tecnología de la información, la cuarta es un desarrollo de la anterior. La penetración de la tecnología digital en la evaluación nos ha acercado a un nuevo territorio en el cual las aportaciones de áreas de conocimiento como la ingeniería, lingüística computacional, informática y la inteligencia artificial abren nuevos campos de exploración, y cuestionan el concepto clásico de test; pero además, “el dato” se ha instalado en nuestras vidas. Este nuevo referente procedente de aplicaciones, dispositivos móviles y redes sociales está permitiendo analizar conductas, clasificar y predecir. Es cierto que los procedimientos de obtención de datos son diferentes, pero ambos acercamientos presentan afinidades en sus objetivos. El límite entre el test y el dato como instrumentos que a partir del análisis de información facilitan la toma de decisiones se diluye. La cuestión, o las cuestiones ante este horizonte, son varias ¿estamos los psicólogos preparados para acometer esta tarea? ¿cuentan los perfiles más tecnológicos (ingenieros, informáticos…) con el suficiente background sustantivo para abordarla? La coordinación entre áreas, la formación del psicólogo en lenguajes como R o Phyton (Elosua, 2009, 2011), y el trabajo en equipo (Adjerid y Kelley, 2018; König et al., 2020; Oswald, 2020) pueden ser medios útiles que nos permitan afrontar la diversidad y el dinamismo de este tiempo. La experiencia adquirida por la psicometría en el campo de la medición, la comprensión de lo psicológico, y la clara consciencia sobre los problemas relacionados con la validez y el sesgo son valores que la psicología aporta, y de los que el big data puede claramente beneficiarse.

Pero no todo es big data; hemos presentado un abanico de líneas de trabajo actuales antes las cuales el profesional o académico puede tener varias reacciones; una de ellas es sentir las innovaciones presentadas como algo alejado de su quehacer habitual. El test de lápiz/papel, o las escalas Likert siguen estando omnipresentes en la psicología española; la construcción de test (Muñiz y Fonseca-Pedrero, 2019) y su adaptación (Muñiz et al., 2013) son territorios conocidos y fértiles para la academia, y siguen aportando conocimiento a la psicología. La tecnología digital, sin embargo, demanda algo más. Muchas de las innovaciones se estudian, analizan e implementan en compañías que se dedican al mercado relacionado con la construcción y uso de test, sobre todo, en los ámbitos educativo y organizacional. Los estudios sobre uso de test vienen señalando la diferencia entre sectores con respecto a las actitudes y utilización de la tecnología en la evaluación (Muñiz et al., 2020). Esta diferencia se agudiza cuando tratamos con tecnologías digitales (en este monográfico, Santamaría y Sánchez-Sánchez, 2022).

El test tradicional de lápiz/papel sigue vivo, pero hoy convive con desarrollos tecnológicos que han creado un entorno en el que lo virtual y digital ganan peso y atracción. El test surge como un instrumento de apoyo social, y en ello radica su pervivencia. Desde el punto de vista de la evaluación, la era digital crea un entorno compartido por la psicología, la educación, la ingeniería y la ciencia de datos (data science) en el que estamos abocados a participar de forma proactiva.