Durante mucho tiempo se ha pensado que de los millenials para adelante hay que dar por supuestas las habilidades digitales. Esto se está empezando a cuestionar. No cabe duda de que el alumnado actual usa más la tecnología, pero ¿sabe usarla bien? Si algo muestran los datos es que tener más exposición a la tecnología no implica necesariamente una mayor competencia digital y las diferencias son enormes entre estudiantes de entornos favorecidos y desfavorecidos (OECD, 2021a). Numerosos estudios han demostrado que las generaciones más jóvenes pueden estar más familiarizadas con la tecnología que las precedentes; sin embargo, los “nativos digitales” no siempre están necesariamente equipados con las habilidades adecuadas en términos de acceso y uso de la información digital (Breakstone et al., 2018; Macedo-Rouet et al., 2020; McGrew et al., 2018; OECD, 2011). Los estudiantes necesitan utilizar las tecnologías de la información y la comunicación (TIC) para acceder a textos a través de buscadores, utilizar enlaces y pestañas, procesar información de múltiples fuentes, evaluar la calidad de las fuentes de información, detectar posibles conflictos y resolverlos. Las definiciones de lo que significa ser un lector competente están en continua actualización para responder a cambios en la tecnología, la sociedad, la economía, y la cultura, y con ellas las formas de evaluar estas competencias. El objetivo de este trabajo es analizar la forma en que el uso de las Nuevas Tecnologías está cambiando el concepto de Lectura y, en consecuencia, las formas para evaluarlo. En este artículo abordamos algunas de las implicaciones más importantes que tienen estos cambios para el alumnado español, así como para cualquier profesional encargado de interpretar o diseñar evaluaciones educativas que aprovechen los avances de la tecnología. Para más información sobre el impacto de las nuevas tecnologías en otros ámbitos de evaluación como la Psicología y la evaluación ambulatoria ver Andrés et al. (2022), Fonseca-Pedrero et al. (2022) y Santamaría y Sánchez-Sánchez (2022) en este monográfico.

LA LECTURA EN UN MUNDO DIGITAL: EL CONSTRUCTO EN CONTINUO CAMBIO

Según los últimos datos del Programa de Evaluación Internacional de Estudiantes (PISA 2018), el estudiante promedio de 15 años en España pasa unas 35 horas semanales conectado a Internet – lo que supone un incremento de un 66% en 6 años y son datos previos a la pandemia Covid-19 por lo que esta cifra posiblemente no ha llegado a su techo (OECD, 2021a). Sin embargo, aproximadamente uno de cada tres estudiantes en España respondió en las pruebas PISA que hacer clic en el enlace de un correo electrónico de phishing era algo apropiado o muy apropiado1. Menos de la mitad de los jóvenes de 15 años en España son capaces de distinguir hechos de opiniones en las tareas de PISA2. España se encuentra por debajo de la media de la OCDE en ambos indicadores, aunque la diferencia es de menos de 10 puntos porcentuales (INEE, 2021). La buena noticia es que trabajar estas competencias en el aula – por ejemplo, aprender a detectar información sesgada – está relacionado con una mejor competencia lectora – por ejemplo, ser capaz de distinguir hechos y opiniones (Suarez-Alvarez, 2021). Estos datos confirman que la escuela puede jugar un papel fundamental en el aprendizaje de las competencias digitales y ayudar a reducir los riesgos asociados a ellas, aunque, por supuesto, no existen fórmulas mágicas.

Si bien es cierto que 29 de las 35 horas semanales que los estudiantes españoles pasan en Internet son fuera de la escuela, aquellos países cuyos estudiantes pasan más horas utilizando tecnología en el aula no siempre son los que mejor competencia digital muestran (OECD, 2021a). La relación entre el rendimiento en Lectura y el tiempo dedicado a utilizar dispositivos digitales para el trabajo escolar fue negativa en 36 países y economías, incluida España. En Australia, Dinamarca, Corea, Nueva Zelanda y Estados Unidos, esta relación fue positiva después de tener en cuenta la situación socioeconómica de los estudiantes y de las escuelas. Tampoco podemos olvidar que el uso de las tecnologías digitales responde a una realidad multidimensional: en ocasiones el uso de la tecnología en el aula se hace de manera complementaria a otras actividades que también son importantes, mientras que en otros casos pueden llegar a reemplazarlas. La clave puede estar, no tanto en el uso en sí, sino en el cómo se realiza una actividad concreta.

Por ejemplo, aún existe un beneficio claro de leer en papel, algo en lo que coincide la literatura que ha investigado este asunto (Clinton, 2019; Delgado et al., 2018). Estos resultados también son consistentes en los más de 70 países y economías que participaron en PISA 2018: los estudiantes que leen con más frecuencia libros en papel que en formato digital puntúan mejor en las pruebas de Lectura de PISA 2018 e invierten más tiempo leyendo por placer. Estos datos sugieren que no deberíamos desterrar al papel en favor de un monopolio digital y parece razonable buscar una compatibilidad entre formatos de Lectura tradicionales y analógicos. De hecho, los estudiantes más competentes en Lectura son aquellos capaces de optimizar las ventajas de ambos formatos. El alumnado con buenas competencias lectores parece responder al siguiente perfil: lee libros en papel y utiliza dispositivos digitales, dependiendo del objetivo, es decir, puede leer una novela en papel, pero lee diariamente las noticias online.

Otro ejemplo claro es el tipo de estrategias de Lectura que los estudiantes aprenden en la escuela, hecho que en el caso de España es particularmente interesante. Los estudiantes en España obtuvieron una puntuación particularmente alta en dos de los tres índices de conocimiento de estrategias de Lectura incluidos en PISA 2018 (comprender y recordar un texto, y redactar un resumen), pero menos en el índice de estrategias de Lectura para evaluar la credibilidad de las fuentes de información (INEE, 2021). Los datos sugieren que los estudiantes en España tienen un conocimiento relativamente bueno de los aspectos tradicionales y aún importantes de la Lectura. Sin embargo, todavía carecen, en promedio, del conocimiento y las habilidades relevantes para navegar en un mundo digital. Leer no consiste solamente en aprender a decodificar palabras escritas durante la infancia, sino en aprender un conjunto de competencias que van cambiando a lo largo de la vida. Para convertirse en lectores competentes en un mundo digital, los estudiantes necesitan una base sólida de Lectura, pero también la capacidad de pensar críticamente, y ajustar su comportamiento en función de la tarea, así como motivarse para perseverar frente a las dificultades.

En este sentido, España podría beneficiarse de fortalecer los conocimientos y habilidades de los estudiantes para navegar a través de la ambigüedad, contrastar y validar puntos de vista. Sin embargo, agregar asignaturas específicas sobre habilidades digitales en la escuela sin ajustar otras partes del currículo podría ser problemático. Es importante equilibrar el contenido y las competencias para abordar las nuevas demandas sociales sin sobrecargar el plan de estudios. El reto consiste en tratar de responder a las necesidades cambiantes y, al mismo tiempo, minimizar la expansión y la sobrecarga de contenido. Una posibilidad para encontrar el equilibrio entre la actualización curricular y la sobrecarga consiste en incorporar temas transversales o competencias en materias existentes (OECD, 2020), así como la utilización de métodos innovadores de enseñanza y aprendizaje (Paniagua y Istance, 2018; Pérez et al., 2018).

LA TECNOLOGÍA EN LA EVALUACIÓN EDUCATIVA: LAS PRUEBAS ADAPTATIVAS Y LOS DATOS DE PROCESO

Las definiciones de las competencias escolares, no solo de la Lectura como se ha descrito anteriormente, sino también de otras competencias como las matemáticas y las ciencias, están en continuo proceso de actualización para reflejar los cambios en la tecnología, la sociedad, la economía, y la cultura (Fraillon et al., 2019; Mullis y Martin, 2019; OECD, 2018). La navegación, se ha convertido en un componente transversal a cualquier tipo de aprendizaje en un mundo digital y, como describiremos a continuación, también a la forma en que se evalúan estas competencias.

Las evaluaciones a gran escala coordinadas por organismos internacionales como PISA, TIMSS (Estudio internacional de tendencias en Matemáticas y Ciencias) o PIRLS (Estudio Internacional para el Progreso de la Comprensión Lectora) se administran mayoritariamente por ordenador, siendo éste su método principal de administración también en España. Las administraciones públicas españolas llevan probando desde hace algún tiempo las pruebas informatizadas en sus evaluaciones de diagnóstico o de sistema, aunque su uso aún no está generalizado. La realidad de las aulas españolas no es muy diferente. Las evaluaciones educativas en el aula (exámenes, rúbricas, etc.) aunque habituales en muchos centros educativos aún no se ha convertido en el status quo. Sin embargo, la tendencia es clara: a medida que el acceso a internet y a dispositivos digitales aumentan también lo hace su uso. Los avances en la tecnología informática también han influido sustancialmente en las formas en que se realizan, administran, califican y se informa a los examinados (Zenisky y Sireci, 2002). En este artículo nos centramos en dos áreas emergentes que su imparable auge ha generado un cambio de paradigma en la evaluación educativa. Para más información sobre otras aplicaciones como computational psychometrics y machine learning, ver por ejemplo von Davier et al. (2019);en este monográfico Elosua (2022).

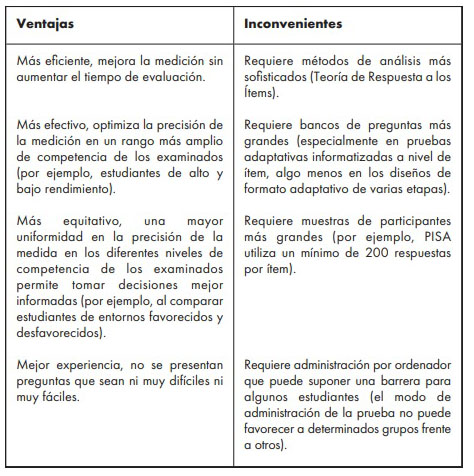

La primera y quizá más extendida es la posibilidad de realizar test adaptativos informatizados (Olea et al., 2010; en este monográfico Abad et al., 2022). Los tests adaptativos informatizados permiten aumentar la precisión en la medición utilizando menos preguntas o ítems por estudiante. Esto se logra presentando a los estudiantes ítems que están alineados con su nivel de competencia. A diferencia de las evaluaciones no adaptativas que habitualmente se centran en evaluar a estudiantes de rendimiento medio, las pruebas adaptativas también permiten una diferenciación más refinada de la capacidad del estudiante en los extremos superior e inferior del nivel de competencia del estudiante (Tabla 1). Este aspecto de las pruebas adaptativas es particularmente relevante cuando se comparan grupos de alto y bajo rendimiento o estudiantes de familias favorecidas y desfavorecidas. Al mismo tiempo, la experiencia de las pruebas para los estudiantes es mejor, ya que no necesitan responder preguntas que sean demasiado difíciles para ellos o demasiado fáciles que hagan que su interés en la prueba se reduzca. El uso de pruebas adaptativas ya se utiliza en la inmensa mayoría de evaluaciones educativas a gran escala como PISA, TIMSS, y PIRLS e incluso en la evaluación de la personalidad (Pedrosa et al., 2016; Postigo et al., 2020; en este monográfico Abad et at., 2022).

TABLA 1 RESUMEN DE LAS VENTAJAS E INCONVENIENTES DE LOS TESTS ADAPTATIVOS INFORMATIZADOS FRENTE A LOS CONVENCIONALES

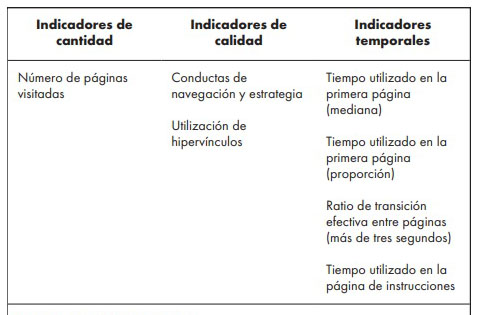

El segundo cambio revolucionario en la evaluación informatizada es la posibilidad de almacenar archivos de registro, también conocidos como datos de proceso. Estos datos contienen información sobre las acciones realizadas por los examinados cuando interaccionan con las tareas que se le presentan en el ordenador y el tiempo dedicado a cada acción durante el proceso (Tabla 2). Este tipo de datos proporciona información adicional más allá de los datos de respuesta que, por lo general, muestran si la pregunta fue respondida de forma correcta o no (He et al., 2019, 2021; von Davier et al., 2019). Por ejemplo, la cantidad de tiempo que los estudiantes dedican a responder a las pruebas puede reflejar su nivel de compromiso (si están dando lo mejor de sí) y, en consecuencia, afectar al rendimiento en la prueba (Wise et al., 2021). Esta información puede ayudar a los responsables de la formulación de políticas, a los investigadores y los educadores a comprender mejor las estrategias cognitivas de los estudiantes y las causas subyacentes del bajo y alto rendimiento. Esto, a su vez, puede repercutir en una mejora del diseño de las evaluaciones y conducir a programas de formación y aprendizaje más eficaces (OECD, 2019a).

TABLA 2 RESUMEN DE INDICADORES DE NAVEGACIÓN BASADOS EN LOS DATOS DE PROCESO

Nota: Adaptado de (OECD, 2021a).

EJEMPLO ILUSTRATIVO DEL USO DE DATOS DE PROCESO EN PISA

PISA es una encuesta trienal de estudiantes de 15 años de todo el mundo que evalúa en qué medida han adquirido los conocimientos y las habilidades clave esenciales para una participación plena en las sociedades. PISA introduce por primera vez las pruebas adaptativas informatizadas en 2018 para evaluar la competencia lectora de los estudiantes de 15 años (últimos datos disponibles hasta la fecha). La naturaleza interactiva de las evaluaciones adaptativas informatizadas como PISA las convierte en candidatos ideales para análisis basados en datos de proceso (Goldhammer et al., 2016; Vörös et al., 2021).

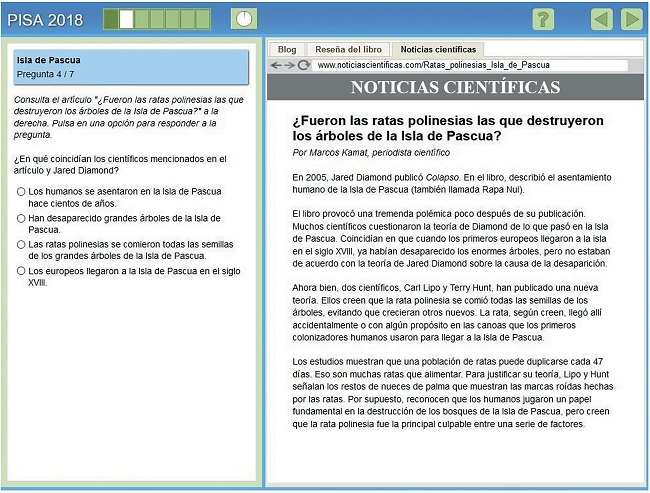

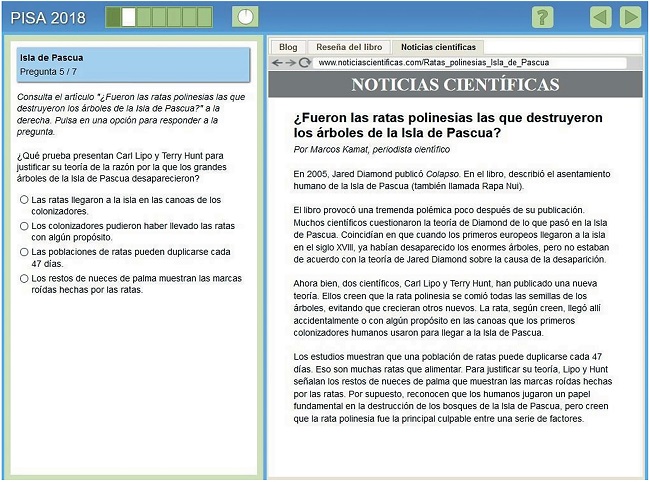

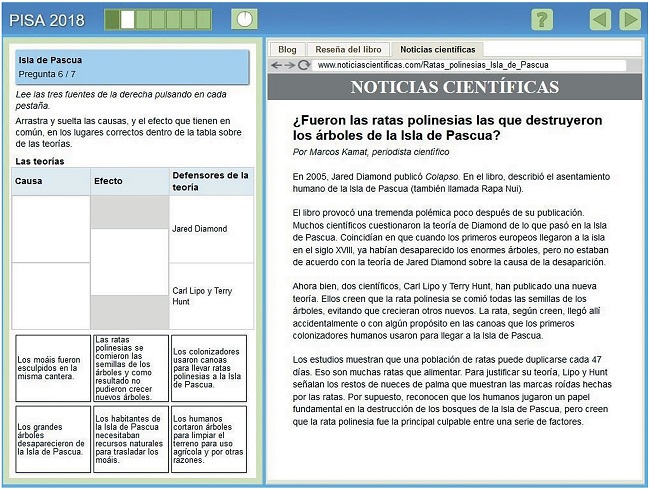

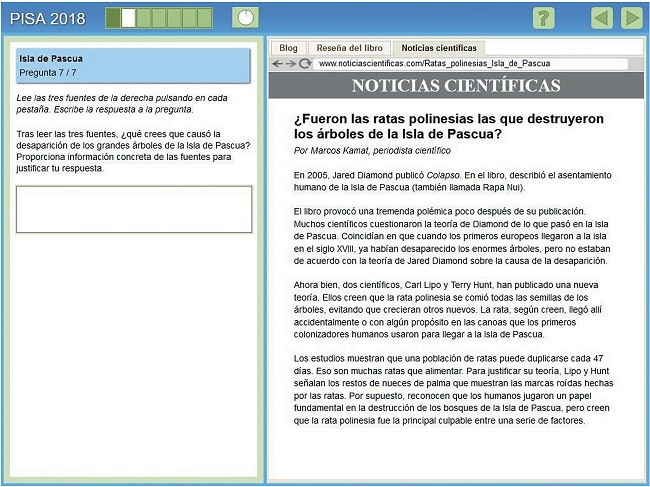

La capacidad de los estudiantes para pensar, monitorear y ajustar su actividad a una tarea en particular son aspectos esenciales a la hora de leer en entornos digitales (OECD, 2019b). Los lectores digitales no solo necesitan seguir estructuras de información lineales, si no también construir sus propios textos seleccionando y evaluando información de diferentes fuentes. Una buena navegación, por tanto, debería ser consistente con estos objetivos. La prueba de Lectura de PISA 2018 permite a los estudiantes navegar a través de las diferentes tareas de tal forma que el estudiante puede decidir cómo interactuar con el texto y qué estrategia es más eficaz. Por ejemplo, un estudiante puede decidir seguir estrictamente las instrucciones de cada tarea según aparecen mientras que otros pueden preferir explorar qué tareas vendrán a continuación para gestionar su tiempo y conocimientos de manera diferente.

El reciente informe PISA, Lectores del Siglo XXI, desarrollando la competencia lectora en un mundo digital, utiliza datos de proceso para agrupar a los estudiantes en función de su navegación en la unidad de Lectura basada en escenarios, Rapa Nui3 (CR551, ver Apéndice A):

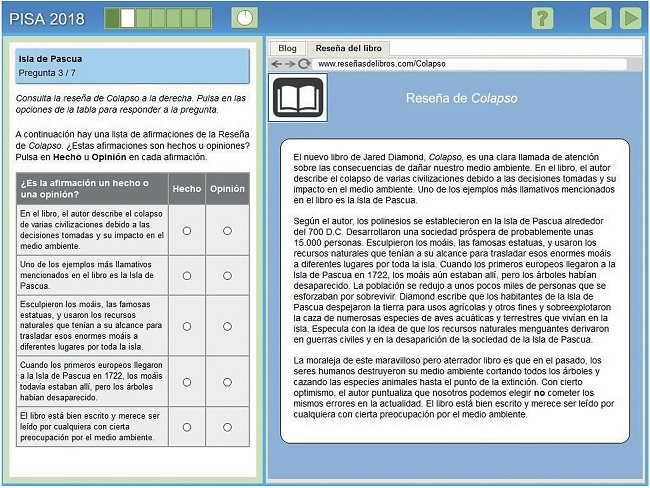

4 Sin navegación: estudiantes que no tienen actividades de navegación ni en ítems con textos de fuente única (ver Apéndice A ítems 1, 2, 3, 4 y 5) ni en ítems con textos de múltiples fuentes de información (ver Apéndice A ítems 6 y 7)

4 Navegación limitada: estudiantes que navegan simplemente en ítems con textos de una sola fuente (ver Apéndice A ítems 1, 2, 3, 4 y 5), pero no a través de ítems con textos de múltiples fuentes (ver Apéndice A ítems 6 y 7)

4 Navegación estrictamente enfocada: estudiantes que siguen estrictamente las instrucciones de las tareas para navegar activamente en ítems con textos de múltiples fuentes de información (ver Apéndice A ítems 6 y 7), pero limitaron la navegación en ítems con textos de fuente única (ver Apéndice A ítems 1, 2, 3, 4 y 5), y

4 Navegación exploratoria activa: estudiantes que navegan activamente en ítems con textos de fuente única y múltiple (ver Apéndice A ítems 1, 2, 3, 4 y 5, 6, y 7).

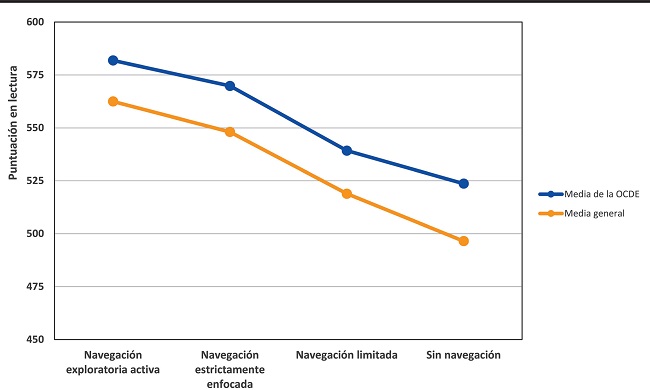

La Figura 1 muestra que el rendimiento en Lectura está fuertemente relacionado con el tipo de navegación de los estudiantes. En la mayoría de los países y economías se encontró un patrón consistente entre las puntuaciones en Lectura y los patrones de navegación. Los datos señalan una diferencia de 66 puntos entre los estudiantes que navegaron activamente entre las páginas y los que no ejecutaron actividades de navegación. El 11% de los estudiantes que pertenecían al grupo de navegación exploratoria activa obtuvieron las puntuaciones más altas en Lectura. Estos estudiantes navegaron activamente a través de tareas de fuente única (ver Apéndice A ítems 1, 2, 3, 4 y 5) y múltiple (ver Apéndice A ítems 6, y 7). Su navegación en tareas con textos de fuente única superó el número de páginas requerido para completar la tarea de lectura. Es decir, no solo leyeron la página requerida, sino también otras páginas accesibles. Este tipo de navegación podría ayudar a los estudiantes a obtener una idea general de toda la prueba de Lectura y prepararse mejor para las siguientes tareas. Esto también podría explicar, al menos en parte, la razón por la que el grupo de estudiantes de exploración activa puntuó mejor en la prueba de lectura que el grupo de estudiantes que siguió estrictamente las instrucciones de la tarea.

Fuente: (OECD, 2021a). Base de datos PISA 2018, Tabla B.3.9

FIGURA 1 SOCIACIÓN ENTRE EL RENDIMIENTO EN LECTURA Y LAS CONDUCTAS DE NAVEGACIÓN

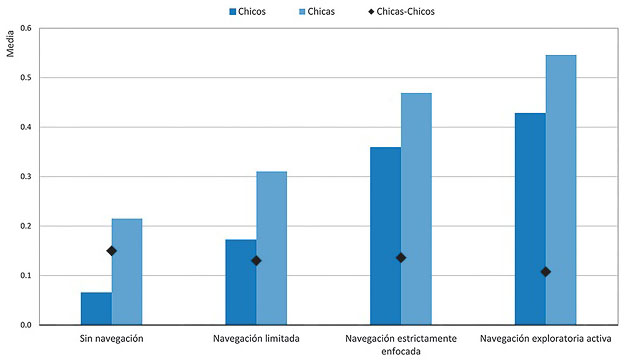

Las chicas presentan mejores estrategias de lectura que los chicos en los tres índices incluidos en PISA 2018 (comprender y recordar un texto, redactar un resumen, y evaluar la credibilidad de las fuentes de información). Este hecho se repite en todos los grupos de navegación. Aun así, tanto los chicos como las chicas que navegaron y exploraron activamente la unidad Rapa Nui tienen un mejor conocimiento de las estrategias de lectura para evaluar la credibilidad de las fuentes que los estudiantes con una navegación limitada o nula. Además, las diferencias de género en las estrategias de lectura son más estrechas entre los estudiantes con una navegación más activa que aquellos sin navegación (Figura 2).

DISCUSIÓN

El uso de la tecnología en la evaluación educativa permite utilizar nuevas fuentes de datos tanto para el proceso de evaluación (el diseño de las pruebas) como para el producto (las puntuaciones en la prueba). Los test adaptativos informatizados y los datos de proceso son dos de las áreas emergentes que más beneficios tienen en la evaluación educativa. El uso de datos de proceso en pruebas informatizadas es particularmente valioso cuando se evalúan competencias que requieren tareas interactivas y el uso de tecnología. En el caso de la evaluación de la competencia lectora, ejemplo analizado en este artículo, los estudiantes necesitan utilizar las tecnologías de la información y la comunicación (TIC) para acceder a textos a través de buscadores, utilizar enlaces y pestañas, procesar información de múltiples fuentes, evaluar la calidad de las fuentes de información, detectar posibles conflictos y resolverlos. Los datos de proceso, más concretamente las secuencias de acciones realizadas por los estudiantes cuando responden a la prueba, permiten identificar las estrategias de navegación utilizadas por los estudiantes cuando interaccionan con textos en un entorno digital. Estos datos se podrían utilizar para medir el grado en que los estudiantes se involucran en la tarea de la forma esperada y mejorar así la validez de las interpretaciones, pero también se podría utilizar junto a las respuestas de los estudiantes para estimar sus puntuaciones en las competencias examinadas (Wise et al., 2021).

De esta forma, los datos de proceso, que a priori son aspectos inherentes al método de evaluación y diseño de la prueba (el proceso), se convierten en cierta medida en el objeto de la evaluación (el producto). Es decir, la tecnología ha calado en todas las capas de la evaluación educativa de tal forma que es casi imposible desenredar la medición del constructo. Las posibilidades que este tipo de datos tiene para la evaluación educativa son incontables (Jiao et al., 2021), pero como nos recuerda el refranero español: es importante no poner el carro delante de los bueyes. Existen al menos tres consideraciones importantes para optimizar el uso de este tipo de datos:

Nota: Todas las diferencias entre chicas y chicos son estadísticamente significativas. Fuente: (OECD, 2021a). Base de datos PISA 2018, Tabla B.5.29.

FIGURA 2 ASOCIACIÓN ENTRE LAS ESTRATEGIAS DE LECTURA PARA EVALUAR LA CREDIBILIDAD DE LAS FUENTES DE INFORMACIÓN Y LAS CONDUCTAS DE NAVEGACIÓN

Diseñar la prueba con el objetivo de extraer y utilizar datos de registro. Los datos de proceso son un subproducto de características inherentes al software utilizado para realizar la evaluación. Es decir, en la inmensa mayoría de casos, las pruebas no están construidas y diseñadas con el objetivo de utilizar estos datos, sino que más bien se utilizan a modo de serendipia para mejorar el proceso y el producto de la evaluación una vez la prueba ha sido administrada y las respuestas a las preguntas codificadas. Si bien mejorar el proceso y el producto de la evaluación no tiene nada de malo, de hecho, los estándares para las pruebas educativas y psicológicas así lo recomiendan (AERA et al., 2014), es importante analizar las consecuencias que puedan tener en otras áreas también importantes de la evaluación. Por ejemplo, si el objetivo es mejorar el producto de las evaluaciones (las puntuaciones) pero el uso de datos de proceso no se ha tenido en cuenta en el diseño de la prueba, la validez de contenido (Pedrosa et al., 2014) puede verse alterada con respecto a su marco conceptual de evaluación. En otras palabras, el riesgo de dar significado a datos a posteriori es que puede desviar el objetivo y el contenido de la evaluación del originalmente propuesto en los marcos conceptuales de evaluación. Para una discusión sobre este tema ver, por ejemplo, cómo cambiarían los rankings de PISA si este tipo de datos se tuviera en cuenta en la estimación de puntuaciones (Pohl et al., 2021).

La extracción de datos de proceso debe estar basada en consideraciones teóricas y analíticas. La elección de qué información se está registrando mientras el examinado responde a la prueba no responde a consideraciones teóricas ni analíticas. Es decir, el software registra ciegamente toda la actividad del examinado, sea ésta relevante o no. Por lo tanto, la extracción de datos de proceso debe estar guiada por consideraciones teóricas y analíticas para evitar interpretaciones espurias. Una aplicación particularmente interesante del uso de datos de proceso para mejorar la medición (el proceso) consiste en utilizar tiempos de respuesta para identificar diferencias en el proceso de respuesta entre grupos culturales y lingüísticos diferentes y así mejorar la validez de las interpretaciones que de lo contrario podrían pasar por alto en los análisis de Funcionamiento Diferencial de los Ítems4 (Ercikan et al., 2020).

La interpretación de los datos de registro debe estar guiada por modelos cognitivos. Es importante señalar que los procesos de respuesta cognitiva no son observables ni en las pruebas convencionales ni en las digitales. Al igual que sucede con otros métodos para obtener evidencia de validez de los procesos de respuesta como los laboratorios cognitivos, o los protocolos de pensamiento en voz alta (Padilla y Benítez, 2014), los datos de registro no reflejan procesos cognitivos en sí, sino rastros o huellas de los procesos cognitivos que los estudiantes utilizaron. La interpretación, por tanto, requiere la utilización de métodos mixtos que compaginen interpretaciones cualitativas y cuantitativas. En otras palabras, es fundamental que la interpretación de los datos de proceso esté guiada por modelos teóricos, en este caso, cognitivos. Por ejemplo, la evaluación de constructos complejos como el razonamiento o el pensamiento crítico puede involucrar procesos cognitivos como tiempos de respuesta explícitamente incluidos en la definición del constructo. Otro ejemplo, como veíamos en este artículo, es la inclusión de conductas de navegación como un aspecto transversal en el aprendizaje de la competencia lectora en un mundo digital.

La tecnología potencia el conocimiento a niveles inimaginables, sea este conocimiento el adecuado o no. De hecho, es habitual que el conocimiento inadecuado o erróneo tenga una mayor capacidad de expansión. Véase como ejemplo la transmisión de información en las redes sociales; una noticia falsa se extiende a una velocidad más rápida que una noticia verdadera (Vosoughi et al., 2018). Mutatis mutandis, los estudios que son más difíciles de replicar tienden a ser más citados (Serra-Garcia y Gneezy, 2021). En España, además, el uso de los test en el ámbito profesional es enorme y la formación y conocimiento sobre el uso de ellos relativamente bajo (Muñiz et al., 2020; en este monográfico Hernández et at., 2022). Es la responsabilidad del investigador asegurar que el uso de los datos y la tecnología sea el adecuado para los objetivos de la evaluación y sirva de forma fiable, válida y justa a las personas involucradas, pero también del usuario saber cuándo, cómo y para qué utilizar los datos. Esperamos que este artículo ayude a reflexionar sobre ambas cosas.