My SciELO

Services on Demand

Journal

Article

Indicators

-

Cited by SciELO

Cited by SciELO -

Access statistics

Access statistics

Related links

-

Cited by Google

Cited by Google -

Similars in

SciELO

Similars in

SciELO -

Similars in Google

Similars in Google

Share

Educación Médica

Print version ISSN 1575-1813

Educ. méd. vol.9 n.2 Jun. 2006

Un sistema para hallar oportunidades de mejora en la enseñanza basado en la percepción de los alumnos

An analytical system to determine opportunities for teaching improvement based on student perceptions.

Alfredo Osvaldo Wassermann, María de los Angeles Harris, Susana Demeco y Jorge Guillermo Bernabó

Departamento de Docencia del Hospital Asociado a la Facultad de Medicina,

Universidad Nacional de Buenos Aires, "Prof. Dr. Bernardo A. Houssay"

Dirección para correspondencia:

RESUMEN

Introducción: El objetivo de este trabajo es evaluar un sistema para hallar oportunidades de mejora en la enseñanza partiendo de una encuesta de satisfacción de los alumnos.

Materiales y Métodos: Se administró una encuesta a alumnos de 15 materias durante 2003, dividida en 3 secciones: datos generales, cuantitativa (escala de Likert pentanivel) y cualitativa. Las preguntas se agruparon en 5 dominios: satisfacción general (SG), actividad docente (AD), contenidos (Co), evaluación (Ev) y estructura y confort (EC). Se realizó análisis factorial y determinación de la confiabilidad mediante coeficiente a de Cronbach. Las respuestas se evaluaron por materia y dominio, comparando niveles y significación de las diferencias con la prueba U de Mann-Whitney

Resultados: Se obtuvieron 179 encuestas de 190 alumnos ( 94%). El coeficiente a de Cronbach fue 0,90. EC no correlacionó con los otros dominios. Las respuestas se ubicaron: 27.6 % en nivel 3, 12.8 % en los niveles inferiores y 57.7 % en los superiores, indicando determinación. En los niveles superiores SG obtuvo 62%, AD 64%, Co 60%, Ev 49% y EC 50%, las teóricas 80%, los prácticos 51%, la posibilidad de participar 61%, los contenidos 81% y los conocimientos de los docentes 58%. El 83% recomendaría cursar en esta unidad (pregunta control). La pregunta referida a los objetivos obtuvo la mayor indeterminación.

Conclusiones: La encuesta demostró ser un instrumento de medición fiable. La comparación entre materias mediante análisis estadístico de las diferencias de percepción de los alumnos permitió determinar las oportunidades individuales de mejora para cada materia.

Palabras clave: Encuesta de Satisfacción de Alumnos, Evaluación de la enseñanza, Docencia de grado, Calidad de la enseñanza.

ABSTRACT

Rationale: The aim of the study was to evaluate a system to determine opportunities for teaching improvement, from a survey of student perceptions, and the level of student satisfaction regarding the quality of medical education.

Methods: A survey divided into three main areas - general data, quantitative and qualitative sections - was carried out across a sample of students from 15 courses throughout 2003. For the quantitative section, a five-level scale was used. Questions were grouped in domains: general satisfaction (GS), teaching activity (TA), contents (Co), evaluation (Ev) and structure and comfort (SC). Factor analysis and reliability were calculated using Spearman and simple correlation matrix and Cronbach´s alpha-coefficient, respectively. Answers were evaluated individually, by domain and course, comparing levels and significance of the differences with the Mann-Whitney U test.

Results: 179 surveys were obtained from 190 students. The Cronbach´s alpha-coefficient was 0.90. The answers indicated determination in choices, since only 28% of the surveyed students chose the indetermination level, while 13% chose the two lower levels, and 59% chose the higher ones. In the higher levels GS yielded 62%, TA 64%, Co 60%, Ev 49% and SC 50%, and bedside training 51%. Among surveyed students, 83% would recommend taking courses in the hospital in question (control question). The question referring to teaching objectives showed the highest level of indetermination.

Conclusions: This student satisfaction survey proved to be a reliable tool for the evaluation of education. The analytical system comparing courses through different statistical tools mainly used in quality programs made it possible to identify specific improvement opportunities for each course.

Key words: Student Satisfaction Survey, Evaluation of education, Undergraduate medical education, Quality of education.

Introducción

El proceso de educación médica de grado está sujeto a continuos cambios que intentan mejorar la eficiencia del aprendizaje. La evaluación de este proceso tiene un rol fundamental como fuente de información para detectar oportunidades de mejora e implementar acciones correctivas. La opinión de los estudiantes es consultada con frecuencia creciente, como un componente esencial para evaluar la calidad de los procesos de enseñanza y aprendizaje. Obtener la retroalimentación de los alumnos resulta aparentemente sencillo, sin embargo transformar estas opiniones en información útil para los docentes constituye el verdadero desafío.

La administración de encuestas de satisfacción es una práctica creciente en la medición de la calidad docente en las facultades de medicina1-6. No todos los autores coinciden en la confiabilidad de las encuestas de satisfacción de los alumnos con respecto a la enseñanza. En efecto, muchos docentes argumentan que los alumnos no deberían ser los evaluadores de los docentes, y que la mayor parte de los instrumentos están pobremente construidos7. De todas maneras la confianza en la evaluación de los alumnos es creciente 8-10, en especial cuando los instrumentos tienen diseño adecuado, se administran correctamente y son interpretados cuidadosamente11,12. Los instrumentos deben ser multidimensionales, fiables, estables, válidos y no afectarse por sesgos de interpretación12. Pueden ser hallados ejemplos de encuestas administradas a estudiantes de medicina en distintos países 1,13. Varias escuelas requieren la evaluación de los educandos como parte de sus procesos de aseguramiento o mejora de la calidad 14.

El objetivo de este trabajo es mostrar la implementación y utilidad de un sistema de evaluación de la calidad de la enseñanza normalizado, útil y confiable, originado en las opiniones de los alumnos, que permite la detección de las oportunidades de mejora y la priorización de las más relevantes, mediante la aplicación de un conjunto de herramientas estadísticas habitualmente empleado en los sistemas de calidad.

Material y métodos

El Hospital "Prof. Dr. Bernardo Houssay", está Asociado a la Facultad de Medicina de la Universidad de Buenos Aires, Argentina. Tanto el Hospital como la Facultad son instituciones públicas, sin cargo para la atención de los pacientes o la formación médica de pregrado. En este Hospital comenzamos a utilizar una encuesta de satisfacción de los alumnos durante el año 2003.

Luego de considerar los datos de la consulta bibliográfica se definieron los dominios a encuestar y se diseñaron las preguntas para medir satisfacción. Se construyó un cuestionario con 13 preguntas, agrupadas en forma no matricial para evitar las respuestas automatizadas. Se ajustó el instrumento luego de una prueba piloto realizada en egresados recientes para verificar la comprensión de los términos utilizados, interrogando a cada uno acerca de lo que interpretaba como contenido de cada pregunta. Se les consultó además si consideraban que el cuestionario medía su propio grado de satisfacción con el curso. Consideramos validado el instrumento luego de los ajustes determinados en esta etapa.

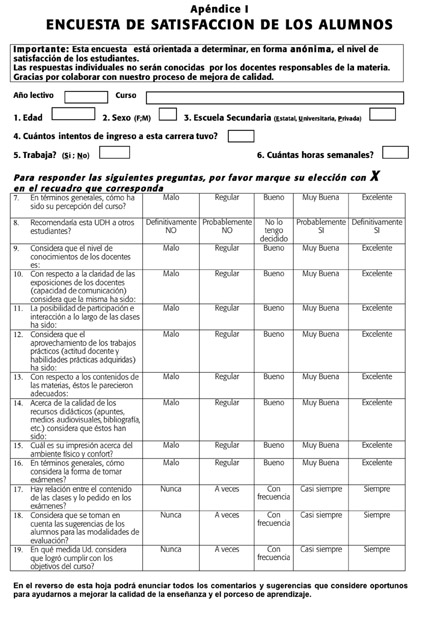

El cuestionario consta de 3 partes (Apéndice I): a) datos generales: 6 preguntas; b) sector cuantitativo o cuerpo principal de la exploración: 13 preguntas y c) sector cualitativo no cuantificable de comentarios libres. La pregunta 8 se elaboró de acuerdo a la tipificación de una pregunta control.

Las 13 preguntas del sector cuantitativo ofrecen una escala categórica de medición ordinal tipo Likert de 5 niveles, siendo 1 la puntuación más negativa y 5 la más positiva, adaptando las propuestas al tipo de pregunta. De acuerdo a su contenido las preguntas del sector cuantitativo se agruparon por dominios para el análisis, tal como muestra la tabla 1.

El estudio se orientó inicialmente en forma transversal. Un encuestador, independiente de los cuerpos docentes de cada materia, invitó a los alumnos de 15 materias cursadas en este Hospital durante el año 2003 a contestar la encuesta, en forma anónima, a continuación del examen final y antes de conocerse la calificación correspondiente. La encuesta se administró luego de cursar las siguientes materias: Cirugía, Dermatología, Gine-cología, Medicina Interna A (Semiología), Medicina Interna B (Clínica y terapéutica), Neumología, Neurocirugía, Neurología, Nutrición, Obstetricia, Otorrinolaringología, Pediatría, Psiquiatría, Trau-matología y Urología.

Para el conjunto de datos obtenidos se realizó análisis factorial por matrices de correlación de Spearman. La determinación de la consistencia interna se realizó calculando el coeficiente alfa de Cronbach para las respuestas consideradas individualmente, para los dominios y para los promedios de los dominios para cada materia.

Los resultados se evaluaron de dos formas complementarias. La primera como proporción de respuestas en cada nivel para cada pregunta individualmente y para las preguntas agrupadas por dominio. La segunda determinando la mediana y rango intercuartílico (RIC) de los valores de las respuestas de cada dominio. Se compararon los dominios entre materias y con los resultados globales con la prueba no paramétrica U de Mann-Whitney y se determinaron los niveles de significación estadística. Se consideró la diferencia como estadísticamente significativa cuando la p resultaba menor a 0,05.

Se confeccionó un gráfico comparativo ordenando los resultados de menor a mayor, insertando la mediana global en la posición correspondiente. Para el análisis estadístico se utilizó el programa SPSS 13.0.

Al finalizar cada una de las cursadas de cada una de las materias se entregó a los encargados de enseñanza de cada materia el análisis estadístico individual, con un informe resumido.

Para preservar la confidencialidad de los datos y evitar competitividad improductiva, las materias fueron informadas en forma codificada. Esta confidencialidad es mantenida en este informe ya que consideramos que la implementación de un modelo de este tipo se beneficia con esta condición.

Resultados

Se obtuvieron 179 encuestas sobre 190 alumnos que rindieron los respectivos exámenes finales, representando el 94% del universo teórico. Se dividieron en 131 (73,2%) de género femenino y 48 (26,8%) de género masculino, con una edad de 25,3 con un desvío estándar de 2,4 años. Dado que los alumnos tienen la posibilidad de cursar varias materias en el mismo Hospital a lo largo del período evaluado, es posible que los alumnos hayan respondido la encuesta en varias materias cursadas a lo largo del período de evaluación. Los datos presentados a continuación se refieren a alumnos-materia. En los casos que una materia haya tenido más de un curso durante el año, los resultados se suministran por materia, agrupando los alumnos de todos los cursos.

El análisis de consistencia interna de la encuesta muestra un coeficiente a de Cronbach de 0,90 cuando se calcula en función de las respuestas individuales para cada pregunta, de 0,88 cuando se calcula para las respuestas agrupadas por dominios y de 0,85 cuando se agrupan además por materia, superando en las 3 modalidades el valor 0,70 considerado aceptable12,13.

El análisis factorial de las preguntas consideradas individualmente, determinada por la matriz de correlación de Spearman, aceptando un nivel de significación estadística de a = 0,05 (dos colas) sólo permite discriminar la pregunta 15 referida a Estructura y Confort. La pregunta 8, tomada como control, correlaciona con todas las otras excepto la pregunta 15.

Las datos en la tabla 1 permiten apreciar que las respuestas fueron elegidas indicando posición frente a la pregunta, ya que el nivel 3 de la escala de Likert, que podría considerarse como nivel de indefinición, sólo fue seleccionado en el 28% de las posibilidades totales. El 13% de las preguntas fue respondida en los niveles 1 y 2, y el 59% en los niveles 4 y 5. Adicionalmente, la comparación de las proporciones de los niveles obtenidos en las respuestas a cada pregunta muestran amplia discriminación en la selección de las mismas. Más aún, las respuestas correspondientes a las preguntas de un mismo dominio permiten observar discriminación para cada uno de los aspectos encuestados. Por ejemplo, en el dominio Satisfacción General la pregunta 8 obtuvo el 83% de respuestas en los niveles 4-5 y 12% en el nivel 3; en tanto la pregunta 19, que inquiría acerca de los objetivos de la materia, obtuvo un 56% de respuestas en el nivel 3, representando el mayor nivel de indeterminación del cuestionario, coincidente con lo observado en la matriz de correlación.

El dominio Satisfacción General mostró un 62% de respuestas en nivel 4 y 5, 33% en el nivel intermedio y 5% en los niveles 1 y 2. En este dominio se incluyen la pregunta con mayor tasa de aceptación, indicando que el 83% de los alumnos recomendaría cursar en este Hospital.

El análisis de las preguntas del dominio Actividad Docente, muestra 64% de respuestas en niveles 4 y 5, 28% en nivel 3 y 8% en niveles 1 y 2. En los aspectos referidos a las clases teóricas el 80% calificó las exposiciones de los docentes con nivel 4 y 5, la posibilidad de participar con el 61% y los conocimientos docentes con el 58% en este nivel. En contraposición, los trabajos prácticos sólo obtuvieron el 51% de respuestas en este nivel.

El dominio Contenidos obtuvo 60% de respuestas en niveles 4 y 5, 28 % en nivel 3 y 12% en niveles 1 y 2. El 81% consideró que los contenidos de las materias eran adecuados en los niveles 4 y 5, pero sólo el 47% consideró que los recursos didácticos se hallaban en este nivel.

El dominio referido a Evaluación obtuvo 49% de respuestas en niveles 4 y 5, 24% en nivel 3 y 27% en niveles 1 y 2. El 68% manifestó adecuada relación entre los contenidos de la evaluación y de las clases, el 52% que la metodología de la evaluación era correcta, pero sólo el 25% consideraba que las sugerencias de los alumnos eran tenidas en cuenta para la selección de la modalidad de la evaluación.

La pregunta referida a la Estructura física y Confort para cursar las materias, presentó la mayor frecuencia de abstención de respuesta. Sin embargo, las respuestas consignadas ubican el nivel de aceptación dentro del rango del conjunto de preguntas. Los resultados por materia permiten apreciar diferencias aún cuando se cursaron en las mismas instalaciones.

La tabla 2 muestra la mediana y RIC para cada una de las preguntas y para el conjunto. La mediana del conjunto fue de 3,7 (RIC: 3,2-4,0); 4 materias resultaron significativamente mejor y 2 peor evaluadas. El gráfico en la figura 1 muestra los gráficos en caja, conformados por el RIC marcando las medianas, los cuales permiten observar las diferencias en la apreciación global entre materias.

El gráfico en la figura 2 muestra las medianas de cada dominio para cada materia, permitiendo comparar los resultados en cada uno de los aspectos evaluados.

El 66% de los alumnos realizó 293 comentarios en el sector cualitativo de la encuesta. Entre ellos, 71 eran evaluaciones positivas, 118 negativas, las cuales se acompañaron de 105 sugerencias. Los temas más frecuentemente abordados fueron la necesidad de disponer un programa previo, demanda de mayor tiempo dedicado a actividades prácticas, mayor correlación de las evaluaciones con los contenidos y mejorar la infraestructura.

Discusión

La evaluación del proceso de enseñanza está clásicamente enfocada hacia los estudiantes, utilizando instrumentos destinados a medir sus conocimientos y, en menor grado, sus competencias. La evaluación enfocada hacia los docentes, los programas y las instituciones académicas, a cargo de pares u organizaciones externas es de uso creciente. La utilización de la opinión de los estudiantes, destinatarios directamente involucrados y afectados por los resultados del proceso educativo es menos utilizada y aceptada15.

La crítica fundamental que se formula sobre la mayoría de las estrategias evaluativas implementadas es la falta de clarificación de los propósitos que las promueven. Con frecuencia las instituciones establecen procesos evaluativos sin considerar previamente los objetivos ni las consecuencias que dichos procesos podrían generar para los sujetos y para la institución16. Coincidiendo con otros autores16 hemos seleccionado un instrumento idóneo para que el profesor pueda visualizar sus fortalezas, así como las debilidades hacia las que debe dirigir sus esfuerzos para mejorar. El objetivo primario de la evaluación del cuerpo docente es brindar ayuda para mejorar el desempeño17. La finalidad esencial de todo sistema de evaluación debe orientarse preferentemente a ayudar a que el profesor descubra cómo puede mejorar su práctica docente; en definitiva, cómo puede mejorar la calidad de la enseñanza18

La capacidad de los estudiantes para participar de la evaluación de la tarea docente es tema de debate. Se acepta actualmente que los estudiantes pueden ser una fuente accesible y válida de información, opinión crítica constructiva y recomendaciones para el cambio14,19,20. Como usuarios cotidianos e interesados ellos observan diariamente las distintas actividades y actitudes docentes y, aún cuando no son observadores expertos forman opinión válida sobre los temas que les competen. Es importante que los alumnos sientan que se los compromete y se los hace participar en los programas de mejora de la calidad de la actividad educativa, que sus opiniones son respetadas, y que la información obtenida es adecuadamente utilizada. Es también importante que los alumnos sean informados acerca de los resultados de las encuestas y del uso y acciones resultantes de estos datos14.

De los resultados de este trabajo merece considerarse en primer lugar el alto porcentaje de respuestas obtenidas: 84% del total de cursantes y 94 % de los alumnos que se presentaron a rendir el examen final de la asignatura. Esto es además un indicador de la confiabilidad de los resultados2. Este alto porcentaje de respuestas, así como el número y riqueza de los comentarios libres, se han mantenido durante todo el período de utilización de la encuesta, aún cuando los encuestados eran en su mayoría los mismos alumnos finalizando diferentes asignaturas. Pensamos que esto puede estar en relación con el limitado número de preguntas, la sencillez y claridad de las mismas, la metodología y el momento de administración de la encuesta y la percepción, de parte de los alumnos, del uso dado a los resultados.

El análisis formal mostró que la encuesta es adecuada para la obtención de información a partir de las respuestas obtenidas y permitió a los docentes de cada materia hallar oportunidades de mejora a partir de la comparación con otras materias y con los resultados globales.

La encuesta utilizada mostró poseer las siguientes cualidades:

a) es adecuada para obtener información.

b) obtuvo adecuada consistencia interna como lo demuestra el valor del coeficiente de Cronbach referidos a preguntas, dominios y materias21,22.

d) obtuvo determinación en la selección de las respuestas (tabla 1)

e) permite detectar oportunidades de mejora y de la actividad docente, al facilitar la comparación numérica y gráfica entre materias y de cada materia con los resultados globales. Esto permitirá también, al comparar distintas cursadas de la misma materia, monitorear los resultados de los cambios que se implementen (tabla 2, figura 2).

El uso sistemático de la encuesta al finalizar la cursada de cada una de las materias, seguida de su análisis estadístico, permitió la presentación de un informe resumido y el análisis de los resultados con los equipos docentes a cargo de las distintas materias, provocando un fuerte estímulo a la reflexión sobre la actividad desarrollada, a la mayor búsqueda de antecedentes y lectura de bibliografía y a la relación e interacción entre docentes de distintas asignaturas. En otras palabras, las tareas generadas por la evaluación y su análisis impulsaron el desarrollo del proceso de mejora de las actividades docentes. La idoneidad de los instrumentos evaluativos es superior cuando tienen la capacidad de generar mejoras inmediatas23, y en este caso el análisis de la encuesta entregado a los docentes en forma coincidente con la finalización de la cursada, permitía un aprendizaje basado en las dificultades recientes.

Además, el disponer de un instrumento de medición objetiva y externa, de aplicación sistemática permitió a los docentes contar con datos numéricos, gráficos y tablas confiables de referencia y comparación. Esto facilitó la discusión crítica de la actividad docente llevándola a un terreno racional, y alejándola de subjetividades y emociones.

Globalmente se evaluó mejor a los docentes que a los recursos. La encuesta permitió apreciar respuestas de menor nivel cuando se interroga por los trabajos prácticos comparado con las clases teóricas, y dentro de éstas la posibilidad de participar es menos apreciada que la claridad en las exposiciones. La evaluación de los componentes del dominio Actividad Docente solicita claramente mayor posibilidad de participación e interacción durante las clases teóricas, mejorar el desempeño de los trabajos prácticos y participación de los alumnos tanto en las instancias del aprendizaje como en la selección de las modalidades de evaluación.

La elevada selección del nivel de indeterminación en la pregunta19 podría interpretarse como desconocimiento o falta de comprensión de los objetivos para el estudio de las respectivas materias. Por otro lado, la mayor dispersión de respuestas referidas a la materia 14 confirma que las mayores dispersiones se relacionan con los peores resultados.

Los docentes de la materia con peor desempeño en el dominio Estructura y Confort, habían presentado frecuentes reclamos durante el desarrollo del curso. Los docentes de la materia 21 refirieron su propia falta de aceptación a la modalidad de evaluación impuesta, traduciéndose como el dominio con peor nivel para esta materia. De esta manera pudimos apreciar que la encuesta fue útil para poner en un plano concreto presunciones fundadas en la observación empírica.

La encuesta permite identificar las diferencias en la evaluación de los dominios dentro de cada asignatura, las cuales pueden ser aprovechadas como las principales oportunidades individuales para lograr una mejora en la calidad de la enseñanza (gráfico 2), las cuales fueron:

Elaborar y transmitir los objetivos del aprendizaje para cada materia.

Mejorar los recursos didácticos.

Adecuar aspectos de estructura y confort a las necesidades.

Elevar el nivel de las actividades prácticas.

Adecuar la metodología de la evaluación.

La figura 2 permite además una comparación relativa por criterio a través de todas las materias, estableciendo un escalamiento que resulta útil para detectar las oportunidades de mejora individuales de cada materia. Las oportunidades de mejora fueron apreciadas a través de las diferencias entre materias, que alcanzaron diferencias estadísticamente significativas en algunos casos, y la diferencia en la evaluación de los criterios para cada materia.

Probablemente la oportunidad de mejora que demande implementación prioritaria sea la adecuada transmisión de los objetivos de la enseñanza de cada materia a los alumnos. El déficit en la transmisión de los objetivos fue también hallado por otras encuestas4 y ha sido considerado como uno de los inconvenientes más frecuentes en las escuelas de medicina24. Algunos otros problemas comunes en la enseñanza de la medicina fueron hallados, tales como la reducida motivación para incrementar la participación activa de los estudiantes durante las clases y la poca inducción para la reflexión y discusión24. Estas dificultades pertenecen a categorías reiteradamente detectadas en trabajos e informes de evaluación de la enseñanza y las propuestas de cambio no han podido resolverlas a pesar del transcurso del tiempo como muestran revisiones recientes24,25.

La sección cualitativa de comentarios libres fue extensamente utilizada a diferencia de lo observado por otros autores18. La síntesis de estos comentarios se correlacionó con los resultados del análisis cuantitativo de la encuesta agregando percepciones difíciles de indagar por una encuesta cuantitativa.

El análisis conjunto de los sectores cuantitativo y cualitativo de la encuesta permite una observación con enfoques diferentes y complementarios, que al resultar correlacionables agregan confianza en los resultados.

Se ha sugerido que la magnitud de los esfuerzos y recursos destinados a la evaluación de la enseñanza debe ser contrastada con el valor y el uso que se da al proceso de evaluación y sus resultados15. La implementación de la encuesta nos proporcionó gran cantidad de información útil, en relación a un moderado requerimiento de recursos.

La encuesta de satisfacción de los alumnos y el sistema de análisis empleado demostraron conformar un instrumento de medición fiable para ser incorporado como herramienta de evaluación de la enseñanza. Sus resultados permitirán diseñar estrategias para mejorar el proceso de enseñanza en este Hospital.

Agradecimientos

Los autoresagradecen a la Dra. María del CarmenIanella, su colaboración en el análisis estadístico.

Bibliografía

1. Ziaee V, Ahmadinejad Z, Morravedji AR. An evaluation on medical student satisfaction with clinical education and its effective factors. Med Educ Online [serial online] 2004;9:8. Disponible en http://www.med-ed-online.org/f0000082.htm. Última consulta 2 de diciembre de 2005. [ Links ]

2. Metcalfe DH, Matharu M. Students' perception of good and bad teaching: report of a critical incident study. Med Educ. 1995;29:193-7. [ Links ]

3. Webwe A, Wacker A, Weltle D, Lehnert G. Assessment of teaching at the faculties of medicine in Germany. Dtsch Med Wochenschr. 2000;125:1560-4. [ Links ]

4. Bloomfield L, Harris P, Hughes C. What the students want? The types of learning activities preferred by final year medical students. Med Educ. 2003;37:110-8. [ Links ]

5. Monteiro Pelusso MA, Tavares H, Délia G. Assessment of medical courses in Brazil using student-completed questionaires. Is it reliable? Rev Hosp Clin Fac Med S Paulo. 2000;55:55-60. [ Links ]

6. Shores JH, Clearfield M, Alexander J. An index of students' satisfaction with instruction. Acad Med. 2000;75(10 Suppl):S106-8. [ Links ]

7. Morton PG. Student evaluation of teaching: potential and limitations. Nurs Outlook. 1987;35:86-8. [ Links ]

8. Aleamoni LM. Student Ratings of Instruction. En J. Millman (Ed.), Handbook of teacher evaluation. Beverly Hills, California, USA: Sage. 1981. [ Links ]

9. Braskamp L A & Ory JC. Assessing faculty work: Enhancing individual and institutional performance. San Francisco: Jossey-Bass. 1994. [ Links ]

10. Cashin WE. Student ratings of teaching: The research revisited. IDEA Paper No. 32, IDEA Center, Kansas State University, Center for Faculty Evaluation and Development. 1995. Disponible en: http://www.idea.ksu.edu/papers/Idea_Paper_32.pdf. Última consulta el 2 de diciembre de 2005. [ Links ]

11. Fong CM, McCauley GT. Measuring the nursing, teaching, and interpersonal effectiveness of clinical instructors. J Nurs Educ. 1993;32:325-8. [ Links ]

12. Gien LT. Evaluation of faculty teaching effectiveness-toward accountability in education. J Nurs Educ. 1991;30:92-4. [ Links ]

13. Hoyt DP, Pallett H. Appraising Teaching Effectiveness: Beyond Student Ratings. Individual Development & Educational Assessment. Idea Paper #36, 1999. Disponible en http://www.idea.ksu.edu/papers/Idea_Paper_36.pdf. Última consulta el 2 de diciembre de 2005. [ Links ]

14. Morrison J. ABC of learning and teaching in medicine. Evaluation. BMJ. 2003;326:385-7 [ Links ]

15. Snell L, Tallett S, Haist S, Hays R, Norcini J, Prince K, Rothman A, Rowe R. A review of the evaluation of clinical teaching: new perspectives and challenges. Med Educ. 2000;34:862-70 [ Links ]

16. Miguel Díaz, M de. Evaluación y mejora de la actividad docente del profesorado universitario. Educ. méd. 2003;6(3):22-25. [ Links ]

17. Cashin WE. Developing an effective faculty evaluation system. IEA Paper No.33. IDEA Center, Kansas State University, Center for Faculty Evaluation and Development. 1996. Disponible en: http://www.idea.ksu.edu/papers/Idea _Paper_33.pdf. Último acceso el 2 de diciembre de 2005. [ Links ]

18. Prada JA, Verástegui Escolano C y Velázquez Martínez R. Aportaciones del Alumnado al estado actual de la calidad de la docencia en Anatomía. Educ. méd. 2003;6(4):153-158. [ Links ]

19. Martin JA, Carey RM. The student-initiated, faculty-assisted system of evaluation of clinical teaching at the University of Virginia. Acad Med. 1991;66:773-5. [ Links ]

20. González Such J. Modelos, procedimientos e instrumentos de evaluación de la actividad docente. Educ. méd. 2003;6(3):20-21. [ Links ]

21. Cronbach, LJ. Coefficient alpha and the internal structure of tests. Psychometrica. 1951;16: 297-334. [ Links ]

22. Nunnally, JC. Psychometric theory. New York: McGraw-Hill, 1978. [ Links ]

23. Murray, HG. Does evaluation of teaching lead to improvement of teaching? Int J Acad Dev. 1997;2(1):8-23. [ Links ]

24. Spencer J. ABC of learning and teaching in medicine. Learning and teaching in the clinical environment. BMJ. 2003;326:591-4 [ Links ]

25. Christakis NA. The similarity and frequency of proposals to reform US medical education. Constant concerns. JAMA. 1995;274:706-11. [ Links ]

![]() Dirección para correspondencia

Dirección para correspondencia

Alfredo Osvaldo Wassermann

Av. Hipólito Yrigoyen 1757 Florida - Vicente López

Provincia de Buenos Aires Argentina (B1602BPD)

Telefax: (5411) 4796-7211

Correo electrónico: aowassermann@fmed.uba.ar