Mi SciELO

Servicios Personalizados

Revista

Articulo

Indicadores

-

Citado por SciELO

Citado por SciELO -

Accesos

Accesos

Links relacionados

-

Citado por Google

Citado por Google -

Similares en

SciELO

Similares en

SciELO -

Similares en Google

Similares en Google

Compartir

Educación Médica

versión impresa ISSN 1575-1813

Educ. méd. vol.9 no.4b dic. 2006

Competencia clínica de los médicos de familia en 14 Comunidades Autónomas españolas.

Clinical competence of the general practitioners in 14 Spanish Different Communities

D. Ramírez-Puerta1, M. González-Béjar2, J. Zarco-Rodríguez3, I. Gilbert4 y A. Gual-Sala5

1 Centro de Salud los Fresnos, Área 3 del Servicio Madrileño de Salud. Madrid

2 Centro de Salud Montesa. Área 2 del Servicio Madrileño de Salud. Madrid

3 Centro de Salud La Plata, Área 3 del Servicio Madrileño de Salud. Madrid

4 ABS Cardedeu-Llinars. CAP Linars del Valle

5 Facultat de Medicina, UB - IDIBAPS

Dirección para correspondencia

RESUMEN

Fundamento y Objetivo: El Desarrollo Profesional Continuo (DPC) es un proceso de adquisición, mantenimiento y mejora de conocimientos, habilidades, actitudes y competencia profesional. En España, mantener la competencia es responsabilidad del profesional, para ello debe detectar objetivamente sus déficts formativos. Este estudio, pretende detectar diferencias en niveles de competencia clínica y déficits formativos, entre médicos de familia de distintas CC.AA. españolas, en el año 2005.

Sujetos y método: Estudio descriptivo transversal. Se evaluaron 1158 médicos de 14 CCAA. Se utilizó como herramienta la Evaluación de Competencia Objetiva Estructurada (ECOE) de 15 estaciones. Se compararon las puntuaciones globales obtenidas, por competencias y área de conocimiento mediante ANOVA, y se estudió la fiabilidad de la prueba, mediante el alfa de Cronbach.

Resultados: La puntuación global media fue 59,08 (DE 6,12), (IC 95%: 58,52-59,31). Se detectaron diferencias significativas entre Cataluña (63,65±5,2) y Castilla-León (55,37±5,78), Valencia (57,20±7,18), Andalucía (57,67±6,04), y Murcia (57,19±5,50). Por componente competencial, el mejor resultado correspondió al área de comunicación (80,11% del ideal) y el peor a atención familiar (45,54%). Por áreas de conocimiento, el mayor se obtuvo en dolor abdominal (75,94±14,70) y el menor en diabetes (43,36±15.97). El coeficiente de fiabilidad global de la prueba, alfa de Cronbach, fue 0,79.

Conclusiones: Este estudio muestra el mapa competencial de los médicos de familia españoles y las diferencias existentes entre CCAA. La competencia es globalmente buena. Este tipo de estudio aporta una visión integral al médico de familia sobre su DPC, que le servirá de guía en su formación, para conseguir la excelencia profesional y mantenerla.

Palabras clave: Medicina de Familia. Desarrollo Profesional Continuo (DPC). ECOE (Evaluación Competencia Clínica Objetiva y Estructurada).

ABSTRACT

Objective: The Continuous Professional Development (CPD) is a process of acquisition, maintenance and improvement of knowledge, abilities, attitudes and professional competence. In Spain, the manteinance of the clinical competence is responsibility of the professional. The professional for it must detect his déficts of formation objectively. This study detects differences in levels of clinical competence and deficits of formation in general practitioners of different Spanish Communities, in 2005.

Method: Cross sectional study. 1158 doctors of 14 Communities were evaluated. The Objective Structured Clinical Examination (OSCE) was used as a tool with 15 different clinical situations. The global scores were compared. By competitions and area of knowledge by means of ANOVA. The reliability of the test was assessed of alpha Cronbach.

Results: The global score average was 59.08 (SD 6,12)(IC 95 58,52-59,31). Significant differences were detected between Cataluña (63,65 SD 5,2) and Castilla Leon (55,37 SD 5,78), Valencia (57,20 SD 7,18), Andalucia (57,67 SD 6,04) and Murcia(57,19 SD 5,50). By competential component, the best result corresponded to the area of communication (80.11% of ideal) and the worse one to family attention (45,54%). By areas of knowledge was detected, the greater in abdominal pain (75,94 SD 14,70) and the minor in diabetes (43,36 SD 15.97). The global coefficient of reliability of the test was 0,79.

Conclusions: This study shows to the competential map of the Spanish general practitioner and the existing differences between Communities. The clinical competence is globally good. This type of study contributes to an integral vision of the general practitioner on its CPD, it will serve to him as a guide in their formation, to obtain the professional excellence and to maintain it.

Key words: General practitioner. Continuous Professional Development (CPD). OSCE (Objective Structured Clinical Examination).

Introducción

El cambio introducido por el concepto de Desarrollo Profesional Continuo (DPC) individual, en sustitución de la tradicional Formación Médica Continuada (FMC), comienza a finales de los años 90 en el Reino Unido y ha estado relacionado con el desarrollo de la "clinical governance" o gestión clínica. En el contexto internacional el DPC se considera como un elemento de mejora de la calidad asistencial, como se desprende del documento Quality in the new NHS del Reino Unido1. También en los EE.UU. de América se ha ido introduciendo el concepto de DPC individual, de modo que la División de FMC de la AMA (American Medical Association) se ha convertido en División de CPPD (Continuing Professional Physicians Development)2.

El DPC hay que entenderlo como el proceso de adquisición, mantenimiento y mejora de conocimientos, habilidades y actitudes y de la competencia profesional, proceso acreditable por diferentes razones, pero fundamentalmente para garantizar al ciudadano la calidad, tanto del profesional como de la profesión médica. Queda claro pues, que el DPC esta en la órbita y responsabilidades del profesional y de las organizaciones profesionales y no en la del empleador o de las patronales, y que se diferencia claramente de otros conceptos, como el de carrera profesional o Sistema de Incentivación y Promoción Profesional, con el que frecuentemente se les compara, cuando no confunde2.

Mantener permanentemente la competencia es, sin duda, una de las responsabilidades del profesionalismo y, en aras de ello, los profesionales y sus organizaciones deben detectar sus necesidades formativas de manera objetiva, para ofrecer los programas formativos ad hoc. En general, las necesidades sentidas o percibidas suelen estar tamizadas por elementos subjetivos, en relación con intereses personales, a las características de la formación previa, o a intereses externos, a veces no bien definidos3. Sin embargo, las necesidades formativas objetivadas nos definen las áreas de mejora de la competencia profesional de los médicos, así como los posibles déficits formativos.

La competencia clínica es un concepto complejo y multidisciplinar4-5, un fenómeno dinámico que cambia y se expresa de diversas maneras a medida que los profesionales adquieren experiencia6. Si bien existen diferentes metodológicas para la evaluación de la competencia clínica, como video-grabaciones de consultas, selfaudits, porfolio, revisiones mediante visitas realizadas por otros profesionales al centro y a la consulta, auditorias de historias clínicas y cumplimentación de cuestionarios sobre habilidades comunicacionales y diagnósticas7, se eligió para este trabajo una prueba ECOE, por la difusión y conocimiento que ha tenido en los últimos años en nuestro país8, 9, 10. Este instrumento incorpora diversos elementos evaluativos, que simulan situaciones clínicas verídicas y que exploran tres de los cuatro niveles de la pirámide de Miller: saber, saber cómo y mostrar cómo11.

Con la finalidad de detectar posibles diferencias o incluso carencias y como consecuencia, disponer de la capacidad de proponer programas formativos pertinentes, el Grupo de Desarrollo Profesional de SEMERGEN (Sociedad Española de Médicos de Atención Primaria), propuso un primer análisis que permitiera objetivar, de una forma genérica, los niveles de la competencia clínica y los posibles déficits formativos de los médicos de familia en diferentes CC.AA. españolas. Para realizar este mapeo, se planteó una evaluación de la competencia clínica, mediante un estudio descriptivo transversal, que utilizó la metodología de la Evaluación Clínica Objetiva y Estructurada (ECOE)12, que nos permite orientar las debilidades competenciales de los profesionales de las distintas CC.AA. de nuestro país, en el manejo de determinadas situaciones clínicas, y establecer una comparación entre dichas Comunidades.

Sujetos y método

Se trata de un estudio descriptivo transversal de la competencia clínica de los médicos de familia de 14 CCAA españolas, utilizando como instrumento de evaluación una ECOE.

1. Comité de Prueba

En primer lugar, en el año 2004, se constituyó el Comité de Prueba (CP), formado por 15 médicos de familia (*) que cumplían los siguientes criterios: experiencia en la práctica clínica habitual como médicos de Atención Primaria, experiencia docente e investigadora y formación específica en el ámbito de la evaluación de la competencia profesional13. Sus funciones consistieron en: definir los componentes competenciales, definir los criterios de priorización de los mismos, listar y priorizar las situaciones clínicas, construir la tabla de especificaciones, diseñar los casos clínicos de la ECOE, así como listar y priorizar el listado evaluativo, realizar el pilotaje y validar la prueba.

2. Diseño de la ECOE

Sobre la base del Programa Oficial de la Especialidad en Medicina Familiar y Comunitaria14, se definió y ponderó de forma consensuada siete componentes competenciales de la prueba: anamnesis, exploración física, manejo (capacidad para establecer un plan diagnóstico, terapéutico y de seguimiento correctos), habilidades técnicas, actividades preventivas, atención familiar y comunicación. La ponderación de las siete áreas competenciales definidas se muestra en la Tabla 1.

Las estaciones o casos de la prueba se seleccionaron entre un listado de situaciones clínicas representativas de la práctica clínica diaria. La priorización se realizó, de forma consensuada, mediante instrumentos objetivos como la matriz decisional, utilizando la ponderación de los siguientes criterios: prevalencia en la consulta de AP, gravedad de la clínica, importancia de la prevención y diagnóstico precoz, complejidad del caso, evaluación de la capacidad resolutiva del médico, factibilidad en el montaje y ejecución del caso, facilidad y simplicidad en la evaluación15, 16. Una vez elegido el instrumento más adecuado a la situación clínica planteada (imágenes clínicas, maniquíes, actor, o preguntas abiertas de respuesta corta), se elaboró la Tabla de Especificaciones (Tabla 1), que combina las competencias a valorar, los instrumentos evaluados y las situaciones clínicas a desarrollar. En las estaciones donde el instrumento evaluativo era un actor, el sexo del mismo se estableció atendiendo a la epidemiología de la situación clínica que constituía el caso.

La prueba se compuso con 15 estaciones o situaciones clínicas distintas; todas ellas en alguno de los posibles escenarios de una consulta de Atención Primaria (AP), esto es, a demanda, programada o urgencias. La duración de cada estación fue de 6 minutos, y la duración total de la prueba de 2 horas. Cada componente competencial se valoraba como mínimo en dos estaciones, con una media de 5,71 estaciones (moda 9). El número de componentes competenciales que se valoraron en cada estación osciló entre dos y tres (media 2,6 y moda 3). En cuanto al instrumento evaluativo, se utilizó en 9 estaciones las simulaciones de pacientes estandarizados mediante actores, y las evaluaciones mediante imágenes clínicas, maniquíes, y preguntas abiertas de respuesta corta se utilizaron respectivamente en 2 estaciones cada una.

Los recursos humanos utilizados en cada prueba fueron: 9 actores (7 mujeres y 2 varones, según los criterios anteriormente mencionados), 11 observadores, 3 controladores y 3 encargados de la logística. Tanto los actores como los observadores fueron entrenados. En el caso de los actores se realizan 4 sesiones de entrenamiento mediante 2 responsables: uno de ellos un actor profesional, que asumió la función de coordinador de actores, y el otro un miembro del CP. Con los observadores se mantuvieron varias entrevistas formativas, para explicar y aclarar con todos ellos los factores de corrección de los distintos ítems del listado evaluativo, para conseguir una mayor fiabilidad en la cumplimentación de dichos listados.

El pilotaje previo de la prueba se realizó con 15 médicos voluntarios que reunían los mismos requisitos de la población a la que se dirigía la prueba. Se pasó un cuestionario a los observadores de las estaciones sobre la pertinencia de las situaciones clínicas, la complejidad del listado evaluativo y la valoración de cada caso, recogiendo los puntos de mejora en el diseño definitivo de la ECOE, ajustando el listado evaluativo de los casos clínicos a los resultados y sugerencias recogidas en los cuestionarios de los observadores. Basándose en estas observaciones se modificó el guión de 3 pruebas con pacientes simulados, en las que se incluyó nuevas Unidades Básicas de Información (UBIs) o preguntas reto.

3. Informe de evaluación: metodología de feed-back

Concluida la ECOE y tras el análisis de los resultados, se realizó un informe que incluía la puntuación global obtenida por cada candidato, así como los resultados por áreas competenciales. Cada participante recibió sus puntuaciones individuales, así como las puntuaciones promedio del grupo de profesionales que efectuaron la prueba el mismo día y en el mismo lugar que el candidato. En dicho documento se indicaban las áreas en las que la puntuación del candidato era inferior al 60% del ideal y por tanto susceptibles de mejora, así como aquellas áreas competenciales en las que el candidato destacaba con respecto a su grupo, con una puntuación superior al 75% del ideal. Ambos límites fueron previamente establecidos, de forma consensuada por el CP. El informe fue remitido por correo al domicilio particular del profesional, manteniéndose en todo momento la confidencialidad de los resultados.

4. Población evaluada

El número total de médicos que pasó la prueba ECOE fue de 1.158, repartidos en 14 CC.AA. La distribución de los participantes y el número de ECOEs realizadas en cada CCAA se muestran en la Tabla 2. En cada jornada la prueba se repitió como máximo 3 veces, dependiendo del número de candidatos, de modo que el número máximo de profesionales que pasaban la prueba en un mismo día era de 45 (3 ruedas de 15 estaciones). La misma prueba se realizó en 38 jornadas diferentes del año 2005, durante un período de 6 meses. Las distintas ECOEs se realizaron en centros de salud que reunían los requisitos estructurales necesarios para una prueba de las características indicadas.

Los criterios de inclusión para participar en la prueba fueron: ser médico de familia o general, con experiencia clínica en Atención Primaria durante al menos 5 años y no tener experiencia en pruebas ECOEs con anterioridad. Los participantes lo hicieron de forma voluntaria y gratuita, realizándose y difundiéndose la prueba a través de diversos medios profesionales de comunicación, revistas médicas y páginas web profesionales, e inscribiéndose a los candidatos por riguroso orden de solicitud. No debían cumplir ningún requisito específico en cuanto a ámbito de trabajo o formación previa. Todos asistieron a una reunión donde se les informó de las características de la prueba y donde se aclararon las dudas con respecto a la misma. Los criterios de exclusión para la evaluación de los resultados fueron, la falta de presentación a la prueba, o el abandono de la misma antes de cumplimentar todas las estaciones que la componían.

5. Análisis de los datos

Cada situación clínica puntuó un máximo de 100 puntos, repartidos entre los distintos componentes competenciales que se evaluaban en esa estación; siendo la puntuación global, la correspondiente a la suma de las puntuaciones de todas ellas.

Al finalizar la prueba, se pasó un cuestionario de opinión a los participantes, recogiendo su parecer sobre la metodología, el contenido, la organización y la satisfacción global con la ECOE realizada.

La logística y el análisis psicométrico fueron responsabilidad del Servicio de Estadística del Departamento de Ciencias de la Salud de la Universidad Rey Juan Carlos, con el apoyo en la interpretación de los datos de un miembro del Comité de Prueba. El estudio de los datos se hizo mediante el programa SPSS 11.5, realizándose un análisis descriptivo (media, moda y desviación estándar) de los resultados para cada participante y lo mismo para cada componente competencial y por cada estación. De igual forma se describen las opiniones de la encuesta de satisfacción sobre la prueba realizada. En el estudio comparativo se realizó un análisis de la varianza (ANOVA), mediante el test de Scheffe, para estudiar la posible significación estadística de las diferencias obtenidas en los resultados de las puntuaciones globales, por área o componente competencial y por situación clínica, entre las distintas CCAA en las que se realizó la prueba.

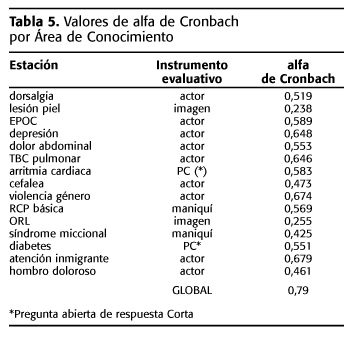

Por último, la fiabilidad global de la prueba, por componente competencial y por situación clínica o es-tación, se analizó con el estadístico alfa de Cronbach.

Resultados

1. Puntuaciones globales.

Las puntuaciones obtenidas se expresan como porcentaje de los puntos conseguidos sobre el total posible o ideal. En la Tabla 3 se muestran las puntuaciones medias y las desviaciones estándar (DE) distribuidas por CCAA. La media global fue de 59,08 (DE: 6,12), con un IC 95% de 58,52 a 59,31.

La comparación de las puntuaciones globales entre CCAA muestra varias diferencias significativas, lógicamente entre las que obtuvieron valores medios más altos y más bajos. Así, los valores obtenidos en Cataluña (63, 65±5,27) son estadísticamente significativos respecto a los valores de Castilla-León (55,37±5,78; p≤0.001, Valencia (57,20±7,18; p≤0.001) , Andalucía (57,67±6,04; p≤0.05), y Murcia (57,19±5,50; p≤0.05). También se aprecia significación estadística entre las puntuaciones de Castilla-León (55,37±5,78) con las puntuaciones de las comunidades de Castilla la Mancha (59,33±7,20; p≤0.05), Galicia (61,77±6,60; p≤0.05), y Aragón (60,93±6,02; p≤0.05).

2. Puntuaciones por componentes competenciales

El análisis de las puntuaciones por componentes competenciales muestra el mejor resultado en el área de comunicación (80,11% de la puntuación ideal), seguida del área de habilidades técnicas (70.07%) y la de anamnesis (59.37%); los valores más bajos se obtuvieron en el área de atención familiar (45.54%) que fue la única que no supera el 50%, y en la de manejo (51.38%) (Tabla 3).

El análisis comparativo de los resultados de cada uno de los siete componentes competencial entre las CCAA, muestra que el mayor número de diferencias estadísticamente significativas se obtuvo en las áreas de atención familiar (28) y comunicación (26), mientras que los componentes competenciales con menos diferencias significativas entre Comunidades fueron: exploración (4), manejo (5) y preventivas (5), (Tabla 3).

3. Puntuaciones por situaciones clínicas, áreas de conocimiento o estaciones

Las puntuaciones medias de cada CCAA por área de conocimiento o estación aparecen reflejadas en la tabla 4. Las puntuaciones más bajas se obtuvieron en las estaciones de diabetes (43,36±15,97), EPOC (45,31±11,84) y síndrome miccional (45,92±14,41); y las más elevadas en las de dolor abdominal (75,94 ±14,70), resucitación cardiopulmonar (70,07±23,80) y lesión de piel (66,38±21,10).

El análisis comparativo entre las puntuaciones de las CCAA (Tabla 4) muestra mayor número de diferencias estadísticamente significativas en las estaciones de violencia de género (46), dolor abdominal (44) y atención al inmigrante (41), y menos diferencias en las de lesión de piel (0), patología otorrinolaringológica (2) y síndrome miccional (5).

4. Resultados del análisis de fiabilidad

El coeficiente de fiabilidad global de la prueba, el alfa de Cronbach fue de 0,79. El análisis de fiabilidad por componente competencial muestra que los mejores resultados se obtuvieron en comunicación (0,835), manejo (0,622), anamnesis (0,619) y habilidades técnicas (0,569); mientras que los resultados mas bajos fueron: actividades preventivas (0,286), exploración (0,455) y atención familiar (0,461). El mismo análisis, por estación o situación clínica muestra que los mejores resultados de fiabilidad se obtienen en las áreas de atención al inmigrante (0,679), violencia de género (0,674), depresión (0,648) y TBC pulmonar (0,646), en las que se utilizó actores como instrumento evaluativo. Los valores más bajos de fiabilidad corresponden a lesión cutánea (0,238) y patología ORL (0,255), ambas evaluadas con imágenes clínicas (ver Tabla 5).

5. Resultados de la encuesta

Por último, los resultados de la encuesta de opinión de los participantes sobre la prueba, muestran una puntuación en la satisfacción global de 8,18±0,3, obteniéndose las mejores valoraciones en los contenidos (8,53±0.3) y en el impacto de la prueba (8,18±0.4) (Figura 1). Las opiniones expresadas con mayor frecuencia en la pregunta abierta de la encuesta de opinión fueron: "Me ha sido muy útil. Es muy importante realizar esta prueba" (14,75%), "Mucho estrés al sentirse observado" (16,39%), "Prefiero a los actores que a los maniquíes y el otro tipo de pruebas" (13,11%), y "Mejorar la calidad de las imágenes en pruebas complementarias" (11,48%).

Discusión

En cuanto al diseño de la prueba ECOE, debemos tener presente que la bibliografía existente hasta la fecha coincide en señalar que el número de estaciones o situaciones clínicas difiere en función de las características de la prueba, formativa o sumativa17, 18. Además, según sean los contenidos también variará la prueba en el número de estaciones, número de casos clínicos, y su duración. Una ECOE sumativa de medicina interna o medicina de familia debe estar entorno a un mínimo de 20 o 22 estaciones, con una duración de unas 4 horas, para que ésta tenga la fiabilidad suficiente. Dado que el objetivo inicial del presente estudio no era realizar una evaluación sumativa estricta, ni tan siquiera formativa, sino la de establecer un análisis descriptivo prospectivo de la competencia de los médicos de familia y ver si había diferencias entre CCAA, con el fin de disponer de un mapa competencial básico de los médicos de familia españoles, el Comité de Prueba consideró factible una ECOE de 15 estaciones, con una duración total de la prueba de 2 horas.

Es necesario poner de relieve las características de la muestra estudiada, ya que se presenta una población que supera ampliamente el millar de médicos de familia, con experiencia laboral de al menos 5 años en ejercicio. Estos profesionales se presentaron a la prueba de forma voluntaria para conocer las áreas de su mapa competencial como médicos de familia más deficitarias, y, aunque este hecho pudiera haber supuesto un sesgo de selección, al haberse producido de forma similar en todas las Comunidades Autónomas, no resulta un obstáculo a la hora de comparar los resultados.

Diferentes estudios en los que se evalúa la competencia clínica se han realizado en poblaciones de médicos residentes en formación20, 21, o de estudiantes de medicina22, 23, y si bien es cierto que también se dispone de datos publicados en poblaciones de médicos en ejercicio10,17, son poblaciones menores y normalmente referidos a una CCAA concreta. La mayor experiencia en la evaluación de la competencia clínica de profesionales en ejercicio en España corresponde al Institut dEstudis de la Salut (IES), que trabaja en la metodología ECOE en España desde hace más de 20 años, y que, por tanto, dispone de la mejor casuística en nuestro país5. En cualquier caso, el tamaño de la muestra del presente trabajo es muy superior a la de otras publicaciones, tratándose del primer estudio que realiza un análisis comparativo del área competencial entre diferentes CCAA.

El resultado de las puntuaciones globales de la prueba (59,08%), concuerda con otros estudios realizados en poblaciones más reducidas de nuestro país10, 17, 20, y aunque en principio pueda parecer una puntuación alta, puede explicarse por el hecho de que en la selección de las situaciones clínicas por el Comité de Prueba, uno de los criterios puntuados era la mayor prevalencia de dichas situaciones en la consulta de Atención Primaria, de forma que no salieron seleccionadas situaciones excepcionales o complejas en su manejo por el médico de familia, motivo que puede también explicar que la dispersión de los datos no sea muy elevada.

El hecho de que se observen diferencias significativas entre las puntuaciones de Cataluña y cuatro CC.AA., tanto en la puntuación global, como por áreas competenciales y por áreas de conocimiento o estaciones, puede explicarse por ser esta comunidad pionera en la realización de pruebas ECOE, tanto a médicos residentes como a médicos de familia en ejercicio, o incluso en otras especialidades como medicina interna. Este resultado, cuando menos, justifica que los candidatos de esta CCAA tengan un mayor conocimiento de este tipo de instrumento evaluativo. Es de destacar que el intervalo de confianza obtenido para las puntuaciones globales es muy estrecho (IC 95: 58,52 a 59,31), lo que refleja una precisión importante de los resultados.

Como se ha comentado anteriormente, el objetivo principal del estudio es establecer un mapa competencial de los médicos de familia españoles; lo que motivó escoger una herramienta, como es la ECOE, diseñada para medir competencia profesional de forma global. Esto justifica que, si bien existen diferencias significativas entre las puntuaciones medias por área competencial entre las distintas CCAA, éstas son mucho menores que cuando se realiza la comparación por área de conocimiento o situación clínica.

Respecto a los resultados por áreas competenciales, la que presenta mejor puntuación, coincidiendo con otros estudios similares, es el área de comunicación10, 17, seguida de la de habilidades técnicas. Las áreas con resultados más bajos corresponden a atención familiar y actividades preventivas, coincidiendo igualmente con otros trabajos publicados10. El hecho de que la comunicación sea el área con mejor puntuación puede justificarse por los siguientes motivos: o bien la comunicación es una de las áreas competenciales donde el profesional cuida especialmente su habilidad dentro de su práctica profesional; o bien los participantes ponen una atención especial en las mismas, especialmente en las estaciones con pacientes estandarizados, donde conocen que van a ser evaluados en este área ("efecto de Hawthorne")24. También debe tenerse en cuenta el posible sesgo del actor, responsable de la evaluación de esta área, al empatizar con el evaluado (sesgo actor-observador)25. Además, al ser una de las competencias que se mide en mayor número de estaciones, a pesar de ser la evaluación más subjetiva, es la más fiable per sé. Por el mismo motivo, pero en sentido inverso, este último hecho puede justificar el que, entre los resultados más bajos, se encuentren los de atención a la familia y actividades preventivas, que son precisamente los componentes que se miden en menor número de estaciones, con escaso poder, por tanto en la tabla de especificaciones. En cualquier caso, la dispersión de las puntuaciones medias es de las más bajas, lo cual podría apoyar la hipótesis de que realmente son estas áreas competenciales en las que los profesionales deben prestar mayor énfasis en su formación, aunque la explicación podría estar también en la selección de las situaciones clínicas que miden dichos componentes competenciales.

Por otra parte, los buenos resultados en habilidades técnicas pueden deberse a un sesgo de selección en las situaciones clínicas que se seleccionaron para medirlas, ya que alguna de ellas, como es el caso de la Resucitación Cardiopulmonar ha sido seleccionada en otras experiencias que incluían la ECOE como instrumento evaluativo para médicos de familia.

La fiabilidad hace referencia al hecho de que un procedimiento de recogida de datos nos lleve siempre a la obtención de la misma información, dentro de una determinada situación, independientemente de quien recoja los datos o del momento de su recogida. Entre los instrumentos de medida de la fiabilidad o consistencia interna de la prueba ECOE, el más utilizado es el alfa de Cronbach26. La fiabilidad global de la prueba en el presente trabajo es de 0,79, lo que ha de considerarse como un valor satisfactorio al compararlo con estudios similares existentes10, 17. Además, teniendo en cuenta el número de casos y la heterogeneidad de la muestra, no cabe la posibilidad de que se trate de un valor artefactual o falsamente elevado27, 28.

Somos conscientes de la limitación que pudiera suponer el hecho de que la prueba no se realizara de forma simultánea en todas las Comunidades Autónomas (justificado por la complejidad organizativa y la necesidad elevada de recursos que conllevaría), no obstante, cabe señalar que se llegaron a realizar pruebas simultáneas hasta en 5 CCAA, acortando el estudio en el tiempo todo lo posible. Además, añadir que los resultados que podrían sugerir un posible efecto copia, como los mejores resultados de algunas Comunidades, no se explica por el orden en el que se les realizó la prueba; así por ejemplo Cataluña fue una de las Comunidades en las que primero se realizó la prueba, obteniendo mejores resultados en las puntuaciones globales. Además, en esta Comunidad se realizaron en 4 jornadas distintas, separadas en el tiempo incluso por semanas, no encontrándose diferencias significativas en las calificaciones de los profesionales presentados en distintas fechas en la misma CCAA, e incluso siendo la tendencia a obtener mejores calificaciones en las pruebas de los primeros días de cada Comunidad que en las sucesivas.

El valor de alfa ha sido menor en el caso de actividades preventivas, atención familiar y exploración, áreas en las que, como se ha comentado anteriormente, los resultados de las puntuaciones alcanzadas por los participantes han sido también menores. Hay que tener en cuenta la escasa dispersión de los resultados en dichas áreas (DE de 0,68; 0,63 y 1,24 respectivamente), lo que, junto al hecho de que el componente de actividades preventivas ha sido evaluado en 5 estaciones, hace pensar que los resultados muestran un área en la que los profesionales realmente deberían mejorar. Respecto a los resultados de fiabilidad de alfa por estaciones hay que considerar el hecho de la baja puntuación en las situaciones clínicas tanto de lesión de piel como en las alteraciones en ORL siendo, además, estaciones con una DE superior a la media (21,1 y 19,7; DE media: 13,83). No hay que pasar por alto el que estas dos estaciones se realizaron con imágenes clínicas como instrumento evaluativo, y que los participantes manifestaron en su encuesta de opinión que debía mejorarse la calidad de las imágenes presentadas en la prueba. No obstante para llegar a estas conclusiones con mayor seguridad se debería realizar un estudio de fiabilidad más profundo, mediante un análisis de variables múltiples, que no se ha realizado debido al hecho de que el objetivo fundamental de nuestro estudio no era éste, sino el de realizar un estudio comparativo de la competencia profesional en los médicos de familia españoles.

Respecto a la validez de la prueba, la validación de este tipo de estructuras evaluativas, es un proceso complejo en el que hay que comprobar la validez de apariencia (realismo de la prueba o validez facial), de contenidos (selección pertinente de las situaciones clínicas incluidas) y de constructo (grado en que la prueba se comporta del modo previsto y razonable, es decir, mide aquello para lo que se diseñó)10. El resultado de las encuestas a los participantes, en la fase de pilotaje de la prueba a los observadores, además de la propia metodología en el diseño de la ECOE, dan soporte a los diferentes tipos de validez.

La alta satisfacción con la prueba, manifestada por los participantes en la encuesta de opinión que cumplimentaron tras la finalización de la misma, tanto a las preguntas sobre organización y logística, como a las de contenidos y valoración global, indican la aceptabilidad de los profesionales del instrumento evaluativo empleado, si bien la factibilidad del proyecto como herramienta de detección de necesidades reales de formación de los médicos, viene determinada por otros factores, como el coste económico, tanto en material tangible (coste real) como intangible (recursos humanos, tiempo, complejidad organizativa), que supone la mayor dificultad a la hora de continuar con estudios complementarios a este en el marco del DPC.

Es preciso señalar que, aunque no fuera el objetivo principal de nuestro proyecto el realizar una ECOE con carácter formativo, al concluir el diseño del proyecto con un informe individualizado de los resultados para cada médico evaluado en el que se le señalaba los déficits formativos y las áreas de mejora, indirectamente ha proporcionado una información de gran valor tanto para el propio profesional, como para las sociedades científicas, entorno a la planificación y metodología de la formación y del valor y la importancia del DPC.

El presente trabajo muestra pues un análisis descriptivo sobre el mapa competencial de los médicos de familia españoles y las diferencias entre las distintas CCAA, evidenciando que la formación del médico general/de familia en España es buena, si bien presenta áreas de mejora; hecho en el que las asociaciones profesionales deben implicarse de manera directa y dirigir la formación de los profesionales a sus necesidades individuales. Por último, y más importante, aporta una visión integral del desarrollo profesional continuo (DPC) del individuo, lo cual facilita la tutorización y guía del profesional dentro de trayectorias formativas específicas e individuales, cuyo objetivo es conseguir la excelencia profesional y el mantenimiento de la misma.

Bibliografía

1. Continuing Professional Development Quality in the new NHS. NHS, julio 1999. Disponible en http://www.dh.gov.uk/assetRoot/04/01/20/12/04012012.pdf. [ Links ]

2. Desarrollo Profesional en Ciencias de la Salud. World Federation for Medica Education. Educación Médica 2004; 7 (2): 39-52. [ Links ]

3. Xunta de Galicia. Las necesidades de formación del personal sanitario de la red asistencial del SERGAS. Santiago: Xunta de Galicia; 2002. [ Links ]

4. Hélio Teixeira MD. Competencia en Medicina. Rev Electron Biomed / Electron J Biomed 2005;2:13-22. [ Links ]

5. Brailovsky CA, GrandMaison P. "Using evidence to improve evaluation: A comprehensive psychometric assessment of a SP-based OSCE licensing examination". Advances in Health Sciences Education. 2000;5:207-219. [ Links ]

6. Epstein RM, Hundert EM. Defining and assessing professional competence. JAMA 2002;287:226-35. [ Links ]

7. Martín Zurro A. Diversificación metodológica de la evaluación de la competencia del médico de familia. Jano 2002;1430(62): 16 – 17. [ Links ]

8. Harden R, Glesson F. Assessment of clinical competence using an objective structured clinical examination (OSCE). Medical Education (1979) 13:41-54. [ Links ]

9. Ruiz i Gil E, Florensa i Claramunt E, Cots i Yago JM, Sellares Salas J, Iruela López A, Blay Pueyo C, et al. Primeras experiencias en evaluación de la competencia clínica de los médicos de familia de Cataluña. Atención Primaria 2001;28:105-109. [ Links ]

10. Cervera Alemani AM, Salvá CCasanovas A, Altimir Losada S, Miralle Basseda R, Yuste Marco A, Baly Pueyo C et al. Evaluación clínica objetiva y estructurada en geriatría. Resultados del primer proyecto realizado en España. Rev Esp Geriatr Gerontol 2002; 37 (6):298-303. [ Links ]

11. Miller, G. The assessment of clinical skills/competence/performance. Academic Medicine (1990) 65:S63-S67 [ Links ]

12. De Serdio E. ECOE: Evaluación Clínica Objetiva Estructura-da (I) Competencias y Evaluación. Medicina de Familia 2002; 2: 127-132. [ Links ]

13. Grupo de Evaluación de la Competencia. Prueba ECOE. Página web oficial de SEMERGEN. Disponible en http://www.semergen.es/semergen2/cda/nav/03/30100.jsp. Actualizada el 27 de febrero de 2006. Consulta realizada el 27 de febrero de 2006. [ Links ]

14. Programa Formativo de la Especialidad de Medicina Familiar y Comunitaria. Comisión Nacional de la Especialidad en MFyC, Ministerio de Sanidad y Consumo, Ministerio de Educación y Ciencia. Enero 2005. Disponible en http://www.msc.es/profesionales/formacion/docs/medifamiliar.pdf. [ Links ]

15. Sellarés J, Bosch C, Florensa E, De Serdio E, Gorroñogoitia A, Medina E, et al. Evaluación de la competencia: reto y necesidad. Barcelona: semFYC, 2002. [ Links ]

16. De Serdio E. ECOE: Evaluación Clínica Objetiva Estructurada (II). Diseño. Medicina de Familia 2002;1: 49-52. [ Links ]

17. Pedregal M, Molina E, Prados JA, Quesada F, Bonal P, Iglesias C. Evaluación de la competencia clínica de tutores de residentes de medicina familiar y comunitaria. Atención Primaria 2004; 34 (2): 68-74. [ Links ]

18. Norcini JJ, Blank LL, Duffy FD et al. The mini-Cex: a method for assessing clinical skills. Ann Intern Med 2003;138:476-81. [ Links ]

19. Hays RB; Fabb WE, van der Vleuten CP. Validity of final examinations in undergraduate medical training. BMJ 2000; 321:1217-1219. [ Links ]

20. Toledo JA, Fernández MA, Trejo JA, Grijalva MG, Gómez FJ, Ponce ER. Evaluación de la competencia clínica en el postgrado de medicina familiar mediante el Examen Clínico Objetivo Estructurado. Atención Primaria 2002;30 (7): 435-441. [ Links ]

21. Auewarakul C, Downing SM, Praditsuwan R, Jaturatamron U. Item analysis to improve reliability for an internal medicine undergraduate OSCE. Adv Health Sci Educ Theory Pract 2005;10 (2): 105-113. [ Links ]

22. Jacobs JCG, Denessen E, Postma CT. The structure of medical competente and results o fan OSCE. The Journal of Medicine, 2004; 62 (10): 397-403. [ Links ]

23. McLaughlin K, Gregor L, Jones A, Coderre S. Can standardized patients replace physicians as OSCE examiners?. BMC Medical Education 2006; 6:12-17 [ Links ]

24. Laporte JR. La observación clínica y el razonamiento causal. En: Principios básicos de investigación clínica. (on line). Disponible en www.icf.uab.es/llibre/llibre.htm. Actualizado en febrero 2006.Consulta realizade el 8 de febrero de 2006. [ Links ]

25. Melia JL; Chisvert M, Pardo E. Un modelo de las atribuciones y actitudes ante los accidentes de trabajo: Estrategias de medición e intervención. Rev Psicol. Traby Org 2001; 17 (1): 63-90. marzo de 2006. [ Links ]

26. Chesser AM, Laing MR, Miedzybrodzka ZH, Brittenden J, Heys SD. Factor analysis can be a useful standard setting tool in a high stakes OSCE assessment. Med Educ 2004;38(8):825-831. [ Links ]

27. Barman A. Critiques on the Objective Structured Clinical Examination. Annals Academy of Medicine 2005; 34 (8):478-482 [ Links ]

28. Blay C. Los límites de la evaluación clínica objetiva y estructurada (ECOE). Atención Primaria 2004;34 (2): 68-74. [ Links ]

![]() Dirección para correspondencia:

Dirección para correspondencia:

1 Centro de Salud los Fresnos, Área 3 del Servicio Madrileño de Salud. Madrid

C/ Narváez nº 15. 1º dcha. 28009 Madrid.

Mail: dulce.ramirez@salud.madrid.org

Mail: dramirezp@semergen.es

Tfno. 91.500.21.71/606.54.86.89

2 Centro de Salud Montesa. Área 2 del Servicio Madrileño de Salud. Madrid

C/Montesa 38 28006 MAdrid

3 Centro de Salud La Plata, Área 3 del Servicio Madrileño de Salud. Madrid

4 ABS Cardedeu-Llinars. CAP Linars del Valles

C/ Frederic Mares S/N

5 Facultat de Medicina, UB - IDIBAPS