Mi SciELO

Servicios Personalizados

Revista

Articulo

Indicadores

-

Citado por SciELO

Citado por SciELO -

Accesos

Accesos

Links relacionados

-

Citado por Google

Citado por Google -

Similares en

SciELO

Similares en

SciELO -

Similares en Google

Similares en Google

Compartir

Anales de Psicología

versión On-line ISSN 1695-2294versión impresa ISSN 0212-9728

Anal. Psicol. vol.37 no.2 Murcia may./sep. 2021 Epub 21-Jun-2021

https://dx.doi.org/10.6018/analesps.37.2.345151

Psicología Evolutiva y de la Educación

Diseño y validación de un cuestionario (CAA) sobre la facilitación del desarrollo de la competencia aprender a aprender en el profesorado Universitario

1 Mondragon Unibertsitatea (España).

2 Universidad del País Vasco UPV/EHU (España).

En el marco del Espacio Europeo de Educación Superior, el profesorado ha de contar con capacidades profesionales para impulsar en el alumnado la competencia aprender a aprender, que hace referencia a la capacidad de autorregulación del propio proceso de aprendizaje. El objetivo del presente trabajo consistió en diseñar y validar un cuestionario para medir los contextos facilitadores de aprendizaje que el profesorado universitario activa para el desarrollo de la competencia aprender a aprender, el CAA. En primer lugar, partiendo de la revisión teórica y empírica, se definieron 86 ítems. A continuación, se examinaron la validez de contenido (n = 20 expertos), la validez basada en los procesos de respuesta (n = 10 docentes), la validez basada en la estructura interna (n = 415 docentes) y la validez concurrente. Los resultados mostraron una adecuada calidad psicométrica, fiabilidad de las puntuaciones y bondad de ajuste. La versión final del CAA comprendió 4 dimensiones y 39 ítems. Este instrumento puede ser una herramienta de rápida aplicación, válida y fiable, para conocer el desarrollo de los contextos facilitadores de aprendizaje de la competencia aprender a aprender. Asimismo, puede servir para detectar necesidades de formación profesional en el desarrollo de dicha competencia.

Palabras clave: Aprender a aprender; competencia profesional; evaluación educativa; educación superior; competencia; instrumentos evaluación

Introducción

En el marco del Espacio Europeo de Educación Superior (EEES), es clave el desarrollo de competencias en los estudiantes que les permitan construir conscientemente conocimiento, aprender en diferentes contextos y modalidades a lo largo de la vida, afrontar futuros desafíos de aprendizaje y adaptar el conocimiento a situaciones cambiantes (Cano, 2008). La adquisición de competencias por parte de los estudiantes es el principal objetivo de la educación y los contenidos son recursos indispensables para el desarrollo de las mismas (Bolívar, 2008).

En el proyecto Definición y Selección de Competencias Clave, promovido por la Organización para la Cooperación y el Desarrollo Económicos (OCDE), se define la competencia como “la capacidad de responder a demandas complejas y llevar a cabo tareas diversas de forma adecuada …, supone una combinación de habilidades prácticas, conocimientos, motivación, valores éticos, actitudes, emociones, y otros componentes sociales y de comportamiento que se movilizan conjuntamente para lograr una acción eficaz” (Ministerio de Educación, Cultura y Deporte del Gobierno de España, MECD, 2013, pp. 17-18).

En la ordenación de las enseñanzas universitarias oficiales (Real Decreto 1393/2007), se establece que los estudiantes deben adquirir competencias generales y específicas. A través de las competencias transversales se obtiene la capacidad de seguir aprendiendo y actualizarse a lo largo de la vida, de desarrollar la capacidad para comunicarse y trabajar en equipos multidisciplinares y multiculturales y de hacer el mejor uso de todos los recursos disponibles (Agenda Nacional de Evaluación de la Calidad y Acreditación, 2014). Concretamente, la competencia transversal de aprender a aprender es una competencia básica de gran influencia en todas las demás, principalmente porque es clave para el aprendizaje permanente que tiene lugar en distintos contextos vitales de desarrollo humano (Black, McCormick, James, & Pedder, 2006). Esta competencia incluye una serie de destrezas que requieren autonomía personal, pensamiento crítico y capacidad reflexiva sobre el propio proceso de aprendizaje (Black et al., 2006). Aprender a aprender implica desarrollar conocimientos sobre los procesos mentales involucrados en el proceso de construcción del conocimiento y aplicar los nuevos conocimientos y capacidades en otros contextos (MECD, 2018). Además, para la adquisición de esta competencia es necesario desarrollar actitudes y valores tales como la motivación y la confianza. Esto permite al estudiante planificar objetivos realistas, alcanzar metas y retroalimentar de ese modo su confianza y capacidad personal para la consecución de tareas y plantearse objetivos de aprendizaje más complejos (MECD, 2018).

En el actual sistema educativo español, la responsabilidad principal de proporcionar una formación integral en competencias recae sobre el profesorado, lo que ha supuesto a este colectivo afrontar exigentes retos formativos y asumir un nuevo enfoque docente centrado en el alumnado (Zabalza, 2009). En lo que respecta al desarrollo de la competencia aprender a aprender en el marco universitario, se ha señalado la importancia de llevarlo a cabo a través de contextos facilitadores de enseñanza-aprendizaje (Fazey & Fazey, 2001; Wingate, 2007). A este respecto, son diversas las variables que se han relacionado con el desarrollo de dicha competencia (Coll, Mauri, & Rochera, 2012; Muñoz-San Roque, Martín-Alonso, Prieto-Navarro, & Urosa-Sanz, 2016; Villardón, Yániz, Achurra, Iraurgi, & Aguilar, 2013). Por una parte, cabe destacar los enfoques de enseñanza-aprendizaje de los profesores universitarios (Monroy, González-Geraldo, & Hernández-Pina, 2015; Trigwell & Prosser, 2004). Se diferencian dos tipos de enfoques docentes; a saber, un enfoque caracterizado por una estrategia centrada en el profesor, en la que se entiende la enseñanza como transmisión o comunicación, y otro enfoque polar que aplica una estrategia centrada en el estudiante. En el primero, se parte de un planteamiento tradicional del aprendizaje como adquisición de conocimiento, en el cual se enfatiza la cantidad del aprendizaje. Por el contrario, en el segundo enfoque, la enseñanza se entiende como un proceso de creación de oportunidades de aprendizaje en el que el profesor trata de incidir en la forma en la que los estudiantes consideran su aprendizaje y en la construcción del conocimiento. Para que la labor docente facilite la competencia aprender a aprender y un aprendizaje de mayor profundidad, el enfoque de aprendizaje del profesor debe estar centrado en el alumno (Trigwell & Prosser, 2004).

Por otra parte, diversos autores han relacionado la metacognición con un mayor desarrollo de la competencia aprender a aprender (Fazey & Fazey, 2001; Veenman, Van Hout-Wolters, & Afflerbach, 2006). La metacognición hace referencia a la capacidad para reflexionar y comprender en profundidad los procesos de aprendizaje (Veenman et al., 2006). Ello posibilita que los estudiantes amplíen el conocimiento de sí mismos como personas en formación, impulsa el aprendizaje autónomo y esto, a su vez, influye en la autorregulación del aprendizaje (Van der Stel & Veeman, 2010). Este proceso exige al alumno definir objetivos, planificar procesos para la consecución de los mismos, regular el desarrollo del aprendizaje y desarrollar la capacidad para evaluar su propio proceso (Villardón et al., 2013).

La competencia aprender a aprender en el ámbito universitario consiste en un complejo proceso de desarrollo personal que para el estudiante supone realizar cambios en sus percepciones, en sus hábitos de aprendizaje y en sus creencias epistemológicas (Wingate, 2007). Por lo tanto, para que el desarrollo de dicha competencia tenga éxito, es necesario que los estudiantes reciban apoyo personalizado (Zabalza, 2009). Nos referimos a un entorno educativo positivo, basado en el respeto y la confianza mutua, donde la persona se siente escuchada, aceptada y empoderada. Para ello es preciso que las relaciones entre el profesor y los estudiantes sean positivas y cercanas, caracterizadas por una comunicación bidireccional fluida, en la que los significados son compartidos (Coll et al., 2012). Asimismo, es necesario que los alumnos y alumnas perciban que son personas activas y responsables, capaces de dirigir su aprendizaje (Putwain, Sander, & Larkin 2013). Aspectos todos ellos que fortalecen su autoconcepto académico (Coll et al., 2012).

Además, el desarrollo de la competencia aprender a aprender se ha de llevar a cabo en diferentes contextos y a través de una metodología diversa (Wingate, 2007). Partiendo del principio de que la metodología ha de estar cimentada sobre el aprendizaje significativo, también ha de ser funcional, motivante y dirigida a la acción, capaz de combinar la esfera individual con la social (Novak, 2002). Cabe señalar que en algunas investigaciones se ha hallado que el uso de diversas metodologías facilita el aprendizaje y posibilita responder a la heterogeneidad de las demandas del alumnado (Wingate, 2007; Zabalza, 2009). La metodología para el desarrollo de la competencia aprender a aprender implica proponer situaciones de aprendizaje propias de la profesión, reales o simuladas, y un sistema de evaluación que no se encuentre separado de la formación (Monereo & Lemus, 2010). Asimismo, se ha de considerar al estudiante como un sujeto activo en ese proceso y se ha de potenciar la reflexión crítica sobre la práctica, una conducta necesaria para poder incorporar mejoras en el proceso de aprendizaje, siendo éste el objetivo principal de la evaluación (Margalef, 2014).

Por otra parte, una enseñanza eficaz de la competencia aprender a aprender, también exige un compromiso docente (Wingate, 2007). Es decir, apreciar el gusto por la profesión, disfrutar de ella, mostrar una implicación afectiva e intelectual hacia el trabajo docente, interiorizar una cultura emprendedora y expresar una actitud positiva hacia los cambios (Zabalza, 2009). La calidad de la educación superior pasa por disponer de un profesorado con una formación excelsa en el desarrollo de competencias. A su vez, ello requiere elaborar instrumentos de medida que evalúen la condición de su implementación. En lo que se refiere a la competencia aprender a aprender, aunque se disponen de instrumentos de medida válidos para evaluar algunas de las variables citadas anteriormente (p. ej., el Cuestionario Approaches to Teaching Inventory, S-ATI-20, Monroy et al., 2015; la Escala de Autopercepción del Nivel de Desarrollo de la Competencia de Aprender a Aprender, EADCAA, Muñoz San-Roque et al., 2016), la mayoría se centran en la perspectiva del alumnado (p. ej., la Escala de Competencia de Aprendizaje, LCS, Villardón et al., 2013). Así pues, actualmente no se dispone de instrumentos en lengua castellana que permitan medir de forma concreta, válida y fiable el desarrollo de esta competencia entre el profesorado universitario. Por ello, el objetivo del presente trabajo consistió en diseñar y validar un cuestionario para medir los contextos facilitadores de aprendizaje que el profesorado universitario activa para el desarrollo de la competencia aprender a aprender.

Método

Participantes

El instrumento se administró a 415 profesores (204 mujeres y 211 hombres) (M de edad = 45.03, DT = 10.58) de educación superior de diversas universidades de España. La selección de la muestra fue incidental, pero se trató de que fuera equilibrada en cuanto al género, grupo de edad, titularidad de la universidad de pertenencia, título en el que se imparte la docencia y experiencia docente de los participantes. Asimismo, se procuró que estuvieran representadas todas las áreas de conocimiento (véase la Tabla 1). La participación fue voluntaria y todos los participantes dieron su consentimiento informado antes de la inclusión en el estudio. Se excluyeron del estudio los profesores que en ese momento no impartían docencia en educación superior (n = 15).

Instrumentos

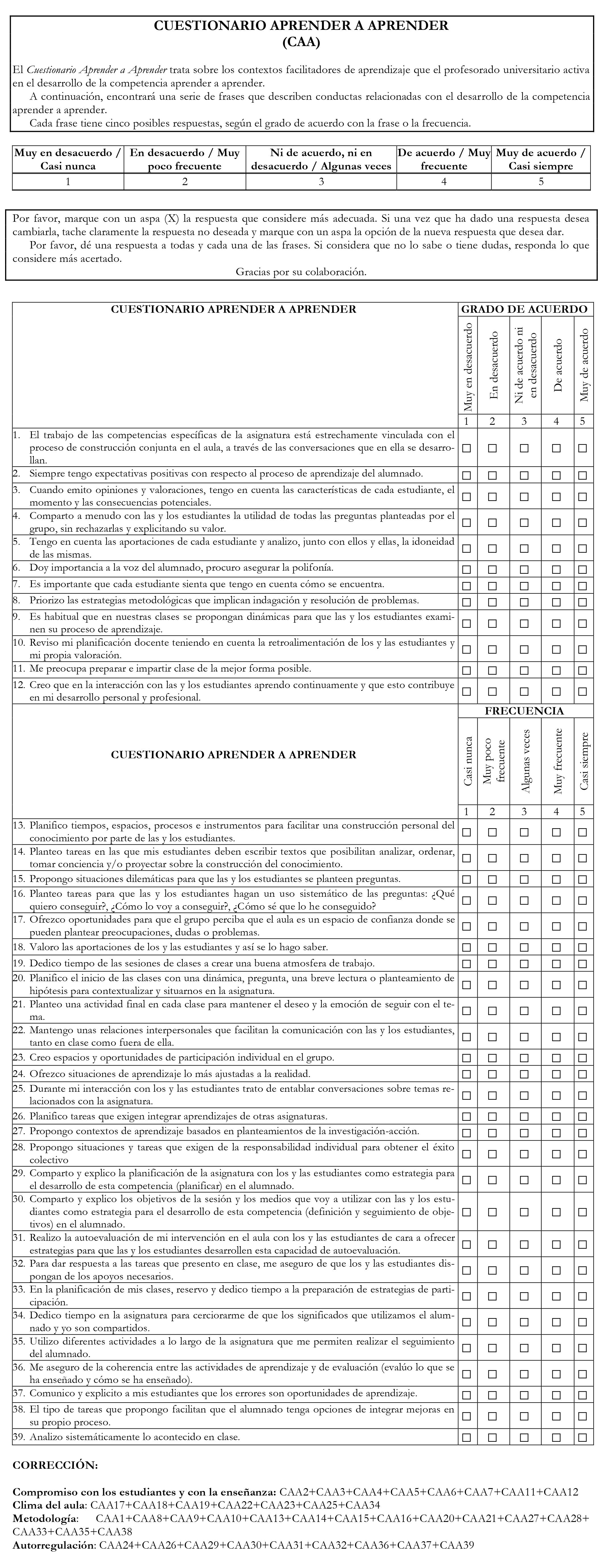

Cuestionario Aprender a Aprender (CAA). El CAA es un cuestionario que mide los contextos facilitadores de enseñanza-aprendizaje para el desarrollo de la competencia aprender a aprender en el profesorado universitario. Consta de 39 ítems que el participante debe responder en una escala tipo Likert con 5 opciones de respuesta que van desde “Muy en desacuerdo/casi nunca” hasta “Muy de acuerdo/casi siempre”. Se necesitan aproximadamente 20-25 minutos para cumplimentarlo. El CAA incluye 4 factores. El factor Compromiso con los estudiantes y con la enseñanza (8 ítems) se centra en la implicación del profesor para incidir en el desarrollo profesional y personal del estudiante. Asimismo, se refiere al compromiso con la profesión y la calidad de la enseñanza a través del análisis de la propia práctica y la mejora continua (p. ej., “Creo que en la interacción con las y los estudiantes aprendo continuamente y que esto contribuye en mi desarrollo personal y profesional”). El factor Clima del aula (7 ítems) alude a los entornos de enseñanza-aprendizaje basados en la aceptación, el compromiso y el respeto mutuo, para lo que es clave el establecimiento de relaciones positivas y cercanas tanto entre los profesores y el alumnado como entre los propios estudiantes (p. ej.,” Valoro las aportaciones de los y las alumnas y así se lo hago saber”). El factor Metodología (15 ítems) hace referencia a las metodologías activas de enseñanza-aprendizaje centradas en el alumnado. Son metodologías que comprenden un planteamiento investigativo y exploran situaciones complejas conectadas con la realidad sociocultural del alumnado. La enseñanza se entiende como un proceso de creación de oportunidades de aprendizaje en el que el profesor trata de incidir en la forma en la que los estudiantes consideran su aprendizaje y en la construcción del conocimiento (p. ej., “Priorizo las estrategias metodológicas que implican indagación y resolución de problemas”). Por último, el factor Autorregulación (9 ítems) describe el tipo de apoyo que presta el profesor para que el alumno realice una adecuada transición de la regulación externa del proceso de aprendizaje a la interna. Para ello favorece la metacognición e impulsa el aprendizaje autónomo lo que a su vez influye en la autorregulación del aprendizaje (p. ej., “Realizo la autoevaluación de mi intervención en el aula con los estudiantes de cara a ofrecer estrategias para que los estudiantes desarrollen esta capacidad de autoevaluación”).

Versión española del cuestionario Approaches to Teaching Inventory (S-ATI-20, Monroy et al., 2015; versión original de Trigwell y Prosser, 2004). El S-ATI-20 mide los enfoques de enseñanza de los profesores universitarios. Consta de 20 ítems agrupados en dos escalas de 10 ítems. Cada una representa los extremos de un continuo de los enfoques de enseñanza: Transmisión de Información/Estrategia centrada en el Profesor (TICP) (p. ej., “Es recomendable que los estudiantes centren su estudio en aquello que yo les proporcione”) y Cambio Conceptual/Estrategia centrada en el Estudiante (CCCE) (p. ej., “En las sesiones de clase de esta asignatura deliberadamente provoco debate y discusión”). El TICP hace referencia a un tipo de enfoque que aborda la enseñanza centrándose en el profesor en términos de cómo estructura, presenta, gestiona y transmite la materia, independientemente de lo que hagan los estudiantes. Para el presente estudio se utilizó el factor CCCE que se caracteriza por ser un enfoque docente centrado en el estudiante. En nuestra muestra, el índice de consistencia interna evaluado mediante el coeficiente alfa de Cronbach fue de .91.

Procedimiento

En primer lugar, se realizó una conceptualización y operacionalización del constructo objeto de estudio. Del mismo modo, se procedió a definir a quién evaluar y el uso que se les daría a las puntuaciones obtenidas, y se argumentó la justificación y viabilidad de la creación del instrumento (Abad, Olea, Ponsoda, & García, 2011). Este proceso dio lugar a la confección de los ítems y propuesta de las dimensiones a las que teóricamente cabría asignar dichos ítems. La primera versión del cuestionario se compuso de 86 ítems.

Para determinar en qué medida el contenido del cuestionario era congruente y apropiado para los objetivos específicos del mismo, se llevó a cabo una evaluación por un grupo de expertos. Concretamente participaron 18 jueces expertos de diversas universidades de España (6 hombres y 12 mujeres) y 2 jueces expertos de una universidad de Chile (1 hombre y 1 mujer). Para la identificación de las personas que formaron parte del juicio de expertos se siguieron los siguientes criterios: experiencia en relación al constructo tratado; reputación en la comunidad científica; disponibilidad y motivación para participar; e imparcialidad.

El proceso se realizó en dos fases. En un primer momento, se seleccionaron 5 expertos que formaron parte de un grupo de trabajo. Después de especificar a los participantes tanto el objetivo de la prueba como las dimensiones y los indicadores que medía cada uno de los ítems, se llegó a un consenso de la validez de las dimensiones y de los ítems mediante discusión. Partiendo de esta versión consensuada, se creó un panel de expertos (n = 15) y se aplicó la metodología Delphi para evaluar la validez de contenido de la prueba. Para la evaluación de la relevancia y representatividad de las dimensiones y los ítems, se elaboró una herramienta con sus respectivos indicadores para la valoración cuantitativa (escala Likert de 1 a 10; desde “nada relevante” hasta “totalmente relevante”) y cualitativa. Una vez realizada la primera valoración, se informó a cada uno de los expertos sobre las respuestas y las justificaciones dadas por el resto de los participantes y se les dio la posibilidad de cambiar alguna respuesta tras valorar otras posibles argumentaciones. Se realizaron dos rondas de valoración hasta definir un número de ítems por dimensión y conseguir una primera versión del cuestionario. Todo el proceso se realizó por vía telemática. Se eliminaron las dimensiones e ítems con valoraciones cuantitativas inferiores a siete o valoraciones cualitativas con menos de un 70% de acuerdo entre expertos (Bulger & Housner, 2007).

Para obtener evidencias de validez basadas en los procesos de respuesta se utilizó el método de entrevista cognitiva (Miller, Cheep, Wilson, & Padilla, 2013). El cuestionario se administró a 10 docentes universitarios. En primer lugar, mientras cumplimentaban el cuestionario, se solicitó a los participantes que verbalizasen sus pensamientos. Después, a través de una entrevista semiestructurada se recopiló información verbal sobre las respuestas emitidas durante la realización del cuestionario. De ese modo se evaluó la calidad de la respuesta y se determinó si los ítems generaban la información que se pretendía. Se llevaron a cabo ligeras modificaciones como, por ejemplo, en el ítem “Cuando emito mensajes apreciativos, tengo en cuenta las características de cada estudiante, el momento y las consecuencias potenciales” que generaba ciertos problemas de comprensión, se modificaron las palabras “mensajes apreciativos” por “opiniones y valoraciones”, ya que era más fácil de entender y además se mantenía fiel al significado original del ítem.

A continuación, se realizó un estudio piloto a fin de obtener datos empíricos acerca del funcionamiento del CAA. Tomaron parte 50 profesores universitarios (64.4% mujeres y 35.4% hombres) de entre 25 y 60 años de edad. Se llevó a cabo un análisis de tendencia de respuesta de los ítems, un análisis de los índices basados en la distribución y un estudio de la relación entre cada uno de los ítems que componían la escala y la escala misma por medio del índice de discriminación. Así, se obtuvo la versión preliminar del CAA compuesta por 80 ítems.

Por último, con objeto de obtener evidencias de validez y fiabilidad de las puntuaciones del CAA, nos pusimos en contacto por vía telemática con 1500 profesores de diversas universidades españolas a los que se les invitó a participar en el estudio.

Análisis de datos

Para el estudio de las evidencias de validez de la estructura interna del CAA, la muestra total (n = 415) se dividió en dos grupos equivalentes mediante selección aleatoria a través del Programa SPSS V. 24. Con la primera mitad (n = 207) se llevó a cabo un análisis factorial exploratorio (AFE) y con la segunda mitad (n=208) se llevó a cabo un análisis factorial confirmatorio (AFC). Para realizar el AFE de la versión preliminar del CAA se utilizó el programa FACTOR 10.8.02 (Lorenzo-Seva & Ferrando, 2013) y el software Mplus v7.4. Las respuestas a los ítems fueron tratadas como variables ordinales-categóricas, por lo tanto, se optó por el modelo de análisis factorial con metodología de variable categórica (GVM-AF, Muthén & Kaplan, 1985) basado en las correlaciones inter-ítem policóricas. En primer lugar, partiendo de la matriz de correlaciones policórica, se determinó el número de dimensiones a retener mediante el procedimiento de análisis paralelo optimizado con extracción aleatoria de 500 submatrices y basado en un análisis de rangos mínimo (Timmerman & Lorenzo-Seva, 2011). A continuación, se llevó a cabo el AFE mediante el método de estimación de mínimos cuadrados no ponderados y el método de rotación de factores Promin (Lorenzo-Seva, 1999), ya que se esperaba que los factores estuvieran correlacionados. El grado de adecuación de los datos al análisis factorial se realizó mediante el test de esfericidad de Bartlett y el índice de Kaiser-Meyer-Olkin (KMO). Además, se seleccionaron aquellos ítems que presentaron cargas factoriales estandarizadas superiores a .30. Los siguientes índices fueron utilizados para determinar la bondad de ajuste del modelo: el error cuadrático medio de aproximación por grados de libertad (RMSEA), el índice de ajuste comparativo (GFI) y la raíz media cuadrática residual estandarizada (SRMR). Para el manejo de los datos faltantes, se utilizó el procedimiento de imputación múltiple (Hot-Deck Multiple; Lorenzo-Seva & Van Ginkel, 2016).

Con el objetivo de validar la solución factorial propuesta en el AFE, se procedió a efectuar un AFC con la segunda mitad de la muestra (n=208). Los datos se analizaron mediante el software MPLUS versión 7.4. Para analizar el ajuste del modelo propuesto en el AFC se utilizó el método de estimación de mínimos cuadrados ponderados robusto con un estadístico χ2 ajustado por media y varianza (WLSMV), método que es preferible a otros cuando las variables son de naturaleza ordinal, no siguen una distribución normal y existen indicadores que muestran efectos techo o suelo (Finney & DiStefano, 2013). Se usaron los siguientes indicadores de bondad de ajuste: (1) χ2 dividido por los grados de libertad (cocientes ≤ 2.0 indican excelente ajuste; a menor índice menor ajuste; Bollen, 1989); (2) CFI (comparative fit index); (3) TLI (Tucker-Lewis index), (4) RMSEA (root mean square error of approximation) y WRMR (weighted root mean square residual). Se considera que valores CFI y TLI mayores que .90 y .95 reflejan un ajuste aceptable y un ajuste excelente, respectivamente (Hu & Bentler, 1999). En el caso del RMSEA, valores inferiores a .08 y .06 indican, respectivamente, un ajuste aceptable y un ajuste adecuado (Hu & Bentler, 1999). Por último, en lo que se refiere WRMR, valores inferiores a 1 indican un buen ajuste (DiStefano, Liu, Jiang, & Shi, 2018).

Para la estimación de la fiabilidad de las puntuaciones se partió del modelo trifásico propuesto por Viladrich, Angulo-Brunet, & Doval (2017).

Con el objetivo de estudiar la validez convergente del CAA, se examinaron las relaciones previsibles entre las puntuaciones del cuestionario CAA y la versión española del cuestionario S-ATI-20 (Monroy et al., 2015). Para el presente estudio se utilizó el factor Cambio Conceptual/Estrategia centrada en el Estudiante (CCCE). Dado que no cumplía el supuesto de normalidad, se estimó el coeficiente de correlación de rho de Spearman.

Por último, se estudiaron las diferencias en la expresión de las dimensiones del CAA en función del género, la edad y la experiencia docente. En primer lugar, se probó la invarianza de la estructura del modelo obtenido en el análisis factorial confirmatorio. A continuación, para analizar las diferencias, se utilizó el coeficiente de correlación de rho de Spearman y las pruebas Kruskall-Wallis y U de Mann-Whitney.

Resultados

Análisis factorial exploratorio

La matriz de correlaciones policórica mostró apropiados indicadores de adecuación para su factorización (estadístico de Bartlett =7248.9; gl = 2016; p < .0001; Kaiser-Meyer-Olkin KMO = .902; p < .0001). A continuación, partiendo de dicha matriz de correlaciones policórica, se realizó un análisis paralelo optimizado en el que 4 factores superaron el porcentaje de varianza explicado por aquellos generados aleatoriamente. Tal y como se puede observar en la Tabla 2, el modelo compuesto por 4 factores mostraba un mejor ajuste.

Los resultados del AFE pusieron de manifiesto que 5 ítems (8, 32, 65, 67, 68) presentaban una carga factorial menor que .30, los cuales se eliminaron progresivamente de uno en uno. También se observó que 11 ítems (4, 25, 29, 33, 48, 53, 55, 57, 59, 60, 62) presentaban una carga factorial similar en más de una dimensión, por lo que también se procedió a su eliminación. Por último, se descartaron 5 ítems (2, 14, 51, 52, 61) cuya ubicación en el factor propuesto no tenía un significado sustantivo. En total, la versión final resultante de estos análisis quedó configurada por 43 ítems agrupados en 4 factores: Compromiso con los estudiantes y con la enseñanza (9 ítems), Clima del aula (7 ítems), Metodología (18 ítems) y Autorregulación (9 ítems), explicando en conjunto el 50.40% de varianza común.

Análisis factorial confirmatorio

En primer lugar, con el propósito de evaluar la estructura unidimensional del CAA, se realizó un AFC con los 43 ítems extraídos en el AFE. Este modelo presentó los siguientes índices de ajuste: χ2(819, n = 208) = 1473.5, p = .0001; χ2/df = 1.80; CFI = .895; TLI = .890; RMSEA(CI90%) = .062(.057; .067); WRMR = 1.306. A continuación, se puso a prueba el modelo cuatridimensional propuesto en el AFE, el cual presentó un mejor ajuste, χ 2 (854, n = 208) = 1408.4, p = .0001; χ 2/df = 1.65; CFI = .913; TLI = .908; RMSEA(CI90%) = .056(.051; .061); WRMR = 1.215. No obstante, con el objetivo de elegir el modelo más parsimonioso, con sentido conceptual y una óptima bondad de ajuste, en base a los valores de los índices de modificación ofrecidos por el programa MPLUS 7.4, se fueron suprimiendo ítems inapropiados de forma sucesiva. Finalmente se obtuvo una solución compuesta por 39 ítems agrupados en 4 factores: factor 1. Compromiso con los estudiantes y con la enseñanza (8 ítems), factor 2. Clima del aula (7 ítems), factor 3. Metodología (15 ítems) y factor 4. Autorregulación (9 ítems), χ 2 (696, n = 208) = 992.7, p = .0001; χ 2/df = 1.43; CFI = .950; TLI = .946; RMSEA(CI90%) = .045(.039; .052); WRMR = 1.024. Todas las cargas factoriales fueron estadísticamente significativas (p < .0001) y superiores a .40 (valores entre .45 y .80). Cabe señalar que se halló una equivalencia de esta estructura factorial tanto en la primera mitad de la muestra, χ 2 (696, n = 207) = 970.9, p = .0001; χ 2/df = 1.40; CFI = .953; TLI = .949; RMSEA(CI90%) = .044(.037; .050); WRMR = 1.004, como en la muestra total, χ 2 (696, n = 415) = 1257.3, p = .0001; χ 2/df = 1.81; CFI = .951; TLI = .947; RMSEA(CI90%) = .044(.040; .048); WRMR = 1.143.

En la Tabla 3 se muestran las dimensiones del CAA, ítems que las componen y cargas factoriales estandarizadas.

En la Tabla 4 se presentan las medias, desviaciones típicas y correlaciones de rho de Spearman entre los diferentes factores que componen el instrumento de medida.

Consistencia interna

Partiendo del modelo propuesto por Viladrich et al., (2017), en la primera fase se estudiaron las distribuciones univariadas y las relaciones entre ítems. La exploración de los datos puso de manifiesto efectos de techo, los valores de asimetría no fueron particularmente destacados y se observaron valores altos de curtosis, por lo que los datos fueron tratados como ordinales. Por esta razón, se obtuvieron los coeficientes de correlación policórica. En una segunda fase, en primer lugar, se especificaron con AFC los modelos de medida tau-equivalentes y el de medidas congenéricas. A continuación, se estimaron los parámetros del modelo, se calcularon los índices de bondad de ajuste y se eligió el modelo de medición con mejor ajuste que a la vez parsimonioso e interpretable. Para ajustar a los datos los modelos de medida se utilizó el estimador WLSMV mediante el programa Mplus versión 7.4. En la Tabla 5 se presentan los resultados principales de los modelos de medida.

Como se observa en la Tabla 5, el ajuste al modelo de medidas congenéricas fue mejor que el ajuste de medidas tau-equivalentes. Por lo tanto, se estimó la consistencia interna a partir del coeficiente omega ordinal (Gadermann, Guhn, & Zumbo, 2012). Los valores fueron de .826 (.814-.838) para el Compromiso con los estudiantes y con la enseñanza, .815 (.802-.828) para el Clima del aula, 0.887 (0.88-0.894) para la Metodología y .784 (.768-.800) para la Autorregulación.

Relaciones entre las dimensiones del cuestionario CAA y el S-ATI-20 (Monroy et al., 2015)

Se obtuvieron correlaciones positivas y moderadas entre las puntuaciones obtenidas por los participantes en las dimensiones del CCA y la dimensión Cambio Conceptual/Estrategia centrada en el Estudiante (CCCE) del S-ATI-20 (Monroy et al., 2015). Para una información más detallada véase la Tabla 6.

Diferencias en la expresión de las dimensiones del CAA en función del género, la edad y la experiencia docente

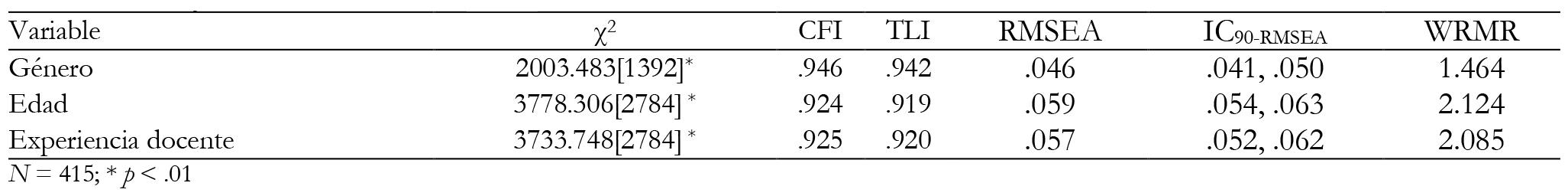

En la Tabla 7 se presentan los índices de bondad de ajuste de los modelos de invarianza configural en función del género, la edad y la experiencia docente.

Tabla 6: Correlaciones entre las puntuaciones obtenidas por los participantes en las dimensiones del CCA y la dimensión CCCE del S-ATI-20.

Tal y como se observa en la Tabla 7, los índices de ajuste permiten aceptar la equivalencia de la estructura factorial obtenida en el AFC para los diversos grupos en función del género, la edad y la experiencia docente.

Con el objetivo de examinar si existían diferencias entre las profesoras y los profesores en las puntuaciones de las dimensiones del CAA, se aplicó la prueba U de Mann-Whitney, obteniéndose diferencias estadísticamente significativas entre las medias de los rangos en los factores Compromiso con los estudiantes y con la enseñanza (U = 17771; p = .002), Clima del aula (U = 18758.5; p = .023), Metodología (U = 18216; p = .009) y Autorregulación (U = 17098; p = 0,001). De acuerdo con estos resultados, los tamaños del efecto asociados a las diferencias de rangos entre las profesoras y los profesores fueron de pequeña magnitud en todos los casos (r = .15, r = .11, r = .13 y r = .18, respectivamente).

Con el fin de conocer si existían diferencias en las puntuaciones de las dimensiones del cuestionario CAA en función de la edad, se aplicó la prueba de Kruskal-Wallis, en el que se tomó el grupo de edad como variable predictora y las puntuaciones de las dimensiones en el cuestionario CAA como variable criterio. Los resultados mostraron que no existían diferencias estadísticamente significativas en las puntuaciones de las dimensiones del cuestionario CAA en función del grupo de edad.

Por último, con objeto de averiguar si los grupos de experiencia docente (0-5 años, 6-15 años, 16-25 años y más de 25 años) diferían en las dimensiones del CAA se aplicó la prueba de Kruskal-Wallis. Los resultados mostraron que no existían diferencias estadísticamente significativas en las dimensiones del cuestionario CAA en función de la experiencia docente.

Discusión

El objetivo del presente trabajo consistió en diseñar y validar un cuestionario, el CAA, para medir los contextos facilitadores de aprendizaje que el profesorado universitario activa para el desarrollo de la competencia aprender a aprender. Para tal fin, se examinaron la validez de contenido, la validez basada en los procesos de respuesta, la validez basada en la estructura interna y la validez concurrente.

Los resultados obtenidos ponen de manifiesto que el CAA cumple con los criterios de elaboración de instrumentos psicométricos con argumento de validez, por lo que se puede considerar que es una herramienta apropiada para medir los contextos facilitadores de aprendizaje que el profesorado universitario activa para el desarrollo de la competencia aprender a aprender. En primer lugar, se alcanzaron evidencias tanto de validez de contenido como de validez basada en los procesos de respuesta. Los resultados obtenidos revelan que el CAA se compone de 39 ítems agrupados en 4 factores: 1. Compromiso con los estudiantes y con la enseñanza (9 ítems), 2. Clima del aula (7 ítems), 3. Metodología (18 ítems) y 4. Autorregulación (9 ítems). Todos los factores mostraron unos buenos índices de consistencia interna. La validez convergente del cuestionario fue examinada a través del cálculo de las correlaciones entre las dimensiones del CAA y la dimensión CCCE del S-ATI-20 (Monroy et al., 2015). Estos análisis proporcionaron evidencias de validez convergente.

En lo que se refiere a las diferencias en la manifestación de las dimensiones del CAA en función de la edad y la experiencia docente, los resultados mostraron que no existían diferencias en las puntuaciones de los participantes en dichas dimensiones. Por lo tanto, podemos concluir que la competencia profesional para facilitar espacios de aprendizaje para desarrollar la competencia aprender a aprender no depende de acumular años de experiencia docente o de tener una mayor o menor edad. A nuestro modo de ver, una mayor capacidad en dicha competencia probablemente se relacione con variables dinámicas y flexibles que inciden en general en el desarrollo de competencias profesionales en el contexto universitario (Feixas, Fernández, Lagos, Quesada, & Sabaté, 2013; Ion & Cano, 2012; Tejada Fernández, & Ruiz Bueno, 2016). Así, partiendo de la propuesta de Feixas et al. (2013), se podrían agrupar en factores de formación (recibir una formación docente específica en dicha competencia), factores del entorno (implementarla con el apoyo de los pares, recibir supervisión y reconocimiento institucional, cultura docente del equipo de trabajo) y factores del individuo (organización personal del trabajo). En futuros estudios sería interesante conocer con qué tipo de factor(es) de formación docente se relaciona un mayor desarrollo de la competencia aprender a aprender en el profesorado universitario.

Por otra parte, cabe señalar que se encontraron diferencias entre las profesoras y los profesores en las puntuaciones de las dimensiones del CAA. Concretamente las profesoras mostraban puntuaciones más altas que los profesores en todas las dimensiones del CAA. Es complicado aventurarse a dar una explicación certera de este resultado ya que no existe precedente alguno en este tipo de estudios. No obstante, consideramos que estos resultados pueden estar relacionados con una mayor presencia de determinadas variables en las profesoras que en los profesores como, por ejemplo, una mayor consciencia de la importancia de la enseñanza centrada en el alumno, haber recibido una mayor formación específica sobre el desarrollo de la competencia aprender a aprender y haber llevado a cabo una mayor transferencia de la misma. Son meras conjeturas puesto que dichas variables no han sido medidas para este estudio, por lo tanto, es necesario seguir avanzando en este campo de estudio y con muestras más amplias para obtener información complementaria.

Conclusión

La adaptación al EEES ha traído consigo un profundo cambio en la educación universitaria, tanto en las titulaciones como en los contenidos y la metodología docente. Las metodologías de enseñanza-aprendizaje dirigidas al desarrollo de competencias redundan más en lo que aprende el estudiante que en lo que enseña el docente, lo que se ha relacionado con una mayor comprensión, motivación y participación del estudiante en el proceso de aprendizaje (Guisasola y Garmendia, 2014).

El Cuestionario Aprender a Aprender (CAA) es el primer instrumento en lengua castellana para evaluar el desarrollo de los contextos facilitadores de aprendizaje en la elaboración de la competencia aprender a aprender en la práctica docente universitaria, una herramienta de rápida aplicación, válida y fiable. Por lo tanto, en el marco del EEES, contar con el CAA puede ser de gran utilidad para el profesorado universitario ya que así puede disponer de una medida exacta de cómo está implementando a través de su práctica docente el desarrollo de la competencia aprender a aprender y así poder detectar acciones de mejora.

Por otra parte, se ha de tener en cuenta que las competencias profesionales docentes se desarrollan a lo largo de toda la vida laboral de la persona de forma dinámica. Ser docente en la educación superior actual significa aprender a serlo, por lo que en la mayoría de los centros universitarios se apuesta por una formación continua del perfil docente. A este respecto, el CAA puede servir para detectar necesidades de formación profesional a nivel de centro en el desarrollo de dicha competencia.

Para finalizar, señalar que este estudio cuenta con algunas limitaciones que hay que tener presentes. En primer lugar, este trabajo se llevó a cabo con una muestra incidental de profesores universitarios que participaron voluntariamente. Por lo tanto, sería preferible realizar un muestreo probabilístico para evitar las limitaciones relacionadas con la generalización de los resultados. En segundo lugar, consideramos que el tamaño de la muestra, aunque suficiente no es muy grande, por lo que hubiese sido recomendable haber utilizado una muestra más amplia. Tercero, aunque se contó con una muestra heterogénea con respecto al género, grupo de edad, estudios, experiencia docente y área de conocimiento, cabe señalar que las y los profesores del área de conocimiento de Ciencias y Ciencias de la Salud se encuentran infrarepresentados. Por lo tanto, hubiese sido más adecuado contar con una muestra más representativa de dichas áreas de conocimiento. Por último, con objeto de acumular mayores evidencias de validez de la interpretación de las puntuaciones, sería interesante llevar a cabo estudios comparativos de rendimiento académico de los estudiantes que reciben docencia de profesores con diferentes niveles en la puesta en práctica de contextos facilitadores de aprendizaje de la competencia aprender a aprender. Asimismo, teniendo en cuenta que el ámbito de aplicación natural es el marco docente universitario, sería adecuado aportar evidencias basadas en las consecuencias de aplicación del CAA.

REFERENCIAS

Abad, F. J., Olea, J., Ponsoda, V. & García, C. (2011). Medición en ciencias sociales y de la salud (Measurement in health and social sciences). Madrid: Síntesis. [ Links ]

Agenda Nacional de Evaluación de la Calidad y Acreditación (2014). Guía de apoyo para la redacción, puesta en práctica y evaluación de los resultados del aprendizaje (Support guide for the writing, implementation and evaluation of learning outcomes). Madrid: ANECA. [ Links ]

Black, P., McCormick, R., James, M. & Pedder, D. (2006). Learning how to learn and assessment for learning: A theoretical inquiry. Research Papers in Education, 21, 119-132. https://doi.org/10.1080/02671520600615612 [ Links ]

Bolívar, A. (2008). El discurso de las competencias en España: educación básica y educación superior (The discourse of competences in Spain: basic education and higher education). Revista de Docencia Universitaria (RedU), número monográfico II, 1-23. [ Links ]

Bollen, K. A. (1989). A new incremental fit index for general structural equation models. Sociological Methods & Research, 17, 303-316. https://doi.org/10.1177/0049124189017003004 [ Links ]

Bulger, S. M. & Housner, L. D. (2007). Modified Delphi investigation of exercise science in physical education teacher education. Journal of Teaching in Physical Education, 26, 57-80. https://doi.org/10.1123/jtpe.26.1.57 [ Links ]

Cano, M. E. (2008). La evaluación por competencias en la educación superior. Profesorado (Assessment by competencies in higher education. Faculty). Revista de Curriculum y Formación de Profesorado, 12, 1-16. [ Links ]

Coll, C., Mauri, T. & Rochera, M. J. (2012). La práctica de evaluación como contexto para el aprendizaje competente (Assessment practice as a context for competent learning). Profesorado, 16, 49-59. [ Links ]

DiStefano, C., Liu, J., Jiang, N. & Shi, D. (2018). Examination of the weighted root mean square residual: Evidence for trustworthiness? Structural Equation Modeling: A Multidisciplinary Journal, 25(3), 453-466. https://doi.org/10.1080/10705511.2017.1390394 [ Links ]

Fazey, D. M. & Fazey, J. A. (2001). The potential for autonomy in learning: Perceptions of competence, motivation and locus of control in first-year undergraduate students. Studies in Higher Education, 26, 345-361. https://doi.org/10.1080/03075070120076309 [ Links ]

Feixas, M., Fernández, A., Lagos, P., Quesada, C. & Sabaté, S. (2013). Factores condicionantes de la transferencia de la formación docente en la universidad: un estudio sobre la transferencia de las competencias docentes (Conditioning factors for the transfer of teacher training at the university: a study on the transfer of teaching competencias). Infancia y Aprendizaje, 36, 401-416. https://doi.org/10.1174/021037013807533034 [ Links ]

Finney, S.J. & DiStefano, Ch, (2013). Nonnormal and categorical data in structural equation modeling. In G.R. Hancock & R. O. Mueller, Structural Equation Modeling. A second course (2nd ed.) (pp 439-492). Charlotte, NC: Information Age Publishing. [ Links ]

Gadermann, A. M., Guhn, M. & Zumbo, B. D. (2012). Estimating ordinal reliability for Likert-type and ordinal item response data: A conceptual, empirical, and practical guide. Practical Assessment, Research & Evaluation, 17, 1-13. [ Links ]

Guisasola, G. & Garmendia, M. (2014). Aprendizaje basado en problemas, proyectos y casos: diseño e implementación de experiencias en la universidad (Learning based on problems, projects and cases: design and implementation of experiences in the university). Servicio Editorial de la Universidad del País Vasco/Euskal Herriko Unibertsitateko Argitalpen Zerbitzua. [ Links ]

Hu, L. T. & Bentler, P. M. (1999). Cutoff criteria for fit indexes in covariance structure analysis: Conventional criteria versus new alternatives. Structural Equation Modeling: A Multidisciplinary Journal, 6, 1-55. https://doi.org/10.1080/10705519909540118 [ Links ]

Ion, G. & Cano, E. (2012). La formación del profesorado universitario para la implementación de la evaluación por competencias (The training of university teachers for the implementation of the assessment by competencias). Educación XX1, 15, 249-270. [ Links ]

Lorenzo-Seva, U. (1999). Promin: A method for oblique factor rotation. Multivariate Behavioral Research, 34, 347-365. https://doi.org/10.1207/S15327906MBR3403_3 [ Links ]

Lorenzo-Seva, U. & Ferrando, P. J. (2013). Factor 9.2: A comprehensive program for fitting exploratory and semiconfirmatory factor analysis and IRT models. Applied Psychological Measurement, 37, 497-498. https://doi.org/10.1177/0146621613487794 [ Links ]

Lorenzo-Seva, U. & Van Ginkel, J. R. (2016). Multiple imputation of missing values in exploratory factor analysis of multidimensional scales: Estimating latent trait scores. Anales de Psicología, 32, 596-608. https://doi.org/10.6018/analesps.32.2.215161 [ Links ]

Margalef, L. (2014). Evaluación formativa de los aprendizajes en el contexto universitario: resistencias y paradojas del profesorado (Formative evaluation of learning in the university context: resistance and paradoxes of the teaching staff). Educación XXI, 17, 35-55. [ Links ]

Miller, K., Chepp, V., Willson, S. & Padilla, J.L. (2014). Cognitive Interviewing Methodology: A Sociological Approach for Survey Question Evaluation. New York, NJ: John Wiley and Sons. [ Links ]

Ministerio de Educación, Cultura y Deporte del Gobierno de España (2013). Guía para la formación en centros sobre las competencias básicas (Guide for training in centers on basic competences). Secretaría General Técnica. Subdirección General de Documentación y Publicaciones, Madrid. [ Links ]

Ministerio de Educación, Cultura y Deporte del Gobierno de España (2018). https://www.mecd.gob.es/educacion/mc/lomce/inicio.html [ Links ]

Monereo, C. & Lemus, R. (2010). Dime cómo evalúas y te diré cómo aprenden (a aprender) tus alumnos (Tell me how you evaluate and I will tell you how your students learn (to learn)). Aula de Innovación Educativa, 190, 56-59. [ Links ]

Monroy, F., González-Geraldo, J. L. & Hernández-Pina, F. (2015). A psychometric analysis of the Approaches to Teaching Inventory (ATI) and a proposal for a Spanish version (S-ATI-20). Anales de Psicología, 31, 172-183. https://doi.org/10.6018/analesps.31.1.190261 [ Links ]

Muñoz-San Roque, I., Martín-Alonso, J. F., Prieto-Navarro, L. & Urosa-Sanz, B. (2016). Autopercepción del nivel de desarrollo de la competencia de aprender a aprender en el contexto universitario: propuesta de un instrumento de evaluación (Self-perception of the level of development of the competence of learning to learn in the university context: proposal of an evaluation instrument). Revista de Investigación Educativa, 34, 369-383. https://doi.org/10.6018/rie.34.2.235881 [ Links ]

Muthén, B. & Kaplan, D. (1985). A comparison of some methodologies for the factor analysis of non‐normal Likert variables. British Journal of Mathematical and Statistical Psychology, 38, 171-189. https://doi.org/10.1111/j.2044-8317.1985.tb00832.x [ Links ]

Novak, J. D. (2002). Meaningful learning: The essential factor for conceptual change in limited or inappropriate propositional hierarchies leading to empowerment of learners. Science Education, 86, 548-571. https://doi.org/10.1002/sce.10032 [ Links ]

Putwain, D., Sander, P. & Larkin, D. (2013). Academic self‐efficacy in study‐related skills and behaviours: Relations with learning‐related emotions and academic success. British Journal of Educational Psychology, 83, 633-650. https://doi.org/10.1111/j.2044-8279.2012.02084.x [ Links ]

Tejada Fernández, J. & Ruiz Bueno, C. (2016). Evaluación de competencias profesionales en educación superior: retos e implicaciones (Assessment of professional competencies in higher education: challenges and implications). Educación XX1, 19, 17-38. [ Links ]

Timmerman, M. E. & Lorenzo-Seva, U. (2011). Dimensionality assessment of ordered polytomous items with parallel analysis. Psychological Methods, 16(2), 209. https://doi.org/10.1037/a0023353 [ Links ]

Trigwell, K. & Prosser, M. (2004). Development and use of the approaches to teaching inventory. Educational Psychology Review, 16(4), 409-424. https://doi.org/10.1007/s10648-004-0007-9 [ Links ]

van der Stel, M. & Veenman, M. V. (2010). Development of metacognitive skillfulness: A longitudinal study. Learning and Individual Differences, 20(3), 220-224. https://doi.org/10.1016/j.lindif.2009.11.005 [ Links ]

Veenman, M. V., Van Hout-Wolters, B. H. & Afflerbach, P. (2006). Metacognition and learning: Conceptual and methodological considerations. Metacognition and Learning, 1(1), 3-14. https://doi.org/10.1007/s11409-006-6893-0 [ Links ]

Viladrich, C., Angulo-Brunet, A. & Doval, E. (2017). A journey around alpha and omega to estimate internal consistency reliability. Anales de Psicología, 33(3), 755-782. https://doi.org/10.6018/analesps.33.3.268401 [ Links ]

Villardón, L., Yániz, C., Achurra, C., Iraurgi, I. & Aguilar, M. C. (2013). Learning competence in university: Development and structural validation of a scale to measure. Revista de Psicodidáctica, 18(2), 357-374. https://doi.org/10.1387/RevPsicodidact.6470 [ Links ]

Wingate, U. (2007). A framework for transition: Supporting ‘learning to learn' in higher education. Higher Education Quarterly, 61(3), 391-405. https://doi.org/10.1111/j.1468-2273.2007.00361.x [ Links ]

Zabalza, M. A. (2009). Ser profesor universitario hoy (Be a university professor today). La Cuestión Universitaria, 5, 68-80. [ Links ]

Recibido: 08 de Octubre de 2018; Revisado: 10 de Marzo de 2020; Aprobado: 05 de Noviembre de 2020

texto en

texto en