Introducción

Un asistente virtual o chatbot es un programa informático con el que es posible mantener una conversación y del cual se puede obtener información o algún tipo de acción (Hill, Ford y Farreras, 2015; Khan y Das, 2017; Shawar y Atwell, 2005). Para comprender la historia de estas máquinas y los esfuerzos humanos por mejorarlas, es necesario hablar de Alan Turing. A mediados del s. XX, Turing propuso un postulado teórico en el que ponía a prueba el comportamiento inteligente de una máquina frente al de una persona (Maudin, 1994; Turing, 1951; Turing, Braithwaite, Jefferson y Newman, 1952). El conocido como "Test de Turing" o "Juego de imitación" tiene el propósito de dilucidar si un robot puede mostrar un comportamiento similar al de un humano. Para ello, un evaluador mantiene una conversación, a través de una interfaz, con dos interlocutores: un bot y una persona humana. Si el evaluador no es capaz de distinguir cuál es el bot en un intervalo de tiempo de cinco minutos, se concluye que la máquina ha superado la prueba. En la competición Loebner Price, cuya primera edición tuvo lugar en 1991, diversos robots pueden competir por superar el famoso test. En esta competición se han repartido premios a los mejores robots durante muchos años, pero ha sido en 2014, más de dos décadas después de la primera edición, cuando una máquina ha logrado superar el test de Turing (Khan y Das, 2017; Maudin, 1994; Warwick y Shah, 2014, 2016).

Los orígenes de los chatbots se vinculan necesariamente a la Psicología. Los primeros pasos en el desarrollo de estas máquinas se atribuyen a Joseph Weizenbaum (1966), quien construyó un programa que permitía simular una conversación con una psicóloga. Dicho programa, llamado ELIZA, se puede considerar el primer chatbot o agente virtual de la historia (Khan y Das, 2017). ELIZA se encarga de identificar, en el texto que introduce el usuario, palabras clave, a partir de las cuales genera preguntas. Cuando no es capaz de identificarlas, emplea frases hechas que animan al usuario a hablar más: "¿por qué dices eso?", "¿puedes desarrollarlo más?" (Weizembaum, 1966). Aunque las respuestas están predefinidas, este robot transmite la sensación de que es capaz de comprender al usuario (ELIZA, 2018).

ELIZA sirvió de inspiración para trabajos posteriores (Khan y Das, 2017). Un ejemplo de ello es el chatbot Alicebot –creado en 1995 por Richard Wallace– que ha logrado ganar el premio Loebner en varias ocasiones y que se creó con más de 40.000 categorías de conocimiento (ELIZA tenía alrededor de 200). Estas categorías se componían de una pregunta y una respuesta, y estaban integradas en un diagrama de árbol para facilitar el diálogo. Por su diseño, este agente virtual se pensó para estar en continuo desarrollo y mejora: de ello se encargaba el botmaster, quien creaba nuevo contenido para ajustar las respuestas de Alicebot (Wallace, 2009). Unos años después se creó el bot SmarterChild, el cual no solo permitía mantener una conversación, sino que, además, ofrecía información sobre varios temas (deportes, películas, el tiempo, etc.) (Klopfenstein, Delpriori, Malatini y Bogliolo 2017; Khan y Das, 2017). Posteriormente, también se han desarrollado agentes virtuales animados, esto es, avatares con apariencia, gestos y expresiones humanas que interactúan con los usuarios. Al parecer, este tipo de presentación favorece que el usuario perciba al chatbot como más sociable y agradable (Klopfenstein et al., 2017).

Estos bots pioneros han establecido las bases para el diseño de una gran diversidad de agentes conversacionales. Los más conocidos se encuentran actualmente en nuestros dispositivos, como por ejemplo Google Assistant (desarrollado por Google), Siri (desarrollado por Apple), Cortana (desarrollado por Microsoft) o Watson (desarrollado por IBM). Son capaces de interactuar con el usuario a partir de entradas de texto y voz, y tienen el objetivo de ayudarle a realizar múltiples acciones como pueden ser activar la música, organizar citas médicas, resolver preguntas de todo tipo o, incluso, pedir comida a domicilio (Khan y Das, 2017). Asimismo, cada día son más las empresas que incluyen un chatbot en su web o en sus redes sociales con el fin de que ofrezca productos y servicios a los clientes. Un ejemplo es Irene, la asistente virtual de la empresa Renfe, que facilita al usuario preparar su viaje y que, además, cuenta con un avatar animado.

Aunque la mayoría de los chatbots se han desarrollado con fines comerciales, estas máquinas también resultan de utilidad en otros ámbitos: un posible caso de uso no comercial puede ser como herramienta de apoyo en las tareas de evaluación e intervención psicológica. Por un lado, solo hemos encontrado un bot destinado a realizar labores de evaluación psicológica hasta el momento; se llama Sentinobot (Sentino, 2018) y fue construido con el objetivo de evaluar rasgos de personalidad (ELIZA o Alicebot no se presentan específicamente como herramientas de ayuda a la evaluación, aunque favorecían que el usuario revelara sus problemas psicológicos). Sentinobot recoge información sobre los cinco grandes (extroversión, responsabilidad, amabilidad, neuroticismo y apertura a la experiencia) mediante preguntas y respuestas de opción múltiple basadas en una escala tipo Lickert; es decir, se trata de un agente virtual que administra un test de evaluación con preguntas y respuestas cerradas. Sentinobot es una herramienta con un formato distinto al de los tradicionales test de evaluación, pero no hemos encontrado estudios sobre las garantías psicométricas de este prototipo. Por otro lado, el mejor ejemplo de ayuda para las labores de intervención es Woebot (Fitzpatrick Darcy y Vierhile, 2017), un agente conversacional basado en elementos de la terapia cognitivo conductual. Este bot administra un programa de autoayuda a usuarios que presentan síntomas de depresión. En un estudio realizado con una muestra de 70 estudiantes, se observó que el grupo que recibió terapia a partir del asistente virtual redujo los síntomas de depresión, en comparación con el grupo que simplemente recibió información sobre este trastorno. Los autores de este estudio concluyen que los chatbots pueden ser una herramienta de potencial utilidad a la hora de administrar terapia cognitivo conductual (Fitzpatrick et al., 2017).

También cabe mencionar el Chatbot Replika (Brandtzaeg y Følstad, 2018; Replika, 2018), que fue diseñado con el objetivo de que el usuario mantenga una interacción agradable y "se sienta mejor". Se presenta como un amigo virtual, y realiza preguntas sobre las actividades cotidianas de su interlocutor, sus hobbies, sus aspiraciones y sus sentimientos. Aunque no se define como un psicólogo ni ha sido construido con esa intención, es capaz de identificar palabras clave vinculadas al malestar psicológico; y quizá es destacable su función de derivación a un servicio de atención especializado cuando detecta ideación suicida. Respecto a este agente virtual, no hemos encontrado estudios controlados que ofrezcan evidencias sobre su eficacia, efectividad o eficiencia.

En nuestro equipo de investigación estamos diseñando actualmente un Psicólogo-Chatbot encargado de realizar una entrevista de evaluación psicológica inicial (a la que denominamos pre-evaluación). Con este proyecto, pretendemos crear un robot conversacional con garantías y rigor científico que sirva de ayuda para las labores de evaluación psicológica. Además, una vez construida la herramienta, será posible estudiar las diferencias entre las entrevistas en las que el usuario interacciona con un chatbot (proceso humano-chatbot) y las entrevistas en las que el usuario interacciona con un psicólogo humano (proceso humano-humano). Esto permitirá no solo mejorar el chatbot, sino también conocer en profundidad qué formas de interacción son más eficaces para lograr un determinado objetivo. Por otro lado, servirá para establecer las bases de desarrollo de futuras herramientas, así como para iniciar un debate acerca de la pertinencia y la necesaria regulación de su uso.

A continuación, exponemos las bases necesarias para desarrollar un agente virtual de evaluación psicológica, describiendo los conceptos básicos para su creación y diseño, y las consideraciones psicológicas necesarias.

CÓMO CREAR UN CHATBOT

Herramientas para desarrollar agentes conversacionales

Dado que en los últimos años se ha incrementado el desarrollo de agentes conversacionales, también ha aumentado el número de herramientas que permiten diseñarlos. Algunas de las plataformas más importantes que ofrecen servicios vinculados al desarrollo de chatbots son IBM Watson, API.ai, Dialogflow o Microsoft LUIS. Estas herramientas facilitan la programación de agentes conversacionales con aparente inteligencia y además se encuentran en constante mejora (Khan y Das, 2017). También son conocidos los servicios proporcionados por Chatfuel o Flow XO; herramientas más sencillas que las mencionadas anteriormente, pero más limitadas (Janarthanam, 2017; Kothari, Zyane y Hoover, 2017).

Dentro del ámbito de la Psicología, resultará necesario utilizar plataformas avanzadas que permitan una interacción fluida y rica con los usuarios puesto que, si el chatbot no aparenta cierta inteligencia, el usuario aumentará su desconfianza hacia la herramienta. En cualquier caso, para diseñar un asistente conversacional es necesario conocer una serie de conceptos básicos con los que trabajan la gran mayoría de plataformas destinadas a desarrollarlos.

Estructuración del chatbot: intenciones, entidades y diálogo

Hay tres conceptos esenciales que han de considerarse de cara a la construcción de un chatbot: intenciones, entidades y diálogo (Khan y Das, 2017).

Las intenciones se refieren a las acciones o demandas que requiere el usuario (comprar un billete de tren, reservar una mesa, comunicar un problema, preguntar una duda, etc.); lo primero que un agente conversacional debe identificar es qué solicita el humano con el que interactúa. Sin embargo, dado que el lenguaje humano es ampliamente rico, existen múltiples formas de comunicar lo mismo y es preciso tener en cuenta que el chatbot solo podrá identificar las intenciones del usuario si previamente se han descrito en su programación las diferentes formas de expresar una misma intención.

Imaginemos un ejemplo sencillo: un centro de estudios ofrece formación online e implementa un chatbot en su página web para conocer los deseos de los visitantes de la página y ayudarles a contratar el curso que más les interese. Un usuario requiere inscribirse a un curso de formación y, para ello, puede decirle al chatbot: "necesito un curso", "quiero apuntarme a un curso", "me gustaría formarme en su centro", etc. En este caso, tendríamos que haber incluido todas las formas de expresar esa solicitud en la intención #inscribirse_curso (es habitual emplear el símbolo "#" antes de cada intención).

Además, una misma intención puede tener diversos matices. Por ejemplo, un usuario puede estar interesado en inscribirse a un curso de Psicología Clínica, mientras que otro puede preferir una plaza en un curso de gestión de Recursos Humanos. La intención es la misma, inscribirse en un curso, pero los usuarios no se están refiriendo a lo mismo. Pues bien, las entidades son las que permiten hacer este tipo de distinciones relativas a una misma intención. Se podrían considerar "palabras clave" y generalmente se identifican utilizando el símbolo "@". Así, en el ejemplo que acabamos de mencionar, podríamos distinguir entre @psicología_clínica y @recursos_humanos, y programar que, si el chatbot reconoce la intención #inscribirse_curso, pregunte: "¿Te interesan los cursos del área de Psicología Clínica o del área de Recursos Humanos?". Si el usuario contesta "Quiero informarme sobre los cursos de psicología clínica", el chatbot identificará la intención @psicología_clínica y le ofrecerá información al respecto.

Por último, el chatbot necesita un conjunto de preguntas o frases para interactuar con el usuario, esto es, un Diálogo. Este diálogo se programa detalladamente de acuerdo con el tipo de interacción que vaya a llevarse a cabo. En el proceso de creación del mismo, las intenciones y las entidades irán conformando y dirigiendo el diálogo: el sistema funciona como un árbol de decisiones, es decir, según las intenciones y las entidades que detecte en las respuestas del usuario, irá decidiendo a qué nodo pasar. Siguiendo con el ejemplo anterior, si un usuario muestra interés por contratar un curso, y el chatbot "entiende" su intención, realizará preguntas (descritas en el diálogo) para tratar de identificar qué tipo de curso quiere, el horario, etc. Es fundamental que, para que el asistente no se pierda en la conversación, todas las opciones posibles de conversación estén contempladas en el árbol de diálogo.

Sobre todo, los chatbots que están pensados para realizar una función comercial, se construyen considerando los conceptos mencionados anteriormente. Su principal propósito es ofrecer la información que solicitan los humanos con los que interactúan. Es decir, los usuarios requieren un producto o servicio, y aquello que le dicen al chatbot (ya sea hablado o escrito) permite, a su vez, dirigir la próxima pregunta que hará el bot. De modo que, si un cliente indica que quiere adquirir una entrada, el chatbot detectará que ha de identificar qué tipo de entrada necesita (teatro, cine, etc) y, por tanto, responderá acorde a ello.

Sin embargo, como se indicará en el siguiente apartado, esto es ligeramente distinto cuando hablamos de un chatbot que pretende hacer el trabajo de un psicólogo que realiza una primera evaluación de un caso clínico. En este uso, es el Psicólogo-Chatbot el que requiere la información necesaria del humano para realizar una valoración de su problema, y será el agente virtual el que guíe la conversación con el usuario para que éste sea capaz de describirlo de la mejor manera posible (Figura 1).

Por tanto, a la hora de construir un Psicólogo-Chatbot, hay que considerar una serie de aspectos antes de definir las intenciones, las entidades y el árbol de diálogo.

CONSTRUCCIÓN DE UN PSICÓLOGO-CHATBOT

Consideraciones previas

Antes de empezar a construir el chatbot, es necesario considerar qué tipo de agente virtual queremos programar y para qué fin. En nuestro caso, expondremos los elementos necesarios para construir uno dirigido a realizar tareas de evaluación psicológica preliminar, aunque es cierto que los conceptos y pasos que describiremos podrían generalizarse a robots con funciones similares.

Es importante tener claro el público al que va dirigido. Muchas empresas ofrecen los servicios a través de un chatbot alojado en su página web o en sus redes sociales, abierto a todos los públicos con objetivos no especificados. En nuestro caso, consideramos que el Psicólogo-Chatbot tendría que estar solo disponible para los clientes de centros sanitarios en los que se demanden evaluaciones psicológicas preliminares.

También es necesario tener en cuenta la información que el chatbot obtendrá de los usuarios; en nuestro caso, dado que los psicólogos trabajamos con información confidencial, hemos de cuidar al máximo el tratamiento de estos datos y la accesibilidad a los mismos. El agente virtual ha de estar construido de modo que el acceso y la custodia de la información cumplan con todos los requisitos del Reglamento Europeo de Protección de datos (UE) 2016/679 de 27 de abril de 2016 (RGPD) y de la Ley Orgánica 3/2018, de 5 de diciembre, de Protección de Datos Personales y garantía de los derechos digitales. Entre otras cosas, ha de estar alojado en un servidor seguro y el acceso a los datos debe estar limitado a los psicólogos del centro en el que se trate el caso. Por supuesto, los usuarios que interactúen con el chatbot estarán informados acerca del tratamiento de sus datos personales y deberán consentirlo antes de iniciar la conversación.

Una vez que todos estos pasos estén claros, podremos empezar a considerar los objetivos que tendrá el chatbot o agente conversacional.

Objetivos del chatbot con funciones de evaluación psicológica inicial

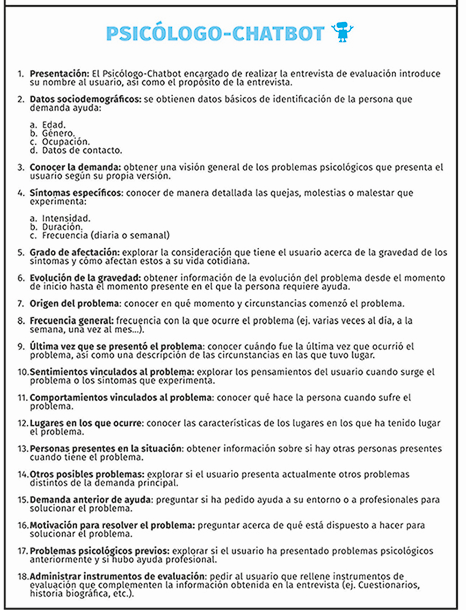

Cuando un psicólogo humano hace una entrevista de pre-evaluación (evaluación psicológica inicial), lo hace con una serie de objetivos preestablecidos. En primer lugar, es necesario conocer datos básicos del usuario: nombre, edad, ocupación… En segundo lugar, el psicólogo que realiza la entrevista recaba datos sobre el problema del cliente y guía a este para lograr que lo describa de la manera más precisa posible. Por ejemplo, si el cliente indica que tiene ansiedad, el psicólogo ha de concretar la intensidad de los síntomas, en qué situaciones, desde cuándo, con qué frecuencia, etc. En este caso, no es el cliente quien demanda al chatbot un determinado tipo de información (horarios, tipos de entradas…), o requiere determinadas acciones (reservar, comprar…), sino que es el chatbot el que pregunta al cliente, con el propósito de después facilitar la información relevante de su caso a una Clínica Psicológica.

Para construir un asistente conversacional con funciones de evaluación psicológica, hemos de especificar adecuadamente los objetivos de la entrevista para poder transmitírselos a la herramienta mediante el flujo del diálogo y las entidades. Recordemos que en este caso el chatbot no ha de identificar qué quiere el cliente, sino que será el árbol de diálogo predefinido el que guíe la conversación. Esto significa que seguramente no será necesario definir intenciones, pero sí entidades o palabras clave que permitirán al bot identificar si está recabando la información adecuada.

Los objetivos de pre-evaluación que proponemos a continuación para integrar en el Psicólogo-Chatbot están basados en la entrevista conductual propuesta por Fernández Ballesteros (2015) y en la propia experiencia y criterio de las autoras del presente artículo. Con este tipo de preguntas no se busca realizar un diagnóstico, sino obtener información general que ayude tanto a analizar el problema posteriormente (esto es, una explicación de por qué el usuario no logra afrontar sus dificultades con éxito), como a valorar de qué manera ha de continuar la fase de evaluación, en el caso de que el usuario decida iniciar la terapia. Asimismo, como se describirá más adelante, esta herramienta puede resultar de gran utilidad para las Clínicas que cuenten con distintos profesionales, pues los datos recabados en la conversación pueden ayudar en la decisión de a qué especialista derivar al usuario.

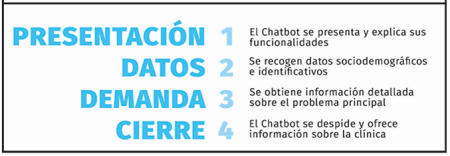

Las figuras 2 y 3 reflejan la estructura y los objetivos que debería tener un chatbot cuya finalidad es realizar una pre-evaluación a un usuario que demanda ayuda psicológica.

Diálogo y palabras clave

Las palabras clave y el diálogo se establecerán en base a los objetivos del chatbot con funciones de evaluación psicológica. Por ejemplo, respecto a las preguntas acerca de los datos sociodemográficos, si el objetivo es conocer la ocupación del usuario, el diálogo podrá ser: "¿Cuál es tu ocupación actual?" o "¿A qué te dedicas?". Asimismo, las palabras clave que indican que se ha respondido a la pregunta y que, por tanto, se puede continuar con el siguiente objetivo serían "estudio", "trabajo", "en paro", etc., que corresponderían a las entidades @estudio, @trabajo, @paro, etc.

En definitiva, cada objetivo del chatbot debe llevar asociada una lista de posibles preguntas sinónimas que conformarían el diálogo. Además, se registrarán listas de palabras clave que el chatbot habrá de identificar en la respuesta (de texto o voz). No obstante, cabe la posibilidad de que en ciertas partes del diálogo no se definan estas palabras clave para detectar, sino que se permitirá que se responda de manera más abierta. En concreto, en casi todas las preguntas pensadas para recabar información sobre el problema del cliente, no es muy conveniente hacer una lista de palabras clave a identificar en la respuesta, pues la conversación debe avanzar sin restringir la manera de expresarse del usuario o la información que ha de aportar.

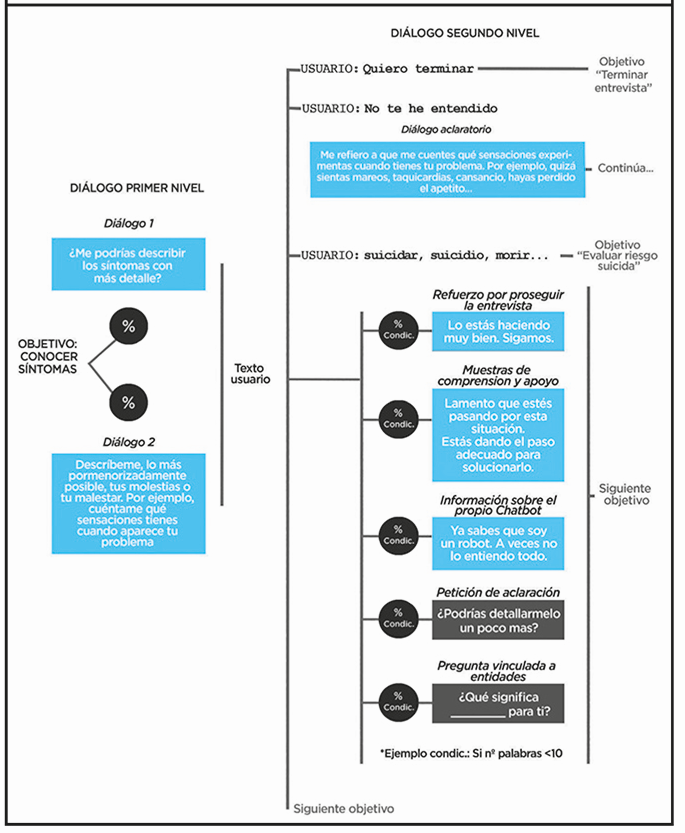

Para lograr construir un chatbot inteligente y que además sea eficiente, el árbol de diálogo ha de contar con lo siguiente (esquematizado en la figura 4):

Los nodos con las preguntas para la pre-evaluación expresadas de diferentes maneras.

Un nodo aclaratorio para aquellas ocasiones en las que el cliente no entienda la pregunta que se le hace (Ej. "Me refiero a que si hay algún otro problema que pueda ser relevante o del que te hayas acordado durante la conversación y que también te produzca malestar").

Un nodo en el que se requiere al usuario que complete la respuesta cuando esta es aparentemente escueta (Ej. "¿Podrías detallármelo un poco más?"), con el objetivo de ampliar la información.

Nodos que expresen comprensión y apoyo en relación al problema que plantea el usuario (Ej. "Lamento que estés pasando por esta situación").

Nodos que refuercen al usuario por la realización de la entrevista (Ej. "Lo estás haciendo muy bien, sigamos").

Nodos que recuerden al usuario que está interactuando con un chatbot y que es probable que éste no comprenda todo lo que le dice (Ej. "Ya sabes que soy un robot, a veces no lo entiendo todo").

Para un desarrollo más avanzado, sería muy útil contar con un configurador que permita gestionar las preguntas, de manera que la aparición de las preguntas estuviera asociada a una determinada probabilidad o, incluso, al propio aprendizaje automático de la herramienta. No obstante, ya que estos avances precisan de un desarrollo informático más complejo, no son imprescindibles en la fase inicial del chatbot.

Instrucciones para el usuario

Una vez contemos con una visión general acerca del diálogo y las palabras clave que "reconocerá" el chatbot, será el momento de considerar cómo empezará la conversación. Resultará conveniente advertir al usuario acerca del funcionamiento del agente virtual, indicando que se trata de un robot y que necesita que interactúen con él utilizando frases concisas. De otro modo, los clientes podrían comenzar a describir su problema a partir de grandes entradas de texto, lo que dificultaría que el agente virtual pudiera "entender" el contenido (es decir, reconocer las entidades adecuadas). Se le puede avisar también de que es posible que se le pregunte por datos que ya ha mencionado en mensajes previos. En ocasiones, en una misma entrada de texto el cliente puede informar de varios datos (ej. Lugar en el que tuvo un ataque de ansiedad y personas presentes); si el chatbot no está programado para identificar ambos datos en una sola entrada, es probable que en otras preguntas que realice pida al usuario información sobre algo que ya le ha contado. Si no advertimos al cliente de que esto puede ocurrir, es más probable que se frustre y abandone la conversación sin haber terminado la entrevista.

Por otro lado, como comentábamos anteriormente, es necesario informar al cliente acerca del uso de los datos personales que va a proporcionar. En nuestro caso, consideramos que esta información, de acuerdo con la legislación vigente, se le debe ofrecer al usuario antes de que comience la conversación con la herramienta. Sin embargo, no está de más que el propio agente virtual realice un recordatorio al inicio de la interacción.

Síntesis de la información recabada por el Chatbot

Una vez el usuario ha completado la entrevista con el chatbot, esta se almacenará en un servidor seguro con acceso restringido. La información que permita identificar al usuario estará cifrada y separada del resto de información. Para este tipo de chatbot en particular, hemos diseñado la salida de datos de tal forma que se pueda obtener la conversación en bruto con las palabras relevantes destacadas (ej. "triste", "ansiedad", "miedo", "dolor", "morir" etc.). Al inicio de la conversación se generará un cuadro resumen que recogerá estas palabras además de la descripción de la demanda del usuario. Así, de un primer vistazo podrá conocerse la temática del caso.

Como ya se ha anunciado anteriormente, la información recabada por el Chatbot podrá ser de utilidad para decidir a qué profesional de un equipo de psicólogos asignar el caso. Esta labor se agilizará gracias a la herramienta, puesto que no será necesario emplear tiempo para evaluar personalmente cada caso. Asimismo, se evitará que el usuario comience la terapia con un terapeuta distinto al que hizo la evaluación inicial. Es preciso decir que el terapeuta al que se le asigne el caso contará con la información recabada por el chatbot, lo que facilitará el análisis del problema y la preparación de las sesiones presenciales. En caso de que esta herramienta sea empleada por un único profesional, la información recopilada ayudará igualmente a planificar la evaluación e incluso a hacer una primera aproximación a la explicación del problema.

Desarrollo interdisciplinar

De todo lo descrito anteriormente, se puede advertir que la colaboración entre psicólogos, ingenieros informáticos y lingüistas es indispensable. Los psicólogos son los encargados de indicar cuáles han de ser las preguntas del chatbot y el tipo de información que este ha de ir recabando. Además, son los encargados de señalar aquellas situaciones que requerirían la derivación prioritaria a un psicólogo humano o incluso, más específicamente, a un servicio de emergencia especializado (ej. El usuario presenta ideación suicida con planificación). Los ingenieros y lingüistas se encargan de diseñar y construir el chatbot para que este consiga entender al usuario (identificar ciertas palabras en la entrada de texto o voz), guiar la conversación, interactuar con un lenguaje lo más natural posible, etc.

No hay que olvidar que un chatbot debe estar en continuo desarrollo. Lo ideal es contar con herramientas de aprendizaje automático, pero no siempre se tiene acceso a este tipo de tecnología. En cualquier caso, este proceso tendrá que estar supervisado por un botmaster (y en el caso de un Psicólogo-Chatbot, esta tarea deberá ser desempeñada por psicólogos, ingenieros y lingüistas).

DISCUSIÓN

Los chatbots son una realidad en incesante aumento y desarrollo. Si bien sus orígenes se remontan a hace más de medio siglo, es ahora cuando su presencia está empezando a despuntar. Esto es posible, en gran parte, gracias a los últimos avances de la ciencia computacional y la inteligencia artificial (Brandtzaeg y Følstad, 2018). Estas máquinas son capaces de ofrecernos servicios de indudable potencial: nos ayudan con la gestión de tareas diarias, con la adquisición de productos y servicios, e incluso se ofrecen como un amigo virtual. En cuanto al ámbito de la Psicología, si bien el primer chatbot de la historia se presentaba como una psicoterapeuta, son pocos los agentes virtuales de este tipo que se han desarrollado con posterioridad y aún menos los que han sido sometidos a estudios controlados para obtener evidencias sobre su eficacia, efectividad y eficiencia.

Consideramos que la creación de chatbots dedicados a labores de evaluación e intervención puede resultar de especial interés y utilidad. Los agentes virtuales de evaluación psicológica pueden ser una herramienta más del psicólogo que se encarga de la valoración de un caso clínico. Una de sus principales ventajas es el ahorro en términos de coste temporal y utilización de espacios físicos. En primer lugar, al ser una herramienta disponible a través de un servicio web, no es necesario que se ocupe un despacho para realizar la evaluación inicial. En segundo lugar, si el chatbot logra recabar información, esta puede agilizar el proceso de evaluación, ahorrando tiempo al psicólogo encargado de asignar el caso a los diferentes terapeutas y, en consecuencia, ahorrando tiempo al propio usuario. Asimismo, los agentes virtuales pueden servir de apoyo durante el tratamiento, facilitando al cliente el proceso de aprendizaje de las pautas y técnicas requeridas para su caso específico.

Es importante reflexionar acerca de las limitaciones de estos agentes conversacionales. En primer lugar, no presentan una inteligencia tal y como entendemos este concepto; su funcionamiento dependerá de cómo hayamos definido las intenciones, las entidades y el diálogo. Evidentemente, no bastará con una versión inicial del bot, sino que será necesario someterle a un proceso de "aprendizaje" constante que permita su perfeccionamiento. En segundo lugar, el empleo de agentes virtuales requiere que los usuarios estén familiarizados con las nuevas tecnologías. Para interactuar con un chatbot se necesita contar con un ordenador o dispositivo móvil, además de con una conexión a internet. Por tanto, emplear un Psicólogo-Chatbot para algunos sectores de la población (por ejemplo, niños y personas mayores) quizá no sea la mejor de las opciones. Asimismo, y en relación con la necesidad de estar conectado a Internet, la interacción con esta herramienta está sujeta a posibles problemas de conexión, los cuales afectan negativamente a la experiencia del usuario.

Otro aspecto a tener en cuenta es el tipo de información que recibe el cliente en la interacción con un asistente conversacional. Los psicólogos no solo ofrecen información verbal, sino que el lenguaje no verbal también tiene un importante papel, por lo que, si el agente virtual no cuenta con un avatar, la interacción se puede ver empobrecida. Lo mismo ocurre en cuanto a la información que recopila el chatbot, pues por ahora no contamos con una tecnología avanzada y asequible que permita comprender el lenguaje no verbal del usuario. Por tanto, el tipo y la cantidad de información obtenida es claramente distinta de la que recabaría un humano. En cualquier caso, no se debe olvidar que es una herramienta de apoyo y que nunca podrá sustituir completamente al psicólogo.

Por otro lado, y con independencia de la disciplina a la que se adscriban, los chatbots han de cumplir con las directrices relativas a la normativa de protección de datos. Estas directrices son aún más estrictas en el caso de la Psicología, puesto que los datos que se manejan son personales, y deben ser tratados confidencialmente y de acuerdo a la ley. En la plataforma de contacto, hay que garantizar al usuario la confidencialidad, informarle del uso que se hará de los datos obtenidos y pedirle su consentimiento. En este caso, la normativa exige un alto nivel de protección y que dicha información solo sea accesible a los psicólogos autorizados. Además de lo anterior, creemos que es importante que los chatbots dedicados a labores de evaluación e intervención psicológica cuenten con una regulación que garantice el cumplimiento de unas directrices mínimas relativas a las normas éticas que tanta relevancia tienen en esta profesión. Por otro lado, también es imprescindible estar en condiciones de ofrecer al usuario la información que se ha obtenido a través del chatbot, en caso de que la solicite (al igual que un usuario puede solicitar al centro psicológico un informe acerca de los datos recabados en el proceso terapéutico).

Las tareas de diseño de un agente virtual psicólogo requieren necesariamente de la aportación del conocimiento de la Psicología, la Ingeniería informática y la Lingüística. La máquina requiere de una base de programación avanzada para su creación y ha de construirse de modo que sea capaz de "entender" el lenguaje natural de los usuarios; a la vez, debe tener en cuenta las estrategias de evaluación e intervención reconocidas como eficaces y efectivas para que cumpla su finalidad con éxito.

Uno de los beneficios de desarrollar estos agentes conversacionales consiste en la posibilidad de estudiar las características del proceso terapéutico chatbot-humano y analizar las diferencias que presenta con el proceso humano-humano. Por ejemplo, podemos estudiar si difieren en el tiempo de interacción, en el número de frases, en la valoración subjetiva del grado de ayuda, en la satisfacción percibida, también si hay expresiones que son más eficaces para obtener un determinado tipo de información, etc. Esto, a su vez, nos permitirá optimizar el agente conversacional (Hill et al., 2015), implementando las mejoras posibles que detectemos. Esperamos que el chatbot que se está desarrollando actualmente y que ha sido descrito en este trabajo nos permita obtener este tipo de datos, para que podamos contribuir a mejorar y expandir el uso de estas herramientas en el ámbito de la Psicología.

El objetivo de este trabajo ha sido presentar de manera sintética el estado de la cuestión en relación al desarrollo de chatbots y su vinculación con la Psicología. Asimismo, se pretende animar a los profesionales a que participen en el proceso de diseño y puesta a prueba de estas herramientas para demostrar su eficacia, efectividad y eficiencia, y para garantizar unas buenas prácticas. No cabe duda de que en los próximos años los avances tecnológicos van a permitir mejoras sustanciales en el desarrollo de agentes virtuales, lo que facilitará su creación y perfeccionamiento. En el ámbito de la Psicología, esperamos que estos avances incorporen elementos relevantes para la profesión, como por ejemplo la posibilidad de identificar el lenguaje no verbal de los usuarios.