INTRODUCCIÓN

La revisión de test que promueve la Comisión de Test del Consejo General de la Psicología de España (COP, http://cop.es) en colaboración con la Comisión de Test de la European Federation of Psychologists' Associations (EFPA, http://efpa.eu; Evers et al., 2013) se inició en 2011 (Muñiz et al., 2011) y desde entonces se han publicado 84 revisiones al ritmo aproximado de una edición anual. Con esta iniciativa se pretende dar respuesta a las necesidades de información independiente por parte de la profesión (e.g., Hidalgo y Hernández, 2019), así como de formación (e.g., Fonseca-Pedrero y Muñiz, 2017), que son más relevantes cuando se utilizan los test para tomar decisiones con consecuencias importantes para las personas evaluadas (e.g., Hernández et al., 2015).

Entre los actores que intervienen en el proceso, la Comisión de Test del COP, formada por profesionales del ámbito académico y de las casas editoriales, ha asumido la función de priorizar los test a evaluar en cada edición. A su vez, el perfil mayoritario de participantes en las revisiones ha sido el de personas que ocupan posiciones senior en distintas especialidades académicas en los ámbitos de la psicología y la educación. Una vez consolidado el proceso, se ha hecho explícita la voluntad de incluir nuevas voces en la revisión (Elosua y Geisinger, 2016), particularmente las que hablan desde el ámbito profesional y desde posiciones junior (Fonseca-Pedrero y Muñiz, 2017). Un paso más en esta dirección sería la ampliación a estudiantes que se incorporarán en breve a la profesión, bajo la tutoría de su profesorado. Además de integrar una nueva voz en el proceso, esta estrategia daría la oportunidad al profesorado de compaginar las tareas de revisión y de formación, al menos en algunas especialidades académicas.

El potencial del modelo europeo de revisión de test como herramienta de formación ha sido ampliamente reconocido por parte del profesorado universitario (Hidalgo y Hernández, 2019; Vermeulen, 2019). Así lo vimos también en la asignatura de Psicometría de la Universitat Autònoma de Barcelona (UAB, http://uab.cat ) cuando a partir del curso 2011/12 implementamos un proyecto de aprendizaje basado en problemas utilizando el modelo de evaluación de test promovido por el COP. El estudiantado redacta un informe de evaluación de un test psicológico, educativo o logopédico completando el Cuestionario de Evaluación de Test Revisado (CET-R; Hernández, et al., 2016) y lo defiende oralmente como parte de las evidencias de aprendizaje que presenta (Doval et al., 2013; Viladrich, Doval, Aliaga et al., 2014). Durante la última década, hemos evaluado un total de 91 test entre los disponibles en nuestra docimoteca, hemos presentado datos favorables de la validez de sus revisiones en comparación con las de especialistas (Viladrich, Doval y Penelo, 2014), hemos estudiado el efecto de la adhesión temprana al proyecto en los resultados académicos (Espelt et al., 2016), y hemos contribuido a la revisión del modelo español (Hernández et al., 2016), además de colaborar individualmente como revisores en distintas ediciones. Durante el curso académico 2019/20 hemos aceptado el reto de liderar la octava edición de la evaluación de test editados en España. Para ello, hemos adaptado la metodología docente que veníamos utilizando a un formato de aprendizaje-servicio (ApS, Redondo-Corcobado y Fuentes, 2018) que ha salido del ámbito de la universidad para dirigirse al conjunto de la comunidad profesional (Viladrich et al., 2019, 2021).

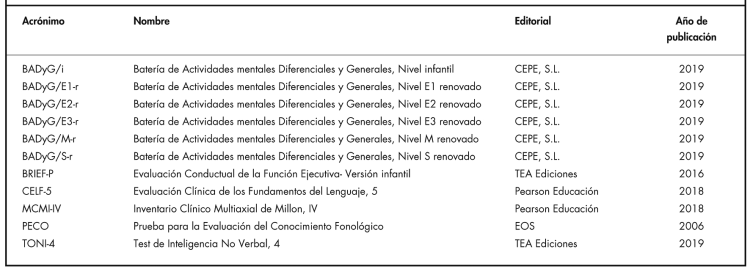

En esta edición, la Comisión de Test del COP nos encargó que revisáramos 11 test encaminados a la medida de la inteligencia, las aptitudes verbales, y la personalidad, publicados entre los años 2006 y 2019. Concretamente, se trata de los seis niveles del test BADyG, y de los test BRIEF-P, CELF-5, MCMI-IV, PECO y TONI-4. Pueden verse más detalles de todos ellos en la Tabla 1. En consecuencia, el primer objetivo de este artículo es exponer y discutir los resultados de calidad de los 11 test sometidos a evaluación en la octava edición de la evaluación de test editados en España. El segundo objetivo es exponer y discutir la aportación de la universidad en relación con dos roles novedosos: como proponente de los test a evaluar y como participante en el proceso de revisión a través del estudiantado de psicología bajo la tutoría de su profesorado.

MÉTODO

Participantes

Participaron 332 estudiantes (78,9% de sexo femenino que formaron 69 equipos de trabajo y el equipo de profesorado de la asignatura de Psicometría, que es obligatoria de tercer curso del grado en Psicología de la UAB. Por otra parte, participaron seis revisoras y cuatro revisores especialistas en psicometría, salud o educación provenientes de distintas instituciones españolas (véase parte superior izquierda de la Tabla 2) y un número no concretado de personas de cada casa editorial.

Instrumentos

CET-R. Los criterios de calidad del modelo español de evaluación de test se reflejan en el CET-R (Hernández et al., 2016), que está formado por tres apartados. En el primero, se describen las características del test; en el segundo, se evalúan sus propiedades; y en el tercero, se resumen todas las valoraciones. Las propiedades de los test se valoran contestando preguntas cerradas con cinco categorías de respuesta ordenadas desde insuficiente a excelente (10 preguntas sobre el desarrollo del test, 18 sobre validez, 14 sobre fiabilidad y nueve sobre interpretación de las puntuaciones). Además de estar basadas en una rúbrica, estas valoraciones se argumentan en varias preguntas abiertas. Puesto que no todos los test requieren las mismas evidencias de calidad, el modelo se flexibiliza sometiendo al juicio de quién evalúa un test concreto la aplicabilidad de cada tipo de evidencia, particularmente en los apartados de fiabilidad e interpretación de puntuaciones.

Rendimiento y satisfacción del estudiantado. Se proporcionan de forma estándar para todas las asignaturas de la universidad. Se valora el porcentaje de retención y el de éxito (UAB, n.d.-a), así como percepción de puntos fuertes y puntos débiles de la asignatura (UAB, n.d.-b).

Procedimiento

En la Figura 1 se representa el procedimiento que consiste en obtener dos revisiones independientes, conciliadas por la editora que, a continuación, considera los comentarios de las casas editoriales antes de redactar y difundir el informe definitivo y el proceso de evaluación. Véase Gómez (2019) para más detalles sobre protocolo estándar. Por nuestra parte, hemos desarrollado un protocolo específico para aplicarlo al proyecto académico de ApS. Cada una de las siete personas que firman este trabajo actuó como editor/a de uno o dos de los test a evaluar hasta cubrir los 11 que formaron el encargo. La primera autora, además, canalizó todos los flujos de información con la Comisión de Test, con las revisoras, los revisores y con las casas editoriales y supervisó todos los informes. Durante el curso académico, en cada grupo de prácticas de Psicometría se evaluó uno de los test en forma de competición entre cuatro o cinco equipos formados por entre tres y seis personas. Cada equipo desarrolló un borrador, recibió los comentarios de su tutor o tutora, y redactó después el informe final. El informe ganador de cada test fue considerado como la Revisión 2 (véanse las autorías en la parte inferior de la Tabla 2). En caso que el premio se considerara desierto, el profesorado tutor asumía este papel. Posteriormente, el profesorado llevó a cabo dos sesiones de discusión para fijar una línea editorial común y valorar el proyecto.

En cuanto a las precauciones éticas, la adaptación al formato ApS fue como sigue. Cada miembro del equipo de profesorado aceptó participar en el proyecto antes de empezar el curso; como alternativa, podía restringir su actividad a la usual de tutorizar a sus estudiantes. Para el estudiantado fue una actividad obligatoria y evaluable como lo venía siendo en la última década. Se les informó del proyecto durante la primera sesión de clase y de forma permanente en el aula virtual. Cada estudiante reconoció mediante su firma haber leído el documento sobre las leyes de copyright que afectan a los materiales. Por otra parte, cada firmante de un proyecto ganador dio por escrito su consentimiento para hacer uso de su texto como Revisión 2 y para publicar su nombre en los procesos de difusión. La gratificación económica que ofrece el COP a la editora y al Revisor 2 se ingresó en un fondo de la UAB destinado a sufragar gastos de la asignatura de Psicometría.

RESULTADOS Y DISCUSIÓN

Calidad de los Test Sometidos a Evaluación

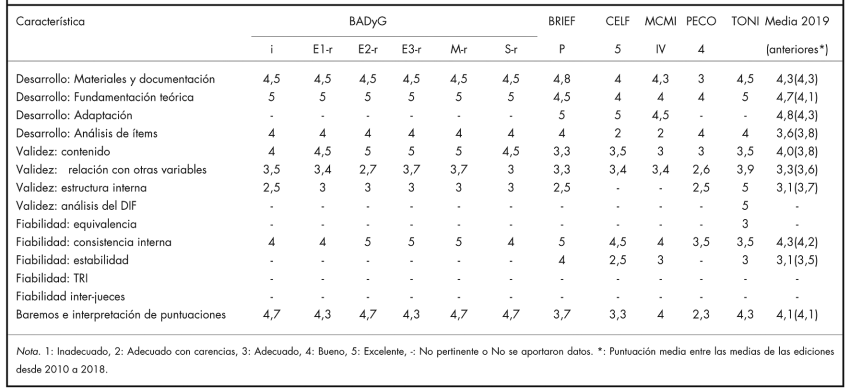

Los informes de revisión de los 11 test sometidos a evaluación son el resultado principal de este trabajo y pueden consultarse y descargarse en el sitio web del COP, dentro del apartado correspondiente al año 2019 (https://www.cop.es/index.php?page=evaluacion-tests-editados-en-espana). A modo de resumen, en la Tabla 3 pueden observarse las puntuaciones de cada uno de los 11 test evaluados en los aspectos relativos al desarrollo del test, las evidencias de validez, la estimación de la fiabilidad de las puntuaciones, y la baremación e interpretación de puntuaciones.

En primer lugar, destacamos que los test valorados en esta edición están desarrollados y baremados de forma muy correcta, tal y como se desprende de la primera y última categorías en la Tabla 3. En todos los manuales se presenta una fundamentación teórica entre buena y excelente y lo mismo sucede con el proceso de adaptación. Aunque con algo más de variabilidad, también los materiales y la documentación de los test se han valorado en este mismo rango, así como la gran mayoría de los estudios de baremación. Estos resultados se mantienen a una altura similar o superior a los obtenidos en las otras revisiones basadas en el CET-R (Gómez, 2019; Fonseca-Pedrero y Muñiz, 2017; Hidalgo y Hernández, 2019) y, en conjunto, ilustran la robustez de los test que las casas editoriales someten a evaluación año tras año en estos aspectos. Cabe destacar que la presentación de datos de análisis de ítems no siempre alcanza valores aceptables según la rúbrica del CET-R. En este sentido, recuperamos aquí la sugerencia de Ponsoda y Hontangas (2013) de que en los manuales se podrían mencionar materiales suplementarios que estuvieran disponibles en la página web de la editorial, como ya se hace, por ejemplo, con la batería de test BADyG. Respecto a la interpretación de puntuaciones, la mejora que juzgamos más importante sería que en todos los manuales se justificaran los puntos de referencia que se publican a modo de ayuda para la toma de decisiones. Así reza la recomendación del CET-R (apartado 2.13.2.1), y un ejemplo de buena práctica son los datos de sensibilidad y especificidad que se publican en el manual del test MCMI-IV. Como mínimo, en todos los manuales habría que hacer un esfuerzo por aclarar que el hecho de que una persona ocupe una posición atípica en relación con su grupo normativo no tiene en sí mismo significación clínica. Se contribuiría así a corregir posibles malos usos que pueden ser razonablemente anticipados (American Educational Research Association [AERA] et al., 2014, estándar 7.1).

La información contenida en el apartado de validez ha sido calificada mayoritariamente como adecuada, lo que significa que el uso de los test evaluados ha merecido confianza a quienes han revisado, aunque sin duda es el apartado con mayor margen de mejora. Una primera oportunidad de mejora sería asociar a cada uno de los usos propuestos del test aquellas evidencias de validez que lo sustentan. Así se recomendaba en la revisión firmada por Elosua y Geisinger (2016), así está contemplado en la introducción al apartado 2.11 del CET-R, y en ello se insistía con la propuesta de Gómez (2019) de reconsiderar la valoración de la etiqueta "No se aporta información" en el CET-R. De hecho, escribir en el manual de un test la afirmación "el test TAL puede utilizarse para evaluar la característica X" requiere un soporte distinto que escribir la afirmación "el test TAL puede utilizarse para detectar dificultades de una persona en la característica X, para diseñar un plan de intervención encaminado a su mejora, y para hacer el seguimiento de su evolución en los ámbitos clínico, educativo, social y legal". La diferencia radica en que la primera afirmación deja bajo la responsabilidad de la persona usuaria del test el uso concreto que hará de esa evaluación y, por tanto, la responsabilidad de sustentar dicho uso (AERA et al., 2014, estándar 9.4). En cambio, con la segunda afirmación se promueve explícitamente el test para diversos usos específicos, por lo que la responsabilidad de apoyar cada uso concreto recae en la casa editorial (AERA et al., 2014, estándares 5.0 y 7.1).

Otra mejora se conseguiría si, antes de presentar resultados de validez, se especificaran con toda claridad las hipótesis concretas que se van a comprobar y cuáles son los resultados que se considerarán evidencia favorable teniendo en cuenta la fundamentación teórica, los resultados obtenidos en investigaciones anteriores y los usos previstos del test (e.g., Ziegler, 2014). En este sentido, la cadena hipótesis-resultados-conclusiones debería quedar clara en relación con todas las cargas factoriales, todos los coeficientes de correlación y todos los tamaños del efecto que se publican, incluso si se presentan dentro de tablas o como resultados previamente publicados. Ello no impide incorporar muchas variables en unas pocas hipótesis, como es el caso de las que se hacen en el análisis factorial o en el diseño de matrices multirasgo-multimétodo; al contrario, este sería precisamente un formato muy recomendable.

La tercera oportunidad de mejora en el ámbito de la validez consistiría en incorporar más información sobre la equivalencia y la equidad en el uso de los test. De forma consistente, en las revisiones anteriores se ha animado a hacerlo incrementando la publicación de estudios sobre funcionamiento diferencial de los ítems (DIF, por sus siglas en inglés; e.g., Fonseca-Pedrero y Muñiz, 2017; Gómez, 2019; Hidalgo y Hernández, 2019). Con todo, en la presente edición su uso se mantiene a un nivel parecido o menor, ya que se ha aportado un único análisis DIF, el relativo al test TONI-4. Por nuestra parte, valoramos el coste que tiene hacer este tipo de pruebas, incluyendo el riesgo de sobreestimar la presencia de DIF. Por ello, creemos que ha llegado el momento de recomendar un paso más asequible y, sin embargo, fundamental, para dar a la equidad la importancia que se le reconoce actualmente tanto en la sociedad como en los textos normativos (AERA et al., 2014; COP, 2015a, 2015b; Asociación Española de Normalización y Certificación [AENOR], 2013). Concretamente, sugerimos incluir en los manuales un apartado específico dedicado a aportar información sobre la flexibilidad del test para afrontar la diversidad funcional, lingüística, neurológica o social de las personas potencialmente evaluables. Esta información puede recabarse mediante análisis DIF, pero únicamente cuando los grupos son grandes y las hipótesis bien definidas. En cambio, es mucho más factible obtener información relevante mediante consultas a especialistas y a personas integrantes de los grupos minorizados (AERA et al., 2014, estándar 3.11). Esta información puede y debe obtenerse y compartirse de forma rigurosa (Levitt et al., 2018). Un rigor que, además, debería extenderse a todas las evidencias obtenidas mediante el uso de métodos cualitativos, entre las que se incluyen la obtenidas durante el desarrollo y la adaptación de un test y, en especial, la recopilación de evidencia relacionada con el contenido del test y también la relativa a puntos de corte para la interpretación de puntuaciones referida al criterio. En nuestra opinión, como mínimo, sería necesario especificar por separado cuántas personas participaron y su cualificación para ello, las estrategias que se utilizaron para obtener la información, los datos que se obtuvieron, sean verbales o numéricos, y las conclusiones y decisiones que de ellos se derivaron, para así facilitar la formación de un juicio propio de quien lee sobre la calidad de dichas decisiones.

Finalmente, respecto a la fiabilidad, los estudios de consistencia interna incluidos en los manuales que se han evaluado reciben mayoritariamente una valoración entre buena y excelente, lo que significa que se publican coeficientes de fiabilidad elevados obtenidos en muestras suficientemente grandes. Sin embargo, hay que remarcar la gran cantidad de casillas sin información que se observan en este apartado de la Tabla 3. Aunque no todos los diseños para estudiar fiabilidad son aplicables a todos los test, tanto en el CET-R (apartado 2.12.1) como en anteriores revisiones (e.g., Hernández et al., 2015) se sugiere como buena práctica la posibilidad de aportar varios coeficientes de fiabilidad para cada escala o subescala y subpoblación. Por nuestra parte, creemos que ello podría concretarse en que cada test aporte datos de fiabilidad obtenidos al menos con dos tipos de diseños de los que se contemplan en el CET-R o, alternativamente, explicaciones claras sobre por qué no son objeto de preocupación otras fuentes de variación aleatoria más allá de las derivadas de la coherencia entre los ítems del test. Incluso sin utilizar otro diseño que el de consistencia interna, sería muy oportuno reconocer que no todas las puntuaciones de un mismo test tienen la misma fiabilidad, lo que conllevaría la publicación de datos de fiabilidad relativa como los que se pueden obtener utilizando la teoría de respuesta a los ítems. Con esta sugerencia nos sumamos de nuevo a las recomendaciones realizadas en anteriores revisiones (e.g., Gómez, 2019).

Aportaciones Novedosas de la Universidad al Proceso de Revisión de Test

En esta edición queremos sumarnos al agradecimiento que, año tras año, se hace de la colaboración de las casas editoriales ofreciendo su ayuda y su experiencia durante el proceso de evaluación de test y del apoyo de la Comisión de Test del COP durante todo el proceso. Con mayor motivo si cabe porque nuestro proyecto docente ha conllevado mayor apoyo económico y ajuste a los tiempos académicos por su parte. Queremos también reflexionar sobre el proceso de priorización de los test a evaluar a partir de tres datos. El primer dato es la lista ordenada de los 25 test más usados por las personas colegiadas según una encuesta reciente (Muñiz et al., 2020). El segundo dato es la lista de los 84 test con informes publicados en la página web del COP desde el año 2010. Al comparar ambas listas se observa que solo coinciden en 12 casos y no siempre se trata de los test más usados. El tercer dato es la lista de los 91 test que han valorado en este mismo periodo nuestros estudiantes en sus trabajos de curso con mayor o menor éxito, una lista accesible contactando con la autora de correspondencia. Son test seleccionados entre los disponibles en nuestra docimoteca que, por su parte, realiza las adquisiciones atendiendo a demandas del profesorado de la Facultad de Psicología. Más de una cuarta parte de estos 91 coinciden con los test evaluados por el COP, pero resulta interesante observar la presencia de nueve test que están también en la lista de los más utilizados que no cuentan con informe oficial publicado. Otro dato interesante es que uno de los test que está en la lista de los más utilizados y que no ha sido evaluado hasta ahora es un test no comercializado. Todo ello induce a pensar que, si se abriera la participación a nuevos colectivos con intereses en este proceso, probablemente se conseguiría mayor cobertura de las necesidades reales de información por parte de la profesión y, además, sería un nuevo paso en favor de la diversificación de las voces que participan en el proceso de revisión.

Respecto a la actuación de nuestro estudiantado, en la última columna de la Tabla 3 se presenta la comparativa de las puntuaciones promedio de la octava edición con las puntuaciones promedio del conjunto de las siete ediciones anteriores. Solo se incluyen las 10 características para las que ha sido posible obtener datos promedio en todas las revisiones disponibles. Aunque al observar dato por dato se encuentran algunas divergencias que se equilibran por ser unas al alza y otras a la baja, las dos series de datos tienen un mismo valor promedio de 3,9 puntos y el coeficiente de correlación entre ellas es de 0,90; es decir, se trata de evaluaciones globalmente muy comparables. Sea como fuere, no hay que perder de vista que las diferencias podrían atribuirse a quien evalúa, pero también a los test que se han sometido a evaluación en la presente edición.

Más informativa resulta la comparación de los informes de la Revisión 1 (especialista) con los de la Revisión 2 (estudiantes) sobre el mismo test. La mediana de los coeficientes de correlación entre las puntuaciones otorgadas por el Revisor 1 y el Revisor 2 en las preguntas en que todos los revisores dieron puntuaciones válidas a todos los test evaluados fue de 0,67, un valor moderado y muy similar al publicado por Ponsoda y Hontangas (2013) que fue de 0,61. De hecho, un valor como este o incluso menor sería de esperar en un proceso de revisión por pares en el que las discrepancias son consustanciales, tal como señalaron Fonseca-Pedrero y Muñiz (2017).

En las preguntas abiertas, los equipos de estudiantes ganadores escribieron textos mucho más largos (entre 2000 y 4400 palabras) que las personas profesionales (entre 800 y 3000 palabras). La lectura comparativa mostró que los textos del estudiantado pueden ser más argumentados, pero también más redundantes y más dependientes de la forma de presentación de la información utilizada en los libros de texto y en los manuales de los test. El profesorado atribuimos estos resultados a diversos motivos. Por una parte, puede ser que el estudiantado sienta la necesidad de escribir un apoyo teórico que le dé pie a expresar su opinión. Por otra, su formación previa está muy basada en la lectura de manuales educativos y de artículos científicos, por lo que podría resultarles difícil enfrentarse a textos desarrollados para la comercialización de un producto, aunque este tenga base científica. En cambio, las personas expertas tendrían más recursos para interpretar y valorar estos materiales. Otra explicación puede provenir de los comentarios del profesorado a los borradores, ya que en ellos se les pidió fundamentalmente que reconsiderasen las inconsistencias de sus valoraciones, que incorporasen información, y/o que desarrollasen más sus argumentos.

Relacionado con lo anterior, los equipos ganadores presentaron comentarios muy ajustados a las instrucciones y rúbricas del CET-R. Ello no es de extrañar porque, tal como hemos dicho, nuestras clases de psicometría están alineadas con ellas y las dudas del estudiantado al respecto se resolvieron gracias a la tutorización presencial. Con todo, las personas especialistas también han hecho comentarios en el sentido que algunas preguntas del CET-R son difíciles de contestar. Por ello, creemos que sería de gran ayuda que se implementara la propuesta de Fonseca-Pedrero y Muñiz (2017) de rebajar esta barrera facilitando más información técnica y desarrollando tutoriales sobre como rellenar el CET-R.

Todavía en el mismo orden de cosas, hemos detectado un amplio margen para seguir desarrollando lenguaje compartido tanto técnico como inclusivo. En cuanto al lenguaje técnico, nos alineamos con la opinión expresada en anteriores trabajos de que el CET-R es una buena guía para la construcción, la edición y el uso de los test (Elosua y Geisinger, 2016; Muñiz y Fonseca-Pedrero, 2019) y, por ello, sugerimos a las casas editoriales que al redactar los manuales se utilice en la medida de lo posible el lenguaje psicométrico tal como está expresado en el CET-R. Nada más lejos de nuestra intención que coartar la presentación de pruebas novedosas en apoyo de los usos de un test; antes al contrario, estas serían muy bienvenidas. Pero para la presentación de pruebas más clásicas, proponemos como referencia el lenguaje psicométrico del CET-R porque éste es una síntesis consensuada de algunos de los textos normativos más ampliamente aceptados como son los criterios de la EFPA, los estándares de la AERA y de la APA, de la International Test Commission y la norma ISO-10667 (Hernández et al., 2016) y también porque la homogeneización facilitaría enormemente el compartir el material con el resto de la profesión y, especialmente, con las personas principiantes. Y en relación con el uso de lenguaje inclusivo, por una parte, en los manuales de los test que hemos evaluado se utiliza ampliamente el masculino genérico para referirse a las personas y, por otra, en nuestra universidad se considera buena práctica valorar positivamente el uso de lenguaje inclusivo. Paradójicamente, nuestro estudiantado ha visto penalizada en sus escritos una práctica lingüística utilizada en los manuales que estaba evaluando. Creemos que es un buen momento para proponer a las casas editoriales que se sumen a dar ejemplo alineándose así con la política del Colegio Oficial de la Psicología en cuanto al uso de lenguaje inclusivo.

Finalmente, en la vertiente educativa, es de destacar que la asignatura ha tenido este curso una retención superior al 99% y un éxito del 93%, resultados dentro del rango de los obtenidos en los últimos cursos (UAB, n.d.-a) y que consideramos muy satisfactorios. Los pocos estudiantes que participaron en la encuesta de satisfacción reflejaron opiniones polarizadas. Entre las negativas destacó que el tiempo dedicado a elaborar el trabajo es mucho y compite con el tiempo dedicado a la explicación y asimilación de conceptos teóricos. Entre las positivas, predominó que el proyecto implica el fortalecimiento del aprendizaje conceptual mediante la aplicación real de la teoría y la aproximación al mundo profesional-laboral. Esta polarización se reflejó prácticamente en los mismos términos en las valoraciones del profesorado.

CONCLUSIONES Y RECOMENDACIONES

El primer objetivo de este trabajo ha sido valorar la calidad de 11 test sometidos a la octava edición de la evaluación de test en España aplicando el modelo de evaluación consensuado por la Comisión de Test del COP y reflejado en el cuestionario CET-R. Nuestras conclusiones han sido que en la documentación que acompaña a estos test se presentan datos más que adecuados en apoyo del desarrollo y adaptación del test así como sobre las muestras de tipificación. También se aportan excelentes datos relativos a la consistencia interna del test, pero debería incrementarse la presencia de otras pruebas de fiabilidad. Hemos detectado un mayor margen de mejora en cuanto a la aportación de pruebas en sustento de la validez del test para todos y cada uno de los usos propuestos. Nuestras propuestas de mejora son la asociación explícita de las pruebas de validez con cada uno de los usos propuestos, la especificación previa de las hipótesis que se pretende probar, el desarrollo de pruebas en favor de la equidad en el tratamiento de diversas personas evaluables, y el reporte de la metodología cualitativa basado en estándares actualizados.

Estas conclusiones tienen derivadas que afectan a la estructura y valoración de las preguntas del CET-R. En este sentido, recomendamos (a) incorporar una pregunta sobre los usos previstos del test en el apartado de descripción y estructurar la valoración de la validez en función de dichos usos, (b) dar dos opciones evaluativas para caracterizar la información faltante, que se calificaría o bien como No relevante o bien como Relevante, pero no se aporta información, (c) valorar de manera estructurada las evidencias de validez obtenidas con metodología cualitativa, considerando por separado el método y los resultados y (d) dar entidad a la aplicación equitativa de los test desarrollando de forma estructurada la valoración de los datos presentados sobre acomodaciones.

Nuestro segundo objetivo ha sido valorar la aportación novedosa de la universidad a dos aspectos del proceso de evaluación. En cuanto a los test que se someten a evaluación, nuestra conclusión ha sido que se podría ampliar la cobertura de las necesidades de información de la profesión si en el proceso de priorización se incorporara la opinión de otras entidades además de la Comisión de Test del COP. Por otra parte, hemos ofrecido datos sobre la ampliación de las voces representadas en la revisión ofreciendo esta oportunidad a estudiantes bajo la tutorización del profesorado. Nuestras conclusiones han sido que a nivel cuantitativo se ha mantenido una gran similitud con las ediciones anteriores y, a nivel narrativo, nuestros estudiantes han escrito textos más largos y más ajustados a las instrucciones del CET-R, aunque no siempre han proporcionado las argumentaciones más sólidas porque sus textos son muy dependientes del manual de la asignatura y de las valoraciones expresadas en la propia documentación que están evaluando. Ello nos ha llevado a destacar la conveniencia de profundizar en el desarrollo de lenguaje compartido entre los diferentes grupos con intereses en el uso de los test. En cuanto a la función educativa, concluimos que ha sido muy efectiva, puesto que nuestro estudiantado ha tenido éxito en la asignatura en un 93% de los casos, aunque también hemos observado opiniones polarizadas entre lo costoso y lo motivador del proyecto.

Nuestra conclusión sobre esta experiencia es que la incorporación de estudiantes bajo tutoría en el proceso de revisión de test ha resultado costosa en cuanto a los materiales y el tiempo necesarios para desarrollarla; variable en cuanto a su potencial motivador; y satisfactoria en relación con el éxito académico del estudiantado, la profesionalidad de los informes que han desarrollado, y las ideas que han aportado para desarrollar manuales de test que resulten cómodos para profesionales principiantes.

AGRADECIMIENTOS

Agradecemos a la Dra. Laura Gómez y al Prof. Dr. José Muñiz su apoyo a lo largo de todo el proceso. A las casas editoriales, la aportación de seis ejemplares de cada test, a la Facultad de Psicología y a la Biblioteca de Humanidades de la UAB, la compra de los ejemplares faltantes hasta completar el material necesario para cubrir todos los grupos de clase. Al Espai de Suport i Innovació Docent de la Facultad de Psicología de la UAB su apoyo en la gestión del acceso a los materiales. A Remei Prat, Elena Ripollés, Salomé Tàrrega y Joan Pons su contribución al desarrollo del proyecto formando parte del equipo docente en cursos anteriores.