Mi SciELO

Servicios Personalizados

Revista

Articulo

Indicadores

-

Citado por SciELO

Citado por SciELO -

Accesos

Accesos

Links relacionados

-

Citado por Google

Citado por Google -

Similares en

SciELO

Similares en

SciELO -

Similares en Google

Similares en Google

Compartir

Educación Médica

versión impresa ISSN 1575-1813

Educ. méd. vol.11 no.4 dic. 2008

Evaluación de competencias médicas en un currículo de grado no diseñado por competencias

Assessment of medical competences in an undergraduate curriculum not designed for developing competences

A.M. Reta-De Rosas, M.J. López, A.L. Vargas, M.C. Montbrun

Facultad de Ciencias Médicas. Universidad Nacional de Cuyo. Mendoza, Argentina.

Dirección para correspondencia

RESUMEN

Introducción. En 2005 se definieron y difundieron seis competencias con 27 componentes para la carrera de medicina.

Objetivos. Evaluar los instrumentos de evaluación de los aprendizajes que se utilizan durante la carrera, formar docentes en la elaboración y uso de instrumentos adecuados, válidos y fiables con el fin de evaluar competencias médicas, y formular criterios generales para la evaluación de los aprendizajes.

Materiales y métodos. Se trabajó sobre una muestra de 17 asignaturas, pertenecientes a cuatro grupos. Se recogieron muestras de sus instrumentos de evaluación, que se analizaron según su validez, fiabilidad y capacidad de evaluar competencias médicas, en un estudio descriptivo y cuali-cuantitativo. Varios instrumentos de evaluación de las asignaturas no resultaron válidos ni fiables. Pocos evaluaban las competencias médicas. Se devolvieron resultados y se trabajó en la capacitación de docentes de cuatro de esas asignaturas, cuyos sistemas de evaluación mejoraron considerablemente. Se elaboraron cinco criterios generales para el diseño de sistemas de evaluación de competencias médicas válidos y fiables.

Resultados y conclusiones. a) Muchos de los instrumentos de evaluación del aprendizaje que se utilizan en la carrera no son válidos ni fiables; b) son pocas las competencias médicas definidas para la carrera que se evalúan en las rotaciones clínicas, aun cuando gran cantidad de docentes participaron de su formulación; c) capacitando al personal docente se logra que produzcan instrumentos de evaluación válidos, fiables y orientados a evaluar las competencias médicas; d) la facultad deberá esforzarse en desarrollar programas de capacitación docente.

Palabras clave. Competencias médicas de grado. Evaluación. Mejoramiento. Validez y fiabilidad.

ABSTRACT

Introduction. Six medical competences with 27 components were defined for the undergraduate medical program in 2005.

Aims. To evaluate the learning assessment tools that are used through the program, to develop faculty for working out and using reliable and valid assessment tools, in order to control medical competences, and to formulate learning assessment criteria.

Materials and methods. In a descriptive, quali-quantitative study, a sample of 17 modules, belonging to four different groups of courses was chosen. Samples of different evaluation tools of those modules were collected and analyzed in terms of validity, reliability and capability to evaluate medical competences. After given back the data to faculty and developed a training program for four modules’ teaching teams, their assessment system considerably improved. Five general criteria were developed to design a valid and reliable system of medical competences assessment.

Results and conclusions. a) Many of the learning assessment tools that are used in the program are nor valid neither reliable, particularly those used in clerkships; b) even though many faculty members were part of the medical competences drafting process, a few competences’ compounds are effectively assessed; c) training faculty is enough to have them build up valid, reliable and competence oriented assessment tools; d) the Medical School should set up faculty development programs.

Key words. Assessment. Improvement. Undergraduate medical com-petences. Validity and reliability.

Introducción

Las actuales demandas de la sociedad en la formación de sus profesionales intentan satisfacerse mediante el paradigma de la educación basada en competencias, que define los resultados que los estudiantes deben demostrar al finalizar su formación. En el área de la educación médica se está trabajando este paradigma desde hace muchos años [1,2]. Numerosas escuelas médicas del mundo han definido ya las competencias médicas que guiarán la capacitación profesional de sus egresados [3-6].

Además, ya existen propuestas para cambiar el enfoque de la actual evaluación para la acreditación de carreras de medicina, en el sentido de evaluar no sólo la fortaleza de las instituciones y los planes de estudio de las carreras que debe acreditar, sino también las competencias profesionales de los egresados de dichas carreras [7]. Sin embargo, se ha publicado muy poco respecto de los sistemas de evaluación implementados para verificar la existencia de dichas competencias. Algunas publicaciones informan de la evaluación final de las mismas en el momento del egreso. Sólo se ha encontrado una que da cuenta de la evaluación que se realiza durante la carrera, aunque no especifica instrumentos [3]. En cambio, hay abundantes publicaciones sobre la evaluación de los aprendizajes en educación médica [8-18].

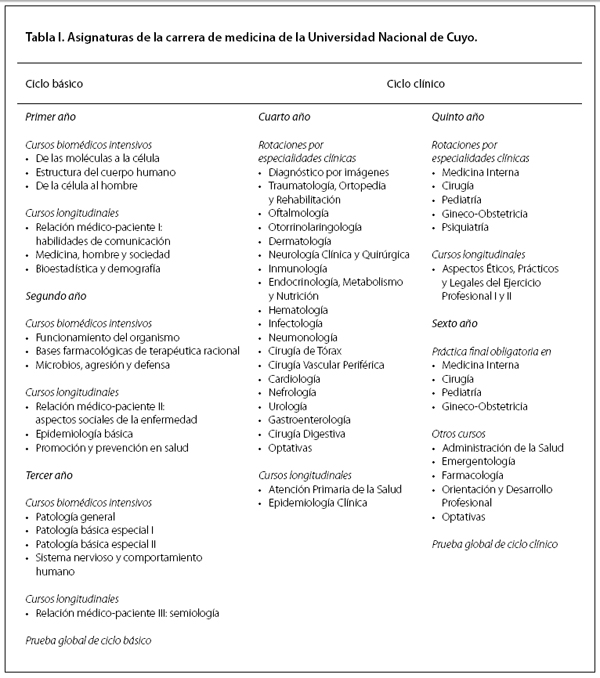

La carrera de medicina de grado de la Facultad de Ciencias Médicas de la Universidad Nacional de Cuyo tiene un currículo de seis años de duración, orientado a la formación de un médico general, capaz de resolver los problemas de salud prevalentes en atención ambulatoria, derivar en el caso de problemáticas que corresponden a especialidades y brindar los primeros cuidados en la emergencia. Para lograr este perfil, la oferta académica cuenta con dos ciclos de formación, básico y clínico, en los que se distribuyen diferentes tipos de asignaturas:

•Cursos biomédicos intensivos integrados por contenidos de ciencias básicas con ingredientes de clínicas.

•Cursos longitudinales sobre las dimensiones éticas, psicológicas y sociales de la salud.

•Rotaciones por especialidades clínicas con predominio de práctica clínica real.

•Pruebas globales de fin de ciclo (Tabla I).

El estudiante debe aprobar el examen final de cada asignatura y todas las asignaturas de cada año para promoverse al siguiente. Estos exámenes pueden ser orales, escritos o de desempeño, en función de la decisión del responsable de cada asignatura.

Este currículo no fue diseñado siguiendo un modelo de competencias. En 2006, el grupo de investigación que realizó el presente trabajo, a partir de un proceso que involucró la participación de buena parte del cuerpo docente de la carrera, identificó, definió y difundió las competencias al egreso de la carrera de grado de medicina, así como las estrategias generales para su evaluación [19]. Las competencias seleccionadas fueron: habilidades clínicas, conocimiento médico, habilidades de comunicación, actualización y desarrollo profesional y personal, aspectos éticos y legales de la profesión y sistema de salud y contexto social. Cada una de ellas reúne un número variable de componentes.

La formulación de las competencias profesionales y sus respectivos componentes, a partir del trabajo citado, configuró una visión más integral del perfil del futuro médico y proveyó de una idea más clara respecto de las necesidades de la evaluación del aprendizaje.

¿Cuánto se alejarían los instrumentos de evaluación que se utilizan en el currículo actual de los pertinentes para evaluar esas competencias que se acababan de definir? ¿En qué medida esos instrumentos eran de calidad suficiente (válidos y fiables)?

Una investigación sistemática de los instrumentos utilizados y la interacción con los docentes a cargo podían arrojar luz sobre el sistema de evaluación y cómo encaminarlo hacia la verificación de las competencias médicas y sus componentes. Estos datos permitirían en un futuro próximo tener un diagnóstico claro de qué y cómo se evalúa, así como reorientar la enseñanza en consecuencia.

Por tanto, se plantearon los siguientes objetivos:

•Evaluar los instrumentos de evaluación de los aprendizajes que se utilizan durante la carrera de medicina.

•Formar docentes de la carrera de medicina en la elaboración y uso de instrumentos de evaluación adecuados, válidos y fiables, para verificar el logro de competencias médicas por parte de los alumnos.

•Formular criterios generales para la evaluación de los aprendizajes, de modo que la misma se encamine a verificar la existencia de las competencias médicas o algunos de sus componentes.

Materiales y métodos

Muestra en estudio

Se realizó una selección de asignaturas dentro de los cuatro tipos de exigencias que tienen que cumplir los estudiantes para graduarse. Se utilizó como criterio que fueran representativas de las características de cada grupo, por los instrumentos de evaluación que utilizan. Se eligieron seis cursos biomédicos intensivos, tres cursos longitudinales, seis rotaciones por especialidades clínicas y las dos pruebas globales (Tabla II).

Según la normativa del plan de estudios, las asignaturas del currículo de medicina deberían evaluar el aprendizaje de los estudiantes a través de una evaluación formativa o continua y con un examen final, al terminar el cursado. Para esta experiencia, se recolectó material de evaluaciones del aprendizaje realizadas en cada una de las 17 asignaturas en estudio: material impreso en los casos de exámenes finales escritos y listas de cotejo para la evaluación continua, así como grabaciones en los casos de exámenes finales orales –con o sin pacientes– que después fueron transcritos a papel. Se clasificaron los instrumentos de evaluación obtenidos, en función de si correspondían a una evaluación continua o eran exámenes finales (escritos, orales y/o de desempeño). Todo este material fue volcado a formularios descriptivos, en que se consignaron los temas evaluados, la cantidad, la calidad y el tipo de preguntas sobre cada uno, así como la duración del examen. Asimismo, se solicitó al responsable de cada asignatura, mediante entrevista, un detalle del sistema de evaluación del aprendizaje utilizado en la misma. Los formularios descriptivos de los exámenes, así como la información obtenida de las entrevistas, fueron la base para el análisis cualitativo de los instrumentos de evaluación utilizados por las asignaturas, a la luz de los criterios de valoración que se exponen a continuación. Se elaboró una tabla con los resultados de la aplicación de dichos criterios a los instrumentos de evaluación de las 17 asignaturas en estudio.

Criterios de valoración

De acuerdo con la bibliografía sobre el tema, se seleccionaron los siguientes criterios para evaluar los instrumentos recogidos:

Validez

Un instrumento de evaluación es válido cuando efectivamente evalúa lo que se pretende determinar. Se establecieron distintos tipos:

•Validez de contenido: el instrumento debe incluir una muestra representativa de los conocimientos y habilidades que ha de tener el alumno.

•Validez de significado: el instrumento debe evaluar lo enseñado.

•Validez de retroacción: el instrumento debe producir alguna retroalimentación sobre la enseñanza y el aprendizaje.

•Validez de construcción: el instrumento debe ser coherente con la teoría de enseñanza-aprendizaje que sustenta el currículo.

•Validez manifiesta: es la que surge de la percepción que el público tiene de que la prueba es adecuada.

Fiabilidad

Un instrumento de evaluación es fiable cuando es estable, es decir, no registra variabilidad en cada una de sus aplicaciones, sino que siempre se comporta de la misma manera. La fiabilidad no depende tanto de que los instrumentos sean estandarizados o estructurados, sino más bien de que haya una buena muestra del contenido y de la estabilidad de la situación –pacientes y evaluadores– [20]. La fiabilidad de una prueba puede medirse a partir de los resultados de su aplicación, utilizando el a de Cronbach.

Dado el interés del trabajo respecto de la validez y fiabilidad de los instrumentos para evaluar las competencias médicas, se realizó también un análisis pormenorizado de los componentes de dichas competencias que cada instrumento estudiado era capaz de evaluar.

Devolución de la información y capacitación docente

Se organizó la devolución de los resultados a los responsables de las 17 asignaturas que conformaron la muestra en estudio con los datos obtenidos sobre los sistemas de evaluación del aprendizaje y los instrumentos utilizados por cada una de dichas asignaturas.

Además, de acuerdo con los resultados obtenidos, se seleccionaron cuatro casos de la muestra estudiada, que serían objeto de intervención para mejorar su sistema de evaluación, entre aquellos equipos docentes que manifestaron voluntad expresa de recibir una capacitación: dos pertenecientes al grupo 2 (cursos longitudinales con formación clínica y/o humanística) y dos del grupo 3 (rotaciones por especialidades del ciclo clínico).

La oferta de capacitación docente se diseñó a medida de cada grupo de docentes, según las características del sistema de evaluación de cada asignatura.

Nuevos resultados

Finalmente, se recopiló la información sobre los cambios que se habían producido después del proceso de capacitación en los sistemas de evaluación y en los instrumentos utilizados. Se analizó la validez y fiabilidad de los nuevos instrumentos y su utilidad para evaluar las competencias médicas.

Resultados y discusión

Análisis de instrumentos y sistemas de evaluación

Los resultados de la aplicación de los criterios de valoración a los instrumentos habitualmente utilizados en las 17 asignaturas de la muestra aparecen en la tabla III. En ésta puede visualizarse fácilmente que no todos los instrumentos de evaluación del aprendizaje, utilizados en los cursos, rotaciones clínicas y pruebas globales de la carrera de medicina cumplen con los criterios de validez y fiabilidad requeridos.

Los instrumentos de evaluación utilizados por los cursos biomédicos del ciclo básico (grupo 1) –tanto para la evaluación continua como para la final– sí cumplían con los criterios de validez y fiabilidad. Por tanto, estas asignaturas no fueron seleccionadas para el proceso de capacitación.

En cambio, la evaluación de dos de los cursos longitudinales (grupo 2) –aquéllos que utilizan examen final oral y de desempeño– no poseían validez de contenido ni fiabilidad, pues el contenido no era representativo del programa de la asignatura y la situación de evaluación no presentaba estabilidad de evaluadores y pacientes. Se seleccionaron estos dos cursos para la etapa de capacitación docente.

Las rotaciones por especialidades del ciclo clínico (grupo 3) cumplen en pequeña medida con los criterios establecidos, salvo una de las asignaturas que cumple con los dos y es la única que realiza la evaluación de proceso y en el examen final incluye, además de la teoría, un examen de desempeño. Los instrumentos utilizados por las cinco restantes tienen escasa validez y, pocos, fiabilidad. Se eligieron dos de estas cinco asignaturas para el proceso de capacitación docente, aquéllas en que sus responsables y equipos docentes estaban dispuestos a recibirla.

Las pruebas globales (grupo 4) son válidas y fiables, en cuanto tienen una elaboración cuidada para que el contenido de las mismas sea representativo de los ciclos básico y clínico que éstas evalúan. Su índice de fiabilidad ha sido siempre superior al 0,85, medido por el a de Cronbach.

Dado el interés del trabajo respecto de la utilidad de los instrumentos para evaluar competencias médicas, en la tabla IV se registra el análisis pormenorizado de los componentes de dichas competencias, que cada sistema de evaluación estudiado es capaz de evaluar. Se consignan los datos brutos.

Como se esperaba, son muy pocos los componentes de las competencias médicas evaluados por las asignaturas del grupo 1. Sería interesante investigar en el futuro en qué medida esos cursos biomédicos del ciclo básico pueden incluir, en sus sistemas de evaluación, la verificación de al menos un germen de los componentes de las competencias médicas.

El grupo 2, dada su naturaleza y ubicación en el currículo, evalúa –según juicio del equipo de trabajo– suficiente cantidad de componentes de las competencias médicas.

Llama la atención que sólo una de las rotaciones por especialidades del ciclo clínico (grupo 3) evalúe cinco componentes de la competencia ‘Habilidades clínicas’, cuando supuestamente las clínicas deben enseñar y evaluar dichas habilidades. Ésa es, indudablemente, la rotación clínica con mejor sistema de evaluación de entre las estudiadas. En el grupo 4, la prueba global de ciclo básico evalúa pocos componentes de las competencias. En cambio, la prueba global de ciclo clínico evalúa más componentes, en especial todos los componentes de las ‘Habilidades clínicas’.

Si se toma el conjunto de las 17 asignaturas estudiadas, los porcentajes de esas asignaturas que evalúan una cantidad determinada de componentes de cada competencia médica aparecen en la tabla V.

Sin lugar a dudas, la competencia mejor evaluada en todos los sistemas de evaluación analizados es ‘Conocimiento médico’, pues el 76,5% de los cursos y las rotaciones de la muestra evalúan sus dos componentes y el resto, al menos uno. También es de destacar positivamente el hecho de que el 76,5% de las asignaturas evalúan al menos uno de los componentes de la competencia ‘Sistema de salud y contexto social’.

En cambio, aparece como negativo el hecho de que el 76,5% de asignaturas de una muestra representativa de la carrera no evalúe ningún componente de las ‘Habilidades clínicas’ –aunque sólo seis (35,3%) pertenecen a ciencias básicas–; que el 70,6% no verifique ningún componente de las ‘Habilidades de comunicación’ y que el 47,1% no controle ningún componente de la competencia ‘Aspectos éticos y legales de la profesión’, todas competencias esenciales para la profesión médica.

Capacitación docente y cambios en los sistemas de evaluación

A partir de los resultados obtenidos, se ofreció y realizó una capacitación de los equipos docentes de cuatro de las asignaturas estudiadas para producir cambios en sus sistemas de evaluación. A modo de ejemplo, se consigna el producto obtenido a partir de esa intervención en una asignatura del grupo 2. Se agregó al examen final de ese curso, que hasta ahora utilizaba sólo el clásico examen oral con el paciente, un examen clínico objetivo estructurado de varias estaciones, con pacientes estandarizados, con el fin de aumentar la validez y fiabilidad de la prueba. Se programaron y aplicaron los tres exámenes del año completo de ese curso. Los resultados de este examen estructurado formaron parte de la calificación final del alumno como un 30% de la misma. Con esta modificación se aumentó en gran medida la validez y fiabilidad del examen final.

Los resultados de los cambios producidos en los sistemas de evaluación de las cuatro asignaturas, después de la capacitación docente, se transcriben en las tablas VI y VII (durante el desarrollo del trabajo se asignó un número correlativo a cada una de las 17 asignaturas para evitar identificarlas por su nombre. En las tablas VI y VII se hace referencia a las asignaturas seleccionadas para intervención con los números que originalmente se les había asignado).

A partir del proceso de capacitación y rediseño de los sistemas e instrumentos de evaluación, se puede verificar que: la asignatura n.° 8 (grupo 2) ha mejorado la validez de contenido y la fiabilidad de sus instrumentos de evaluación. La asignatura n.° 9 (grupo 2) ha mejorado dos tipos de validez (contenido y retroacción), así como la fiabilidad de sus instrumentos de evaluación. La asignatura n.° 14 (grupo 3) mejoró la validez de construcción y retroacción de su examen final, así como su fiabilidad. La asignatura n.° 15 (grupo 3), dispuesta a un largo proceso de capacitación docente, ha mejorado no sólo la validez de contenido, de retroacción, de construcción y manifiesta, sino también la fiabilidad de su sistema de evaluación y la metodología de enseñanza-aprendizaje.

Asimismo, a partir de las modificaciones introducidas en estas asignaturas, se ha observado que el curso n.° 8 no ha aumentado la cantidad de componentes de las competencias médicas que evalúa, pues estaba bien orientado en ese sentido antes de la experiencia. En cambio, el curso n.° 9 y, sobre todo, las asignaturas n.º 14 y 15 del grupo 3 han aumentado considerablemente el número de componentes de las competencias que ahora evalúan.

Criterios generales que deberían reunir el sistema y los instrumentos de evaluación del aprendizaje de la carrera de medicina

Finalmente, y a partir del estudio realizado, se discutieron las características que debería reunir el sistema y los instrumentos de evaluación de los aprendizajes de la carrera en función de verificar, válida y fiablemente, la existencia de las competencias médicas establecidas para el perfil profesional. A través de este análisis, se llegó a algunos criterios generales:

Criterio n.° 1: garantizar validez y fiabilidad de los instrumentos de evaluación del aprendizaje que se utilizan

Según el diagnóstico realizado, la mayoría de los instrumentos y sistemas de evaluación de las rotaciones clínicas (grupo 3) carece de validez de contenido y de fiabilidad, debido a que se reduce al examen final de la asignatura, que en casi todos los casos es oral y cubre muy pocos temas como para ser representativo del contenido de la misma. Esto se solucionaría fácilmente con la introducción de exámenes escritos que representen todos los temas de la asignatura, pero siempre que se advierta que sólo se evaluará ‘conocimiento médico’.

Criterio n.° 2: orientar la evaluación hacia todas las competencias, en vez de sólo al conocimiento

Se ha visto que, en la gran mayoría de las asignaturas de la carrera, los instrumentos de evaluación están orientados a evaluar ‘conocimiento médico’. Las asignaturas del grupo 1 (cursos biomédicos) deberían evaluar otras competencias –aunque sea en un nivel inicial– como, por ejemplo, las ‘habilidades de comunicación’. En cambio, las asignaturas del grupo 3 (rotaciones clínicas) deben evaluar todas las competencias médicas, más allá del conocimiento y fundamentalmente las ‘habilidades clínicas’, para lo cual deben utilizar otros instrumentos de evaluación que los actuales y articularlos en un sistema.

Criterio n.° 3: utilizar pruebas de desempeño, como instrumento indispensable

Sin desterrar el uso de instrumentos verbales de evaluación (orales o escritos), debe considerarse como indispensable la utilización de pruebas de desempeño. En todas las asignaturas –incluso las biomédicas del grupo 1– debería observarse el desempeño del estudiante en ‘habilidades de comunicación’, en ‘aspectos éticos’, etc. Pero, en especial en las rotaciones clínicas, se deben incluir pruebas de desempeño para garantizar la evaluación de los componentes que describen las competencias médicas, particularmente los de las ‘habilidades clínicas’. En exámenes teóricos, de ningún modo se puede inferir el desempeño que tendrá el futuro médico en situaciones reales de trabajo y sus competencias en las tareas propias de la profesión.

Criterio n.° 4: verificar el aprendizaje de cada alumno en múltiples y variadas situaciones

Si bien las asignaturas –en especial las rotaciones clínicas– deben incorporar instrumentos de evaluación del aprendizaje de todas las competencias médicas, deben cuidar la validez y fiabilidad de estos instrumentos que utilicen. En efecto, competencias como las ‘habilidades clínicas’ o las ‘habilidades de comunicación’ sólo pueden verificarse a través de la observación del desempeño del alumno con pacientes, sus familias u otros integrantes del equipo de salud. Pero la observación de una única situación de desempeño no garantiza validez ni fiabilidad. Si se incorporara al examen final el desempeño del estudiante con un paciente, al estilo del clásico examen clínico, no podría inferirse su futuro desempeño en situaciones distintas, dada la especificidad del contenido en la capacidad de solucionar problemas. Por ello, los componentes de las competencias médicas deben observarse en muchas situaciones distintas, que permitan predecir cómo se comportará el estudiante como futuro médico.

Criterio n.° 5: realizar la evaluación de proceso, previa al examen final

La cantidad y variedad de situaciones en que un alumno debe ser evaluado en su desempeño implica la necesidad de una evaluación de proceso, previa al examen final, ya que en él sólo puede controlarse la actividad del alumno en una situación única –si se trata de un examen clínico tradicional con un paciente– o el conocimiento teórico adquirido. El desempeño del estudiante con pacientes que presentan diversas patologías y situaciones personales –observado por los docentes durante las rotaciones clínicas– debería incluirse en la calificación final del alumno, como modo de garantizar mayor fiabilidad y validez de contenido a la evaluación del aprendizaje. Además, si esa observación se transforma en evaluación de proceso, en el sentido de dar retroalimentación al estudiante sobre su desempeño, contribuye también a su mejor aprendizaje.

En conclusión:

•Buena parte de los instrumentos de evaluación del aprendizaje que se utilizan en la carrera de medicina no son válidos ni fiables, especialmente los que se utilizan en el grupo de asignaturas que son rotaciones clínicas.

•Son pocos los componentes de las competencias médicas definidas para la carrera que efectivamente se evalúan en el sistema de evaluación de cada asignatura, aún cuando gran cantidad de docentes participaron de su formulación.

•Capacitando al personal docente se logra que produzcan instrumentos de evaluación válidos, fiables y orientados a evaluar las competencias médicas.

•La universidad deberá esforzarse en desarrollar programas de capacitación docente.

Bibliografía

1. Harden RM, Crosby JR, Davis MH. An introduction to outcome-based education. Med Teach 1999; 21: 125-6. [ Links ]

2. Carraccio C, Wolfsthal S, Englander R, Ferentz K, Martin C. Shifting paradigms: from flexner to competencies. Acad Med 2002; 77: 361-7. [ Links ]

3. Smith SR, Dollase R. Planning, implementing and evaluating a competency-based curriculum, Med Teach 1999; 21: 15-22. [ Links ]

4. The Scottish Deans’ Medical Curriculum Group. The Scottish doctor-learning outcomes for the medical undergraduate in Scotland: a foundation for competent and reflective practitioners. Med Teach 2002; 24: 136-43. [ Links ]

5. Schwarz MR, Wojtczak A. Global minimum essential requirements: a road towards competence-oriented medical education. Med Teach 2002; 24: 125-9. [ Links ]

6. Palés J, Cardellach F, Estrach MT, Gomar C, Gual A, Pons F, et al. Defining the learning outcomes of graduates from the medical school at the University of Barcelona (Catalonia, Spain).Med Teach 2004; 26: 239-43. [ Links ]

7. ACGME Outcome project. URL: http://www.acgme.org/outcome/project/glossary2.asp. [21.07.2003]. [ Links ]

8. Harden RM, Gleeson FA. Assessment of medical competence using an objective structured clinical examination (OSCE). Edinburgh: ASME Medical Education; 1979. [ Links ]

9. Cusimano MD. Standard setting in medical education. Acad Med 1996; 71 Suppl): S112-20. [ Links ]

10. Stone S, Qualters D. Course-based assessment: implementing outcome assessment in medical education. Acad Med 1998; 73: 397-401. [ Links ]

11. Ladyshewsky R. Simulated patients and assessment. The literature on simulated patients suggests that they are a valid and reliable tool that can be used with confidence for the evaluation of clinical competence. Med Teach 1999; 21: 266-9. [ Links ]

12. Friedman Ben-David M. Assessment in outcome-based education. Med Teach 1999; 21: 23-5. [ Links ]

13. Friedman Ben-David M. Standard setting in student assessment. Guide No. 18. Med Teach 2000; 22: 120-30. [ Links ]

14. Troncon LEA, Dantas RO, Figueiredo JFC, Ferriolli E, Moriguti JC, Martinelli ALC, et al. A standardized, structured long-case examination of clinical competence of senior medical students. Med Teach 2000; 22: 380-5. [ Links ]

15. Lynch DC, Surdyck PM, Eiser AR. Assessing professionalism: a review of the literature. Med Teach 2004; 26: 366-74. [ Links ]

16. Norcini J, Blank L, et al. Mini-Cex: a method to assess clinical skills. Ann Intern Med 2003; 138: 476-81. [ Links ]

17. Reta-De Rosas AM, Bordín C, Carrasco N, Gago F E, López-Vernengo CA, Odoriz B, et al. The first experience of a global clinical examination at the National University of Cuyo Medical School. JIAMSE 2005; 15: 60-4. [ Links ]

18. Case SM, Swanson DB. Cómo elaborar preguntas para evaluaciones escritas en el área de ciencias básicas y clínicas. Filadelfia: National Board of Medical Examiners; 2006. [ Links ]

19. Reta-De Rosas AM, López MJ, Montbrun MC, Ortiz A, Vargas AL. Competencias médicas y su evaluación al egreso de la carrera de medicina de la Universidad Nacional de Cuyo (Argentina). Educ Med 2006; 9: 75-83. [ Links ]

20. Van der Vleuten C, Schuwirth LWT. Assessing professional competence: from methods to programmes. Med Educ 2005; 39: 309-17. [ Links ]

![]() Dirección para correspondencia:

Dirección para correspondencia:

Dra. Ana M. Reta de Rosas.

Facultad de Ciencias Médicas. Universidad Nacional de Cuyo.

Parque Gral. San Martín. Ciudad Universitaria. Mendoza 5500, Argentina.

Fax 54-261-4494047

E-mail amreta@fcm.uncu.edu.ar