Mi SciELO

Servicios Personalizados

Revista

Articulo

Indicadores

-

Citado por SciELO

Citado por SciELO -

Accesos

Accesos

Links relacionados

-

Citado por Google

Citado por Google -

Similares en

SciELO

Similares en

SciELO -

Similares en Google

Similares en Google

Compartir

Educación Médica

versión impresa ISSN 1575-1813

Educ. méd. vol.15 no.3 sep. 2012

¿Cómo podemos evaluar la formación de nuestros residentes?

How can we evaluate the training of our house officers?

Antonio M. González

Servicio de Anestesiología y Reanimación. Hospital Universitario Marqués de Valdecilla. Santander, Cantabria, España

Artículo realizado a partir de una ponencia presentada en la 56.a Reunión Anual de la AAEAR, en la mesa de debate sobre 'La formación especializada y la formación continuada'.

Dirección para correspondencia

Cuando realizamos planteamientos tan ambiciosos como el propuesto en el título, nos encontramos con una importante disociación entre la teoría sobre metodología docente, aplicada a la formación médica especializada [1-3], y la realidad en que nos desenvolvemos los tutores de residentes, quienes nos caracterizamos por una pobre formación docente, una limitada disponibilidad temporal y un escaso o nulo presupuesto.

A estas alturas, todos conocemos ya el marco legal que el Real Decreto 183/2008 [4] estableció en relación a la evaluación del residente [5] y el emplazamiento al desarrollo autonómico posterior de la norma, que debería haberse concluido en el año siguiente a su publicación.

En realidad, salvo tres comunidades autónomas, no ha habido desarrollo posterior del Real Decreto ni por las comunidades ni por el propio Gobierno, que estaba encargado de proveer instrumentos para la evaluación, como el 'libro del residente', supuestamente diseñado por cada Comisión Nacional en su formato básico, y que era el eje de la evaluación formativa, ya que debía dar soporte a la actividad del residente y a las entrevistas periódicas del tutor-residente.

Por otro lado, la evaluación sumativa, tanto anual como final, se basan fundamentalmente en el registro impuesto por la Orden de 22 de junio de 1995, de contenido común para todas las especialidades y centros. Esta ficha es el núcleo principal de los informes de evaluación de las rotaciones intra y extradepartamentales, que acaban siendo elevados al Comité de Evaluación y, finalmente, al Ministerio.

En teoría de nuevo, en el supuesto de evaluación positiva, la Comisión Nacional realizaría una prueba al residente que lo solicitase, para optar a las calificaciones de 'destacado' y 'destacado con mención' especial de la CNE. La realidad es que ni el Ministerio de Sanidad y Consumo ni la CNRH del Sistema Nacional de Salud han determinado las directrices básicas que deben contener dichas evaluaciones, y su plazo expiró en la promoción 2009-2010.

Con esta realidad hay que trabajar; así que, en ausencia de instrumentos, el propio Real Decreto 183/2008 facilita a los tutores la capacidad de adecuación de 'instrumentos que permitan una valoración objetiva del progreso competencial del residente según los objetivos del programa formativo' (art. 17.2b), de modo que podemos intentar adecuar o proponer instrumentos de evaluación para rellenar esta laguna. Con esta consideración, esta colaboración tratará de adecuarse a la realidad y exponer, a través de nuestra humilde experiencia, algunas herramientas que pueden utilizarse en este proceso y nuestras reflexiones para avanzar en éste.

Para acometerlo, es preciso definir previamente toda una serie de elementos para su consecución. Necesitamos definir qué queremos evaluar y por qué precisamos esta evaluación, ya que son dos de los elementos condicionantes del resultado. Cualquier evaluación debe adecuarse al propósito y basarse en un contenido definido.

Igualmente resulta preciso responder a cómo se realiza, cuándo y por quién, lo que implica determinar las competencias profesionales que se desean medir, combinar diferentes métodos para evaluar las diversas capacidades y definir el cuándo para tener información precisa sobre el proceso de aprendizaje y poder tomar decisiones sobre el progreso si se precisaran.

En nuestro caso, iniciamos este proceso a través de la planificación docente [6] para responder a la primera cuestión, el qué. Consideramos que el cambio en la concepción de la salud impone que nuestra sistemática de 'aprender haciendo' no era ya admisible, sino que se requieren programas específicos de capacitación que faculten a los residentes a iniciarse en el dominio de la especialidad, cualquiera que sea, de modo que el paciente no resulte perjudicado en su derecho a la salud.

El proceso de formación de residentes no debe dirigirse solamente al desarrollo de capacidades psicomotoras o habilidades prácticas, sino que es preciso profundizar en la adquisición de capacidades intelectuales o conocimientos y en la adquisición de condiciones afectivas o actitudes. El concepto de 'aprender haciendo', además, induce una ocupación sistemática del residente, en nuestro caso en el quirófano, sin considerar el resto de elementos del proceso formativo. Esta realidad debe redirigirse, de modo que se contemple con igual trascendencia el tiempo dedicado a las distintas sesiones, donde se facilita la adquisición de capacidades intelectuales o conocimientos, y a las sesiones de simulación y talleres prácticos, donde podemos incidir fundamentalmente en las habilidades y las actitudes, al tiempo que consolidamos los conocimientos.

Considerando que el periodo de residencia es un proceso de autoformación tutorizada, procedimos a racionalizar la distribución de los rotatorios del programa, conforme a criterios docentes, facilitando los contenidos mínimos de cada periodo de rotación, para que el residente pueda dirigir su estudio de una forma ordenada y sistematizada. Para cada programa de rotación establecimos unos objetivos precisos, tanto en el dominio del conocimiento como de las habilidades y actitudes, de modo que en todo momento puedan establecerse las prioridades en el proceso de formación.

Añadimos dos nuevos elementos al programa docente: por un lado, la 'Guía del residente de Anestesiología', un documento entregado al ingreso en nuestro servicio, en el que se expone el programa formativo completo de la especialidad, los programas complementarios docentes, las bases bibliográficas, las herramientas docentes y el reglamento interno; por otro, un curso de inmersión en Anestesiología para residentes de primer año (R1), de carácter teórico-práctico, de dos semanas de duración, que facilitase la incorporación del residente a una especialidad que, salvo contadas excepciones, no se imparte en el currículo de pregrado.

Incorporamos también un programa docente complementario, en forma de seminarios que profundicen en la incorporación de los conocimientos de la nueva especialidad, estructurados en función del nivel de la especialidad (R1/R2 y R3/R4) y que respondían a diversas modalidades: bibliográficos, casos clínicos... También introdujimos la metodología de la simulación en el proceso docente a través de talleres específicos con simuladores de pantalla o simuladores a escala real.

Como en tantos otros aspectos, si no sabemos a dónde queremos llegar difícilmente podremos saber si hemos llegado. En este sentido es fácil entender que la planificación docente, la adecuación de los programas formativos a tus realidades objetivas y la determinación de unos objetivos de aprendizaje son los cimientos de cualquier sistema de evaluación. Sin objetivos no hay evaluación.

En función de la finalidad (por qué) podemos diferenciar una evaluación de carácter formativo o sumativo, en cuyo caso el cómo difiere notablemente.

En el primer caso, la evaluación formativa, el objetivo es valorar el progreso del proceso de aprendizaje, identificar déficits o áreas de mejora e introducir medidas correctoras, por lo que las características del instrumento de evaluación no tienen que ser muy precisas, sino que interesa un instrumento que proporcione una visión continuada del proceso y sea capaz de ofrecer elementos para un feedback constructivo sobre la progresión del residente.

Ahora bien, cuando la finalidad es sumativa -esto es, cuando precisamos acreditar, calificar o certificar al residente-, entonces las características del instrumento de evaluación son diferentes y precisa más requisitos técnicos en cuanto a validez (mide lo que realmente pretende medir), fiabilidad (precisión de la medida), reproducibilidad (constancia en los resultados), practicabilidad, aceptabilidad, impacto educativo y eficiencia [7], de ahí la importancia de la psicometría de las herramientas de evaluación.

Como tantos otros facultativos, cuando nos sumergimos en el proceso de la docencia -y más específicamente en la evaluación de las rotaciones-, lo hacemos a través del registro (ficha) que facilita el Ministerio de Sanidad y Consumo. Este modelo presenta algunas limitaciones, importantes incluso, pero ha permitido incorporar la dinámica de la evaluación del residente durante las distintas rotaciones y aporta la valoración de diferentes profesionales sobre el residente, lo que delimita en parte la subjetividad de que adolece. Otro factor negativo de la ficha es la ausencia de criterios para evaluar y de definiciones sobre lo evaluado, lo que hace que demasiados docentes opten por calificaciones máximas, sin ningún criterio, considerando 'no perjudicar' al residente respecto a 'competidores' de otros centros.

A partir de estas reflexiones y otras similares [8], dada la escasa aceptación de la ficha por los colaboradores docentes y la falta de interés de los propios residentes en su evaluación, decidimos realizar unas pequeñas correcciones para evitar las principales limitaciones encontradas. Por un lado, establecimos definidores de lo que significaba cada elemento de la ficha, de modo que todo el mundo supiese la definición de lo evaluado, y además le otorgamos un valor numérico prefijado; de este modo, pretendimos delimitar la variable de subjetividad implícita de la ficha.

A esta modificación formal añadimos una segunda, que fue extender la valoración no sólo al colaborador docente, sino al resto de miembros de las diferentes secciones que componen nuestro Servicio de Anestesia, por las que rotan los residentes. Dado que el número de miembros de cada sección, en nuestro servicio, oscila entre 9 y 15 anestesistas, y rotan en seis secciones cada año, al final de cada rotación tenemos, en promedio, entre 36 y 60 valoraciones individuales de cada residente, lo que nos confiere una visión en conjunto muy grande sobre la evolución de la formación del residente, desde muchos y variados, puntos de vista porque, en el fondo, la evaluación lleva implícita una dimensión moral ('lo que evalúo es una muestra de lo que yo valoro') y, en este caso, es mejor disponer de un amplio número de visiones diferentes, que además le dota de un importante valor estadístico.

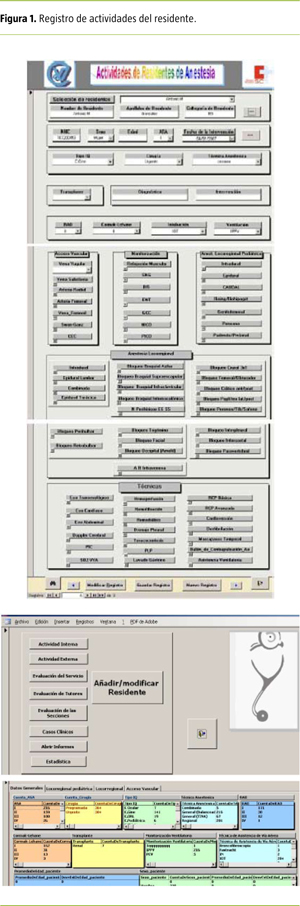

Una segunda herramienta que hemos incorporado a este proceso de evaluación es un programa informático de registro de actividades del residente (Fig. 1). No es más que un 'libro electrónico' del residente, adaptado específicamente para nuestra especialidad, tal como figura en el Real Decreto 183/2008 como eje de la evaluación formativa, que da soporte a la actividad del residente. Se trata de un conjunto de bases de datos en la que se puede recoger toda la actividad realizada por el residente, tanto en las rotaciones externas como internas. Posee igualmente registro de casos clínicos/sesiones para anotar la actividad docente, así como las encuestas de valoración de las secciones por las que rota y la valoración global anual del servicio. Finalmente, está dotada de un módulo estadístico que permite al residente y tutores tener información puntual de la actividad realizada, tanto asistencial como docente, lo que permite determinar rendimientos y detectar insuficiencias o áreas de mejora.

La Comisión de Docencia Hospitalaria del Hospital Universitario Marqués de Valdecilla ha establecido la obligatoriedad de realizar memorias formativas anuales para cada residente (MEFOR) en sustitución del 'libro del residente'. Se trata de un registro semiestructurado, tipo portafolio [9], donde los residentes recogen toda una colección de materiales, de evidencias de su aprendizaje y mejora competencial. A diferencia de un mero currículo, incorpora los registros de actividad asistencial que obtienen del registro de actividades del residente, experiencias clínicas, incidentes críticos, material de feedback, etc. Suele incluir elementos de reflexión, propuestas de acciones de mejora y planes para las lagunas formativas. Estas memorias son un elemento obligatorio y sirven a los tutores para conocer el progreso del residente.

Con estas tres herramientas hemos podido realizar el proceso de evaluación formativa del residente, esto es, un seguimiento que permite objetivar el proceso de aprendizaje, reconocer el progreso y el mérito, e identificar los rendimientos insuficientes o inadecuados. Han proporcionado una información muy precisa, que es devuelta al residente (feedback), y ha posibilitado establecer medidas correctoras que contextualizamos en las entrevistas tutor-residente [10].

Corresponde a los tutores realizar igualmente la evaluación sumativa del residente, en el sentido de definir el nivel alcanzado sobre la base de unos criterios comunes y, en consecuencia, certificar la consecución del programa de la especialidad. Nuestro problema radica en la inexistencia de herramientas para ello y, en consecuencia, en la ausencia de datos psicométricos que sustenten la validez de nuestras calificaciones, porque para este cometido, como mencionamos previamente, la herramienta utilizada debería poseer unos requisitos técnicos en cuanto a validez, fiabilidad, reproducibilidad, practicabilidad, aceptabilidad, impacto educativo y eficiencia.

Para este cometido, en ausencia de una herramienta específica, al igual que otros compañeros en similares tareas [11], hemos realizado una integración de las tres herramientas anteriormente descritas, con diferente grado de ponderación, al que añadimos otros dos descriptores, referidos a la calidad de las sesiones impartidas en el programa docente complementario y a la producción científica del residente.

En nuestro caso, el núcleo principal de la evaluación sumativa (2/3) se corresponde con la nota promediada de la valoración observacional directa del residente por parte de sus adjuntos. Esta nota se complementa con la calificación otorgada por los tutores (1/3), que califican cuatro descriptores definidos previamente y que incluyen: evaluación de la MEFOR, evaluación del registro de actividades del residente, evaluación de los trabajos/publicaciones realizados y calificación de las sesiones impartidas en el programa docente complementario.

Con este esquema, relativamente simple, hemos trabajado en los últimos seis años y a través de su análisis psicométrico hemos comprobado su eficiencia. Nuestros resultados sobre la validez de la herramienta, realizados mediante análisis de la concordancia, indican una correlación de 0,79 ± 0,08 (IC 95% = 0,69-0,88) en el periodo 2006-2009 y de 0,82 ± 0,11 (IC 95% = 0,70-0,94) para los residentes del periodo 2007-2010, lo cual indica una notable fiabilidad del instrumento.

El principal factor de variabilidad es el factor examinador, adjunto en nuestro caso. Sin embargo, consideramos positivo que haya discrepancias en la valoración de cada residente por nuestros adjuntos porque enriquece la comparación. Para minimizar la variabilidad intraespecífica, puede optarse por entrenar a los adjuntos en la herramienta o, mucho mejor, por incrementar el número de éstos y que el mismo residente sea evaluado por varios adjuntos [12], como es nuestro caso, lo cual confiere una gran consistencia estadística.

La practicabilidad de esta herramienta es muy favorable porque no implica consumo de recursos, ni materiales ni económicos, por lo que está al alcance de cualquier servicio, lo que hace que su eficiencia sea muy elevada. Queda por demostrar su aceptabilidad y su impacto educativo, pero ello excede nuestras posibilidades, ya que el propio proceso MIR no está diseñado para conferir una calificación, sino para determinar la aptitud o no aptitud del especialista, lo que hace que los propios residentes consideren el sistema como algo externo, dada la ausencia de impacto curricular de sus calificaciones.

Hasta aquí nuestra experiencia, que como dijimos al principio, era el objeto de esta colaboración, en la medida que pueda servir de modelo para otros compañeros inmersos en la misma problemática.

En el momento actual, estamos tratando de adecuar el proceso formativo a la nueva realidad que, al parecer, pasa por modificar nuestros esquemas basados en la enseñanza y en la determinación de objetivos, para poner el acento en aprender y adquirir competencias [12], entendiéndose éstas como comportamientos resultantes de un conjunto de actitudes, habilidades, destrezas, conocimientos y valores que el residente manifiesta para resolver situaciones concretas relacionadas con su profesión.

Este cambio conceptual obliga a revisar todo el plan formativo, elemento previo a cualquier proceso de evaluación, de modo que partiendo de las guías sobre el programa de especialización en anestesiología, dolor y cuidados críticos de la UEMS/EBA [13], y siguiendo la metodología de trabajo propuesta desde la Sección de Docencia de la Sociedad Española de Anestesiología y Reanimación [14], estamos rediseñando el currículo de anestesiología, lo cual no resulta nada sencillo porque carecemos de proyecto definitivo de programa de formación de la especialidad, trabajamos con el borrador del Ministerio de Sanidad y Consumo de 2006, y no sabemos el impacto que el decreto de troncalidad va a tener en nuestra especialidad, sobre todo en su composición y duración; sea como fuere, trabajamos en la recopilación de competencias que debe adquirir un especialista en formación de anestesiología, reanimación, cuidados críticos y dolor [15-17].

La evaluación de las competencias, entendiéndose como comportamientos resultantes, obliga a considerar la posibilidad de incorporar nuevas herramientas en el proceso de evaluación que puedan ayudar a evaluar la competencia clínica y la evaluación de la práctica clínica, que se corresponden con los niveles superiores de aprendizaje de la pirámide de Miller [18].

En este sentido, en la actualidad, estamos inmersos en el estudio de los simuladores a escala real y del DOPS/Mini-Cex como herramientas en la evaluación, tanto formativa como sumativa, respectivamente, del residente en los niveles mencionados.

De forma muy resumida, con el fin de incorporar los simuladores a escala real en la metodología de la evaluación se requiere un gran trabajo previo [19] para determinar competencias susceptibles de evaluarse mediante simuladores, definir escenarios para esas competencias y desarrollar sistemas de medida, además de una logística y disposición de personal muy importantes [20-22].

Nuestros resultados preliminares indican que la simulación a escala real tiene un alto impacto en la evaluación formativa, donde el debriefing [23] adquiere un elvado valor educativo. Los resultados del conjunto de residentes informan sobre el proceso de adquisición de competencias, cuáles están conseguidas y cuáles continúan en proceso, y el desarrollo de planes formativos específicos para el residente si se precisaran.

Sin embargo, cuando aplicamos la simulación en el evaluación sumativa, entonces es preciso incrementar el nivel de exigencia psicométrica; en este sentido, nuestros resultados [24] indican que la fiabilidad y la consistencia demostradas con la simulación clínica a escala real son más bien pobres, con una limitada capacidad de discriminación entre escenarios (r = 0,44; IC 95% = 0,18-0,70) y una baja consistencia (r = 0,22; IC 95% = 0,14-0,54), como otros autores han encontrado [25-27]. Aunque los datos son limitados, esta experiencia inicial indica que es necesario todavía un desarrollo metodológico importante para considerar la posibilidad de utilizar la simulación clínica a escala real en la evaluación sumativa.

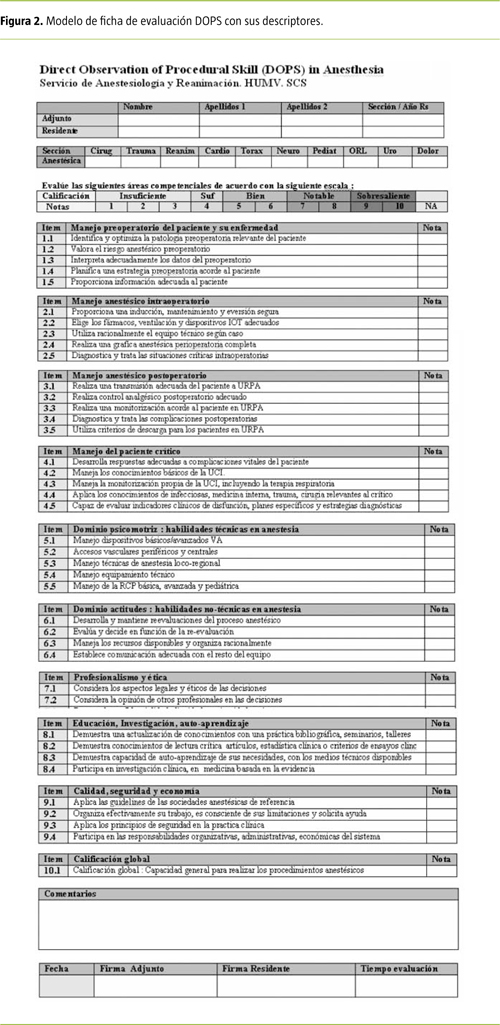

También estamos trabajando en el desarrollo de formularios o cuestionarios para la evaluación de la práctica clínica [28], en nuestro caso, el DOPS (Direct Observational Procedure Skills) y el Mini-Cex (minievaluación clínica). Comparten con la metodología de la simulación la necesidad de determinar las competencias a evaluar, pero a diferencia de la anterior, se centran en la evaluación del nivel superior de la pirámide de Miller [18], que en nuestro entorno puede fácilmente circunscribirse al ámbito quirúrgico, mediante la observación directa y la evaluación conforme a unos descriptores de competencias (DOPS) (Fig. 2).

A partir de nuestra experiencia previa, hemos incorporado al modelo DOPS unos definidores de cada competencia, para que todos evaluemos el mismo concepto, y una escala de evaluación, que en nuestro caso varía entre 1 y 10, más acorde con nuestras costumbres que la escala anglosajona de 1 a 6. Además, mantenemos la misma sistemática de evaluación por parte de un número significativo de miembros de cada sección, de las diferentes que componen el rotatorio de la especialidad, lo que proporcionará una gran consistencia estadística, de acuerdo con la psicometría del test [12].

Todavía no tenemos resultados psicométricos de estas herramientas, pero a juzgar por nuestra experiencia previa, creemos que puede tener un alto valor educativo, como ya han demostrado otros autores [29].

Finalmente, algunos compañeros [30] han avanzado en este proceso de evaluación de competencias utilizando la valoración 360o en la evaluación de la profesionalidad. Básicamente, la evaluación 360o, o feedback de origen múltiple, implica la evaluación por múltiples profesionales, de diferentes escalas, de las competencias relacionadas con el comportamiento y profesionalidad individual [31,32]. Es confidencial, requiere un buen conocimiento del residente a evaluar y una aceptación del modelo y del sistema como oportunidad de mejora personal y del clima de equipo.

Los resultados preliminares no parecen favorables. Se cuestiona la honestidad de las respuestas y su utilidad para valorar actitudes y comportamientos. Sólo el 11% de los evaluadores lo consideraba justo y ningún residente lo cree totalmente, e incluso consideran que las respuestas negativas pueden repercutir en las relaciones con el resto del equipo, por lo que los propios autores del trabajo consideran que esta herramienta de evaluación no es aceptable en su medio.

Agradecimientos

Dra. Angelina Rodríguez Caballero, Dr. Mounir Fayad Fayad y todos los residentes de anestesiología que han compartido esta experiencia.

Bibliografía

1. Nolla-Domenjó M. La evaluación en educación médica. Principios básicos. Educ Med 2009; 12: 223-9. [ Links ]

2. Borrel-Carrio F, Epstein RM, Pardell H. Profesionalidad y profesionalismo: fundamentos, contenidos, praxis y docencia. Med Clin (Barc) 2006; 127: 337-42. [ Links ]

3. Morán-Barrios JM. La formación basada en competencias se centra en el aprendizaje y no en la enseñanza. DPM 2010; 3: 42-5. [ Links ]

4. Real Decreto 183/2008, por el que se determinan y clasifican las especialidades en Ciencias de la Salud y se desarrollan determinados aspectos del sistema de formación sanitaria especializada. Boletín Oficial del Estado del 21 de febrero de 2008. p. 10020-35. [ Links ]

5. Documentos de Trabajo III. Evaluación del residente: propuesta de evaluación de las rotaciones. VI Encuentro de Tutores y Jefes de Estudio. Asociación de Redes Docentes y Asesoras (AREDA). Barcelona, septiembre de 2008. [ Links ]

6. González AM. Propuesta de modificación del Programa Docente de Anestesiología. Santander: Comisión de Docencia del HUMV; 2006. [ Links ]

7. Janssen JJ, Scherphier AJ, Metz JC, Groll RP, Van der Vleuten CP, Rethans JJ. Performance-based assessment in continuing medical education for general practitioners: construct validity. Med Educ 1996; 30: 339-44. [ Links ]

8. Fornells JM. Bases conceptuales en la evaluación de las rotaciones en la formación especializada. Madrid: Sección de Docencia de la SEDAR; 2011. [ Links ]

9. Snaden D, Thomas M. The use of portfolio learning in medical education. Med Teach 1998; 20: 192-9. [ Links ]

10. Holmboe ES, Yepes M, Williams F, Huot SJ. Feed-back and the Mini-Cex evaluation exercise. J Gen Intern Med 2004; 19: 558-61. [ Links ]

11. Reveron MA, Moure EJ, Bravo PL, Tejera RD, Besada JC. Experiencia de la Unidad Docente de Anestesiología y Reanimación del Hospital Universitario Nuestra Señora de Candelaria. Rev Esp Anestesiol Reanim 2011; 58: 223-9. [ Links ]

12, Weller JM, Jolly B, Misur MP. Mini-clinical evaluation exercise in anesthesia training. BJA 2009; 102: 633-41. [ Links ]

13. McCleland D. Testing for competence rather than for intelligence. Am Psychol 1973; 28: 1-14. [ Links ]

14. Saez A, Calvo JM, Olmos M, Sistac JM. Metodología de trabajo para la actualización del programa formativo de la especialidad de Anestesiología y Reanimación. Una propuesta desde la Sección de Docencia y Formación de la SEDAR. Rev Esp Anestesiol Reanim 2010; 57: 28-40. [ Links ]

15. Rose SH, Burkle CM. Accreditation council for graduate Medical Education Competencies and the American Board of Anesthesiology Clinical Competence Committee: a comparison. Anesth Analg 2006; 102: 212-6. [ Links ]

16. Tetzalaff JE. Assessment of competency in anesthesiology. Anesthesiology 2007; 106: 812-25. [ Links ]

17. Epstein RM. Assessment in medical education. N Engl J Med 2007; 356: 387-96. [ Links ]

18. Miller G. The assessment of clinical skills/competence/performance. Acad Med 1990; 65: 563-7. [ Links ]

19. González AM, Caballero AR, Maldonado S, Rodríguez M, Carceller JM. Evaluación de la residencia I. Desarrollo de nuevas herramientas para la evaluación. XXX Congreso de la SEDAR. Madrid, 2011. [ Links ]

20. Boulet JR, Murray DJ. Simulation-based assessment in anaesthesiology: requirements for practical implementation. Anesthesiology 2010; 112: 1041-52. [ Links ]

21. Murray DJ, Boulet JR, Kras JF, Woodhouse JA, Cox T. Acute care skills in anesthesia practice. Anesthesiology 2004; 101: 1084-95 [ Links ]

22. Berkenstadt H, Ziv A, Gafni N, Sidi A. Incorporating simulation-based objective structured clinical examination into the Israeli National Board Examination in Anesthesiology. Anesth Analg 2006; 102: 853-8. [ Links ]

23. Fanning RM, Gaba DM. The role of debriefing in simulation-based learning. Sim Healthcare 2007; 2: 115-25. [ Links ]

24. González AM, Caballero AR, Maldonado S, Burón FJ, Rodríguez M, Carceller JM. Summative evaluation of anesthesia residents using simulation. 17th Annual Meeting of the SESAM. Granada, 2011. [ Links ]

25. Henrichs BM, Avidan MS, Murray DJ, Boulet JR, Kras J, Krause B, et al. Performance of certified registered nurse anesthetists and anesthesiologists in a simulation-based skills assessment. Anesth Analg 2009; 108: 255-62. [ Links ]

26. Schwid HA, Rooke GA, Carline J, Steadman RH, Bosseau W, Olympio M, et al. Evaluation of anesthesia residents using mannequin-based simulation. Anesthesiology 2002; 97: 434-44. [ Links ]

27. Morgan PJ, Cleave-Hogg D, DeSousa S, Tarshis J. High-fidelity patient simulation: validation of performance checklist. Br J Anaesth 2004; 92: 388-92. [ Links ]

28. Norcini J, Burch V. Workplace-based assessment as an education tool. AMEE Guide no. 31. Med Teach 2007; 29: 855-71. [ Links ]

29. Kogan JR, Holmboie ES, Hauer KE. Tools for direct observation and assessment of clinical skills of medical trainees. JAMA 2009; 302: 1316-21. [ Links ]

30. Olmos M, Forés B. Evaluación de la profesionalidad mediante valoración 360o. Estudio sobre su viabilidad y aceptación. Jornadas de la Sociedad de Educación Médica de Euskadi (SEMDE). Bilbao, noviembre de 2010. [ Links ]

31. Whitehouse A, Hassell A, Bullock A, Wood L, Wall D. 360 degree assessment (multisource feedback) of UK trainee doctors: field testing of team assessment of behaviours (TAB). Med Teach 2007; 29: 171-6. [ Links ]

32. Wilkinson TJ, Wade WB, Knock LD. A blueprint to assess professionalism: results of a systematic review. Acad Med 2009; 84: 551-8. [ Links ]

![]() Dirección para correspondencia:

Dirección para correspondencia:

Dr. Antonio M. González

Servicio de Anestesiología y Reanimación

Hospital Universitario Marqués de Valdecilla

Avda. Valdecilla, s/n. E-39008

Santander (Cantabria)

E-mail: anrgga@humv.es

Conflicto de intereses: No declarado.