Introducción

Los avances tecnológicos en el campo de la informática a día de hoy son cuantiosos. Hace poco más de dos décadas, la gran mayoría de las familias carecían de ordenador y quienes disponían de acceso a Internet encontraban un servicio precario. Hoy día, el uso de las tecnologías de la información y la comunicación (TIC) está presente en la vida de los más jóvenes desde su nacimiento tanto en el entorno escolar como familiar, haciendo que las perciban como algo cotidiano y ameno, de ahí que para denominar a las presentes generaciones se use el término acuñado por Prensky (2001) de “nativos digitales”, haciendo alusión a su crianza dentro del lenguaje digital de las computadoras, los videojuegos e Internet (p.1). El uso de aplicaciones o herramientas vinculadas a Internet en los distintos dispositivos fijos o móviles es cada vez más común, y como bien dice Lackerbauer (2001), el uso de esta herramienta es parte de nuestra vida diaria, teniendo su aceptación tal repercusión que “es comparable a la que tuvo en su día el teléfono o la televisión” (p.12).

Para poder situar la incidencia actual de las tecnologías en general, dentro de la sociedad española, y más concretamente la incidencia de Internet, es interesante tomar como referencia algunos de los datos recientemente publicados por el Instituto Nacional de Estadística (2017), donde se expone que en España, el 83,4% de los hogares españoles tiene acceso a la Red, frente al 81,9% del año anterior. De los usuarios, el 99.8% dispone de un tipo de conexión de banda ancha, siendo el teléfono móvil una de las herramientas más usadas para acceder a Internet.

“La informática e Internet han supuesto una revolución técnica y conceptual en todas las áreas de conocimiento y especialmente en la Psicología” (Hernández-Mendo, Morales-Sánchez y González-Ruiz, 2012, p. 147), una revolución que ha supuesto una extensión de la informática no solo a nivel social o desde el punto de vista del usuario básico, sino también en las diferentes áreas de investigación, en las que está provocando un cambio cuantitativo en la forma de obtención y manipulación de datos de los cuestionarios. Respecto al ámbito de la Psicología, y especialmente de la psicometría, la informática desempeña una función vital. Según Renom (1993), gracias a diversas investigaciones desarrolladas en áreas como la educación, investigación militar, la administración pública, el deporte, etc., la informatización de cuestionarios ha causado una revolución metodológica y tecnológica popularizándolos. En esta línea, Prieto, Carro, Orgaz, Pulido, y Gonzáles-Tablas (1993), consideran que una de las aplicaciones más importantes de los ordenadores personales es la implementación, diseño y administración de test informatizados. “En los últimos años, Internet ha cumplido su promesa de permitir a los investigadores acceder a poblaciones y fenómenos que serían difíciles de estudiar utilizando métodos convencionales” (Reis y Gosling, 2010, p. 91), esto puede llevar a que el día de mañana algunos campos sustituyan los test de toda la vida en de papel y lápiz (Bejar, 1985) por su versión digital.

Las TIC y su uso en la investigación psicológica.

El ámbito de las Tecnologías de Información y Comunicación (TIC) es muy diverso (laboral, social, educativo, económico, científico, comercial, etc.) y su uso ofrece a los usuarios la posibilidad de realizar on-line cualquier tipo de trámite así como la posibilidad de realizar evaluaciones mediante cuestionarios o herramientas simulares que se encuentre alojado en un servidor web, facilitando así la investigación

El trabajo realizado 25 años atrás por un investigador durante su jornada laboral era básicamente manual (recopilar datos desplazándose al lugar de la investigación, estudio y análisis de los mismos, realizar informe, cotejar datos, etc.). Si en su jornada de trabajo el rendimiento era X tareas, con los avances tecnológicos actuales (ordenador, bases de datos, programas de cálculo estadístico, redes sociales, Internet) podría llegar a realizar 10X tareas.

El uso de Internet mejora la eficiencia y la precisión con que se pueden recopilar las formas tradicionales de datos (Reis y Gosling, 2010). No se puede negar que los avances científicos y tecnológicos han supuesto una gran revolución en todas las áreas de conocimiento, destacando especialmente Internet junto a los equipos informáticos. Tal ha sido el cambio y la revolución tanto en el ámbito familiar como en el laboral debido a estos avances, que sin ellos, sería muy difícil entender el día a día en el presente.

El aumento de usuarios que disponen de Internet en todo el mundo, la velocidad a la cual se navega, la adaptación de las web para una interacción con los usuarios más amena y segura, contribuyen a que a día de hoy se esté hablando de experimentos on-line, algo impensable hace pocos años. Tradicionalmente los psicólogos han trabajado y complementado sus estudios e investigaciones con ordenadores, que no necesariamente han sido muy sofisticados salvo excepciones como en ciertas áreas de investigación neuropsicológica. Estos equipamientos informáticos se suelen ubicar en laboratorios aislados del mundo exterior (luz, ruido) en los cuales se reclutan a voluntarios para realizar ciertos estudios. Pero esta realidad está cambiando, desde el punto de vista de la disponibilidad de estos recursos, ya al alcance de cualquiera, haciendo que dichos experimentos psicológicos puedan realizarse, ya no en laboratorios, sino en las casas de los voluntarios o participantes. Se estarían así creando los experimentos on-line y los laboratorios virtuales.

Se desconoce cuál será el futuro, pero viendo el gran avance que ha habido en apenas dos décadas, es de prever que haya numerosas mejoras y nuevas técnicas de investigación en años no muy lejanos.

Cabe destacar que todo lo anteriormente expuesto, necesita de unos conocimientos previos que no se pueden dar por supuestos, ya que las tecnologías están en continuo avance y es necesario asimilar y aprender los nuevos conceptos, tanto para jóvenes como para adultos.

Este gran cambio no debe pasar desapercibido antes los ojos de la Psicología actual, tanto en el ámbito académico como científico. Cada vez es más popular encontrar nuevas herramientas en la web (Coll & Monereo, 2008), que facilitan a los investigadores y educadores diferentes formas de actuar. En sus inicios, algunos investigadores optaron por colgar sus experimentos en Internet sin ninguna difusión, lo que causaba un bajo número de participantes. A esta iniciativa se sumaron varias universidades, creando secciones especiales para los experimentos (Risso, 2001). A día de hoy las universidades siguen implantando de forma continuada las tecnologías para el apoyo a la docencia, usando ordenadores en las aulas, centros Wi-Fi, plataformas on-line, etc. (Uceda y Barro, 2008).

En la investigación psicológica se estableció la rutina inicial de solicitar la participación de los sujetos para la realización de experimentos web a través de grupos de noticias, listas de correo, motores de búsqueda, páginas web estáticas de las universidades (participando usuarios de la misma). En la actualidad, los experimentos web cuentan con una alta difusión, haciendo uso de las tecnologías y herramientas destinadas a tal fin: foros de discusión, redes sociales, listas de distribución, novedades en las páginas web, sindicación de contenidos (suscripción a fuentes RSS). Todas estas técnicas ayudan a los investigadores a contar con participantes que realmente quieran intervenir en los experimentos (de manera voluntaria y anónima). Aunque parezca que no, “la web 2.0 ha entrado ya en las universidades de una forma silenciosa gracias a profesores, investigadores y estudiantes que, en la mayor parte de casos sin estímulos institucionales, empezaron ya hace años a utilizar software social, como por ejemplo blogs o wikis”. (Freire, 2007, p. 1). Esta incorporación no se sustenta solo en el hecho de añadir pizarras digitales en los centros, usar plataformas on-line, colgar experimentos web en Internet o usar nuevas herramientas y aplicaciones virtuales (Google Docs, Twitter, Google Reader, Moodle, YouTube etc.), que están dentro del ranking de las 100 herramientas tecnológicas más usadas para el aprendizaje (Esteve, 2009), sino que requiere de una implicación activa por parte de todos para sacarle el mayor partido.

La recogida de datos de forma on-line presenta como hándicap las limitaciones de acceso para personas con edad avanzada, que no dispongan de equipo informático con acceso a Internet, o simplemente no tengan manejo de las TIC. Aunque aún hoy son limitaciones reales, conforme avanzan los años estas limitaciones están disminuyendo debido al empleo de las tecnologías en la educación desde edades tempranas (Area, 2010; Coll, 2008; Martínez & Prendes, 2004) y al crecimiento del uso de Internet en los hogares españoles, existiendo un incremento en los hogares donde existen menores (Fundación Telefónica, 2014; Chillida, 2013; Sádaba, 2010; López, Izquierdo y Currás, 2009).

Uso de la Minería de Datos para el análisis y Evaluación de Resultados.

La minería de datos es el proceso de detectar la información existente en conjuntos grandes de datos. Utiliza el análisis matemático (fundamentalmente basado en cálculo de probabilidades) para deducir los patrones y tendencias que existen en los datos.

Normalmente, estos patrones no se pueden detectar fácilmente mediante un análisis estadístico tradicional de los datos porque las relaciones son demasiado complejas o por la gran cantidad de datos.

Estos patrones se pueden analizar y generar un modelo del sistema a partir de la minería de datos y que son aplicables en diferentes campos como la educación (Romero, 2013), las finanzas, los juegos de azar, etc. Algunos ejemplos de posibles escenarios de aplicación serían: (1) Pronóstico: cálculo de ventas, predicción de las cargas de un servidor, tiempo de inactividad, pronóstico del resultado de un examen en función de las prácticas realizadas, etc. (2) Riesgo y probabilidad: elección del tipo de individuos para la distribución de correo directo, elección de la carrera a estudiar en función del expediente de bachillerato o del deporte a practicar en función de determinadas pruebas o test, determinación del punto de equilibrio probable para los escenarios de riesgo, y asignación de probabilidades a diagnósticos y otros resultados. (3) Recomendaciones: determinación de los productos que se pueden vender juntos, acciones a realizar, generación de recomendaciones. (4) Búsqueda de secuencias: análisis de los artículos que los clientes han introducido en el carrito de la compra y predicción de posibles eventos. (5) Agrupación: distribución de individuos o eventos en grupos de elementos relacionados, y análisis y predicción de afinidades.

La generación de un modelo de minería de datos forma parte de un proceso mayor que incluye desde la formulación de preguntas acerca de los datos y la creación de un modelo para responderlas, hasta la implementación del modelo en un entorno de trabajo. Este proceso se puede definir mediante los seis pasos básicos siguientes: (1) Definir el problema; (2) Preparar los datos; (3) Explorar los datos; (4) Generar modelos; (5) Explorar y validar los modelos; (6) Implementar y actualizar los modelos.

Plataformas de virtuales para la evaluación y la investigación.

Los primeros experimentos sociales datan de antes de 1900 (Hewstone, Stroebe y Jonas, 2012). La introducción de los ordenadores en las investigaciones psicológicas en los años 70, permitió su uso a los laboratorios experimentales para la recogida de muestras (Sanmartin y Algarabel, 1990).

Algunas de las plataformas más destacadas, con sus correspondientes laboratorios psicológicos virtuales, se detallan a continuación:

Laboratorio virtual de Psicología de la Universidad Autónoma de Madrid dirigido por Benjamín Sierra Díez del Departamento de Psicología Básica (http://www.uam.es/personal_pdi/psicologia/bsierra/psicologia/index.html). Reúne un conjunto de experimentos interactivos sobre Psicología básica, entre los que tiene implementados 5 experimentos: compresión de textos, memoria a corto plazo, formación de impresiones, razonamiento silogístico, percepción/expectativas. Es una página orientada a los alumnos en la que no se guardan datos.

On-line Psychology Research. Sitio web en inglés que proporciona una serie de enlaces relativos a estudios psicológicos que se realizan mediante Internet, llevados a cabo por psicólogos y expertos académicos. La responsable del sitio es la Doctora Gardner, profesora titular de Psicología de la Universidad de Central Lancashire, (UCLan, Reino Unido). La web tiene dos enfoques claramente diferenciados, un primer enfoque que sería el de dar de alta un estudio por parte de un investigador académico, y otro, tal vez el más importante, buscar usuarios, que de manera voluntaria y altruista, quieran participar en las diferentes investigaciones en línea. Dispone de varios apartados en el menú, destacando una opción para los investigadores, donde ofrecen una serie de recursos para llevar a cabo un estudio a través de Internet. Si un investigador necesita realizar una investigación on-line, simplemente tiene que rellenar unos datos en un formulario (tiempo para completar el estudio, país, categoría del estudio, universidad asociada, enlace web) y una vez cumplimentado el trámite de aceptación, se procederá a mostrarlo en la página web, para que sea visible por los usuarios que quieran participar en él. Algunos de los estudios que se pueden encontrar en dicha web son relativos a la psicología biológica, clínica, cognitiva, del desarrollo, forense, evolutiva, de la conducta, social, del deporte etc. A fecha de septiembre de 2014, cuenta con más de 500 estudios en línea (http://www.on-linepsychresearch.co.uk/).

Social Psychology Network. Página web mantenida por Dr. Plous, Doctor en Psicología por la Universidad de Stanford (Estados Unidos). Es miembro de “Society of Experimental Social Psychology” (http://www.sesp.org/), organización científica que se dedica al avance de la Psicología social. Los investigadores que deseen, pueden a través de un formulario, dar de alta su investigación mediante la cumplimentación de datos como su nombre, posición (psicólogo, estudiante, becario), email, Universidad, título del estudio, dirección web del estudio etc. La investigación que se proponga debe de cumplir una serie de requisitos como: estar en relación con la Psicología Social, ser aprobada por un comité. Actualmente cuenta con más de 358 experimentos basados en la web. Las diferentes investigaciones están divididas por categorías como toma de decisiones, personalidad, creencias y actitudes, percepción social entre otras .(http://www.socialpsychology.org).

Tal y como se ha mencionado, en el presente, no es la persona la que va al laboratorio, sino el laboratorio el que se acerca a la persona. Esta es la filosofía planteada para realizar experimentos usando Internet. Los experimentos web llegan donde otras técnicas y métodos no son capaces. Por otro lado presenta un considerable ahorro de tiempo y dinero, no dependiendo de un horario estricto ni lugar determinado para realizar los experimentos. La facilidad de recolección de los datos en poco tiempo, recolección diversa y heterogénea de la muestra, (mayoritariamente jóvenes) son algunas de las ventajas.

Ventajas e inconvenientes de las plataformas on-line

En general las plataformas virtuales, ya sean usadas para la evaluación, el aprendizaje, la gestión, etc. facilitan a realización de determinadas tareas de gestión, difusión de información, consulta de datos e investigación (Berrocal y Megías, 2016).

Autores como Díaz de Rada (2011, 2012), Ganassali (2008), Jackob y Zerback (2006), Birnbaum (2004), Tourangeau (2004), Kraut et al. (2004), Truell (2003), Gunn (2002) y Dillman y Bowker (2001), citan en sus investigaciones ventajas o desventajas relacionadas con la investigación on-line. Entre las ventajas más destacadas: la rapidez en la obtención de los resultados al finalizar la prueba seleccionada, como afirman Hernández-Mendo et al. (2014) “disponer de un inmediato feedback sobre una cuestión” permite agilizar el proceso investigador, facilidad de uso para los participantes, ubicuidad ya que se puede acceder a la aplicación desde cualquier parte en cualquier momento siempre que haya disponible una conexión a Internet, compatibilidad ya que el uso de herramientas web es la mejor forma de asegurar la compatibilidad con distintos sistemas operativos, menor margen de error a la hora de introducir los datos, análisis rápido de los datos permite que los resultados están listos para ser analizados en cualquier momento, abaratamiento de costes permite reducir a la mitad los costes de investigación, deseabilidad social (disminución del sesgo del entrevistador). El uso de las plataformas virtuales permite que “los datos se almacenen automáticamente y los comentarios se entreguen instantáneamente a los participantes. Este último beneficio demostró ser particularmente importante porque la retroalimentación sirvió como un gran incentivo para los participantes” (Reis y Gosling, 2010, p. 90). Otra ventaja añadida al almacenamiento automático de los datos es su facilidad para poder ser procesados independientemente del volumen de los mismos,

Como en todos los casos, existen puntos desfavorables como pueden ser la autoría, ya que se necesita una garantía para saber que realmente el usuario que realiza la prueba es el seleccionado para la misma, puesto que la naturaleza anónima de Internet permite a los sujetos participar frívola o maliciosamente (Kraut et al., 2004); dependencia del uso de tecnologías, ya que al situar la investigación en poblaciones donde el uso de dichas tecnologías no llega al 100% de los usuarios, aparecerán exclusiones a la hora de obtener muestras representativas; la falta de formación o pericia al manejar el ordenador; privacidad, ya que numerosos usuarios son reacios a realizar pruebas por Internet debido a que puede llegar a ser un medio no seguro (Jackob y Zerback, 2006); problemas técnicos que pueden surgir mientras se realiza la prueba; imposibilidad de realizar pruebas específicas con ciertos estímulos (táctiles, gustativos, olfatorios) para los que todavía no se disponen de los medios pertinentes (Birnbaum, 2004); falta de relación personal entre investigador e investigado, “cuando dos personas entran en contacto, a través del tipo de conducta comunicativa que establecen, van definiendo progresivamente su relación” (Hernández-Mendo, Fernández-Motta y Raimundi, 2017, p.34) algo que puede ser especialmente necesario dependiendo de la temática a abordar.

Estos puntos estudiados ayudan a los investigadores a tomar la decisión de usar esta metodología presentada a través de Internet. Aunque es importante destacar que según Carlbring et al. (2007) y Gosling, Vazire, Srivastava y John (2004) hasta el momento no existen diferencias significativas entre los resultados obtenidos por esta modalidad y aquellos obtenidos por medios tradicionales como papel, entrevista personal, correo, etc.

Problemas metodológicos planteados por las plataformas virtuales.

¿Puede alguien predecir o afirmar que los problemas metodológicos podrían dejar de serlos en un futuro no muy lejano? En la actualidad, existe gran interés por los métodos de investigación basados en Internet, aunque hay varios aspectos que deben ser considerados. En toda investigación existen limitaciones o retos metodológicos a tener en cuenta (tamaño, naturaleza, captación y selección de la muestra, ausencia de comunicación no verbal, recogida de los datos, diseño, implementación y control de la plataforma etc.) que pueden influir en mayor o menor medida en los resultados obtenidos siendo objeto de estudio por varios autores (Fernández-Ballesteros, 2014; Lozzia et al., 2013; Baena, Fuster, Carbonell y Oberst, 2010; Hogg, Graha, Vaughan y Morando, 2010; Muñiz y Fernández-Hermida, 2010; Del Río, 2009; Cox, 2008; Lacherez, 2008; Martin, 2008; C.D. Estatal y C. O. de Psicólogos, 2007; Fernández-Ballesteros y Macià Antón, 2007; Alvarado y Santisteban, 2006; Bermejo, 2001; APA, 1992).

Según Germine et al. (2012), un amplio espectro de investigadores consideran que la recogida de datos a través de entornos virtuales son menor calidad que aquellos que se recogen de forma directa y presencial en un laboratorio tradicional. Sin embargo, en su investigación comparó resultados obtenidos en la web por personas voluntarias con resultados realizados en laboratorios tradicionales, llegando a la conclusión de que los resultados obtenidos eran tan buenos en un caso como en otro.

Aunque estudios similares también indican que no existen diferencias significativas en la forma de realizar las investigaciones (de manera presencial u on-line), suelen existir otros problemas metodológicos relacionados con las propiedades psicométricas y el uso de Internet como herramienta de investigación (Estalella y Ardévol, 2011; Vallejo, Jordán, Díaz, Comeche y Ortega, 2007).

El acceso a la información generada por millones de personas resulta ahora muy asequible gracias a Internet, permitiendo el acceso a la misma y planteando una serie de cuestiones que se conocen como la ética de la investigación. Estos planteamientos éticos pueden presentarse como problemas si no se siguen unas adecuadas pautas de trabajo dentro de la investigación. Como marco de referencia en la experimentación con humanos, se presenta el Código de Nuremberg (Laporte y Vallvé, 2001) publicado el 20 de agosto de 1947, donde se recogen una serie de principios de la experimentación médica en seres humanos (Muñiz, 1997) y que hoy día se extrapola a otras ramas de la ciencia. También es recomendable la lectura de la Declaración de Helsinki, promulgada por la WMA (Asociación Médica Mundial) donde se encuentran los principios éticos que sirven de guía a la comunidad médica así como a los experimentadores (Manzini, 2000).

A la hora de delimitar las posibles problemáticas, la mejor manera de minimizarlos es reconocer los elementos que intervienen en una investigación on-line, para actuar sobre ellos, y que según identifican Baena et al. (2010) son: (1) El diseño de la plataforma: usabilidad, descripción del diseño, adaptación. (2) La calidad de la investigación: medidas preventivas, medidas correctivas. (3) El análisis de los datos: cuestionarios incompletos, control de tiempo, correcciones estadísticas, tasa de respuesta. (4) La administración del estudio: Web, mail, teléfono, obligatorio/voluntario, ítems aleatorios, número de páginas, zona geográfica. Según (Wood, Griffiths, & Eatough, 2004), si en una plataforma se detalla de forma clara y concisa el nombre del investigador principal, los puntos más importantes del experimento, duración del mismo, público objetivo, se suele incrementar el número de usuarios que participan en la investigación. (5) Reclutamiento de los participantes: gran parte de los usuarios que intervienen en experimentos son estudiantes universitarios entre 20 y 30 años (Vallejo et al., 2007), que puede ser interpretado como un aspecto favorable, debido a que son ellos quienes presentan gran destreza con las nuevas tecnologías y si no es por esta vía, difícilmente son accesibles (Koo & Skinner, 2005). Puede que lo expuesto en este punto no se considere una limitación ya que son diversas las investigaciones donde la muestra presenta las mismas características. (6) Estudio abierto/cerrado, modo de contacto, publicidad del estudio, prevención multientrada, incentivos. Otras técnicas de reclutamiento pueden ser: la aleatoriedad, ofreciendo a un determinado usuario que esté navegando en la plataforma, intervenir en una investigación en curso. La frecuencia de visitas de un usuario en una web, se contempla como otra técnica para ofrecerle la opción de participar. (7) Aspectos éticos y deontológicos: la ética proporciona los criterios que determinan los aspectos correctos o incorrectos de toda investigación mientras que la deontología detalla los deberes y las normas de conducta profesional de los psicólogos, tratando las normas para la “buena práctica” psicológica (Lusar, 2011).

Plataforma MenPas.

La plataforma virtual de evaluación psicosocial MenPas, fue diseñada y puesta en funcionamiento entre los años 2005 y 2008. Desde entonces gestiona 20 áreas de trabajo y más de 70 tareas y cuestionarios donde se evalúan variables y tareas de diversa índole (González, Hernández-Mendo y Pastrana, 2010). Muchas de estas tareas son programas de escritorio, comunicados con el servidor a través de servicios web, lo que permite el desarrollo de diversas aplicaciones integradas en la plataforma o de uso local que se puedan comunicar con ésta mediante el uso de protocolos de comunicación estándar basados en HTTP (Hypertext Transfer Protocol) y XML (eXtensible Markup Language).

Se optó por la implementación de una nueva herramienta web debido a que ninguna de las estudiadas cubría las necesidades requeridas para realizar investigaciones en idioma castellano y las áreas necesarias para los estudios. Es totalmente gratuita, traducida a tres idiomas y abre las puertas a todos los investigadores que deseen ponerla en práctica. Cada vez son más las plataformas on-line de este tipo que implementan sus cuestionarios y aplicaciones, procediendo a la recogida y estudios de datos on-line. Es útil tanto para usuarios de tipo general como para profesionales de la Psicología, donde podrán realizar evaluaciones e investigaciones relativas a los diferentes cuestionarios y aplicaciones implementadas en la misma.

El total de usuarios registrados a fecha de abril 2018 es de 12084 participantes. Actualmente cuenta con 691 grupos dirigidos por los administradores que están realizando investigaciones relativas a distintos cuestionarios o áreas.

Se ha intentado, en la medida de lo posible, añadir a la plataforma diferentes técnicas o métodos que minimicen la recogida de datos erróneos o no válidos para aumentar la fiabilidad de los distintos estudios. Del mismo modo, se pretende una accesibilidad total a la misma buscando un manejo intuitivo, eficiente y cómodo por las diferentes zonas de la misma. La competitividad con otras plataformas y las expectativas de los usuarios, obliga a la mejora continua de la misma para evitar que el sitio web quede obsoleto con un número de visitas inferior al esperado. Hoy día una web que no agregue novedades mensuales y no controle las incidencias o sugerencias de usuarios, está destinada a su desaparición, por eso el esfuerzo que se lleva a cabo para que dicha plataforma siga activa a día de hoy.

El acceso se puede hacer registrándose o de manera anónima, mostrando una serie de cuestionarios implementados a tal fin. Un usuario puede solicitar ser administrador de un determinado grupo de manera fácil y cómoda, simplemente debe de cumplimentar una serie de datos relativos a la investigación y tras un estudio, se procederá a cambiar el perfil de dicho usuario. La evaluación se realiza de manera automática. Un investigador con perfil de administrador puede consultar los datos del grupo asignado, apareciendo de manera actualizada todos los datos.

Se dispone de 5 perfiles diferentes para trabajar en la plataforma: usuario, administrador, administrador restringido, de cuestionarios y países. El usuario solo puede realizar los cuestionarios o tareas implementadas, consultando los valores obtenidos de forma individualizada. El administrador tiene control total sobre todos los cuestionarios y sólo los creadores tienen dicho perfil. El administrador restringido puede consultar los datos de los cuestionarios a los que se les ha dado acceso administrativo. Debido a la necesidad de facilitar el acceso a áreas restringidas a administradores, se creó un nuevo perfil el cual es asignado a usuarios registrados en MenPas que estén al cargo de un grupo en concreto, facilitando el estudio de esa investigación que es dirigida por uno o varios investigadores. Para que este perfil pueda ponerse en práctica, es necesario que el administrador restringido y los usuarios pertenecientes e ese administrador compartan un campo en común que se rellena al darse de alta en la plataforma o una vez registrado, en el área de usuarios. Dicho campo se denomina “grupo”. Gracias a ese campo el administrador restringido puede tener acceso a todas las áreas de la plataforma que previamente el administrador le ha asignado para el estudio, mostrando información del grupo en concreto y no de todos los usuarios de la plataforma. El administrador de cuestionarios es asignado a usuarios que han implementado un cuestionario en la plataforma. Para terminar, el perfil de administrador de países controla todos los cuestionarios de los usuarios de una determinada nacionalidad o país.

Según Raimundi (2012), los beneficios que aporta esta plataforma a los profesiones son: acceso on-line, optimización de recursos de tiempo, al no tener que estar presente mientras se realiza el experimento, reducción de errores a la hora de introducir datos, ya que se almacenan de manera automática y el acceso a grandes muestras a nivel transnacional.

Uno de los aspectos que hay que mejorar en este tipo de plataformas es la imposibilidad de saber en qué condiciones se realiza el cuestionario. Respecto a este punto, MenPas ha implementado varias herramientas que ayudan a controlar algunos de estos aspectos: tiempo que tarda el usuario en realizar el cuestionario, dispositivo desde donde accede, cambio de respuesta de ítems, etc. Pero es muy complicado, por ejemplo, saber si un usuario está participando en un experimento, mientras ve una película, come palomitas y charla con su familia a la vez.

Descripción técnica.

La plataforma MenPas ha sido implementada sobre la plataforma .NET de Microsoft y se han usado los distintos servicios que provee a la hora del desarrollo de aplicaciones web. Aplicando técnicas y estándares se ha desarrollado una aplicación visual para la evaluación psicosocial de deportistas y entornos deportivos. Visual Studio ha sido el entorno de desarrollo integrado (IDE, del inglés Integrated Development Environment) elegido para la implementación de la misma.

Para el perfecto funcionamiento de la herramienta por parte del usuario, basta con tener instalado un navegador web en su máquina, ya sea éste Internet Explorer o cualquier otro navegador. Desde la máquina cliente, donde se ejecuta el navegador, se accede a través de la red al servidor web donde está alojada la herramienta y, de esa forma, se puede utilizar la aplicación, sin necesidad de tener que instalarla en el PC. A continuación se muestran las herramientas que hacen posible el funcionamiento de la plataforma MenPas (algoritmo de encriptación MD5, SQL, ASP.NET, Ajax, bases de datos, servidor IIS, servicios web, lenguaje C#, biblioteca de JavaScript JQuery).

Datos sobre usuarios de la plataforma

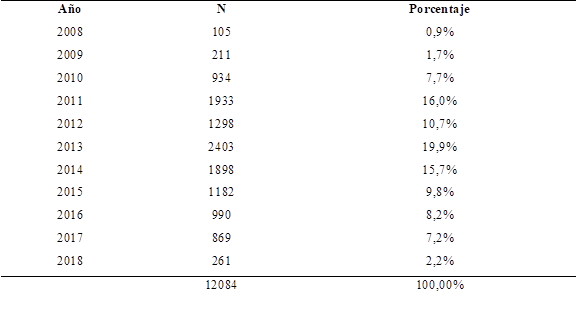

Como se ha comentado anteriormente, el total de usuarios registrados asciende a 12084 participantes, siendo la mayoría de habla hispana, solteros, género masculino, con estudios superiores, menores de 30 años y practican algún deporte. El incremento en el número de participantes ha sido variable a lo largo de los 10 años que lleva en funcionamiento, como puede verse en la tabla 1 y figura 1.

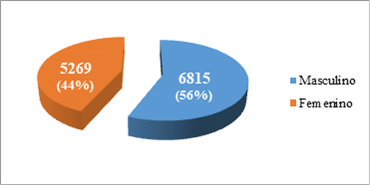

Aunque la muestra es representativa, se cree que en años futuros, gracias al posicionamiento de la plataforma, artículos donde intervengan, uso de redes sociales y mejoras en la misma, se contará con una muestra mucho más representativa que permita realizar estudios de más calado. En la distribución por género se observa un 56.4% de participantes de género masculino (6815 en total) y un 43.6% en femenino (5269) (ver figura 2).

Aunque la plataforma soporta los idiomas: inglés, portugués y español, la muestra está formada por un diverso conjunto de nacionalidades, predominando los países de habla hispana sobre los demás. Cabe resaltar que respecto a la distribución del género por nacionalidades, el género masculino predomina sobre el femenino en casi todos los países, siendo Colombia uno de los que se sale del tópico (ver tabla 3).

Por continentes, son Europa (España, Portugal…) y América (México, Colombia, Argentina…) los que representan a la mayoría de la población. Estos datos obtenidos tienen una relación directa con las visitas a la plataforma por parte de los usuarios.

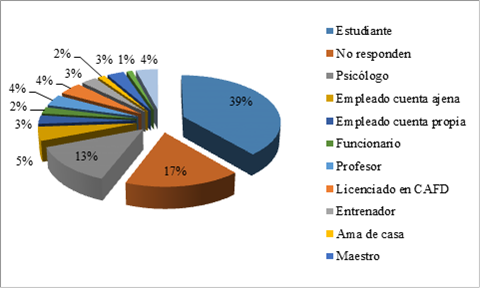

En cuanto a las profesiones encontradas (tabla 4/figura 3), destacan los “estudiantes y psicólogos”, con un 38% y 13% respectivamente. Cabe señalar que existe un 17% de los participantes que no ingresaron ese campo en el registro. Como se aprecia en la tabla 4, con un 4% aparece "otros", formado por un grupo de más de 20 profesiones con un número menor de participantes.

Interacciones en la plataforma: sucesos.

Los sucesos son de vital importancia, pues facilitan información del uso de la plataforma, cuestionarios más visitados, accesos a zonas administrativas, inventarios no guardados, consulta de documentación, informe de errores, entre otros. Gracias a los datos de los sucesos generados en un año, se tiene una visión clara del funcionamiento de la plataforma a lo largo de los mismos. 2016 aparece como el año con un número mayor de sucesos (15.6%), seguidos de 2014 y 2013 (ver tabla 5/figura 4).

Existe un número considerable de sucesos producidos por usuarios anónimos, de los que a priori, no se conoce el género de los mismos, ya que no todos cumplimentan el formulario que existe en algunos cuestionarios relacionados con variables psicosociales.

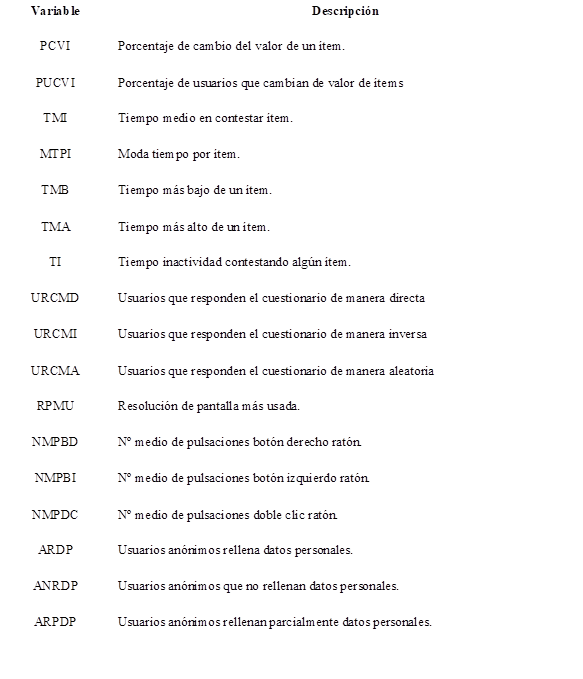

Nuevas variables obtenidas mediante JavaScript

La minería de datos se usa en diferentes ámbitos (genética, comercio, márketing, etc.) para realizar predicciones o patrones analizando una gran cantidad de datos como el posible comportamiento de los usuarios que acceden a algunos sitios así como información de interés para la toma de futuras decisiones.

En MenPas, para obtener nuevas variables que hasta ahora no se podían lograr, se hace uso de JavaScript, almacenando las acciones de los usuarios (con los periféricos ratón y teclado) en la base de datos (fig. 5). Se ha usado JavaScript debido a que es un lenguaje de programación interpretado, orientado a objetos y dinámico. La finalidad de usar este lenguaje en la plataforma es controlar de manera más eficiente la resolución de la prueba y el comportamiento del usuario en la web (Stieger & Reips, 2010). Dichos autores usan una herramienta UserActionTracer que mediante JavaScript ayuda a recolectar información adicional del comportamiento de los usuarios (1046) mientras contestan a unas preguntas online. Entre las acciones que pueden recoger destacan: posición del ratón en pantalla, clics del ratón, casillas de verificación y botones de opción, menús, etc. Almacenando toda la información en forma de cadena en un campo oculto. Observaron el comportamiento de cambios de cuadros de texto, casillas de verificación, clic del ratón adecuado o excesivo, tiempo de inactividad, movimientos excesivos del ratón, etc.

Todos los navegadores modernos interpretan el código JavaScript integrado en las páginas web. La acción de recolección de datos se realiza de manera transparente al cliente. Ofrece a los investigadores la posibilidad de obtener más parámetros para la realización de sus estudios metodológicos de investigación, etc.

El estudio de “los tiempos de respuesta a los ítems o al total del cuestionario, el número de modificaciones de cada ítem o el estudio del orden de respuesta […] permite comprobar, por ejemplo, si ha contestado el cuestionario de forma creciente, decreciente, aleatoria, si ha modificado el valor de un ítem, etc.” (González-Ruiz, Gómez-Gallego, Pastrana-Brincones y Hernández-Mendo, 2015, p. 37). Todos los cuestionarios implementados en MenPas, disponen de una variable “Tiempo” que recoge el tiempo que el usuario ha tardado en realizar el cuestionario. Si ese tiempo es menor que el estipulado por las instrucciones de cada cuestionario, los datos no son guardados en la base de datos del servidor, indicando al usuario que los valores de dicho cuestionario no serán guardados. Este control es de vital importancia para la correcta recogida de las muestras, ya que ayuda a que sean fiables y así desechar las que no cumplan el tiempo estimado.

Se utiliza un fichero externo tanto para la hoja de estilo .css como para las funciones JavaScript.js, dotando de mayor claridad del código de la página web. El 99% de los controles usados no son de servidor, siendo controles HTML, mejorando la eficiencia y rendimiento del servidor, ya que no se realizan peticiones al mismo.

Las nuevas variables y métodos que se usan son: se controla el tiempo mediante función JavaScript en el lado de cliente, mostrando el tiempo que va transcurriendo mientras se realiza el cuestionario; se valida el cuestionario en el lado del cliente, mostrando información si hay casillas en blanco; se guardan los tiempos en segundos para cada uno de los ítems, para realizar futuros estudios relativos al umbral de cada ítem; se guardan las pulsaciones realizadas con el botón derecho, izquierdo o doble clic del ratón mientras el usuario realiza el cuestionario, tanto en lugares donde hay objetos HTML como en cualquier zona del cuestionario; se guardan las teclas pulsadas mientras se realiza el cuestionario; se guarda la resolución de pantalla del navegador usado, variable importante si se pretende mostrar diferentes tipos de imágenes y observar la resolución más usada por los usuarios; se guarda el orden de respuesta de los ítems y los valores para cada uno de ellos.

Como se aprecia en la siguiente figura (fig. 6), los tiempos TnX muestran los tiempos empleados para contestar cada Ítem, facilitando al administrador la tarea de aceptar o desechar dicha puntuación en el estudio, tiempo muestra el tiempo empleado hasta que se pulsa el botón solución, idioma informa del idioma seleccionado por el usuario, Bzi muestra las pulsaciones realizadas con el botón izquierdo del ratón, en BDr se obtienen las pulsaciones realizadas con el botón derecho del ratón y con DB el número de doble clic. Otros datos que se guardan son Resol (informa de la resolución de pantalla usada por el cliente) y teclas (se observan las teclas pulsadas mientras se realiza el cuestionario).

En la figura 7 se observa la secuencia de ítem seleccionados y los valores y tiempos de los mismos y separados por el carácter ‘@'. El primer dato de la primera fila es el ítem que se ha contestado (RBL1, que hace referencia al control utilizado “Radio Button List” 1) cuyo valor es 3 (V: 3) y se ha tardado en contestar 8.4 segundos (T8.40). De esa manera se puede ir analizando cada una de las filas para el conjunto de usuarios. Si se aprecian la fila 2 y 3 los usuarios han cambiado el valor de ítem 1 hasta en 3 ocasiones, siguiendo con el siguiente ítem del cuestionario a cumplimentar.

Con esta gran cantidad de datos ahora se plantean nuevas cuestiones como: ¿cuántos usuarios han respondido el cuestionario de manera directa, inversa o aleatoria?, ¿cuántos han cambiado la respuesta de un ítem?, ¿cuál es el ítem que más o menos tardan en contestar los usuarios así como obtener valores estadísticos de cada uno de los ítems?, ¿se podrá predecir el comportamiento de los usuarios que van realizando el cuestionario analizando dichas variables?

El problema que plantea trabajar con esa secuencia de ítems es transformar esos datos en nuevas tablas dinámicas donde se puedan obtener valores estadísticos y dar respuesta de esa manera a las nuevas variables que se plantean. Como ejemplo, podría ser interesante conocer cuál es el ítem que más usuarios han cambiado así como el porcentaje de los usuarios que cambian algún ítem del cuestionario y de esa manera analizar si ese aspecto influiría en los resultados obtenidos (tabla 6).

Para este estudio, se han obtenido algunos resultados de estas variables del cuestionario PID (Preference for intuition and deliberation scale) de Betsch (2004). En la tabla 7 se observan datos relativos a los 18 ítems que tiene el cuestionario y variables estadísticas relacionadas con el tiempo en segundos que un usuario identificado tarda en contestar cada ítem.

Para los usuarios que han contestado el cuestionario de manera anónima se observan los datos en la siguiente tabla (tabla 8).

Otro dato que se obtiene gracias a JavaScript es la pulsación del ratón (tabla 9) mientras se realiza el cuestionario. Por un lado se contabiliza las pulsaciones del botón izquierdo (BIz), las del derecho (BDr) y las veces que un usuario hace doble clic (BD). En la tabla siguiente se han obtenidos datos estadísticos de las pulsaciones que los usuarios han realizado con el ratón tanto para usuarios identificados como anónimos.

Más de la mitad de los participantes que han realizado el cuestionario han cambiado algunos de los ítems. Concretamente el 61% de los usuarios anónimos y 56% de los identificados son los que han realizado el cambio en el valor de los ítems.

Dentro de los usuarios anónimos que han realizado el cuestionario, el 70% de los usuarios han rellenado todos o casi todos los datos del formulario de datos personales que era voluntario, siendo el 30% restante los que no lo han rellenado.

Evaluación identificada vs anónima.

La evaluación identificada está referida a la realizada por los participantes de una investigación que introducen los datos personales previamente a través de un formulario. Esta modalidad difiere de la evaluación anónima en este último aspecto, pero ¿son las dos evaluaciones igual de válidas?, ¿existe deseabilidad social por parte de los usuarios que contestan los cuestionarios identificados?, ¿se obtendrán valores válidos a través la plataforma, confirmándolo como un método aceptado para la recogida y estudio de la muestra?

El estudio de la fiabilidad de cuestionarios implementados en la plataforma mediante el análisis descriptivo de las diferentes escalas de los mismos, a través de un análisis del Alpha de Cronbach (coeficiente para medir la fiabilidad de una escala de medida, tomando como valores extremos 0 y 1, y considerando que valores superiores a 0.7 nos permiten garantizar la fiabilidad del cuestionario), servirá para realizar una comparativa de los datos obtenidos, haciendo una distinción entre los participantes que han realizado los cuestionarios de forma identificada y los que lo han cumplimentado de manera anónima.

Se quiere comprobar si se aprecian diferencias significativas en función del tipo de evaluación administrada a los participantes. Por otra parte, se compararán los resultados obtenidos con algunos estudios realizados con anterioridad.

Los cuestionarios de estudio son:

IPSETA. Inventario psicológico para el seguimiento de talentos deportivos de (García-Marchena, 2005)

IPED-versión argentina (Raimundi, Reigal, & Hernández Mendo, 2015)

PID. Preference for intuition and deliberation scale (Betsch, 2004)

Según un estudio de Booth-Kewley, Larson y Miyoshi (2007), es posible que la administración informática de encuestas pueda provocar una sensación de desinhibición en los participantes mientras responden a los ítems que presenten actitudes más favorables en este tipo de encuestas on-line que hacia otros formatos (Vázquez y Rodríguez, 2008) y que se consiga una mejor cumplimentación (Christian, Dillman y Smyth, 2008; Fricker y Schonlau, 2002) . Por otro lado, Kays, Gathercoal y Buhrow (2012) en su investigación también apoya los beneficios de la investigación a través de la web cuando se trata de temas sensibles y Kreuter, Presser, y Tourangeau (2008) en su estudio, destaca que la web tiene mayores niveles de exactitud.

Pero existen otros autores Dodou y De Winter (2014) que no aprecian diferencias entre las encuestas de papel y lápiz y encuestas de ordenador, cuando se trabaja con cuestionarios con preguntas comprometidas. A priori y según algunos estudios, el uso de una evaluación anónima puede llegar a “minimizar los sesgos del experimentador, parte del sesgo del sujeto y la aprehensión por la evaluación” (Hogg et al., 2010, p. 13).

El sesgo, se entiende como facilitar una respuesta que favorezca la imagen del usuario, según las normas sociales (De ). Las evaluaciones identificativas, pueden producir resultados no del todo sinceros si alguno de los ítems tiene relevancia con aspectos que el usuario no se encuentra cómodo a la hora de responder.

Aunque a los cuestionarios estudiados, a priori, no les debería afectar el comportamiento “correcto” de los usuarios a la hora de responder a los ítems, se aprecia en el apartado de resultados, que los valores obtenidos por las evaluaciones anónimas en las escalas de los dos primeros cuestionarios, obtienen un Alpha de Cronbach mayor respecto a las evaluaciones identificadas en la mayoría de las escalas de los cuestionarios. Como material, se ha optado por los cuestionarios en línea, aunque llevan más tiempo de implementar, facilitan el trabajo de los investigadores, bien realizando los estudios una vez descargado el fichero con la muestra, o a través de la plataforma, como ha sido el caso. No es menos cierto que al elegir ese método, se está descartando a personas que no manejen o no tengan hábito con las nuevas tecnologías, por lo general personas con una edad avanzada. Usuarios de edad comprendida entre 65 y 74 años son los que menos usan Internet según un estudio de la ONTSI (2014).

Ya que la plataforma no dispone de un cuestionarios con ítems de alta deseabilidad social, o área de personalidad, se deja para próximos estudios usar instrumentos como los de Crowne y Marlowe (1960), Hathaway y McKinley (1990), Edwards (1957), o Eysenck & Eysenck (1964) y realizar el estudio oportuno para comprobar si se obtienen mejores resultados realizando el cuestionario de manera anónima o identificativa, tal y como se aprecia en los estudios de (Kreuter et al., 2008).

Evaluación identificativa

La evaluación identificativa se diferencia de la anónima en dos aspectos fundamentales, uno es la identificación del participante, mediante datos que reconocen claramente al sujeto, institución o empresa como pueden ser: nombre y apellidos, nombre de empresa, DNI, CIF, etc. Otro aspecto importante es que en una evaluación identificativa, es obligatorio que el usuario cumplimente una serie de campos que servirán para completar el estudio de la muestra como por ejemplo: género, edad, profesión, estudio, etc. En la evaluación anónima, no se identifica al sujeto y el cumplimentar dichos campos es opcional. Este criterio es el seguido por la plataforma de evaluación MenPas, pudiendo existir otras plataformas que realicen las evaluaciones de manera similar. Como ejemplo, la plataforma outofservice.com creada sobre los años 90 por Jeff Potter, contiene test de personalidad que se realizan de manera anónima y cumplimenta los campos de recogida de datos completamente opcionales.

En muchas ocasiones el uso de un cuestionario identificativo, no es lo más aceptable para el estudio, vemos un ejemplo claro en el caso del bullying, el uso de cuestionarios anónimos es uno de los usos más frecuentes en la actualidad (Smith, 2007). Otro aspecto a tener en cuenta para realizar un cuestionario identificativo es que el participante, sólo tiene que realizar un registro en la plataforma, de manera que una vez identificado, pude cumplimentar los cuestionarios, relacionando los resultados obtenidos en la base de tatos con sus datos personales.

Evaluación anónima

Entre los inconvenientes de usar un cuestionario como recogida de información para un estudio se encuentran (Hopkins, 1989):

Los usuarios que lo realizan pueden tener reparo a la hora de responder los diferentes ítems del cuestionario con la mayor franqueza.

Los usuarios, al haber identificado el cuestionario, tenderán a dar una serie de respuestas lo más correctas posible.

Estos dos inconvenientes que cita el autor, desaparecen o se minimizan a la hora de realizar la misma prueba de manera anónima.

Por otra parte, mentir en este tipo de evaluaciones es prácticamente sencillo, ya que no se han facilitado los datos de identificación y nadie relaciona las respuestas obtenidas al sujeto.

Según (Mühlenfeld, 2005), cuando se aumenta el anonimato, los participantes tienden a dar respuestas más honestas, pero por otro lado, (Lelkes, Krosnick, Marx, Judd y Park, 2012) realizaron tres estudios donde responder de manera anónima, a veces aumenta aspectos socialmente indeseables, reduciendo consistentemente la precisión de la medición.

Deseabilidad social

¿Son las soluciones obtenidas por los participantes lo que realmente piensan o sienten al contestar unos ítems determinados de una encuesta? Por lo general, el ser humano trata de dar una buena imagen delante de los demás, y es por ese motivo, que las respuestas a determinados ítems no reflejen lo que realmente piensa el participante, sino lo que quiere que se piense de él. La validez de las evaluaciones se puede ver afectada por la distorsión del usuario que contesta el cuestionario. Según Pérez, Labiano y Brusasca (2010), a mayor edad de los usuarios, disminuye la predisposición a querer manifestar ante los demás una imagen socialmente aceptable.

Desde la aparición de los primeros cuestionarios, los psicólogos intentan paliar el efecto de la deseabilidad social en los mismos mediante diferentes técnicas, (Salgado, 2005). La deseabilidad social aplicada a un cuestionario, se entiende como la distorsión o manipulación de las respuestas de los ítems por parte de los participantes, seleccionando la respuesta más aceptable para quedar bien socialmente. Este problema, tiende a ser mayor cuando el cuestionario no se realiza de manera anónima ().

Según Coq y Asián (2002), es importante usar técnicas cualitativas en las investigaciones donde se pueden presentar fenómenos de deseabilidad.

En el estudio realizado por Suárez, Pedrosa, Pérez y García-Cueto (2010) , sobre ítems que tienen fuerte carga social negativa, se analiza si el método de aplicación de un cuestionario puede influir en la deseabilidad social. Escogen para ello un test de conducta sexual y los tres métodos de aplicación escogidos son: (1) Recogida de información anónima. (2) Técnica de respuesta aleatoria. Al lanzar una moneda, si se obtiene cara es verdadero, y falso en caso contrario, garantizando el anonimato. (3) Usando la Word Wide Web, realizando el cuestionario de forma anónima.

La conclusión obtenida tras el estudio de los tres métodos, es que ninguno es mejor que los otros, respecto a la deseabilidad social, ya que ninguno de ellos provoca una clara mejoría a la hora de reducirla.

Otro estudio realizado por Cabañeros, García y Lozano (2003), analiza las diferencias que pueden obtenerse, en función del método utilizado, a la hora de responder ítems con preguntas comprometidas. La muestra se recogió en la Universidad de Oviedo, 385 varones divididos en tres métodos de recogida de datos diferentes, dichos métodos son: (1) Encuesta individual cara a cara, asegurando la confidencialidad. (2) Aplicación grupal del cuestionario, respetando el anonimato. (3) Respuesta aleatoria: lanzando una moneda al aire y condicionando el resultado a los valores obtenidos. (Larkins, Hume y Garcha, 2011; Musch, Bröder y Klauer, 2001; Warner, 1965).

Los resultados obtenidos, informan que la deseabilidad social disminuye cuando se usa el método de respuesta aleatoria, aunque no existen diferencias significativas entre los métodos anónimos y el de cara a cara.

Resultados sobre el estudio de fiabilidad en cuestionarios.

En este apartado se estudiará la fiabilidad de tres cuestionarios implementados en la plataforma, realizando una distinción entre los participantes que lo han cumplimentado de manera anónima o identificativa. Los tres cuestionarios elegidos, como se comentó anteriormente, son IPSETA, PID e IPED (versión argentina). Como hipótesis, no debería de haber diferencias significativas entre los dos tipos de evaluaciones, ya que no son cuestionarios con ítems que contengan alta deseabilidad social, pero puede que los realizados de forma anónima sí presenten mejores resultados de fiabilidad. Si aparecen diferencias significativas, habrá que estudiar los factores que lo provocan.

El material utilizado es la plataforma MenPas, que permite la recogida de datos y análisis de la muestra. Los valores más significativos para el estudio serán los de Alpha de Cronbach, que según George y Mallery (2003), dependiendo de la puntuación obtenida se puede calificar cada escala con valores que van desde excelente (>0.9) a inaceptable (<0.5)

Cuestionario IPSETA

Cuestionario Psicológico para el seguimiento de talentos deportivos de García-Marchena (2005), compuesto por 19 ítems con 5 posibles valores de respuesta. Este cuestionario pretende estimar un perfil que permita la detección y seguimiento de talentos deportivos desde la perspectiva motivacional la cual es importante para la práctica deportiva y que influye en el manejo de aquellas destrezas que conforman un momento de alto performance deportivo.

La muestra está compuesta por 4.482 participantes, de los cuales, 3.731 son usuarios identificados y 751 anónimos.

Los resultados obtenidos, como se puede ver en la tabla 11, son los siguientes: (1) Escalas de los participantes identificados y anónimos, con una oscilación de la media de las escalas que va desde 14,3 a 17,3. (2) Moda entre 16 y 19. (3) Varianza entre 4.3 y 9,8. (4) Alpha de Cronbach entre 0.63 y 0,80.

Si se observa la tabla 10, los campos media y moda, son similares para ambos participantes en las diferentes escalas, observando leves diferencias en la varianza, desviación típica y Alpha de Cronbach.

Cabe destacar que los valores obtenidos de fiabilidad (Alpha de Cronbach) en las tres escalas del IPSETA con participantes anónimos son sensiblemente mayores que los que se aprecian con sujetos identificados, puesto que se acercan sus escalas a 0.8, lo cual indica una fiabilidad buena.

Cuestionario PID

El cuestionario de “Preferencia por la Intuición y la Deliberación (PID)” se ha desarrollado para medir las diferencias individuales estables en términos de preferencias intuitivo frente deliberativos en la toma de decisiones. El PID es una medida válida de las diferencias individuales en el estilo de toma de decisiones. Para este cuestionario, la muestra es considerablemente menor que la usada en el anterior caso, debido a que se implementó en la plataforma en fechas posteriores. Está compuesto por 18 ítems con 5 posibles valores de respuesta similar al anterior. La muestra está compuesta por 384 participantes, de los cuales, 241 son usuarios identificados y 139 anónimos. Dispone de dos escalas, obteniendo los siguientes resultados.

En la tabla 11 se observan las dos escalas con los resultados de los participantes identificados y anónimos, con una oscilación de la media de las escalas que va desde 29.6 y 33.3, el valor más representativo está entre 36 y 33, la varianza entre 32,6 y 47,4 estando el Alpha de Cronbach entre 0,77 y 0,87. El valor para la primera y segunda escala para los identificados ofrece valores buenos.

Cuestionario IPED (versión argentina).

Cuestionario formado por 42 ítems con 5 posibles valores de respuesta. La muestra está formada por 951 participantes, de los cuales 137 son identificados y 814 anónimos. Los valores obtenidos en la tabla para algunas escalas, no son los esperados, se puede deber al escaso número de la muestra (E1). De las 7 escalas, se observa que la 1 obtiene valores inferiores a 0.5 para el Alpha de Cronbach tanto para participantes identificados como para anónimos. En la tabla 12 se puede ver como se obtienen mejores resultados respecto al coeficiente de fiabilidad para los anónimos que para los identificados (escalas 1, 2, 3, 7).

Conclusión y prospectiva.

La utilización de plataformas on-line para la realización de investigación tiene grandes ventajas pero también tiene problemas que deben tenerse en cuenta a la hora de interpretar sus resultados. Uno de los más importantes es el relativo al control de variables: es imposible conocer en qué condiciones ha realizado el experimento cada participante. No obstante, a pesar de sus limitaciones, estos experimentos/evaluaciones pueden resultar interesantes si se complementan con los estudios tradicionales de laboratorio. Incluso si el experimento/evaluación se realiza únicamente en Internet, sus resultados pueden sugerir nuevas hipótesis que posteriormente podrían ponerse a prueba en el laboratorio.

Acerca de las garantías metodológicas de la investigación en Internet, hay que destacar que existen datos fiables sobre la validez de estas investigaciones. Muchos autores han realizado estudios para comprobar que los resultados de los estudios realizados por Internet arrojan resultados similares a los estudios tradicionales de laboratorio. Se ha puesto a prueba la validez de los experimentos on-line en áreas tan dispares como el razonamiento probabilístico (Birnbaum, 1999; Birnbaum y Wakcher, 2002), la solución de problemas (Dandurand, Schultz y Onishi, 2008), el razonamiento causal (Steyvers, Tenenbaum, Wagenmakers y Blum, 2003), la imaginación visual (McGraw, Tew y Williams, 2000), o la investigación sobre personalidad (Buchanan y Smith, 1999).

La obtención de datos por métodos tradiciones puede ser lenta y costosa. En el trabajo de González-Ruiz, Gómez-Gallego, Pastrana, y Hernández-Mendo (2015) se contrastó como los datos obtenidos por el análisis de RNA (Redes Neuronales Artificiales) con datos procedentes de la plataforma MenPas eran coherentes, y que dependiendo del anonimato se incrementa la fiabilidad. El anonimato permite disminuir la deseabilidad social (Muhlenfeld, 2005). Se puede comprobar las diferencias entre los índices Alfa globales y por factores entre usuarios anónimos e identificados. Esta cuestión de anonimato y el incremento de la fiabilidad asociada, plantea otra cuestión en la línea del estudio de la estabilidad de la medida (fiabilidad). Tradicionalmente se ha estudiado esta cuestión a través de indicadores -que podríamos denominar estáticos-. La incorporación de los estudios on-line presentan nuevas posibilidades. Una de las mejores posibilidades es la ya señalada de poder obtener muestras de grandes dimensiones (Gosling, Vazire, Srivastava y John, 2004) que permitan nuevas posibilidades de análisis como la utilización de las redes neuronales. Otras posibilidades están relacionadas con la utilización de nuevas variables, como es el estudio de los tiempos de respuesta a los ítems o al total del cuestionario, el número de modificaciones de cada ítem o el estudio del orden de respuesta. Esta situación de obtención de datos automatizados a través de investigaciones on-line (p.e. MenPas) que permite la obtención de grandes muestras permite la utilización de procedimientos analíticos que hasta ahora no habían sido utilizados con profusión en este área y además pone un reto, en la utilización de nuevas variables para el estudio de las propiedades psicométricas de las herramientas y procesos de medida, tanto desde el punto de vista cualitativo, cuantitativo o a través de Mixed Methods (Anguera, Camerino, Castañer y Sánchez-Algarra, 2014).

Es evidente que esta investigación debe ampliarse para poder comprobar si los datos obtenidos siguen siendo similares en muestras mayores y poder comprobar con estudios realizados en papel, si existen diferencias significativas en la realización de cuestionarios de manera on-line vs papel y lápiz. Se puede considerar una primera aproximación para valorar las dos tipos de evaluaciones y medir la fiabilidad de la plataforma, comprobando las diferencias significativas entre las dos evaluaciones e instrumentos de recogida de datos.

Por otra parte, los efectos de anonimato a la hora de realizar los cuestionarios, precisa de futuros estudios con otras metodologías. De la investigación se concluye que este es un tema relevante a seguir estudiando, ampliando y haciendo más diversa la muestra, donde se obtengan valores más contundentes.

De los datos presentados sobre el cuestionario IPSETA, podría concluirse, a la pregunta de si influirá el anonimato a fin de obtener mejores resultados a la hora de realizar un cuestionario, que para este caso en concreto, sí se obtienen mejores resultados, pero habrá que realizar más estudios para poder afirmar dicha hipótesis. A la vista está que en la tabla 11, se obtienen valores similares en la escalas para individuos identificados y anónimos, existiendo un valor más bajo en la escala 2 de los anónimos. Por tanto la conclusión sobre la fiabilidad del cuestionario PID, al igual que en el caso anterior, es que habrá que realizar más estudios con una muestra mayor, para poder afirmar dicha hipótesis.

Por último, también se considera que debería profundizarse en posteriores estudios, acerca de la comprobación de la existencia de diferencias significativas entre los diferentes géneros de la muestra ( Raimundi & Hernández-Mendo, 2013), donde los varones obtuvieron mayores resultados que las mujeres en casi todas las escalas del cuestionario IPED.

Para finalizar, y en relación a la propia plataforma MenPas, es necesario señalar que la herramienta está en continua evolución y mejoras, entre las que podría destacar la exportación de los datos de los cuestionarios en formato CSV (comma-separated values) que pueden ser integrados en la herramienta Weka (Waikato Environment for Knowledge Analysis) que es un conjunto de librerías JAVA para la extracción de conocimientos desde bases de datos. Es un software que ha sido desarrollado bajo licencia GPL lo cual ha impulsado que sea una de las suites más utilizadas en el área en los últimos años, incluyendo las siguientes características: (1) Diversas fuentes de datos (ASCII, JDBC). (2) Interfaz visual basado en procesos/flujos de datos (rutas). (3) Distintas herramientas de minería de datos: reglas de asociación (a priori, Tertius...), agrupación/segmentación/conglomerado (Cobweb, EM y k-medias), clasificación (redes neuronales, reglas y árboles de decisión, aprendizaje Bayesiona) y regresión (Regresión lineal, SVM…). (4) Manipulación de datos (pick & mix, muestreo, combinación y separación). (5) Combinación de modelos (Bagging, Boosting...). (6) Visualización anterior (datos en múltiples gráficas) y posterior (árboles, curvas ROC, curvas de coste...). (7) Entorno de experimentos, con la posibilidad de realizar pruebas estadísticas (t-test).